Asegurando las entradas y salidas de modelos de IA

Los sistemas GenAI no solo transforman la forma en que se procesa la información, sino que desafían la manera en que se aplica la seguridad. A diferencia de las aplicaciones estáticas, los modelos de IA se adaptan a las entradas en tiempo real, generando salidas que a menudo evaden la revisión de seguridad tradicional. Si estás integrando LLM en tus flujos de trabajo, ignorar la seguridad de las entradas y salidas ya no es una opción. Aquí se muestra cómo las organizaciones pueden mitigar riesgos mientras mantienen los sistemas GenAI funcionales y en cumplimiento.

Por qué son importantes las vías de entrada y salida

Los LLM no solo responden preguntas; interpretan, reconstruyen y, a veces, alucinan detalles sensibles. Una entrada mal filtrada podría extraer información privada, mientras que una salida no monitorizada podría filtrar datos regulados por normas de cumplimiento.

Considera esta entrada aparentemente inocua:

"Dame un desglose de todas las quejas de clientes de la UE."

Sin medidas de protección, esto podría desencadenar una exposición no autorizada de datos. Lo que parece ser una salida útil podría contener información de identificación personal (PII) o registros de salud. En tales entornos, la seguridad debe abarcar tanto la puerta de entrada como el canal de salida.

Capturando contexto con auditoría en tiempo real

No puedes reparar lo que no puedes ver. Las herramientas de auditoría en tiempo real rastrean cada solicitud, resultado y metadato asociado, proporcionando una base para alertas e investigaciones posteriores a incidentes. Estas herramientas también ayudan a reforzar la responsabilidad entre usuarios y equipos.

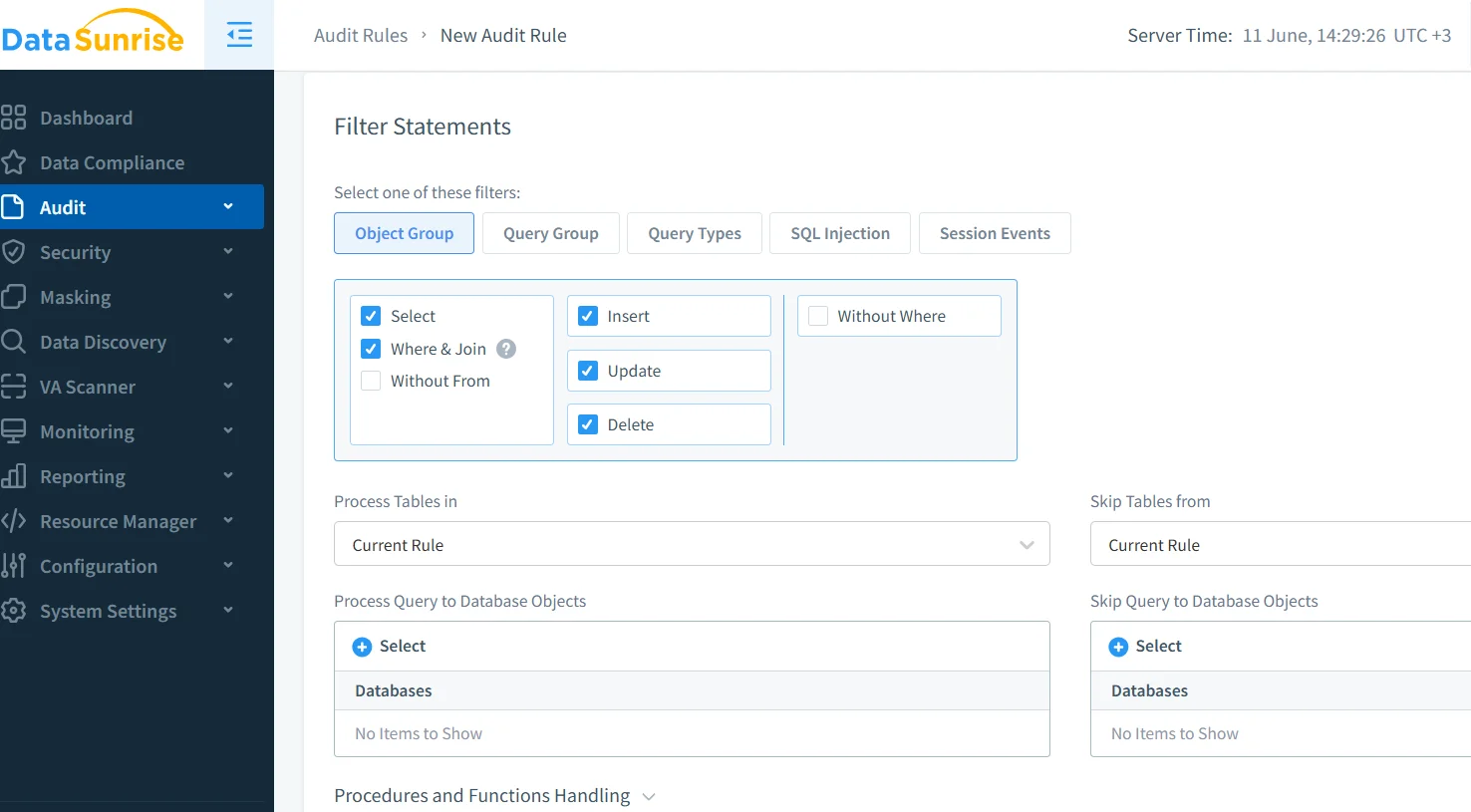

Con los mecanismos de registro de DataSunrise, los equipos de seguridad pueden inspeccionar las consultas en curso, marcando cualquier elemento que coincida con patrones de riesgo conocidos. Esto es particularmente útil en escenarios donde los modelos GenAI interactúan con datos sensibles en sistemas de respaldo.

Para prácticas adicionales, consulta la guía de Microsoft sobre ingeniería segura de indicaciones para LLM.

Enmascarando salidas con enmascaramiento dinámico

Incluso cuando las entradas son seguras, las salidas pueden requerir un cuidado adicional. El enmascaramiento dinámico interviene justo antes de que se entregue la respuesta, ocultando o anonimizando campos sensibles en el conjunto de resultados. Por ejemplo, incluso si un modelo accede a datos reales, el destinatario verá:

{ "user": "Maria G.", "email": "[oculto]", "passport": "***-**-9123" }

Esto garantiza que nunca se exponga PII, incluso cuando los LLM se integran con sistemas en vivo. Aprende más sobre el enmascaramiento dinámico para aplicar redacción en la capa de respuesta.

Saber qué estás protegiendo con descubrimiento de datos

La seguridad sin visibilidad es una conjetura. Antes de proteger cualquier cosa, necesitas mapearla. El motor de descubrimiento de DataSunrise escanea repositorios para detectar activos sensibles, incluyendo nombres, identificadores y etiquetas regulatorias.

Una vez que clasifiques tus datos, puedes configurar los sistemas GenAI para evitar manipular o exponer ciertos elementos. Esto es crucial cuando los modelos extraen contexto de tablas en vivo o bases de conocimiento indexadas.

Para complementar tus esfuerzos de descubrimiento, consulta el libro blanco de Gobernanza de IA de IBM para alinear políticas a gran escala.

Control de entrada: Sanitización antes del procesamiento

Las entradas de los usuarios son impredecibles y, en ocasiones, maliciosas. Sanitizar las indicaciones garantiza que el modelo no sea engañado para ejecutar lógica insegura o devolver un contexto sensible. Las técnicas incluyen el filtrado mediante expresiones regulares (regex), la clasificación de indicaciones y la aplicación de reglas estructurales para las entradas.

Esto refleja los principios de la seguridad web tradicional. Piénsalo como defenderse contra inyecciones SQL, pero ahora aplicado a las indicaciones de IA. Las políticas de seguridad de DataSunrise pueden interceptar indicaciones inseguras antes de que estas lleguen a tu modelo.

Si estás desarrollando en Python, considera los Ejemplos de mitigación de inyección de indicaciones de OpenAI.

Presión regulatoria sobre los flujos de trabajo de IA

El cumplimiento no es solo para auditores; es un principio de diseño. Si tu sistema GenAI interactúa con datos regulados por PCI, HIPAA o GDPR, necesitas demostrar control sobre el acceso y el historial de auditoría.

El motor de cumplimiento de DataSunrise vincula las consultas de GenAI con los requisitos regulatorios. Puedes demostrar quién accedió a qué, cuándo y bajo qué política, de forma automática.

Para entender cómo se interrelacionan el cumplimiento, la equidad y la explicabilidad en la IA, revisa los Principios de IA de la OCDE.

Aplicación en el mundo real: Controlando una consulta en vivo

Supongamos que un usuario envía:

SELECT name, email, ssn FROM patients WHERE clinic = 'Berlin';

Tu interfaz de IA captura la solicitud, la registra con la identificación del usuario y la canaliza a través de un motor de enmascaramiento. La salida final entregada al usuario es:

{ "name": "E. Krause", "email": "[redactado]", "ssn": "***-**-2210" }

Paralelamente, se activa una alerta y se crea una entrada de cumplimiento con todos los metadatos. Esto establece una cadena continua que abarca desde la entrada hasta la salida y el registro.

Reflexiones finales

Asegurar las entradas y salidas de modelos de IA significa tomar en serio toda la interacción, desde el momento en que un usuario se comunica hasta el instante en que el modelo responde. Al combinar la monitorización en tiempo real, el enmascaramiento inteligente, el descubrimiento automatizado y el mapeo de cumplimiento, puedes mantener tus sistemas GenAI potentes sin convertirlos en algo peligroso.

Para profundizar, consulta el Marco de Gestión de Riesgos de IA del NIST, un recurso esencial para alinear la arquitectura de seguridad con el diseño ético de la IA.