Cómo la IA Generativa está Impactando las Prácticas de Seguridad

La IA generativa (GenAI) está transformando la forma en que las organizaciones desarrollan software, gestionan datos y atienden a los usuarios. Pero con esa innovación surge el riesgo. A medida que las herramientas de GenAI generan texto, código, imágenes y toman decisiones, también crean nuevas superficies de ataque. Comprender cómo la IA generativa está impactando las prácticas de seguridad es clave para cualquier organización que maneje datos sensibles o regulados.

Un Nuevo Vector de Ataque: El Lenguaje como Superficie de Amenaza

La seguridad tradicional asume entradas predecibles. GenAI rompe con eso. Al procesar indicaciones humanas, los modelos de lenguaje (LLM) abren la puerta a la inyección de indicaciones, exfiltración de datos y fugas accidentales. Un modelo entrenado con datos propietarios podría, al recibir la indicación adecuada, regenerarlos y exponerlos.

A diferencia de las consultas convencionales, las indicaciones de GenAI pueden desencadenar operaciones no intencionadas. Los atacantes pueden manipular las indicaciones para escalar privilegios o recuperar contenido sensible del entrenamiento. Estos desafíos exigen un cambio en la forma en que se aplican las políticas de seguridad, especialmente para sistemas integrados con APIs de LLM.

Un análisis en profundidad de los ataques de inyección en indicaciones se expuso en este artículo de OWASP, que destaca el desafío de controlar el comportamiento del modelo cuando las entradas son impredecibles.

Auditoría en Tiempo Real para Sistemas de IA

Los registros de auditoría heredados no capturan la sutileza de las indicaciones de GenAI. Ya no basta con registrar “consulta ejecutada”: es necesario registrar la indicación completa, la salida y las acciones posteriores.

Herramientas modernas como los sistemas de auditoría en tiempo real para entornos integrados con GenAI registran cada solicitud, incluyendo las indicaciones de entrada, contexto y respuestas. Esto mejora la visibilidad, respalda las investigaciones forenses y ayuda a detectar usos indebidos sutiles, como los ataques de ingeniería de indicaciones.

Plataformas como DataSunrise Audit Logs están evolucionando para manejar estas cargas de trabajo únicas, permitiendo a los equipos monitorear la actividad impulsada por la IA con contexto completo.

Enmascaramiento Dinámico en Tiempo de Generación

Cuando los LLM generan una respuesta, es posible que incluyan información personal o datos sensibles, especialmente si el modelo fue afinado con conjuntos de datos internos. Ahí es donde el enmascaramiento dinámico se vuelve esencial.

En lugar de enmascarar únicamente los datos de entrada, GenAI requiere enmascaramiento a nivel de salida. Este redacta el contenido en el momento de la respuesta, filtrando dinámicamente la información personal o términos regulados. A diferencia de los métodos estáticos, el enmascaramiento dinámico se adapta a salidas impredecibles y hace cumplir las políticas a través de diferentes contextos de usuario.

SELECT genai_response

FROM model_output

WHERE user_id = CURRENT_USER()

AND mask_sensitive(genai_response) = TRUE;

Una perspectiva más amplia sobre este tema se ofrece en el informe de Google DeepMind sobre la seguridad de los LLM, que expone cómo la seguridad de las respuestas depende del filtrado de contenido en tiempo real.

Descubriendo Riesgos de Datos Ocultos

Muchos sistemas de GenAI se entrenan con conjuntos de datos no clasificados o mal etiquetados. Esto puede llevar a la exposición accidental de datos sensibles a través de consultas aparentemente inofensivas.

Herramientas para el descubrimiento de datos ayudan a clasificar el contenido en datos de entrenamiento, almacenes vectoriales e historiales de indicaciones. Identifican información personal en embeddings, señalan secretos comerciales almacenados en la memoria de contexto y revelan conjuntos de datos no conformes que alimentan los flujos de trabajo de GenAI.

Esta capa de descubrimiento ayuda a hacer cumplir las regulaciones de cumplimiento de datos como GDPR, HIPAA y PCI-DSS, especialmente cuando el modelo se reentrena con datos en vivo. Para obtener orientación práctica, el Marco de Gestión de Riesgos de IA del NIST expone las mejores prácticas para la clasificación e inventario de datos.

Seguridad Reinventada para Flujos de Trabajo Impulsados por Solicitudes

Los controles de seguridad deben tener en cuenta el comportamiento de GenAI. En lugar de roles y permisos estáticos, la aplicación ahora incluye el monitoreo de indicaciones, el filtrado de salidas y el RBAC para las entradas de IA.

La detección de inyecciones SQL basada en patrones también cumple una función al identificar intentos de eludir restricciones mediante consultas creativas. Un usuario con derechos de solo lectura no debería poder construir indicaciones que recuperen datos enmascarados o redactados.

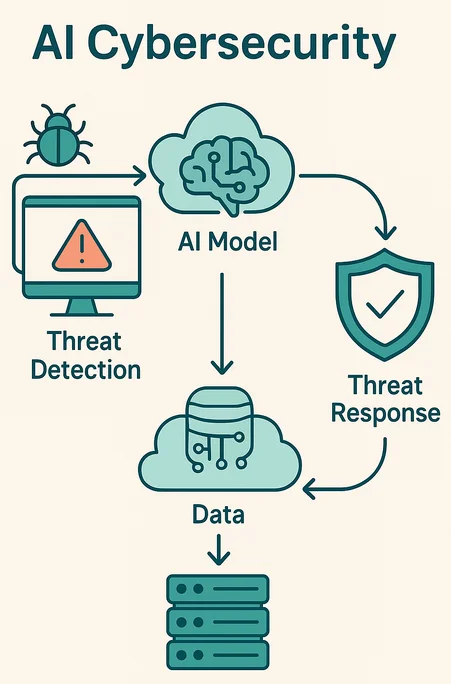

La detección de amenazas en tiempo real puede identificar comportamientos inusuales en las indicaciones, como múltiples intentos de extraer un nombre o reconstruir registros estructurados.

Cumplimiento a la Velocidad de la Generación

El cumplimiento solía ser reactivo: escanear registros, realizar auditorías, enviar reportes. GenAI obliga a los equipos de cumplimiento a actuar en tiempo real. Con los LLM generando respuestas en milisegundos, la aplicación de las políticas debe ser igual de rápida.

Las soluciones automatizadas de gestión de cumplimiento emparejan las indicaciones con las políticas, bloquean las salidas cuando es necesario y activan alertas en tiempo real a través de herramientas como MS Teams o Slack.

No se trata solo de evitar multas. Se trata de generar confianza. Cuando un modelo de IA revela información de un paciente o el historial financiero, el daño es inmediato e irreversible. La solución es prevenir las violaciones antes de que la salida salga del sistema.

Ejemplo: Bloqueo de Indicaciones con Aplicación de Políticas

A continuación se muestra un ejemplo simplificado de un filtro de indicaciones en pseudocódigo:

if contains_sensitive_terms(prompt) or violates_compliance(prompt):

reject(prompt)

alert("Se activó la regla de cumplimiento")

else:

forward(prompt)

Dichas reglas pueden integrarse con las políticas de seguridad para bloquear la generación a nivel del modelo o del middleware.

Mirando Hacia el Futuro: Modelos de Seguridad Nativos de la IA

Las futuras plataformas de seguridad tratarán a GenAI como un modelo de amenaza de primera clase. Introducirán nuevos controles, como cortafuegos para indicaciones, DLP conscientes del significado semántico e integración SIEM nativa para IA. Algunas plataformas utilizarán políticas de enmascaramiento continuo guiadas por aprendizaje por refuerzo.

Para mantenerse a la vanguardia, los equipos de seguridad deben tratar los sistemas de GenAI como agentes probabilísticos, no como herramientas en las que se confía ciegamente. Esto implica monitorear, hacer cumplir y establecer límites en cada interacción.

Al integrar auditoría en tiempo real, enmascaramiento dinámico, descubrimiento y un cumplimiento consciente de la IA, las empresas pueden aprovechar GenAI sin comprometer la integridad de los datos. Porque cómo la IA generativa está impactando las prácticas de seguridad no es una tendencia: es la nueva base para la defensa digital.