Directrices de seguridad OWASP para LLM

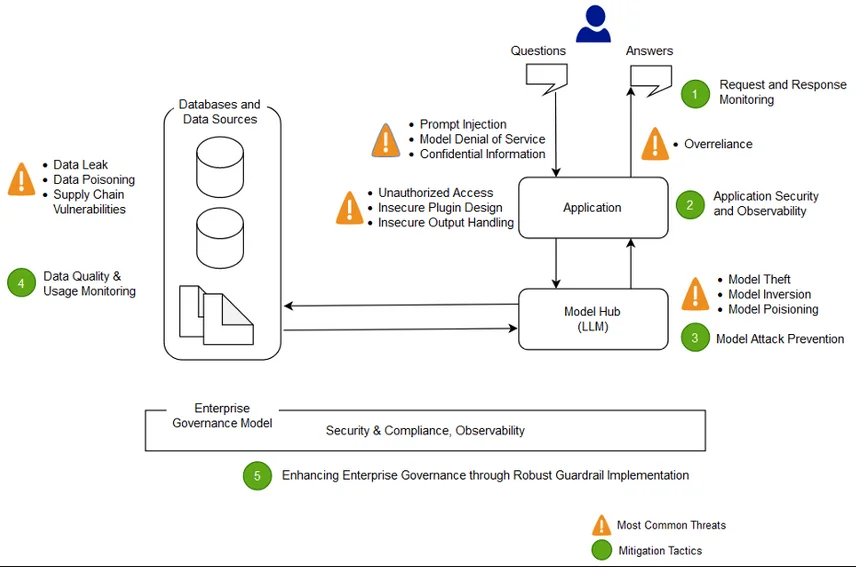

Los modelos de lenguaje a gran escala (LLMs) se integran cada vez más en aplicaciones y flujos de trabajo modernos, impulsando desde bots de atención al cliente hasta la interpretación de datos en tiempo real. Pero con gran poder vienen nuevas superficies de ataque. El Top 10 de OWASP para LLM ha generado discusiones a nivel mundial sobre cómo abordar los riesgos de GenAI, y ahora los equipos de seguridad deben ampliar sus manuales de actuación.

Este artículo explora cómo utilizar las Directrices de seguridad OWASP para LLM para asegurar los sistemas integrados con LLM mientras se logra auditoría en tiempo real, enmascaramiento dinámico, descubrimiento de datos y cumplimiento normativo.

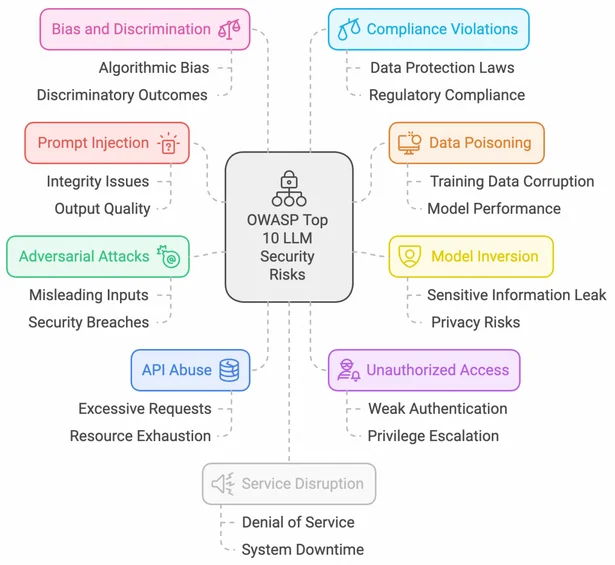

Comprendiendo el panorama de OWASP para LLM

La iniciativa de OWASP en torno a los LLM ofrece un enfoque estructurado para identificar y mitigar vulnerabilidades específicas de los sistemas de GenAI. Algunas amenazas clave incluyen la inyección de indicaciones, la denegación de servicio del modelo, la fuga de datos sensibles y el uso inseguro de plugins.

Los equipos de seguridad pueden consultar el Top 10 de OWASP para aplicaciones de LLM para alinear su adopción de GenAI con un proceso de modelado de amenazas adaptado a los flujos de trabajo de LLM.

Auditoría en tiempo real: Monitoreo del comportamiento de la IA y acceso a datos

Para salvaguardar los sistemas impulsados por LLM, es fundamental implementar mecanismos de auditoría que capturen tanto las interacciones de los usuarios como las indicaciones internas emitidas por el sistema.

Soluciones como las reglas de auditoría de DataSunrise y el monitoreo de actividad de la base de datos pueden ofrecer un seguimiento continuo de las interacciones del LLM con las fuentes de datos estructuradas.

A continuación, se muestra un fragmento de PostgreSQL para capturar los patrones de acceso de los agentes LLM:

SELECT datname, usename, query, backend_start, state_change

FROM pg_stat_activity

WHERE application_name LIKE '%llm_agent%';

Los registros de auditoría enriquecidos con el contexto del usuario, la entrada/salida del modelo y metadatos de marca de tiempo ayudan a las organizaciones a construir una preparación forense y detectar comportamientos anómalos.

Enmascaramiento dinámico de datos para la seguridad en las indicaciones

Cuando los LLM acceden a datos de producción, los campos sensibles sin enmascarar pueden exponerse inadvertidamente en la salida. Integrar el enmascaramiento dinámico directamente en la canalización de datos es fundamental.

Utilizando la capacidad de enmascaramiento dinámico de DataSunrise, puedes redactar o tokenizar la información de identificación personal (PII) antes de que se envíe a las indicaciones.

Una regla de enmascaramiento podría reemplazar las direcciones de correo electrónico reales con valores de marcador de posición, como:

REPLACE(email, SUBSTRING(email, 1, POSITION('@' IN email)-1), 'user')

Esto garantiza el cumplimiento del GDPR y de HIPAA al construir soluciones de IA con datos del mundo real.

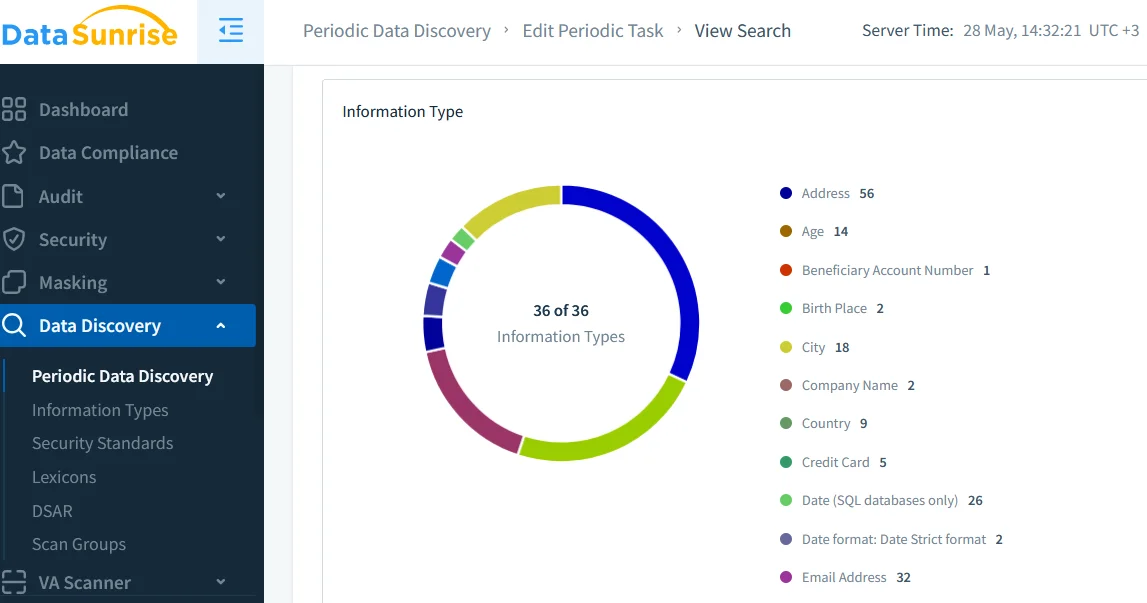

Descubrimiento de datos: Construir confianza en tu corpus de entrada

Los LLM pueden amplificar los riesgos si se entrenan o ajustan con conjuntos de datos desconocidos o no clasificados. Las herramientas de descubrimiento de datos permiten a las organizaciones escanear, etiquetar y catalogar automáticamente los datos sensibles antes de que lleguen a la capa de incrustación o recuperación.

Un proceso robusto de descubrimiento ayuda a reducir las canalizaciones de IA en la sombra y se alinea con políticas de seguridad como los controles de acceso basados en roles (RBAC).

Soluciones externas de gobernanza de datos, como el Open Policy Agent, también pueden integrarse con estos hallazgos para hacer cumplir condiciones de acceso dinámicas para los agentes que construyen las indicaciones.

Políticas de seguridad: Alineando los flujos de trabajo de la IA con los controles

Los LLM no se pueden monitorear como las aplicaciones tradicionales; sus comportamientos son probabilísticos, sensibles al contexto y, a menudo, no deterministas. Por ello, las organizaciones deben aplicar políticas de seguridad en capas que incluyan:

- Validación de entradas y filtrado de salidas

- Limitación de tasas y monitoreo del uso de API

- Sandboxes para plugins o flujos de revisión

Consulta la guía de seguridad de DataSunrise para construir un modelo de defensa en profundidad, adaptado a las operaciones de GenAI.

Para reducir la deriva de seguridad inducida por los LLM, algunos equipos implementan un firewall o proxy liviano para analizar el contenido de las indicaciones y redactar cualquier dato no conforme antes de enviarlo al modelo. Las reglas de seguridad contra inyecciones SQL pueden adaptarse para prevenir explotaciones de inyección en las indicaciones.

Protecciones inspiradas en OWASP en resumen

| Categoría | Controles recomendados | Finalidad |

|---|---|---|

| Manejo de entradas | Validación, verificación de longitud, filtrado de tokens | Prevenir la inyección de indicaciones y mal uso |

| Acceso a datos | Controles de acceso basados en roles, auditoría en tiempo real, enmascaramiento | Garantizar el menor privilegio y el cumplimiento |

| Filtrado de salidas | Filtros con expresiones regulares, verificación de toxicidad, redacción | Limitar la exposición de datos perjudiciales o privados |

| Uso de plugins y herramientas | Listas blancas de plugins, sandboxing, limitación de tasas | Reducir el compromiso del modelo a través de integraciones |

| Registro de cumplimiento | Registros de auditoría, reglas de alerta, clasificación de datos | Apoyar los requisitos del GDPR, HIPAA, PCI DSS |

Cumplimiento: Cuando la IA se encuentra con la regulación

Adoptar LLM no exime a una organización de cumplir con las normativas. Al contrario, regulaciones como SOX, PCI DSS y HIPAA se aplican de manera aún más estricta cuando agentes automatizados acceden o actúan sobre datos sensibles.

Utilizar una infraestructura de IA consciente del cumplimiento que combine registros de auditoría, enmascaramiento y herramientas de generación de informes permite a las empresas documentar evidencia para auditorías y demostrar la aplicación de políticas.

Varias iniciativas de código abierto también están surgiendo para estandarizar los registros de auditoría de IA, como el PyRIT de Microsoft y los esfuerzos de la UE en torno a la Ley de IA.

Conclusión: Construyendo sistemas LLM seguros y conformes

Seguir las Directrices de seguridad OWASP para LLM no se trata de limitar la innovación, sino de garantizar confianza, responsabilidad y alineación con una seguridad a nivel empresarial. Al combinar auditoría en tiempo real, enmascaramiento dinámico y descubrimiento de datos, las organizaciones pueden dominar la complejidad de GenAI y desbloquear su máximo potencial sin exponerse a riesgos indebidos.

Para profundizar, explora al gestor de cumplimiento de DataSunrise y sus perspectivas de seguridad LLM/ML para proteger bases de datos híbridas y potenciadas por IA.