Estrategias de Protección de Datos en Entornos de GenAI y LLM

La inteligencia artificial generativa (GenAI) y los modelos de lenguaje a gran escala (LLMs) están revolucionando la forma en que las organizaciones automatizan, analizan y generan contenido. Estos sistemas operan sobre conjuntos de datos masivos — a menudo conteniendo información sensible o regulada. Sin las salvaguardas adecuadas, pueden exponer datos privados de forma involuntaria o reproducirlos en los resultados. Ese riesgo se amplifica cuando estos modelos se integran en flujos de producción para atención al cliente, programación o análisis. Expertos, como los del Centro Berkman Klein de Harvard, han expresado preocupaciones sobre cómo los LLM manejan datos sensibles de entrenamiento.

Estrategias Fundamentales de Protección de Datos en Entornos de GenAI y LLM

Para mantener el control sobre los datos sensibles en los sistemas GenAI, las empresas deben adoptar defensas en capas. Las estrategias más efectivas combinan la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento automatizado y la aplicación de políticas. Exploremos cómo estas técnicas trabajan en conjunto para crear protecciones robustas.

Auditoría en Tiempo Real y Registro Transparente

La auditoría en tiempo real ayuda a detectar y comprender cómo se accede o consulta la información mediante procesos GenAI. Por ejemplo, si una solicitud activa accidentalmente el acceso a direcciones de clientes, una pista de auditoría en vivo registra ese evento para una revisión inmediata. Esto resulta especialmente valioso cuando los LLM se conectan a bases de datos utilizando búsqueda vectorial o generación aumentada por recuperación (RAG).

DataSunrise proporciona reglas de auditoría flexibles y seguimiento de sesiones que capturan consultas SQL, sesiones de usuario y anomalías en el comportamiento. Estos registros de auditoría pueden ser exportados o integrados con herramientas SIEM, proporcionando una capa continua de cumplimiento. Conozca más sobre las opciones de configuración de auditoría.

La importancia de la capacidad de auditoría en los LLM se destaca en iniciativas como la Tarjeta de Sistema para GPT-4 de OpenAI, que resalta los riesgos en torno a la fuga involuntaria de información.

SELECT * FROM customers WHERE notes ILIKE '%refund%';

Si tal consulta es activada por un modelo GenAI, se registra de inmediato, se etiqueta según el nivel de riesgo y, opcionalmente, se bloquea o enmascara conforme a la política.

Enmascaramiento Dinámico de Datos en Tiempo de Ejecución

El enmascaramiento estático es útil para anonimizar conjuntos de datos antes del entrenamiento, pero en los flujos de trabajo de producción de GenAI, el enmascaramiento dinámico es esencial. Esta técnica oculta campos sensibles en tiempo real sin modificar los datos fuente. Cuando un agente GenAI consulta el backend, las respuestas enmascaradas garantizan el cumplimiento sin interrumpir el servicio.

-- Ejemplo: Aplicar enmascaramiento dinámico a la columna SSN

CREATE MASKING RULE mask_ssn

ON customers(ssn)

USING FULL MASK;

El enmascaramiento dinámico garantiza que los LLM entrenados con fuentes de datos en vivo nunca devuelvan identificadores sin procesar, incluso cuando sus solicitudes sean inesperadas o maliciosas. Combinado con políticas RBAC, limita la exposición para usuarios y agentes de IA específicos.

Como señala NIST en su Marco de Gestión de Riesgos en IA, los controles de acceso conscientes del contexto y el enmascaramiento son fundamentales para proteger conjuntos de datos de alto valor en sistemas de IA.

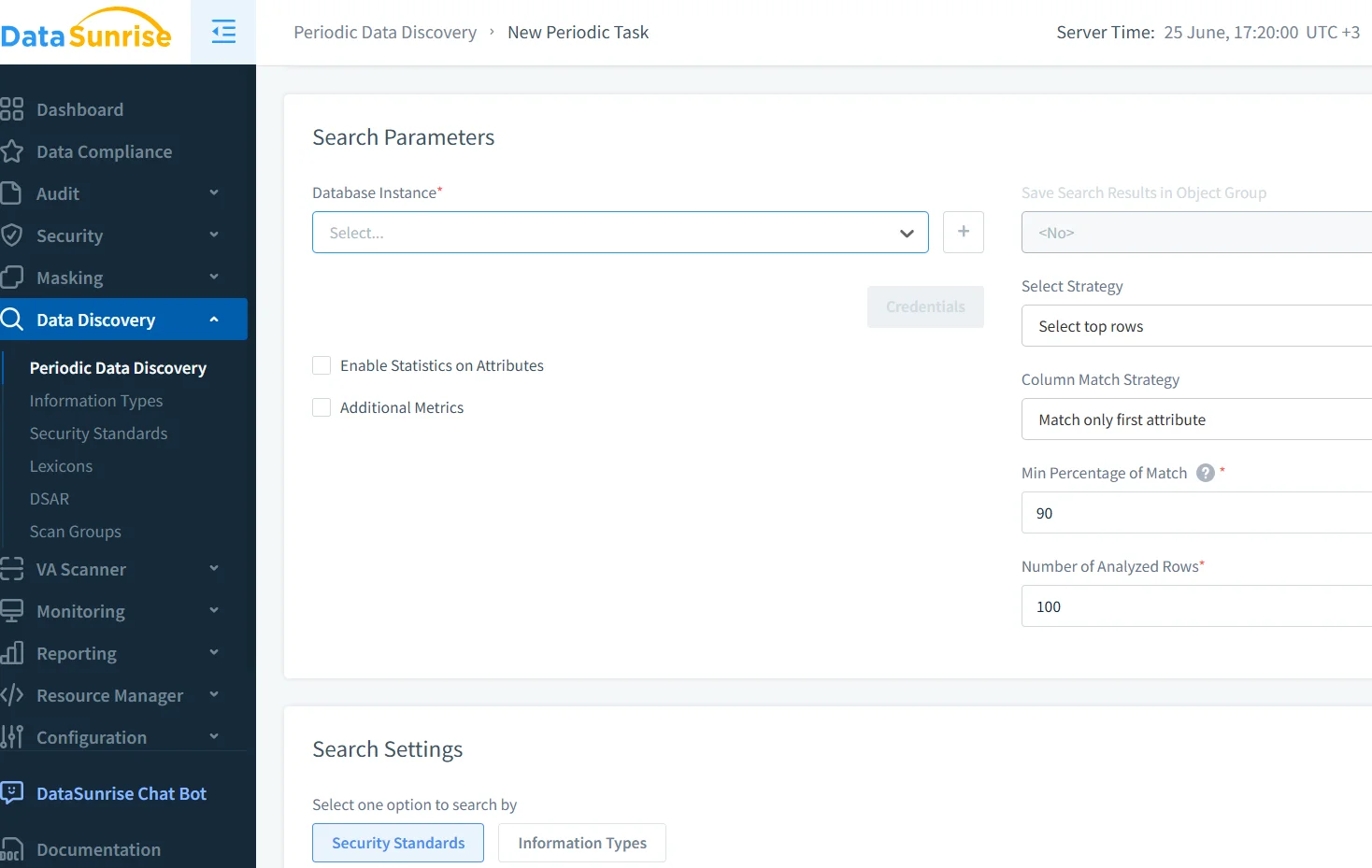

Descubrimiento y Clasificación de Datos Automatizados

Antes de poder proteger los datos, es necesario saber dónde se encuentran. Los escaneos automatizados de descubrimiento de datos ayudan a localizar información personal identificable (PII), información de salud protegida (PHI), registros financieros o contenido regulado en almacenes estructurados y semiestructurados. Esto es fundamental para las aplicaciones GenAI que extraen datos de múltiples lagos de datos o índices vectoriales.

DataSunrise permite realizar escaneos periódicos o bajo demanda, con etiquetado y clasificación de sensibilidad. Combinado con los módulos de auditoría y enmascaramiento, el descubrimiento mejora la visibilidad y garantiza que no se pasen por alto nuevas fuentes.

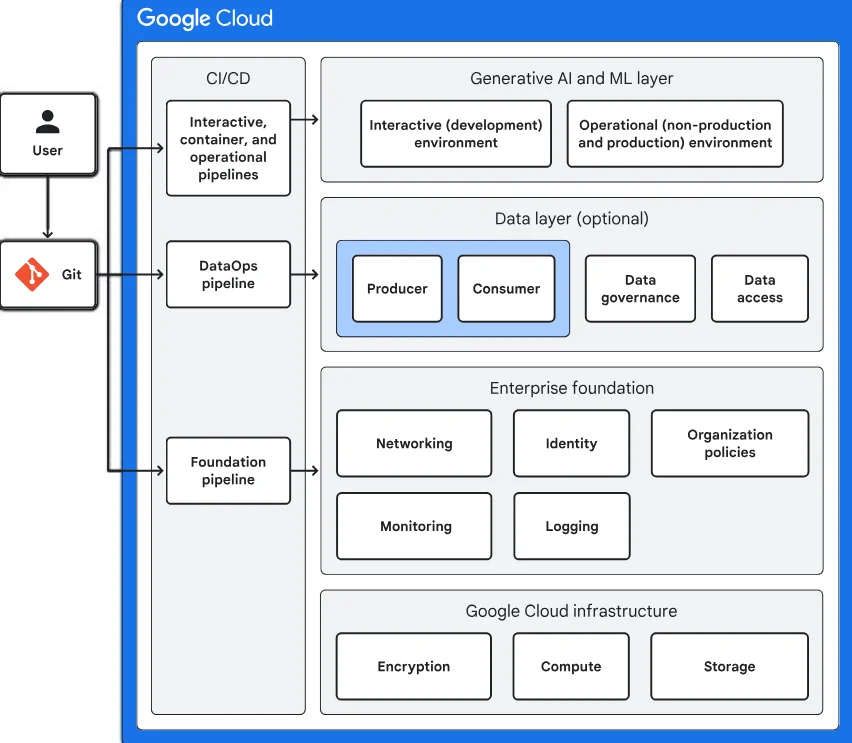

Herramientas como la Protección de Datos Sensibles de Google ofrecen enfoques complementarios para la clasificación automática en entornos nativos en la nube.

Implementación de Seguridad en Despliegues de GenAI

Más allá de la auditoría y el enmascaramiento, los despliegues de GenAI necesitan protección activa contra amenazas como la inyección de solicitudes, la fuga de inferencias o la memorización accidental. Varias técnicas adicionales contribuyen a esto:

- Análisis de comportamiento para detectar patrones de consultas inusuales

- Controles de acceso basados en políticas para integraciones externas

- Prevención de inyección SQL durante la traducción del lenguaje natural

DataSunrise integra estas técnicas a través de su plataforma de seguridad de datos. Con reglas de seguridad adaptadas a los flujos de trabajo de GenAI, los administradores pueden inspeccionar las secuencias de entrada/salida y bloquear operaciones sospechosas antes de que alcancen la capa de la base de datos.

La investigación del Centro de Investigación sobre Modelos Fundamentales de Stanford ilustra aún más la necesidad de salvaguardas en tiempo de ejecución y marcos de seguridad multicapa al desplegar LLM.

Alineación Regulatoria y Gestión de Cumplimiento

El cumplimiento suele ser el catalizador de las estrategias de protección de datos. Ya sea que sus modelos GenAI interactúen con datos de clientes bajo GDPR, HIPAA o PCI DSS, los riesgos de un manejo inadecuado son significativos. Los gestores de cumplimiento automatizados ayudan a hacer cumplir los requisitos mediante plantillas predefinidas, reglas de auditoría e informes exportables.

Por ejemplo, bajo el GDPR, cada instancia de acceso a datos personales debe ser rastreable y limitada. Los registros de auditoría, los registros de control de acceso y las reglas de enmascaramiento, en conjunto, cumplen con ese requisito sin degradar el rendimiento o la capacidad del LLM.

La guía del ICO sobre IA y protección de datos bajo el RGPD del Reino Unido proporciona pasos prácticos para garantizar que las operaciones de los LLM se alineen con la ley de privacidad.

Mejores Prácticas para la Protección de Datos en GenAI

Para mantener la integridad de los datos y reducir riesgos en los flujos de trabajo de GenAI, las organizaciones deben:

- Habilitar la auditoría en tiempo real para todas las bases de datos conectadas a la IA

- Utilizar enmascaramiento dinámico para evitar el acceso directo a datos personales identificables

- Realizar escaneos de descubrimiento automatizados en todas las nuevas fuentes de datos

- Aplicar políticas de acceso contextuales para los servicios LLM

- Automatizar la elaboración de informes de cumplimiento en todas las regiones y estándares

Estas prácticas pueden ampliarse aún más utilizando generación de datos sintéticos, red teaming para solicitudes de LLM y validación de salidas de modelos, especialmente en entornos regulados como finanzas o salud. El Future of Privacy Forum discute muchas de estas técnicas en su exploración de despliegues responsables de IA.

Conclusión

Las Estrategias de Protección de Datos en Entornos de GenAI y LLM deben abordar los riesgos únicos de la inferencia, la ingeniería de solicitudes y el acceso dinámico. Con herramientas como la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento automatizado y la aplicación de políticas ofrecidas por plataformas como DataSunrise, los equipos pueden ampliar de forma segura la adopción de GenAI sin comprometer los datos sensibles ni el cumplimiento regulatorio. A medida que GenAI sigue evolucionando, también deben evolucionar los mecanismos de defensa que incorporamos en su arquitectura.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora