Estrategias de Protección de Datos para Arquitecturas genAI

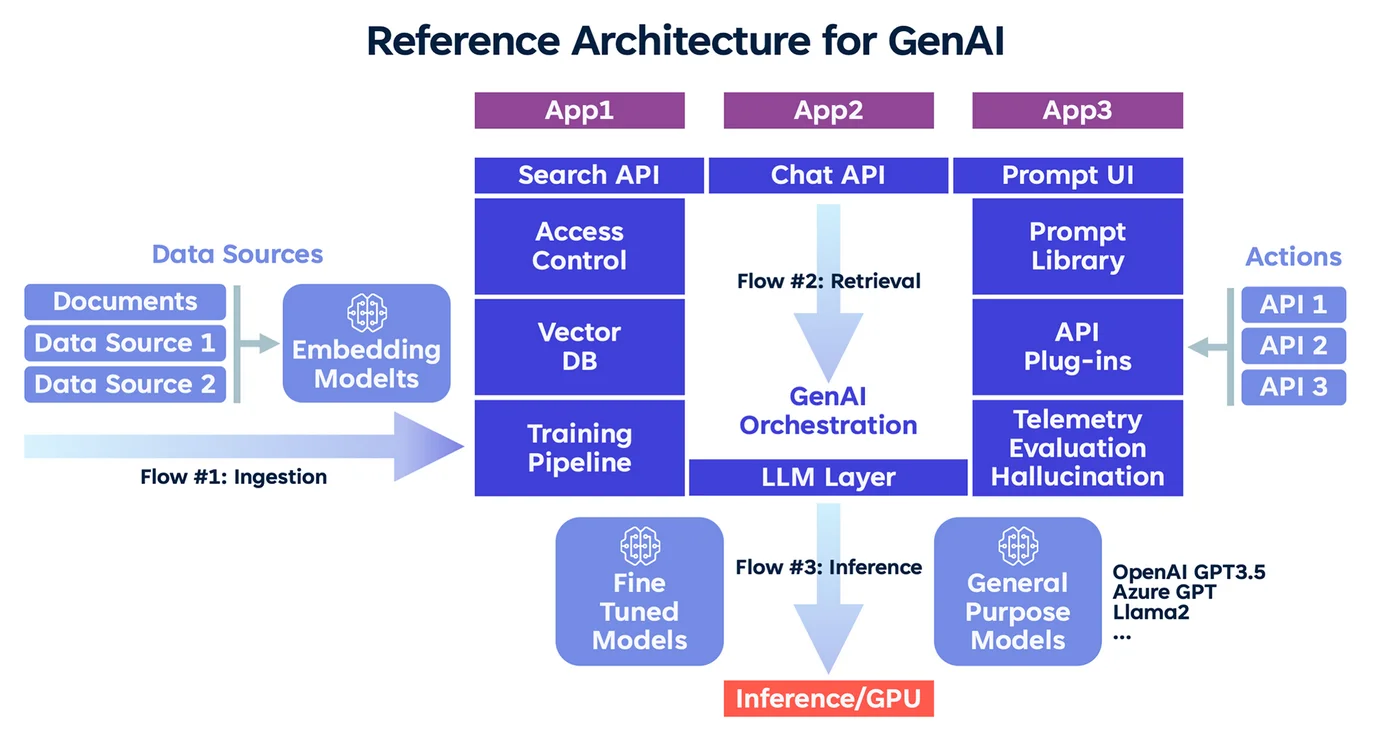

La IA generativa está transformando la manera en que las organizaciones interactúan con los datos. Sin embargo, a medida que evolucionan sus capacidades, también lo hacen los riesgos, especialmente cuando grandes modelos de lenguaje procesan información personal, financiera o propietaria. Diseñar sistemas genAI seguros requiere un enfoque deliberado en la privacidad, el control y la visibilidad.

Este artículo explora estrategias esenciales de protección de datos para arquitecturas genAI, incluyendo auditoría en tiempo real, enmascaramiento dinámico, descubrimiento de datos y gestión del cumplimiento. En conjunto, estos enfoques aseguran que la innovación no comprometa la integridad de la información.

Por qué la genAI Exige Protecciones Más Estrictas

Los modelos genAI están diseñados para generar resultados basados en patrones aprendidos. Aunque esto los hace útiles para la generación de contenido, resumir información o completar código, también introduce riesgos. Los modelos pueden memorizar datos sensibles, revelar artefactos de entrenamiento o producir contenido alucinatorio con información regulada.

Estos riesgos se amplifican cuando las indicaciones, los datos del usuario y las representaciones intermedias no se controlan adecuadamente. Un marco de protección robusto debe monitorear, redactar y hacer cumplir las políticas en tiempo real.

Auditoría en Tiempo Real como Capa de Control

Los registros de auditoría ya no son opcionales para los sistemas de IA: son una necesidad para el cumplimiento y la seguridad. Registrar cada consulta, interacción del usuario y salida del modelo permite a los equipos reconstruir secuencias de riesgo, detectar intentos de inyección de indicaciones y generar informes de cumplimiento para regulaciones como el GDPR o HIPAA.

Herramientas como DataSunrise Audit proporcionan registros en tiempo real en bases de datos y aplicaciones, capturando tanto la actividad estructurada como la no estructurada. Combinado con análisis del comportamiento, las organizaciones pueden identificar anomalías en cómo se accede o se utiliza indebidamente la genAI.

-- Ejemplo: tabla de auditoría para indicaciones y respuestas

CREATE TABLE genai_audit (

id SERIAL PRIMARY KEY,

user_id TEXT,

prompt TEXT,

response TEXT,

timestamp TIMESTAMPTZ DEFAULT now()

);

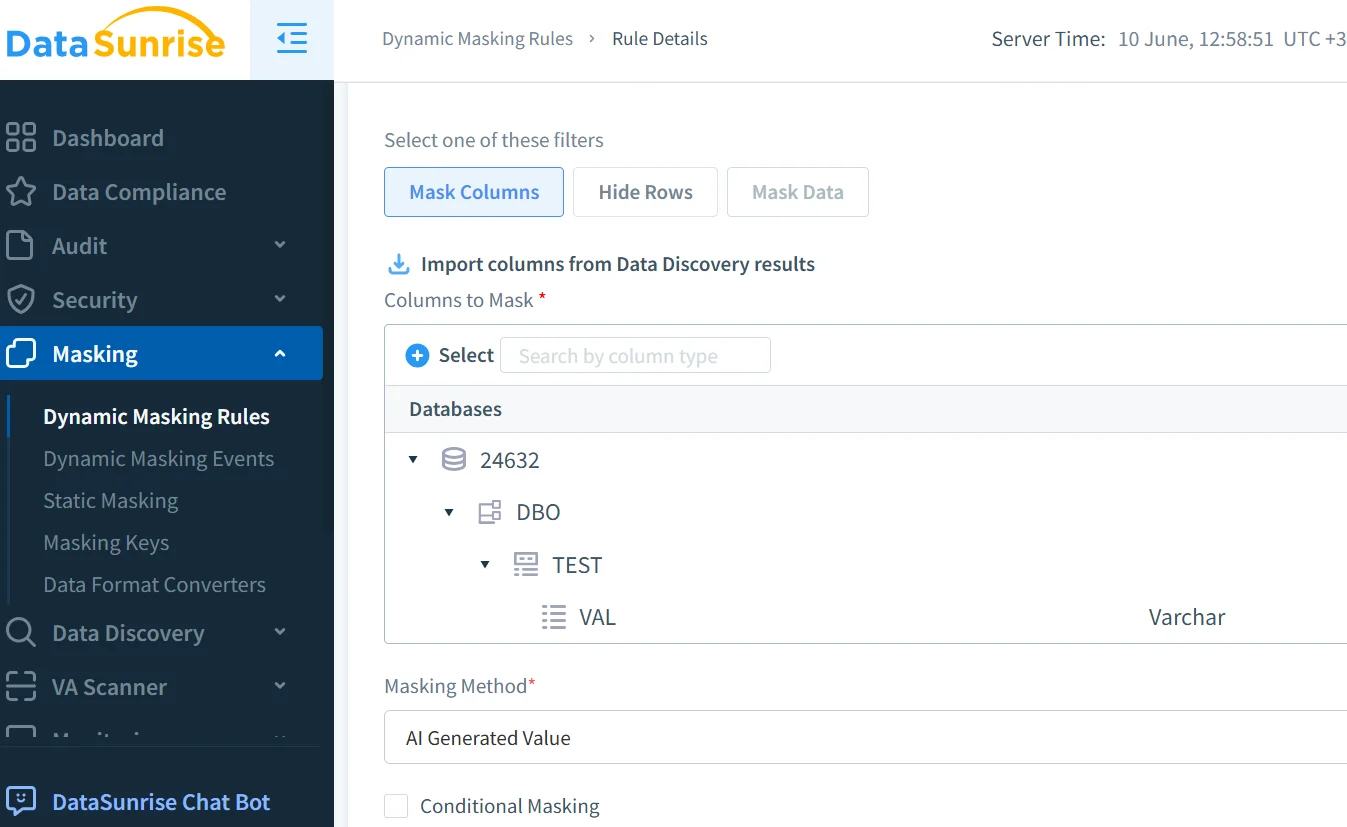

Enmascaramiento Dinámico para Prevenir Fugas

Una de las protecciones más efectivas es el enmascaramiento dinámico, que redacta contenido sensible durante el procesamiento de la IA o la generación de respuestas. A diferencia del enmascaramiento estático, se adapta en tiempo real, lo cual es esencial para tareas generativas.

Por ejemplo, si una indicación incluye un número de seguro social, los motores de enmascaramiento pueden interceptarlo y ocultarlo antes de que el modelo procese la entrada.

El enmascaramiento dinámico de DataSunrise se integra con sistemas NLP, aplicando reglas detalladas que se adaptan al contexto y a los roles. Esto previene la exposición de información personal identificable (PII) y se alinea con los controles de acceso basados en roles.

Descubrimiento de Datos para Canales de Entrada de la IA

No se puede proteger lo que no se sabe que existe. Las herramientas de descubrimiento de datos escanean lagos de datos, almacenes de vectores y entradas de modelos. Ayudan a localizar información personal identificable (PII), información de salud protegida (PHI) y datos relacionados con tarjetas de pago (PCI), descubriendo contenido sensible de entrenamiento y exponiendo bases de datos ocultas que a menudo se pasan por alto en revisiones manuales.

Utilizando las capacidades de descubrimiento de datos de DataSunrise, los equipos pueden automatizar la clasificación antes de que los conjuntos de datos ingresen al flujo de trabajo de entrenamiento o inferencia. Esto ayuda a hacer cumplir los límites de retención, el uso basado en el consentimiento y la redacción.

Alineación con Marcos de Cumplimiento de Datos

La protección de datos en genAI no se trata solo de buenas prácticas; es un requisito de cumplimiento. Dependiendo de la industria y la geografía, las organizaciones pueden necesitar cumplir con el GDPR en Europa, HIPAA en el sector de la salud o PCI DSS en el sector financiero.

Herramientas de cumplimiento como DataSunrise Compliance Manager respaldan la automatización en la generación de informes y las políticas de seguridad de datos. Estas pueden vincularse a puntos finales de IA, garantizando que las indicaciones y resultados se procesen de acuerdo con los estándares legales y éticos.

Seguridad Integral en Flujos de Trabajo Impulsados por IA

Más allá del enmascaramiento y la auditoría, la seguridad en genAI debe abordar riesgos a nivel de infraestructura. Esto incluye el uso de controles de proxy inverso para inspeccionar el tráfico de modelos de lenguaje, aplicar detección de inyección SQL en consultas integradas y hacer cumplir políticas de acceso con mínimo privilegio tanto en el modelo como en las capas de la base de datos.

Cuando los modelos consultan bases de datos o enriquecen contenido utilizando la generación aumentada por recuperación (RAG), estos controles previenen el movimiento lateral y la exposición excesiva de datos.

Construir GenAI que Respeten Límites

El verdadero objetivo de la protección de datos en genAI no es restringir, sino posibilitar un uso confiable. Al combinar la visibilidad de la auditoría, el enmascaramiento sensible al contexto y el descubrimiento de datos enfocado en la seguridad, las organizaciones pueden mantener el control sobre la información sensible, posibilitar una adopción escalable de la IA y reducir el riesgo de incumplimiento en los distintos departamentos.

En última instancia, las estrategias de protección de datos para arquitecturas genAI sirven como base para una integración ética, segura y escalable de la IA. Para obtener una comprensión más amplia de los desafíos de privacidad relacionados con la IA, consulte el Marco de Gestión de Riesgos de la IA del NIST. Para explorar prácticas de seguridad de LLM de código abierto, la base de conocimientos MITRE ATLAS es otro recurso externo valioso. El desafío no es solo hacer que la IA sea poderosa, sino hacerla responsable.