Lista de Verificación de Seguridad y Gobernanza de GenAI para LLMs

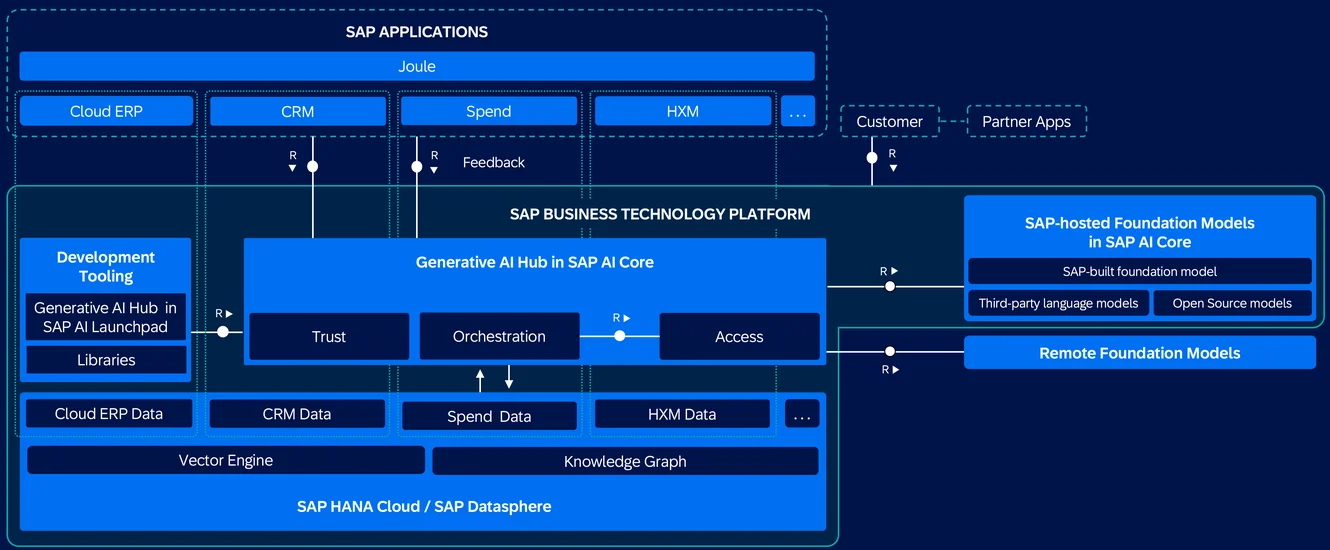

La Inteligencia Artificial Generativa (GenAI), en particular los modelos impulsados por grandes modelos de lenguaje (LLMs), introduce una nueva frontera de innovación—y riesgo. Estos modelos ingieren, generan y procesan datos a gran escala, a menudo extrayendo de fuentes diversas y sensibles. Con gran poder viene la necesidad urgente de contar con una seguridad y gobernanza sólidas.

Esta lista de verificación describe cómo asegurar las canalizaciones de GenAI mediante controles en capas: visibilidad, protección, responsabilidad y automatización.

Monitoreo en Tiempo Real para Cargas de Trabajo de LLM

Los LLMs pueden no parecerse a las bases de datos tradicionales, pero su comportamiento debe registrarse con la misma minuciosidad. Capturar cada interacción—desde los comandos hasta las respuestas generadas—te permite rastrear la exposición de datos sensibles, detectar abusos y satisfacer a los auditores de cumplimiento. Herramientas como Monitoreo de Actividad de Base de Datos proporcionan esta visibilidad en tiempo real.

SELECT * FROM pg_stat_activity WHERE datname = 'llm_logs';

Este ejemplo de PostgreSQL muestra cómo correlacionar las sesiones de la base de datos con los metadatos de uso de LLM.

Consulta también: Reglas de Aprendizaje y Auditoría para ajustar las políticas de auditoría.

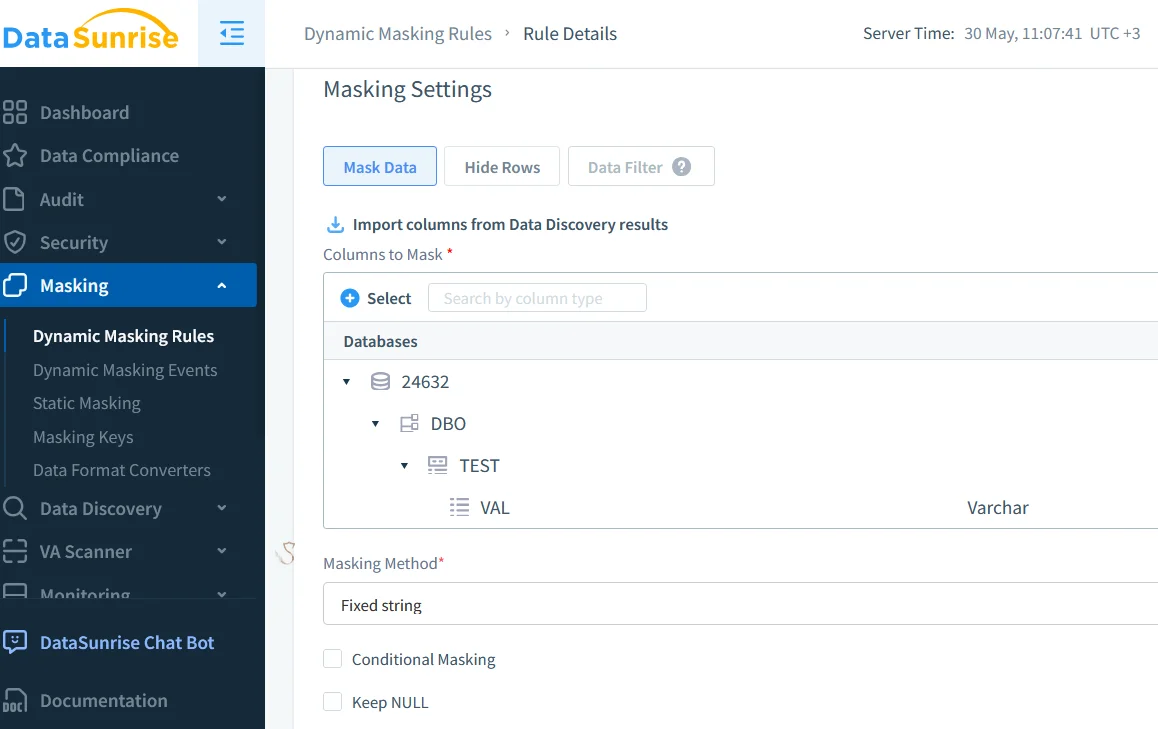

Enmascaramiento de Datos en Tiempo Real en Canalizaciones de GenAI

Datos sensibles, como correos electrónicos de clientes, tokens o registros de salud, no deben filtrarse en los comandos, respuestas o registros. El enmascaramiento dinámico de datos actúa en tiempo real, ajustándose en función del rol del usuario o del nivel de acceso.

Es especialmente valioso en entornos como herramientas de ingeniería de comandos, sistemas basados en RAG y APIs de inferencia compartidas, donde las interacciones de los usuarios son frecuentes y los riesgos de datos son altos.

Para obtener una visión más profunda sobre la protección de campos sensibles, visita el artículo sobre Enmascaramiento en Situ.

Descubrimiento Automatizado de Datos Sensibles

No puedes gobernar lo que no puedes encontrar. Los escaneos automatizados de descubrimiento de datos son cruciales para localizar campos sensibles, especialmente en almacenes vectoriales o canalizaciones multimodales.

Estos escaneos clasifican los comandos de entrada y los datos de los usuarios, etiquetan las salidas para la aplicación de políticas y respaldan necesidades regulatorias como GDPR o HIPAA. Ayudan a los equipos a mantener el control sobre lo que el modelo aprende y genera.

Consulta Tratando los Datos como un Activo Valioso para reforzar tu estrategia de descubrimiento.

Control de Acceso y Restricciones a Nivel de Comando

Los LLMs son susceptibles a abusos mediante inyección de comandos o escaladas a través de plugins. Para reducir estos riesgos, implementa controles de acceso basados en roles (RBAC) y filtros de entrada. Estas medidas previenen fugas de usuarios de baja confianza, limitan el abuso de comandos que apuntan a acciones administrativas y ayudan a gestionar el acceso entre equipos y departamentos.

También puedes explorar Controles de Acceso y el Principio de Mínimos Privilegios para fortalecer los despliegues de LLM.

Gestión Simplificada del Cumplimiento

Las revisiones manuales no escalan. Herramientas como Compliance Manager ayudan a definir mapeos regulatorios, aplicar reglas de acceso y retención, y generar informes bajo demanda.

Por ejemplo:

CREATE MASKING RULE mask_email

ON llm_prompt_logs(email)

USING FULL;

Esta regla garantiza que los datos de correo electrónico se enmascaren antes de ser analizados o exportados.

Puedes explorar más a fondo la importancia de este paso en Generación de Informes.

Recursos que Vale la Pena Explorar

Explora estas referencias para obtener una visión más profunda sobre cómo asegurar las canalizaciones de LLM:

- Marco de Gestión de Riesgos para IA del NIST

- Microsoft IA Responsable

- Top 10 de OWASP para LLMs

- Marco de IA Segura (SAIF) de Google

- Documento de IA Constitucional de Anthropic

Construir para la Visibilidad y la Confianza

Asegurar GenAI se trata de implementar controles inteligentes en capas, no de bloquear la innovación. Tu pila de gobernanza debería incluir auditoría en tiempo real, enmascaramiento sensible al rol, descubrimiento continuo y comprobaciones automáticas de cumplimiento.

Para profundizar, lee sobre Rastros de Auditoría, Seguridad de Datos, Herramientas LLM y ML para la Seguridad de Bases de Datos, y Generación de Datos Sintéticos como una alternativa para probar o entrenar sistemas GenAI de forma segura.