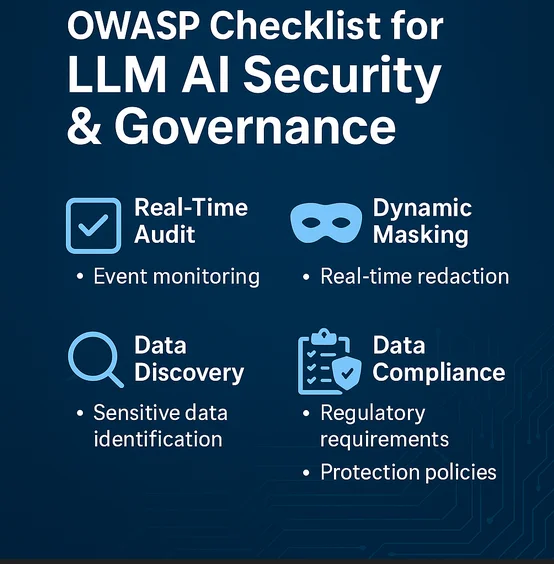

Lista de Verificación OWASP para la Seguridad y Gobernanza de LLM AI

A medida que el uso de modelos de lenguaje grandes (LLMs) se expande en los marcos de seguridad corporativa y gobernanza, la Fundación OWASP ha empezado a resaltar áreas críticas de preocupación. Este artículo explora la aplicación práctica de la Lista de Verificación OWASP para la Seguridad y Gobernanza de LLM AI, centrándose en particular en la auditoría en tiempo real, el enmascaramiento dinámico de datos, el descubrimiento de datos, la seguridad general de la información y el cumplimiento normativo.

Por qué la Lista de Verificación OWASP es Importante para los Sistemas GenAI

Los LLMs como GPT-4 y Claude se están integrando en herramientas que analizan registros, clasifican amenazas o automatizan la respuesta a incidentes. Sin embargo, estos modelos introducen riesgos novedosos, que incluyen ataques de inversión de modelo, inyección de indicaciones, fuga de datos sensibles y uso indebido de repositorios internos de datos. El Top 10 OWASP para LLMs proporciona un marco para identificar y mitigar estos riesgos. Integrar esto con la gobernanza corporativa asegura que la GenAI siga siendo un activo y no una responsabilidad.

Auditoría en Tiempo Real para la Actividad de IA y Cadenas de Decisión

Los LLMs a menudo operan como cajas negras. Registrar las indicaciones de usuario, las respuestas generadas, las decisiones del modelo y las búsquedas de datos en el backend es fundamental para la auditoría. Los sistemas de auditoría en tiempo real, como DataSunrise Audit, pueden interceptar y registrar:

SELECT *

FROM vector_logs

WHERE embedding_model = 'GPT-4' AND confidence_score < 0.5;

Esta consulta de ejemplo puede revelar salidas del modelo con incertidumbre o baja confianza para su revisión. Sistemas como Database Activity Monitoring permiten etiquetar y emitir alertas basadas en patrones de uso inusuales o en el acceso a almacenes de vectores sensibles.

Enmascaramiento Dinámico en Consultas Impulsadas por LLM

Cuando un LLM genera consultas SQL de forma dinámica, existe una posibilidad real de que exponga datos sensibles. Utilizar el enmascaramiento dinámico garantiza que, incluso si una indicación activa una operación de recuperación de datos, información personalmente identificable (PII), como correos electrónicos o números de seguro social, permanezca ofuscada.

Por ejemplo:

SELECT name, MASK(email), MASK(phone_number)

FROM customers

WHERE interaction_type = 'chatbot';

Esto permite que los sistemas impulsados por GenAI funcionen de manera segura en aplicaciones orientadas al cliente sin violar las obligaciones de privacidad.

Descubrimiento de Datos y Filtrado de Entrada de LLM

El descubrimiento de datos efectivo ayuda a identificar cuáles partes del almacén de datos o repositorio de vectores contienen registros sensibles. Combinado con las tuberías de LLM, esto garantiza que las indicaciones de entrada no recuperen o inyecten contexto no autorizado.

OWASP recomienda la clasificación y el filtrado tanto de los datos de entrenamiento como de las indicaciones en tiempo de ejecución para mitigar la fuga de datos. Herramientas como Amazon Macie, el motor de descubrimiento de DataSunrise y el escaneo de metadatos en vectores juegan un papel vital.

Alineación con Políticas de Seguridad y Modelos de Amenaza

Según la guía de OWASP, la superficie de amenaza de los LLMs incluye APIs expuestas, complementos de terceros, configuraciones del modelo inseguras y accesos a bases de datos demasiado permisivos. La gobernanza debe incluir:

Limitar el contexto de salida del modelo mediante indicaciones del sistema.

Aplicar controles de acceso basados en roles (RBAC).

Bloquear consultas peligrosas utilizando un cortafuegos de base de datos.

OWASP también recomienda el análisis de comportamiento para detectar inundaciones de indicaciones o abusos.

Garantizando el Cumplimiento de Datos en el Uso de IA Generativa

El cumplimiento sigue siendo fundamental cuando la GenAI interactúa con datos protegidos (GDPR, HIPAA, PCI DSS). Un gestor de cumplimiento para las tuberías de GenAI ayuda a mapear:

Qué tipos de datos son procesados por el modelo.

Si las salidas se almacenan o registran.

Si la información inferida puede volver a identificar a los usuarios.

En la práctica, esto implica configurar informes automáticos de cumplimiento y combinar las perspectivas del rastro de auditoría con reglas de enmascaramiento y filtrado.

Puntos de Referencia Externos

Varios recursos externos también abordan la intersección entre la GenAI y la gobernanza de datos:

Marco de Gestión de Riesgos de IA del NIST para una gobernanza estructurada.

Estándar de IA Responsable de Microsoft para el despliegue de grandes modelos.

Guía de AWS sobre monitoreo y enmascaramiento en Athena para conjuntos de datos accesibles a la IA.

Estos recursos pueden complementar los principios de OWASP y ayudar a establecer una seguridad integral en el ciclo de vida de la IA.

Conclusión

La Lista de Verificación OWASP para la Seguridad y Gobernanza de LLM AI es más que un documento de políticas. Es un plan para reducir riesgos a medida que la IA generativa se integra en las operaciones de seguridad, en el monitoreo del cumplimiento y en la toma de decisiones. Con herramientas como DataSunrise Audit, el enmascaramiento dinámico y motores de descubrimiento de datos, las organizaciones pueden establecer límites en el comportamiento de la IA, aprovechando al mismo tiempo su potencial.

La gobernanza de datos debe evolucionar junto a la IA. Combinar el enfoque de OWASP con herramientas concretas hace que esto no solo sea posible, sino también práctico.