Medidas de Seguridad para Sistemas de IA Generativa

A medida que la IA generativa continúa transformando industrias, desde las finanzas hasta la atención sanitaria, sus implicaciones en seguridad crecen a la misma velocidad. Estos sistemas procesan enormes cantidades de información sensible y, si quedan desprotegidos, pueden convertirse en una puerta de entrada a brechas de datos, ataques de inyección de indicaciones o exposición no autorizada de la información. En este artículo, exploramos las medidas esenciales de seguridad para sistemas de IA generativa—centrándonos en auditoría en tiempo real, enmascaramiento dinámico, descubrimiento de datos y aplicación del cumplimiento—para garantizar que estos poderosos modelos operen de manera segura.

Por qué la IA Generativa Necesita Seguridad Especializada

A diferencia de las aplicaciones tradicionales, los sistemas de IA generativa aprenden a partir de conjuntos de datos históricos e interactúan mediante indicaciones abiertas. Pueden acceder a datos confidenciales de usuarios o a información sensible de negocios para generar respuestas. Este modelo de interacción introduce dos riesgos principales: la fuga no intencionada de datos en las salidas del modelo y el acceso en sombra a bases de datos sensibles.

Para abordar estos riesgos, los controles de seguridad deben integrarse directamente en las canalizaciones de datos de la IA. Esto incluye no solo la monitorización superficial, sino técnicas conscientes del contexto como el análisis de comportamiento, el enmascaramiento dinámico de datos y la gestión profunda de los registros de auditoría.

Auditoría en Tiempo Real de las Interacciones con la IA

Los registros de auditoría en tiempo real constituyen la base de cualquier sistema de seguridad de IA. Cada interacción—indicaciones enviadas, modelo utilizado y fuente de datos consultada—debe ser rastreada con claridad. Esto permite que los equipos de seguridad reconstruyan la actividad y rastreen comportamientos no autorizados hasta usuarios específicos o patrones en las indicaciones.

Herramientas como la monitorización de actividad de bases de datos de DataSunrise permiten el seguimiento continuo y pueden integrarse con plataformas SIEM para generar alertas cuando se detecten anomalías. Estas pueden incluir reintentos frecuentes de indicaciones, tasas inusuales de consultas o accesos inesperados a columnas protegidas.

Ejemplo (disparador de captura de registro estilo PostgreSQL):

CREATE OR REPLACE FUNCTION log_prompt_event()

RETURNS TRIGGER AS $$

BEGIN

INSERT INTO ai_audit_log(user_id, prompt_text, access_time)

VALUES (current_user, NEW.prompt, NOW());

RETURN NEW;

END;

$$ LANGUAGE plpgsql;

Enmascaramiento Dinámico de Datos en las Canalizaciones de IA

Los modelos de IA generativa que trabajan con bases de datos en vivo pueden, sin intención, revelar información privada en sus respuestas. El enmascaramiento dinámico de datos ayuda a prevenir esto al alterar la visualización de la información dependiendo del contexto. Por ejemplo, un modelo que accede a una base de datos financiera podría devolver valores enmascarados como ****-****-****-1234 al referirse a números de tarjetas de crédito, garantizando que el contenido original permanezca protegido.

El enmascaramiento dinámico de datos puede aplicarse durante la ejecución de consultas o en la capa de respuesta del sistema de IA. La documentación sobre DDM de Microsoft proporciona orientaciones adicionales para su implementación.

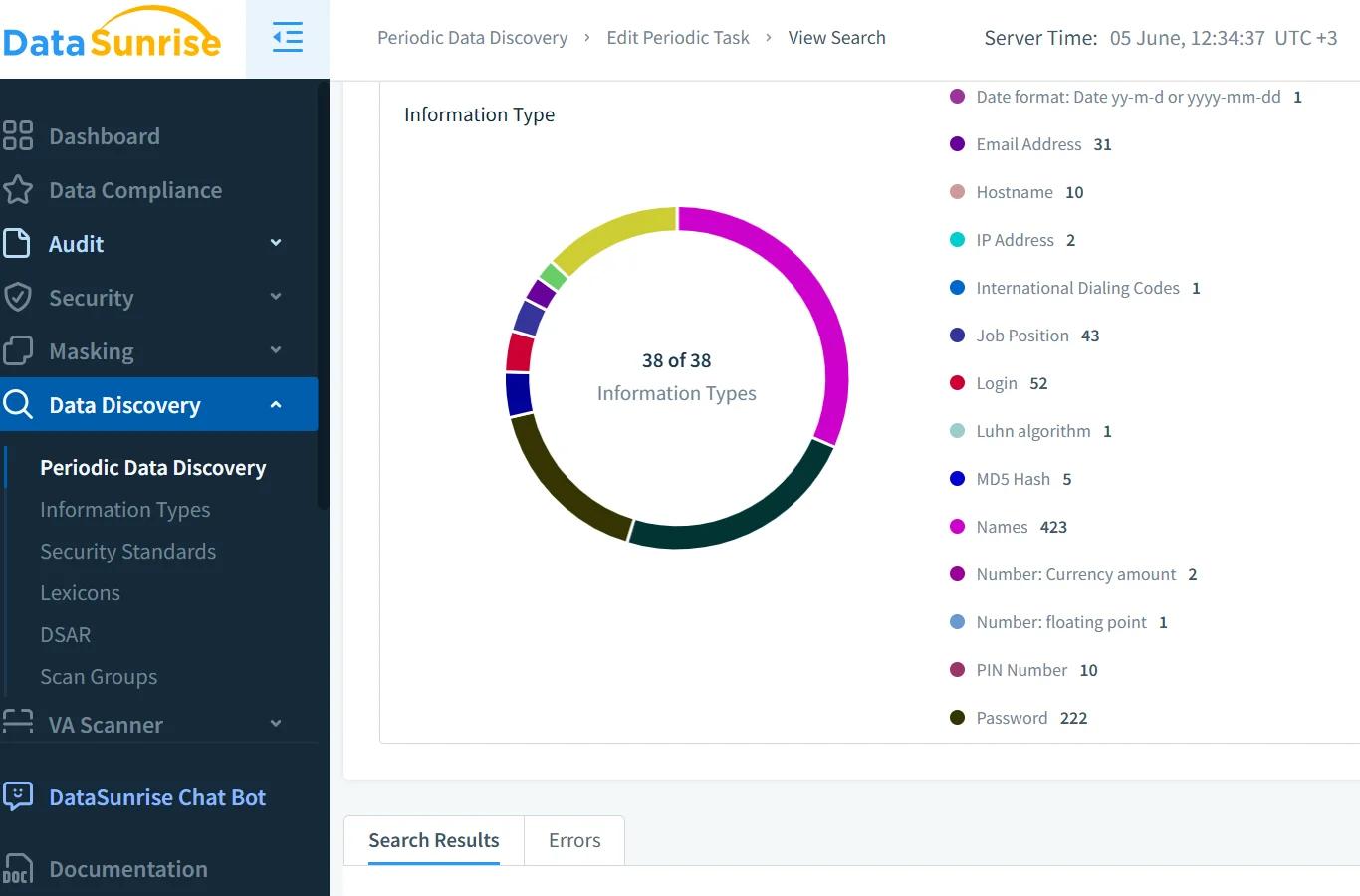

Descubrimiento y Clasificación de Datos Antes del Acceso del Modelo

Antes de que los modelos generativos accedan a datos estructurados, es esencial clasificar el contenido sensible. La información personal identificable (PII), la información de salud protegida (PHI) y los identificadores financieros deben ser identificados con antelación. Esto se logra mediante herramientas automatizadas de descubrimiento de datos que inspeccionan tablas, columnas y contenidos de archivos.

Con la ayuda del motor de descubrimiento de DataSunrise y plataformas nativas en la nube como Google Cloud DLP, las organizaciones pueden etiquetar los datos de forma sistemática y asignar políticas de manejo apropiadas.

Aplicación del Cumplimiento de Datos en los Flujos de Trabajo de LLM

La IA generativa debe operar dentro de los marcos regulatorios tales como GDPR, HIPAA y PCI DSS. Estas normas dictan la forma en que se deben acceder, enmascarar, auditar y reportar los datos.

El Gestor de Cumplimiento de DataSunrise simplifica la aplicación de estas normas mediante la asignación de privilegios de acceso a requisitos específicos de cada regulación. También puede generar reportes adaptados para auditorías y resaltar violaciones en tiempo real. Enfoques complementarios de las directrices de ética en IA de IBM refuerzan el marco para operaciones de IA transparentes y responsables.

Reglas de Seguridad y Gobernanza de Accesos

Los entornos de IA generativa se benefician de políticas de seguridad de gran detalle. Más allá del tradicional RBAC, la seguridad debe involucrar el reconocimiento de intenciones y el perfilado de comportamientos. Un usuario que intente extraer registros privados mediante indicaciones ambiguas—en lugar de consultas explícitas—podría eludir los controles básicos.

Es por esto que reglas mejoradas de mitigación de inyecciones SQL y de seguridad adaptativa son críticas. Estas permiten que los sistemas detecten usos indebidos analizando patrones en las indicaciones, los tiempos de acceso y las desviaciones del comportamiento habitual.

Mirando Hacia el Futuro: IA Más Inteligente, Seguridad Más Inteligente

El futuro de la seguridad en IA reside en la conciencia contextual. Las bases de datos vectoriales, los plugins de terceros y las interfaces de datos en tiempo real abren nuevas superficies de riesgo. Para mitigarlas, las organizaciones están adoptando la detección de anomalías en el comportamiento, alertas en tiempo real y filtrado estratificado de salidas.

Recursos como el Panel de IA Responsable de Microsoft y la metodología de tarjeta del sistema de OpenAI ayudan a los equipos a mapear los patrones de acceso de los modelos. Plataformas como DataSunrise respaldan la aplicación de políticas y la auditoría como parte de una estrategia de seguridad más amplia.

Conclusión

El auge de los LLMs ha redefinido cómo debe ser una infraestructura segura. Los sólidos registros de auditoría, el enmascaramiento dinámico, el descubrimiento de datos sensibles y el cumplimiento en tiempo real son ahora esenciales, no opcionales.

Al implementar estas medidas de seguridad para sistemas de IA generativa, se sienta la base para una IA responsable y se reduce el riesgo de consecuencias reputacionales o legales.

Explora el centro de conocimiento de DataSunrise y complementa tu estrategia de seguridad con marcos como el NIST AI RMF, la ISO/IEC 23894 o los Principios de IA de la OCDE.