Mitigando riesgos de seguridad de la IA

A medida que los modelos de IA generativa (GenAI) se vuelven parte integral de la infraestructura moderna, traen consigo nuevos vectores de exposición a riesgos de seguridad. Desde consultas SQL alucinadas y fugas de datos no intencionadas hasta la inyección maliciosa de solicitudes, la GenAI está transformando el panorama de riesgos. Este artículo explora estrategias prácticas para mitigar los riesgos de seguridad de la IA mediante defensas en capas como la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento de datos y la aplicación robusta del cumplimiento normativo.

Por qué GenAI plantea desafíos únicos de seguridad

Los sistemas de GenAI operan con lógica probabilística, lo que significa que pueden generar resultados impredecibles basados en solicitudes con estructuras poco definidas. Estos resultados pueden incluir datos sensibles de clientes, información personal identificable (PII) o credenciales de acceso aprendidas durante el entrenamiento o recogidas a lo largo del encadenamiento de solicitudes. Peor aún, los usuarios que interactúan con sistemas GenAI podrían extraer información no autorizada si no se imponen barreras de protección.

Considera un caso en el que un agente de GenAI genera consultas SQL para analizar datos de compras de clientes. Una solicitud maliciosa podría engañarlo para que ejecute lo siguiente:

SELECT * FROM customers WHERE ssn IS NOT NULL;

Si esta consulta evade las reglas de seguridad, podría filtrar registros sensibles. Por ello, el análisis contextual y los controles dinámicos son fundamentales para prevenir abusos.

Otro ejemplo podría involucrar intentos de enumerar el esquema de la base de datos:

SELECT table_name FROM information_schema.tables WHERE table_schema = 'public';

Esto podría exponer estructuras de tablas útiles para ataques futuros.

Auditoría en Tiempo Real para Sistemas de IA

La auditoría en tiempo real es la primera línea de defensa para los despliegues de GenAI. Captura y registra interacciones, consultas y acciones resultantes para identificar usos indebidos o violaciones de políticas. Los registros de auditoría también desempeñan un papel crucial en el análisis forense y en la respuesta ante exigencias regulatorias.

Herramientas como el motor de reglas de auditoría de DataSunrise permiten a las organizaciones definir disparadores específicos para consultas iniciadas mediante agentes GenAI. Combinado con el monitoreo de la actividad de la base de datos, estos registros brindan visibilidad sobre cómo los modelos interactúan con fuentes de datos estructuradas y no estructuradas.

A continuación, se muestra un ejemplo de un patrón de regla de registro:

WHEN query_text LIKE '%ssn%' THEN log_event;

Enmascaramiento Dinámico como Barrera Segura para la IA

Una de las formas más efectivas de prevenir la exposición de datos sensibles es enmascarar dinámicamente la salida en tiempo real. A diferencia del enmascaramiento estático, que modifica los datos en reposo, el enmascaramiento dinámico opera sobre la marcha. Esto significa que campos sensibles como números de tarjetas de crédito, identificaciones nacionales o direcciones son reemplazados por valores de sustitución cuando se accede a través de interfaces impulsadas por IA.

DataSunrise admite políticas de enmascaramiento dinámico que pueden delimitarse por roles, contexto de consulta u origen de la aplicación. Cuando se combinan con interfaces LLM, estas políticas aseguran que, incluso si una solicitud intenta acceder a campos restringidos, el modelo solo vea datos enmascarados.

Ejemplo de regla de enmascaramiento dinámico:

MASK COLUMN customers.credit_card USING 'XXXX-XXXX-XXXX-####';

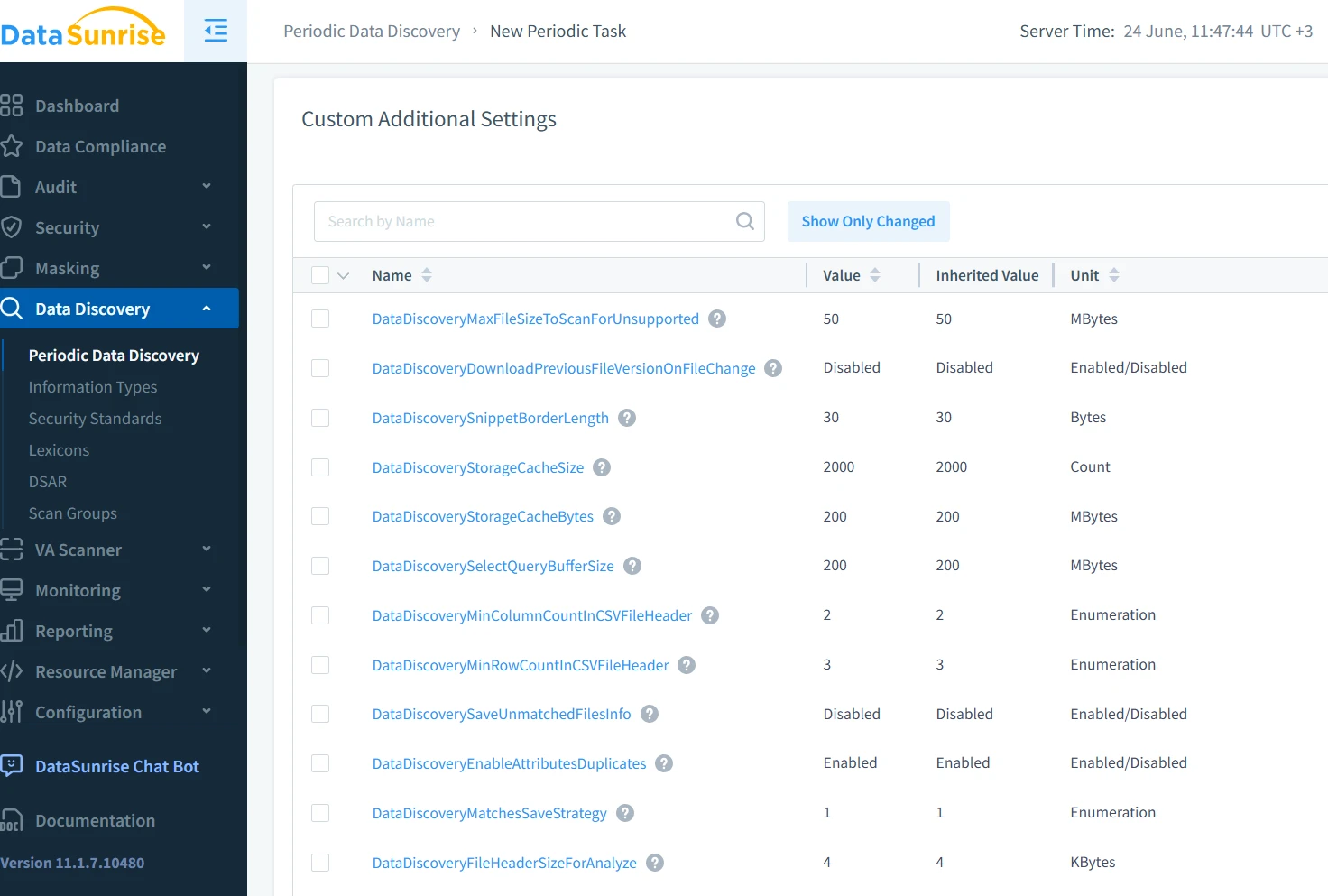

Descubrimiento de Datos para el Mapeo de Acceso Sensible de la IA

Antes de poder proteger los datos contra el uso indebido de GenAI, es necesario saber dónde se encuentran. Las herramientas de descubrimiento de datos identifican y clasifican registros sensibles en bases de datos, lagos de datos y sistemas de archivos. Esto incluye tanto campos estructurados (como nombre y correo electrónico) como patrones semiestructurados (como registros y transcripciones de chats).

El descubrimiento automatizado de datos ayuda a crear mapas de sensibilidad contextual que informan las políticas de acceso y guían los límites de interacción del modelo. Este enfoque proactivo asegura que tanto desarrolladores como auditores comprendan qué datos puede acceder el sistema de IA durante su ejecución.

Por ejemplo, un escaneo sencillo podría identificar correos electrónicos mediante una expresión regular:

[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Za-z]{2,}

Aplicación de Seguridad y Cumplimiento

La seguridad en la IA no se trata solo de prevenir fugas de datos, sino también de cumplir con los estándares legales y regulatorios. Marcos como el GDPR, HIPAA y PCI-DSS ahora requieren una protección continua de los datos, controles de acceso basados en roles y registros auditable, requisitos que se aplican de igual forma a los sistemas impulsados por IA.

La integración de una plataforma de automatización del cumplimiento garantiza el seguimiento y la aplicación en tiempo real de estos estándares en todas las interacciones de los usuarios, incluidas las sesiones de GenAI. Esto permite a las organizaciones implementar políticas como el principio de acceso mínimo privilegiado, limitar el alcance de datos sensibles y asegurar la trazabilidad posterior.

Ejemplo de restricción de roles:

GRANT SELECT ON orders TO analyst_role;

REVOKE SELECT ON customers FROM analyst_role;

Utilizando informes automáticos de cumplimiento, los equipos de seguridad pueden generar registros listos para auditoría que detallan cada interacción de la IA con datos regulados, reduciendo el esfuerzo manual y los errores humanos en las auditorías de seguridad.

Combinando Medidas para una Defensa en Profundidad

Cada uno de estos mecanismos —la auditoría en tiempo real, el enmascaramiento, el descubrimiento y el cumplimiento— proporciona una protección parcial. Pero cuando se combinan, forman una defensa en capas mucho más resiliente. Esto es especialmente importante en contextos de GenAI donde ningún control individual puede predecir o prevenir por completo comportamientos de riesgo.

Imagina este flujo: un LLM genera una consulta SQL; el sistema audita la solicitud, aplica enmascaramiento a los campos PII, filtra los datos y registra la interacción. Mientras tanto, los motores de cumplimiento buscan posibles violaciones de las políticas. Este enfoque holístico mitiga el riesgo sin obstaculizar la innovación.

Prácticas Externas y Perspectivas Futuras

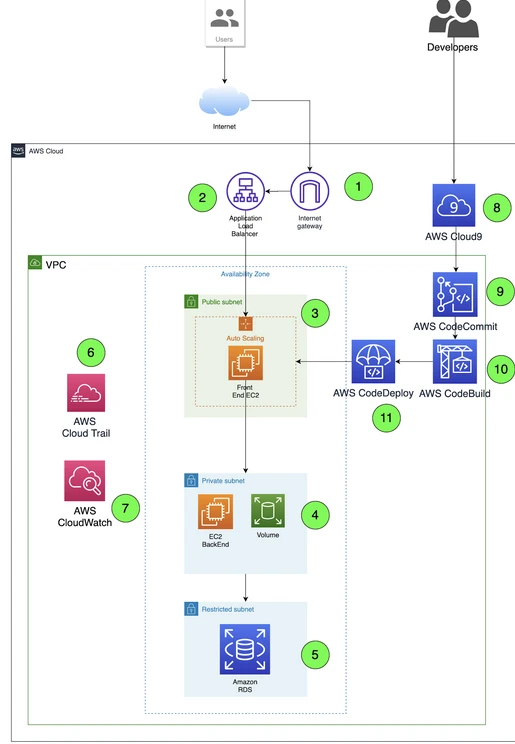

Además de las protecciones integradas en la plataforma, las mejores prácticas de proveedores en la nube como AWS Macie y SecurityHub están evolucionando para abordar las inquietudes relacionadas con GenAI. Estos servicios se integran con herramientas como Lake Formation o CloudTrail para monitorear el uso de datos sensibles y el comportamiento de los usuarios en flujos de trabajo de IA.

A medida que evoluciona la seguridad en la IA, también deben hacerlo las herramientas que utilizamos. El desafío no es solo técnico, sino también filosófico. ¿Cómo aseguramos sistemas que razonan y se adaptan por sí mismos? Todo comienza con la concientización, el uso de herramientas adecuadas y el diseño proactivo de políticas.

Conclusión

La GenAI está transformando industrias, pero también está cambiando el panorama de amenazas. Mitigar los riesgos de seguridad de la IA requiere más que firewalls tradicionales o roles de usuario; demanda una estrategia multinivel y consciente del contexto. Auditorías en tiempo real, enmascaramiento dinámico, descubrimiento de datos y herramientas automáticas de cumplimiento, como las de DataSunrise, son esenciales para asegurar infraestructuras impulsadas por IA sin obstaculizar su potencial.