Optimizar Flujo de Trabajo de Datos

Para empresas orientadas a los datos, el procesamiento eficiente de la información es crucial para que los negocios obtengan conocimientos y tomen decisiones fundamentadas. Sin embargo, al tratar con información sensible, es esencial equilibrar la velocidad y la eficiencia con la privacidad y seguridad de los datos. Este artículo analiza formas de simplificar los flujos de trabajo de datos utilizando métodos ETL y ELT, al mismo tiempo que se protege la privacidad de la información.

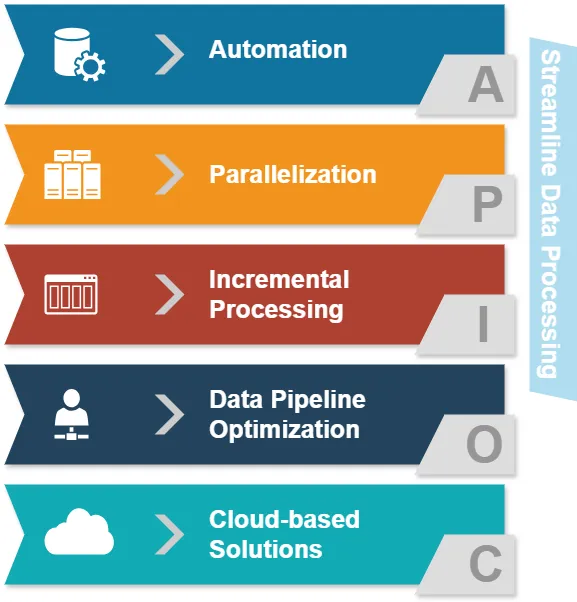

Entendiendo los Enfoques para Optimizar el Procesamiento de Datos

Antes de profundizar en ETL y ELT, examinemos los enfoques comunes para optimizar el procesamiento de datos:

- Automatización: Reducir las intervenciones manuales en las tareas de procesamiento de datos.

- Paralelización: Procesar múltiples flujos de datos simultáneamente.

- Procesamiento incremental: Actualizar solo los datos modificados en lugar de conjuntos de datos completos.

- Optimización de la canalización de datos: Asegurar un flujo de datos fluido entre las diferentes etapas.

- Soluciones basadas en la nube: Aprovechar infraestructuras escalables para el procesamiento de datos.

Estos enfoques tienen como objetivo mejorar la eficiencia del procesamiento de datos. Ahora, exploremos cómo ETL y ELT se integran en este panorama.

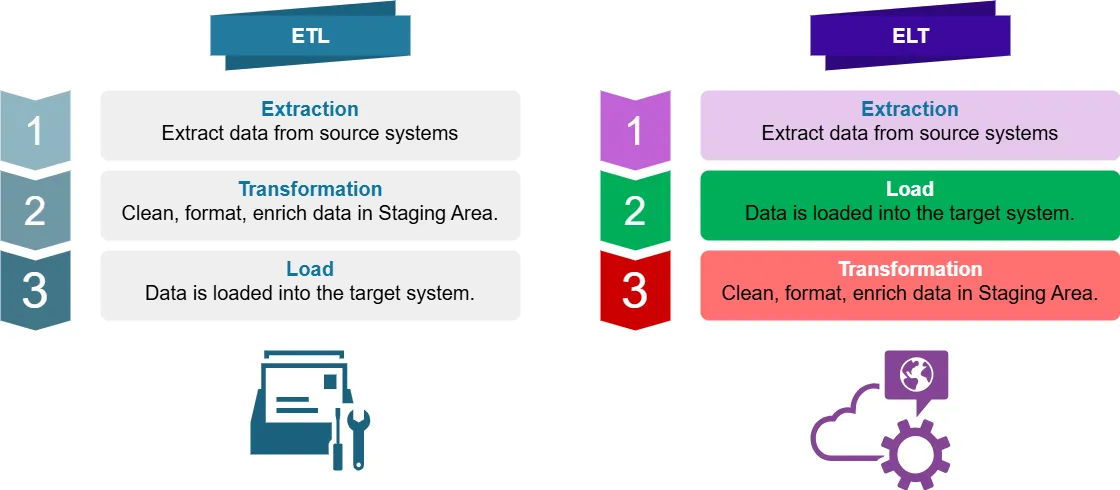

ETL vs. ELT: Una Comparativa en Pocas Palabras

¿Qué es ETL?

ETL significa Extraer, Transformar, Cargar. Es un proceso tradicional de integración de datos en el que los datos son:

- Extraídos de los sistemas de origen

- Transformados (limpiados, formateados, enriquecidos) en un área de preparación

- Cargados en el sistema objetivo (por ejemplo, un almacén de datos)

¿Qué es ELT?

ELT significa Extraer, Cargar, Transformar. Es un enfoque moderno en el que los datos son:

- Extraídos de los sistemas de origen

- Cargados directamente en el sistema objetivo

- Transformados dentro del sistema objetivo

Diferencias Clave en el Procesamiento Óptimo de Datos

Para la inteligencia empresarial, la principal diferencia entre ETL y ELT reside en dónde y cuándo ocurre la transformación de los datos. Esto repercute en el procesamiento óptimo de los datos de varias maneras:

- Potencia de procesamiento: ETL depende de servidores de transformación separados, mientras que ELT aprovecha la potencia del sistema objetivo.

- Flexibilidad de los datos: ELT preserva los datos en crudo, lo que permite transformaciones más ágiles.

- Tiempo de procesamiento: ELT puede ser más rápido para conjuntos de datos grandes gracias a las capacidades de procesamiento en paralelo.

- Privacidad de datos: ETL puede ofrecer un mayor control sobre la información sensible durante la transformación.

¿Dónde se Aplican ETL y ELT?

ETL se utiliza comúnmente en:

- Almacenamiento de datos tradicional

- Sistemas con capacidad de almacenamiento o procesamiento limitada

- Escenarios que requieren transformaciones complejas de datos antes de cargarlos

ELT se prefiere a menudo para:

- Almacenes de datos en la nube

- Entornos de big data

- Procesamiento de datos en tiempo real o casi en tiempo real

- Situaciones en las que la preservación de los datos en crudo es crucial

Optimización de Flujos de Trabajo de Datos: Ejemplos con Python y Pandas

Examinemos algunos ejemplos de procesamiento de datos optimizado y no optimizado utilizando Python y Pandas.

Enfoque no Optimizado

import pandas as pd

# Leer datos desde CSV

df = pd.read_csv('large_dataset.csv')

# Realizar múltiples transformaciones

df['new_column'] = df['column_a'] + df['column_b']

df = df[df['category'] == 'important']

df['date'] = pd.to_datetime(df['date'])

# Escribir los datos transformados a un nuevo CSV

df.to_csv('transformed_data.csv', index=False)Este enfoque lee el conjunto de datos completo en memoria, realiza transformaciones y luego escribe el resultado. Para conjuntos de datos grandes, esto puede consumir mucha memoria y ser lento.

Enfoque Optimizado

import pandas as pd

# Utilizar fragmentos para procesar conjuntos de datos grandes

chunk_size = 10000

for chunk in pd.read_csv('large_dataset.csv', chunksize=chunk_size):

# Realizar transformaciones en cada fragmento

chunk['new_column'] = chunk['column_a'] + chunk['column_b']

chunk = chunk[chunk['category'] == 'important']

chunk['date'] = pd.to_datetime(chunk['date'])

# Agregar el fragmento transformado al archivo de salida

chunk.to_csv('transformed_data.csv', mode='a', header=False, index=False)Este enfoque optimizado procesa los datos en fragmentos, reduciendo el uso de memoria y permitiendo el procesamiento en paralelo. Es más eficiente para conjuntos de datos grandes y puede integrarse fácilmente en flujos de trabajo ETL o ELT.

Privacidad de Datos con ETL y ELT

Cuando se trata de datos sensibles, la privacidad es primordial. Tanto ETL como ELT pueden diseñarse para manejar de forma segura la información sensible:

ETL y la Privacidad de Datos

- Enmascaramiento de datos: Aplicar técnicas de enmascaramiento durante la fase de transformación.

- Encriptación: Cifrar los datos sensibles antes de cargarlos en el sistema objetivo.

- Control de acceso: Implementar controles de acceso estrictos en el servidor de transformación.

Ejemplo de enmascaramiento de datos en ETL:

import pandas as pd

def mask_sensitive_data(df):

df['email'] = df['email'].apply(lambda x: x.split('@')[0][:3] + '***@' + x.split('@')[1])

df['phone'] = df['phone'].apply(lambda x: '***-***-' + x[-4:])

return df

# Proceso ETL

df = pd.read_csv('source_data.csv')

df = mask_sensitive_data(df)

# Otras transformaciones...

df.to_csv('masked_data.csv', index=False)ELT y la Privacidad de Datos

- Encriptación a nivel de columna: Cifrar columnas sensibles antes de cargarlas.

- Enmascaramiento dinámico de datos: Aplicar reglas de enmascaramiento en el sistema objetivo.

- Control de acceso basado en roles: Implementar políticas de acceso detalladas en el almacén de datos.

Ejemplo de encriptación a nivel de columna en ELT:

import pandas as pd

from cryptography.fernet import Fernet

def encrypt_column(df, column_name, key):

f = Fernet(key)

df[column_name] = df[column_name].apply(lambda x: f.encrypt(x.encode()).decode())

return df

# Generar clave de encriptación (en la práctica, almacena y gestiona esta clave de forma segura)

key = Fernet.generate_key()

# Proceso ELT

df = pd.read_csv('source_data.csv')

df = encrypt_column(df, 'sensitive_column', key)

# Cargar datos en el sistema objetivo

df.to_sql('target_table', engine) # Suponiendo que 'engine' es tu conexión a la base de datos

# Transformar datos dentro del sistema objetivoOptimización de Flujos de Trabajo de Datos para Datos Sensibles

Para optimizar los flujos de trabajo de datos y mantener la privacidad de la información, considera estas mejores prácticas:

- Clasificación de datos: Identificar y categorizar los datos sensibles desde el inicio del proceso.

- Minimizar el movimiento de datos: Reducir la cantidad de veces que se transfieren datos sensibles entre sistemas.

- Utilizar protocolos seguros: Emplear encriptación para datos en tránsito y en reposo.

- Implementar gobernanza de datos: Establecer políticas claras para el manejo y acceso a la información.

- Auditorías regulares: Realizar revisiones periódicas de los flujos de trabajo de datos.

Conclusión

Es importante optimizar los flujos de trabajo de datos. También debemos asegurarnos de que la información sensible esté protegida con fuertes medidas de privacidad. Ambos enfoques, ETL y ELT, tienen ventajas únicas y las organizaciones pueden optimizarlos para mejorar el rendimiento y la seguridad.

Este artículo aborda las formas en que las organizaciones pueden crear flujos de trabajo de datos seguros. Estos flujos protegen la información sensible y permiten obtener conocimientos valiosos. Las organizaciones pueden utilizar estrategias y mejores prácticas para lograr este objetivo.

Recuerda, la elección entre ETL y ELT depende de tu caso de uso específico, el volumen de datos y los requisitos de privacidad. Es importante revisar y actualizar periódicamente tus estrategias de procesamiento de datos. Esto asegurará que se alineen con las necesidades cambiantes de tu negocio y cumplan con las leyes de protección de datos.

Para herramientas fáciles de usar que mejoren la seguridad de las bases de datos y el cumplimiento en tus procesos, consulta las opciones de DataSunrise. Visita nuestro sitio web en DataSunrise para ver una demo y aprender cómo podemos mejorar tu procesamiento de datos. Priorizamos mantener tus datos seguros y protegidos.