Desafíos en la Seguridad de Datos en Sistemas de IA

Los sistemas de IA generativa están transformando la forma en que las organizaciones usan y comparten datos. Agilizan los flujos de trabajo, automatizan la toma de decisiones y respaldan modelos de aprendizaje adaptativo. Sin embargo, esta evolución también plantea amenazas nuevas y complejas para la seguridad de los datos. Los modelos ingieren información sensible, generan salidas impredecibles y requieren acceso a conjuntos de datos muy amplios, lo que hace que los controles de seguridad tradicionales sean insuficientes.

Comprender los desafíos de seguridad de datos en los sistemas de IA significa mirar más allá de los cortafuegos de red o la protección de endpoints. Implica asegurar las entradas, el comportamiento del modelo y los flujos de datos, todo en tiempo real y en diversos entornos. Los sistemas de IA son intrínsecamente hambrientos de datos, y su dependencia de datos en tiempo real aumenta la exposición a fugas, ataques de inferencia y violaciones de cumplimiento.

Auditoría en Tiempo Real como Mecanismo de Defensa

Los registros de auditoría no son nuevos, pero su papel en la seguridad de la IA ahora es central. Registrar los comandos del usuario, las respuestas del modelo, las interacciones con la API y las consultas SQL a almacenes vectoriales o bases de datos relacionales ofrece una pista de responsabilidad. Un sistema de auditoría en tiempo real permite la detección inmediata de anomalías como la inyección de comandos, el acceso no autorizado a filas sensibles o la filtración de información de identificación personal (PII).

-- Ejemplo: registrar consulta de usuario en PostgreSQL con comando JSON

INSERT INTO prompt_audit_log (user_id, prompt_body, timestamp)

VALUES (current_user, to_jsonb($$Resumir datos financieros por sector de cliente$$), now());

Cuando se combina con DataSunrise, las reglas de auditoría pueden clasificar y etiquetar automáticamente los comandos que interactúan con campos confidenciales, ofreciendo una capa transparente de monitoreo para aplicaciones de IA construidas sobre arquitecturas GenAI.

Enmascaramiento Dinámico para Salidas Sensibles

Las respuestas de la IA que exponen correos electrónicos, números de teléfono o credenciales son más que una fuga de datos: constituyen una violación de cumplimiento. Ahí es donde el enmascaramiento dinámico se vuelve esencial. A diferencia de la redacción estática, el enmascaramiento dinámico se adapta en tiempo real, protegiendo las salidas sin interrumpir la lógica del sistema.

Por ejemplo, cuando un comando accede a una base de datos de soporte al cliente, el enmascaramiento dinámico puede ocultar todos los campos de tarjetas de crédito tanto en los datos de entrenamiento como en la salida generada. En DataSunrise, esto se configura con reglas de enmascaramiento vinculadas al acceso basado en roles y patrones de contenido.

-- Ejemplo: regla de enmascaramiento para la columna credit_card

CREATE MASKING RULE hide_credit_cards

ON customers.credit_card

USING FULL MASKING

WHEN current_user_role != 'auditor';

Esto garantiza que herramientas de IA como los pipelines de generación aumentada por recuperación (RAG) nunca revelen campos sensibles en bruto, incluso cuando se conectan a almacenes vectoriales confiables.

Descubrimiento Antes de Proteger

Antes de poder proteger los datos, debes saber dónde se encuentran, y la IA complica este desafío. Los modelos ajustados a menudo utilizan fuentes de datos híbridas en bases de datos estructuradas, registros no estructurados y documentos semi-estructurados. Escanear todas las fuentes en busca de atributos sensibles se convierte en un punto de partida crucial.

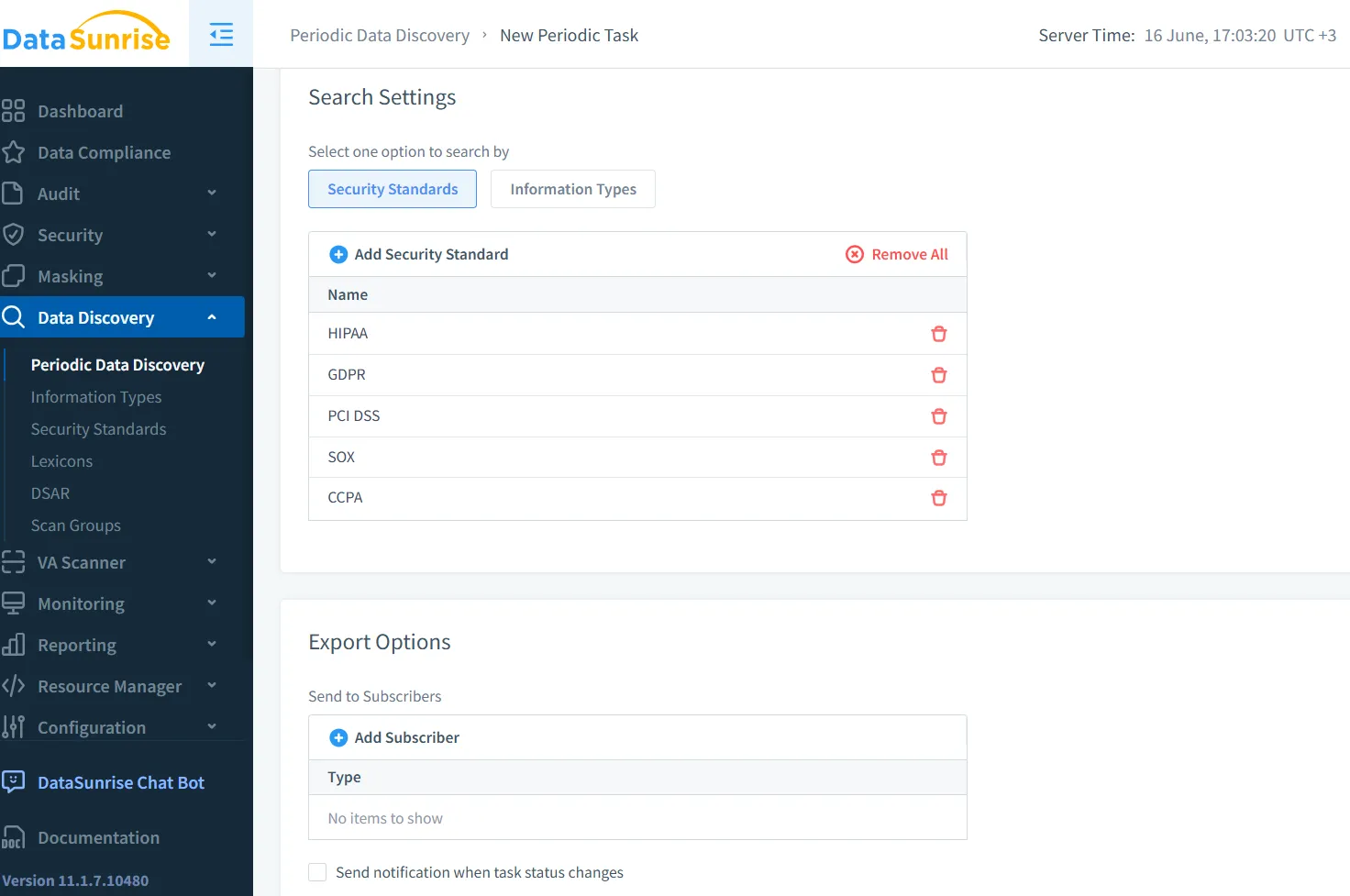

Las herramientas de descubrimiento de datos localizan, clasifican y etiquetan automáticamente los elementos sensibles en diversos sistemas backend. Para la IA, esto incluye identificar dónde los conjuntos de entrenamiento contienen PHI, identificadores de clientes o conocimientos propietarios que no deben ser expuestos.

El descubrimiento no es solo previo al entrenamiento; es continuo. Cuando los conjuntos de datos evolucionan —como nuevos documentos que se indexan en almacenes vectoriales— el descubrimiento debe desencadenar una reclasificación y una reevaluación de las políticas. Esto lo hace esencial para la gobernanza de la IA y la aplicación automatizada de la seguridad.

Arquitectura de Seguridad Adaptada a la IA

La seguridad de la GenIA no se trata de envolver los cortafuegos existentes alrededor de una nueva herramienta. Se trata de diseñar con visibilidad, trazabilidad y controles adaptativos. Un enfoque de seguridad por capas es el más adecuado:

Cortafuegos de comandos para interceptar entradas maliciosas antes de que alcancen el modelo

Clasificación de datos basada en tokens dentro de las canalizaciones de salida de LLM

Detección de anomalías basada en sesiones utilizando el contexto del usuario y del comando

Enmascaramiento dinámico a nivel del vector y de la respuesta SQL

Registro de auditoría consciente de las políticas que refleja el apetito de riesgo de la organización

Estos componentes trabajan en conjunto. Un usuario que ingresa una consulta sospechosa en una interfaz de chatbot puede activar un cortafuegos de comandos, registrar la solicitud en una tabla de auditoría y devolver una respuesta enmascarada, todo sin interrumpir el servicio.

Manteniéndose en Cumplimiento en la Era de la IA

La IA no te exime de cumplir con las normativas. De hecho, su imprevisibilidad añade riesgos a marcos existentes como GDPR, HIPAA y PCI-DSS. Aun así, debes rastrear dónde se accede a la información de identificación personal (PII), demostrar que está protegida y responder a las solicitudes de eliminación o acceso.

DataSunrise une la IA y las obligaciones regulatorias al proporcionar controles de grado cumplimiento sobre el movimiento, la visibilidad de acceso y la protección de datos. La suite de Cumplimiento de Datos asegura que las aplicaciones de IA respeten los mismos límites que los operadores humanos. La integración con herramientas como Descubrimiento de Datos y Enmascaramiento Dinámico te permite definir reglas ejecutables, y no solo reportes pasivos.

Para una guía práctica sobre la integración de estas herramientas, el centro de conocimiento sobre cumplimiento regulatorio ofrece las mejores prácticas en seguridad de bases de datos, enmascaramiento y registro de auditoría para cargas de trabajo impulsadas por la IA.

Mirando Hacia el Futuro: La IA como Amenaza y Aliada

Es tentador ver la IA como un riesgo para la seguridad, pero también puede ser un reforzador. Es probable que las arquitecturas futuras incluyan agentes de seguridad de datos impulsados por LLM que revisen los patrones de acceso, recomienden nuevas políticas de enmascaramiento y bloqueen en tiempo real cadenas de comandos sospechosas.

Al combinar auditoría en tiempo real, enmascaramiento dinámico, descubrimiento continuo y aplicación de políticas, las organizaciones pueden hacer que la IA trabaje a favor de la seguridad en lugar de en su contra. Herramientas como DataSunrise ayudan a navegar este cambio, pasando de una defensa reactiva a una protección proactiva alineada con la IA.

Perspectivas externas también respaldan esta evolución. El artículo de arXiv sobre riesgos de ciberseguridad en LLM explora cómo los modelos pueden filtrar o inferir secretos, mientras que la Cloud Security Alliance enfatiza la seguridad de la IA centrada en los datos como una prioridad principal.

Asegurar la IA generativa no se trata del miedo, sino del diseño. Y el diseño comienza con la visibilidad, la adaptabilidad y el control sobre el ciclo de vida de los datos en cada capa.