Riesgos de Seguridad en Cargas de Trabajo de IA Generativa

Las cargas de trabajo de IA generativa (GenAI) han redefinido la forma en que las empresas interactúan con los datos. Desde la creación de contenido hasta la toma de decisiones automatizada, estos modelos generan un valor inmenso, pero también introducen riesgos de seguridad únicos. A medida que la adopción de GenAI aumenta en diversas industrias, comprender cómo asegurar estas cargas de trabajo se vuelve esencial. Para obtener una visión general de las amenazas emergentes en GenAI, consulta el Marco de Seguridad de IA Generativa de MITRE.

Por qué las cargas de trabajo de GenAI son de alto riesgo por naturaleza

A diferencia de los modelos de IA tradicionales que operan con entradas estáticas, los modelos de GenAI interactúan con datos dinámicos y, a menudo, sensibles. Estos modelos pueden memorizar datos de entrenamiento, responder a indicaciones en lenguaje natural y generar salidas sintéticas que pueden, inadvertidamente, exponer información regulada o confidencial.

Los riesgos inherentes incluyen:

| Categoría de Riesgo | Descripción |

|---|---|

| Fuga de Datos Sensibles | Los modelos de GenAI pueden memorizar y reproducir datos confidenciales de entrenamiento. |

| Exposición de Información Personal Identificable (PII) | La información personal identificable podría aparecer en las salidas del modelo. |

| Inyección de Indicaciones | Los usuarios maliciosos podrían diseñar indicaciones que anulen las instrucciones de seguridad del modelo. |

| Explotación a través de la Salida del Modelo | Los atacantes pueden engañar al modelo para que revele datos internos o protegidos. |

Estos vectores de riesgo requieren salvaguardas avanzadas que vayan más allá de la protección estándar de API. La complejidad aumenta aún más cuando se despliegan grandes modelos de lenguaje (LLMs) a través de interfaces de cara al cliente o se vinculan a sistemas internos con acceso a datos en tiempo real.

Auditoría en Tiempo Real para Interacciones con el Modelo

Para detectar usos indebidos o anomalías en las interacciones con GenAI, es fundamental contar con auditoría en tiempo real. Los registros tradicionales pueden capturar el “qué”, pero los sistemas de auditoría en tiempo real capturan el “por qué” y el “cómo” detrás de la solicitud. Consulta también la guía de Google Cloud sobre cómo asegurar cargas de trabajo de IA con registros de auditoría.

Ejemplo: Supongamos que un usuario envía una indicación como:

SELECT user_id, endpoint, timestamp

FROM api_logs

WHERE endpoint LIKE '%admin%' AND response_code = 200;

En un asistente con tecnología GenAI vinculado a tu base de datos, esto podría exponer comportamientos operativos a menos que existan registros y alertas basadas en reglas.

Plataformas como DataSunrise Audit Logs ofrecen notificaciones en tiempo real e información detallada sobre el comportamiento de los usuarios, lo que permite a los equipos de seguridad rastrear patrones de acceso y detectar anomalías antes de que se produzcan daños.

Enmascaramiento Dinámico: Barreras de Protección en Interacciones en Vivo

El enmascaramiento dinámico es vital cuando las herramientas de GenAI generan respuestas basadas en datos en tiempo real. Al interceptar consultas y respuestas, puedes redactar u ofuscar campos sensibles antes de que lleguen al modelo o al usuario final.

-- Valor original: 1234-5678-9012-3456

-- Salida enmascarada: XXXX-XXXX-XXXX-3456

Esto no solo cumple con los requisitos de privacidad, sino que también impide que la IA “aprenda” patrones vinculados a identidades sensibles.

Conoce más sobre el enmascaramiento dinámico de datos y su función en la protección de datos para cargas de trabajo de GenAI.

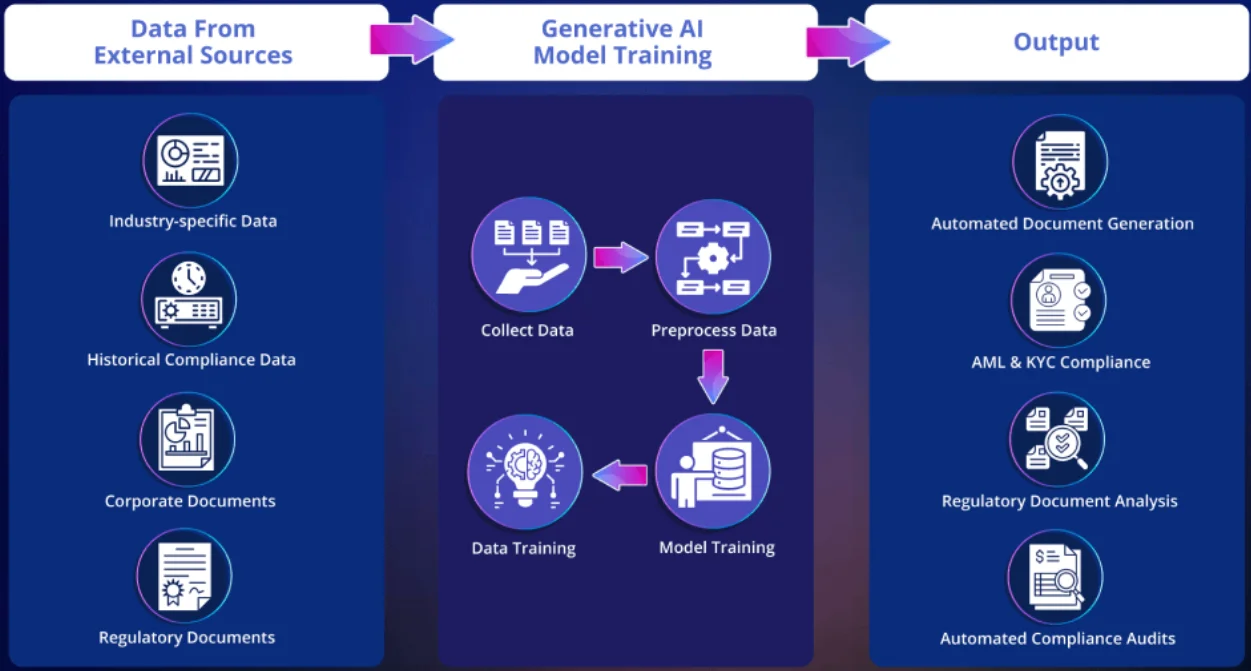

Descubrimiento de Datos Antes del Despliegue

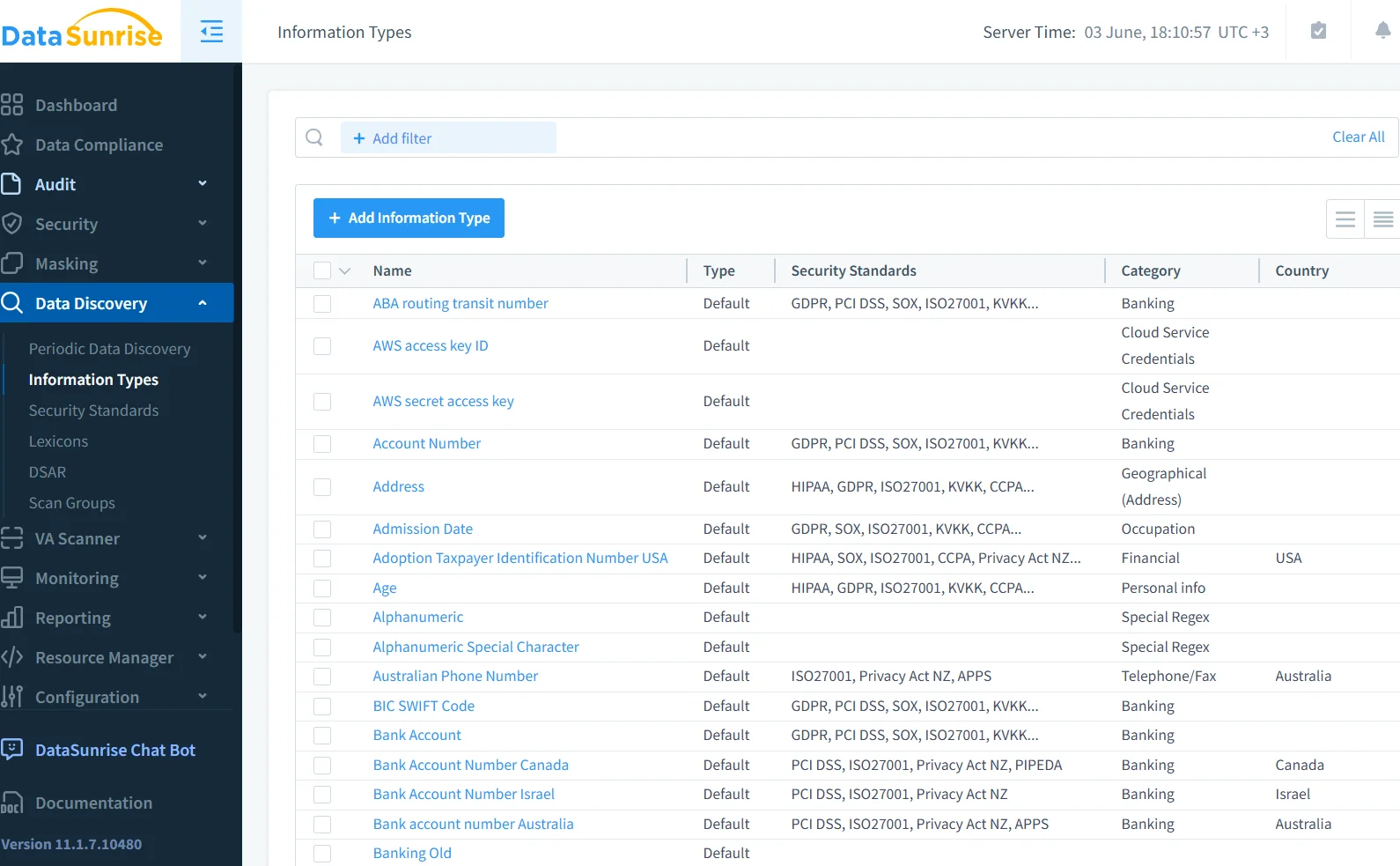

Los modelos de GenAI a menudo se entrenan con grandes conjuntos de datos federados. Sin saber qué contienen, se opera a ciegas. Utilizando herramientas de descubrimiento de datos, los equipos de seguridad pueden escanear bases de datos, data lakes y sistemas de archivos para clasificar los datos regulados antes de que se expongan a los LLMs. Esto es crucial al entrenar modelos personalizados de GenAI con documentos empresariales o historiales de clientes. Para mayor contexto, IBM ofrece una guía sobre clasificación y descubrimiento automatizado de datos para IA.

-- Regla de ejemplo en el motor de descubrimiento

IF column_name LIKE '%ssn%' OR column_name LIKE '%dob%' THEN classify AS 'PII'

Estos metadatos permiten el enmascaramiento basado en políticas y alertas en tiempo real cuando las interacciones con GenAI acceden a tipos de datos marcados.

Cumplimiento y Gobernanza: Donde la IA se Encuentra con la Regulación

La seguridad para GenAI no se trata solo de prevenir explotaciones técnicas, sino también de mantener el cumplimiento con marcos regulatorios como GDPR, HIPAA y PCI DSS. Estos marcos requieren:

- Minimización de datos

- Registro de accesos

- Consentimiento del usuario para el procesamiento

La falta de controles puede resultar en exposición legal, especialmente cuando las salidas generadas por IA reproducen datos protegidos.

Los controles de acceso basados en roles (RBAC) y las pistas de auditoría ayudan a documentar los esfuerzos de cumplimiento y demostrar intención en caso de una investigación.

Inyección de Código y Manipulación de Indicaciones

La inyección de indicaciones es un vector de amenaza en ascenso en los sistemas de GenAI. Los atacantes pueden insertar instrucciones dañinas dentro de indicaciones aparentemente inofensivas, lo que lleva al modelo a revelar datos sensibles o a anular las salvaguardas predeterminadas. La OWASP Foundation ha publicado una lista de los 10 principales riesgos para aplicaciones basadas en LLM que incluye vectores de inyección de indicaciones.

Combinar conjuntos de reglas de auditoría con canalizaciones de saneamiento de indicaciones es una forma efectiva de mitigar estos ataques.

Un Ejemplo Práctico: Uso de Auditoría SQL y Enmascaramiento en Sistemas Impulsados por LLM

Si esto se canaliza a través de un módulo de generación SQL, el backend podría generar una consulta como:

-- Auditoría de saldos vencidos

SELECT customer_name, balance_due FROM billing WHERE status = 'overdue';

Sin enmascaramiento, los campos financieros podrían mostrarse en texto plano. Con políticas de enmascaramiento, las cantidades sensibles se redactan parcialmente.

Para rastrear quién accedió a qué y cuándo, la Monitorización de Actividad en la Base de Datos registra la interacción, vinculándola a una sesión de usuario o a una clave API.

Integración Temprana: Asegurando la GenAI desde el Diseño

Muchas brechas de seguridad en las cargas de trabajo de GenAI emergen porque los equipos se centran en el rendimiento del modelo y no en el diseño del sistema. Integrar la seguridad desde las primeras etapas—aplicando controles de seguridad desde el inicio del ciclo de vida—puede ayudar a incorporar la gobernanza en cada componente:

- Ingesta de datos: escanear y etiquetar entradas sensibles

- Ajuste del modelo: restringir la exposición a corpus sensibles

- Pila de servicio: aplicar enmascaramiento en línea y controles de acceso

- Capa de salida: sanear y auditar las respuestas del modelo

Este enfoque se alinea con las prácticas modernas de DevSecOps y la seguridad basada en datos, mejorando tanto la transparencia como la protección.

Conclusión: Un Nuevo Paradigma de Seguridad para la IA

El auge de la GenAI introduce una categoría completamente nueva de riesgos que los modelos de seguridad tradicionales no están diseñados para manejar. Pero, al combinar auditoría en tiempo real, enmascaramiento dinámico, descubrimiento y gobernanza basada en políticas, es posible construir sistemas de GenAI seguros y en cumplimiento sin sacrificar la innovación. Conoce cómo NIST aborda la gestión de riesgos en IA en su AI RMF 1.0.

Para profundizar en cómo herramientas como DataSunrise pueden ayudar en esta transformación, explora sus guías sobre auditoría, enmascaramiento de datos y las capacidades de firewall para bases de datos.