Seguridad de Datos en la Nube en Despliegues de IA y LLM

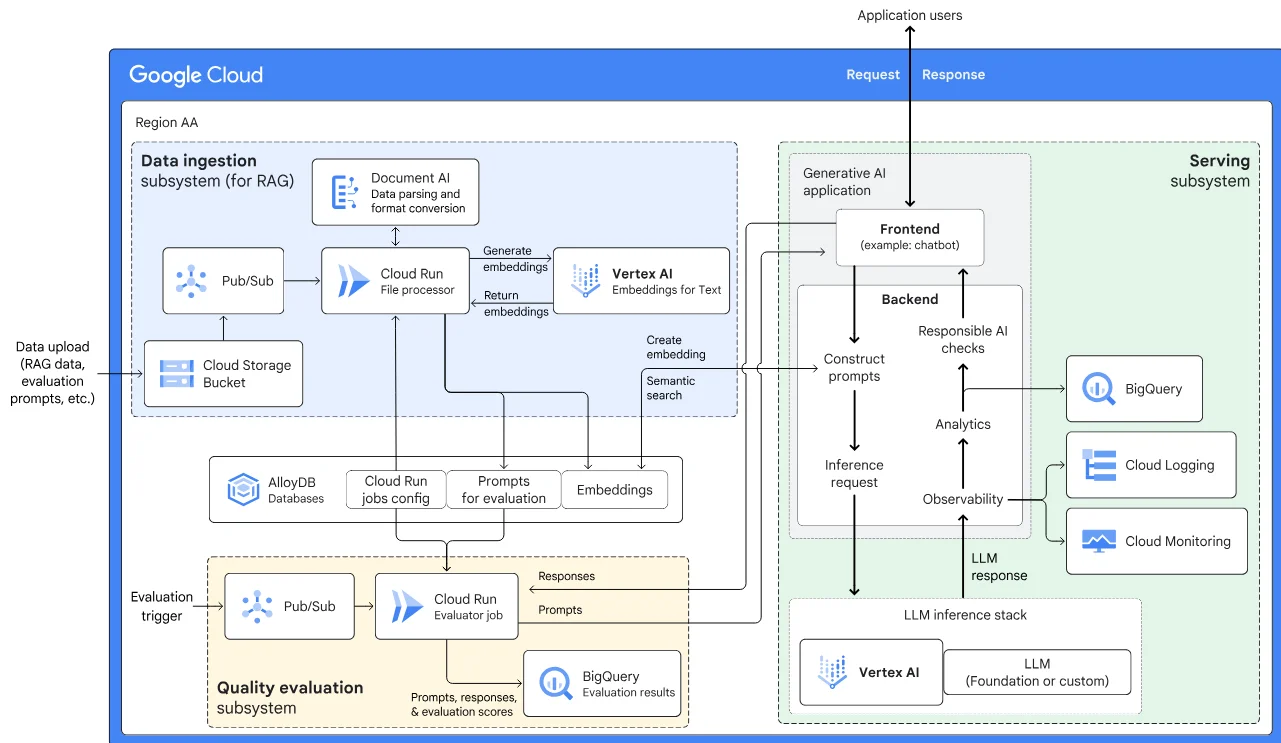

Los modelos de IA generativa (GenAI) y los modelos de lenguaje a gran escala (LLMs) han transformado la forma en que las aplicaciones nativas de la nube procesan y generan datos. Estas herramientas mejoran la automatización, la toma de decisiones y la personalización, pero también introducen desafíos significativos para la seguridad de los datos. A medida que los modelos interactúan con información sensible o regulada, garantizar un manejo seguro y conforme se vuelve esencial. En este artículo, exploramos los componentes clave de la seguridad de datos en la nube en despliegues de IA y LLM, centrándonos en la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento de datos y las estrategias de cumplimiento.

Riesgos Específicos en la Nube de la IA y los LLM

Los LLM desplegados en entornos de nube pueden ingerir, procesar y generar respuestas basadas en datos sensibles de la empresa. Estas respuestas pueden filtrar inadvertidamente identificadores personales, secretos comerciales o contenido regulado, como información de salud o de pagos. Dado que las plataformas en la nube escalan y distribuyen las cargas de trabajo de forma dinámica, la visibilidad del acceso a los datos y su procesamiento se vuelve más compleja. Esta falta de visibilidad y control crea un riesgo de exposición no autorizada de datos, especialmente si las salidas de GenAI se registran o almacenan en caché de manera inadecuada.

Asegurando las Cargas de Trabajo de IA con Auditoría en Tiempo Real

Uno de los elementos fundamentales para asegurar los flujos de trabajo de IA y LLM es la implementación de auditorías en tiempo real. Las auditorías en tiempo real capturan todas las interacciones entre usuarios, servicios y la infraestructura de datos subyacente. Al analizar estas interacciones a medida que ocurren, las organizaciones pueden detectar violaciones de políticas, actividades sospechosas y patrones de uso no autorizados de la IA.

Por ejemplo, cuando un usuario consulta un modelo de IA para generar un resumen del perfil de un cliente, se debe capturar un registro de auditoría que incluya:

SELECT * FROM customer_profiles WHERE customer_id = '12345';

Este rastro puede vincularse a la salida del modelo y almacenarse en un registro a prueba de manipulaciones, lo que permite a los equipos investigar el comportamiento de las solicitudes o diagnosticar problemas de cumplimiento. Plataformas como DataSunrise ofrecen registros detallados de auditoría que se integran con SIEM, habilitando alertas automatizadas y visualizaciones de interacciones de IA de riesgo.

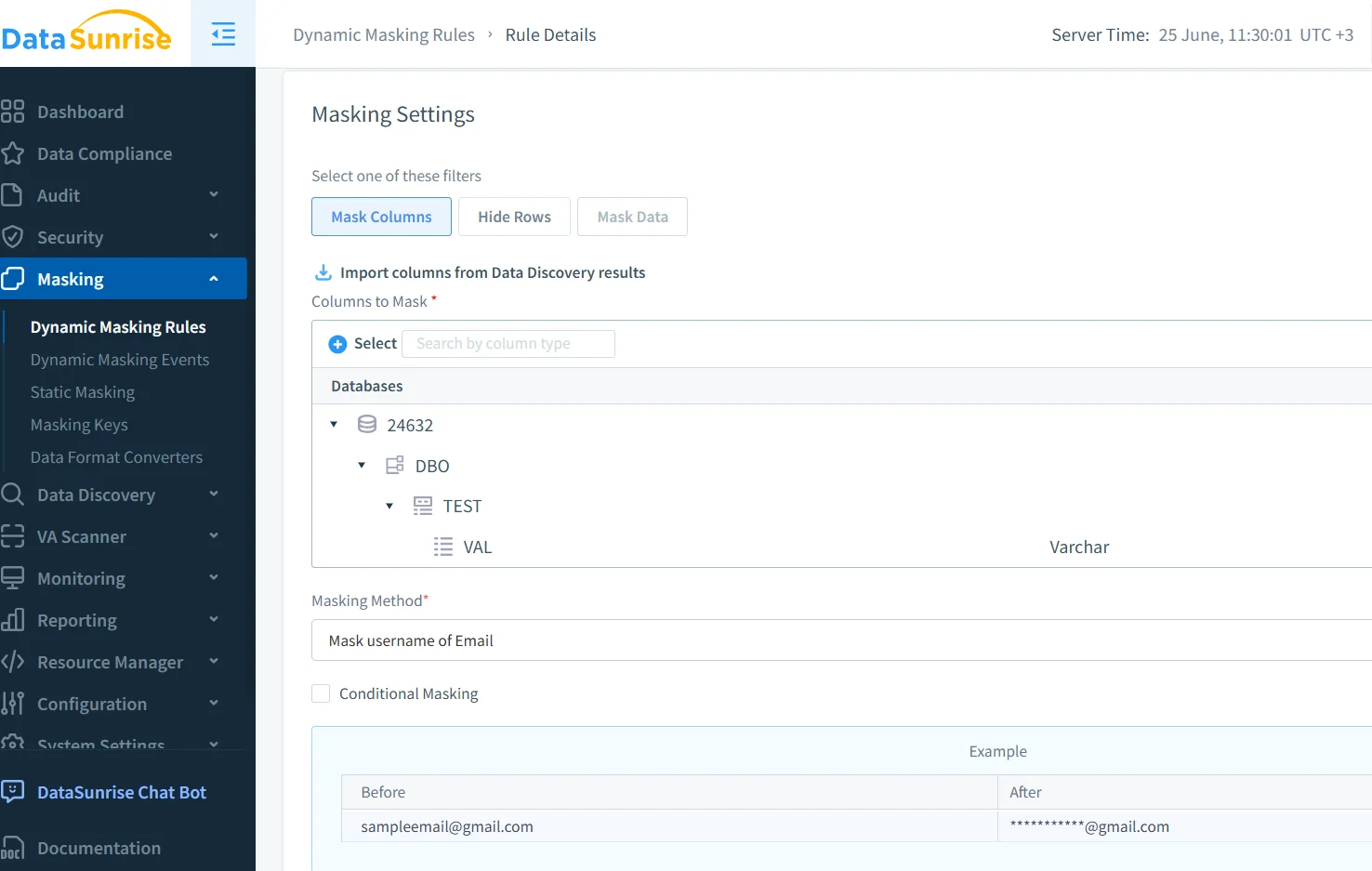

Aplicación del Enmascaramiento Dinámico a las Salidas de IA

El enmascaramiento dinámico juega un papel crucial en la prevención de fugas de datos durante la inferencia con GenAI. A diferencia del enmascaramiento estático, que altera los datos en reposo, el enmascaramiento dinámico ocurre en tiempo real, justo antes de que la salida llegue al usuario o modelo. Esto garantiza que campos sensibles como números de seguridad social, códigos médicos o registros financieros siempre estén enmascarados durante las interacciones con la IA.

Imagina un LLM utilizado para asistir a agentes de servicio al cliente. Cuando un agente pide al modelo que resuma un pedido con información personal identificable (PII), las reglas de enmascaramiento deben garantizar que campos como estos:

{"customer": "John Smith", "card_number": "4111-XXXX-XXXX-1234"}

se entreguen con valores enmascarados tanto al agente como a los registros almacenados. DataSunrise soporta el enmascaramiento dinámico que funciona en bases de datos en la nube y se integra con pipelines basados en LLM.

Descubrimiento de Datos Sensibles Antes de que se Filtren

Los modelos de IA entrenados o solicitados con fuentes de datos desconocidas son propensos a fugas de información. Las herramientas de descubrimiento de datos ayudan a prevenir esto al escanear lagos de datos, almacenes y flujos en busca de atributos sensibles, tales como registros de salud personales, tokens de acceso o identificadores financieros. Integrar los resultados del descubrimiento en los pipelines de GenAI garantiza que los modelos accedan únicamente a conjuntos de datos conformes.

El módulo de descubrimiento de datos de DataSunrise clasifica automáticamente la información en las plataformas de almacenamiento en la nube, ayudando a los equipos de cumplimiento a evitar que datos regulados ingresen a las etapas de entrenamiento o inferencia. Este paso proactivo es clave para habilitar una automatización basada en IA de manera segura.

Reforzando el Cumplimiento en Arquitecturas Impulsadas por la IA

A medida que los sistemas de IA basados en la nube interactúan con contenido regulado, marcos de cumplimiento como GDPR, HIPAA y PCI-DSS se vuelven críticos. Estas regulaciones exigen auditabilidad, minimización de datos y controles de acceso basados en roles. Aplicar estos controles a los modelos de IA y sus entradas/salidas de datos ya no es opcional.

Soluciones como el Compliance Manager de DataSunrise permiten a los administradores de seguridad de IA crear políticas personalizadas alineadas con los estándares de la industria. Las reglas pueden imponer el enmascaramiento en columnas específicas, restringir el acceso a los modelos basado en roles o garantizar que cualquier uso de LLM con datos personales sea completamente auditable.

Construyendo Seguridad en Capas para la IA en la Nube

La seguridad en los entornos de GenAI basados en la nube no se trata de un único control. Requiere un modelo de defensa en capas:

- Auditoría: Capturar y analizar interacciones en tiempo real.

- Enmascaramiento: Prevenir la exposición de contenido sensible.

- Descubrimiento: Mapear y clasificar activos de datos sensibles.

- Controles de Acceso: Implementar controles de acceso basados en roles (RBAC) contextuales y de privilegio mínimo.

- Cumplimiento: Alinear la arquitectura con estándares como GDPR o HIPAA.

Herramientas como el firewall de bases de datos de DataSunrise y las plantillas de políticas de seguridad ayudan a los equipos de seguridad a hacer cumplir estos controles en entornos centrados en la IA.

Recursos externos como el Marco de IA Segura (SAIF) de Google y el Marco de Gestión de Riesgos de IA de NIST ofrecen orientación adicional para las organizaciones que construyen sistemas de IA resilientes.

Conclusión

La seguridad de datos en la nube en despliegues de IA y LLM va más allá de la protección perimetral. A medida que los sistemas de IA evolucionan, también deben hacerlo las estrategias de seguridad que los rodean. Los registros de auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento inteligente de datos y las barreras de cumplimiento automatizadas forman la base de una GenAI confiable. Con plataformas como DataSunrise, las organizaciones pueden avanzar rápidamente sin sacrificar el control, permitiendo una innovación en IA segura, escalable y conforme.