Seguridad de Prompts en las Interacciones de IA y LLM

A medida que los modelos de lenguaje se vuelven centrales para las operaciones empresariales, sus interacciones con las solicitudes introducen nuevas capas de riesgo. Estos riesgos se extienden más allá del comportamiento del modelo, abarcando cómo se estructuran, procesan y registran las solicitudes. “Seguridad de Prompts en las Interacciones de IA y LLM” ha emergido como una disciplina crucial para proteger datos sensibles, mantener el cumplimiento normativo y evitar la manipulación de los resultados de la IA.

Por qué la Seguridad de Prompts Ahora Importa

A diferencia de las aplicaciones tradicionales, los LLMs como ChatGPT o Claude responden a entradas que pueden contener contenido privado, regulado o incluso adversario. Esto crea una superficie de ataque en la que una pregunta inocua podría desencadenar la exposición de datos confidenciales, violaciones de políticas o la manipulación de resultados a través de técnicas de inyección de solicitudes.

Cuando se integran en servicios que se conectan a bases de datos internas o canalizaciones de datos de clientes, las implicaciones de seguridad se multiplican. Por eso, la auditoría en tiempo real, el enmascaramiento dinámico y el descubrimiento de datos deben convertirse en herramientas estándar en las implementaciones de IA.

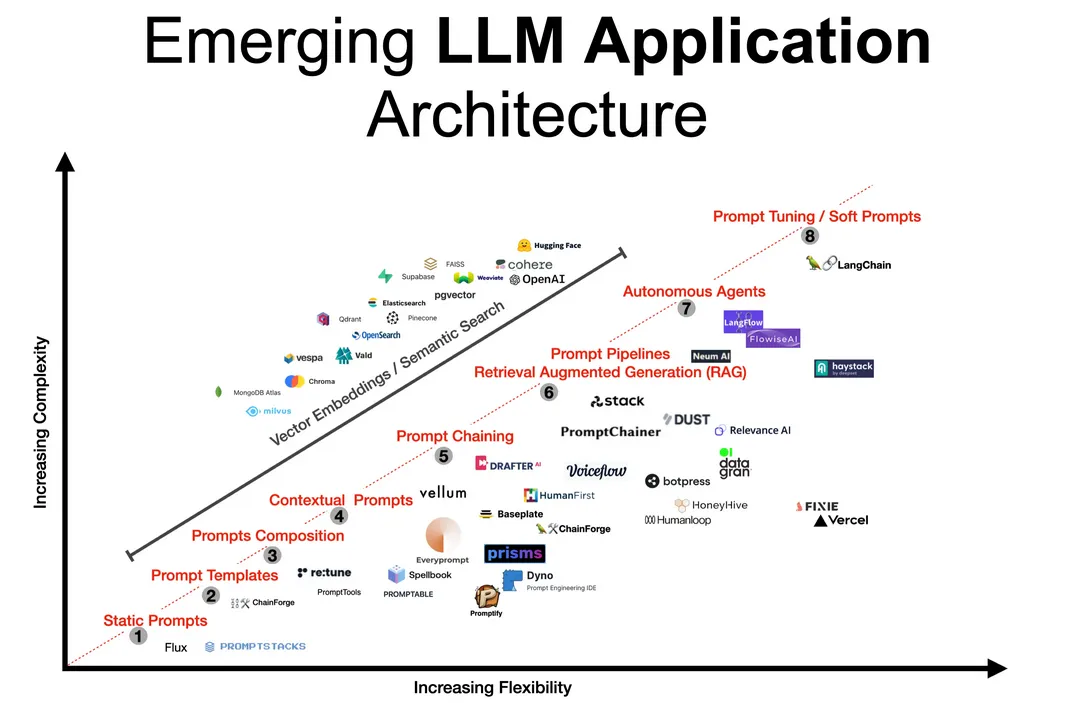

Comprendiendo la Cadena de Solicitudes

Las solicitudes fluyen a través de múltiples sistemas: comienzan en las interfaces de usuario, pasan por filtros de preprocesamiento opcionales, son procesadas por el modelo y, finalmente, se dirigen a cualquier API descendente, como los generadores de SQL.

Este recorrido debe tratarse como una transacción sensible. Registrar lo que entra y sale, detectar anomalías y aplicar políticas de enmascaramiento en tiempo real garantiza la seguridad en cada paso.

Para una lectura técnica adicional, la base de conocimientos MITRE ATLAS explora tácticas adversariales contra el aprendizaje automático, incluidos vectores basados en solicitudes.

Auditoría en Tiempo Real: Rastreando lo Invisible

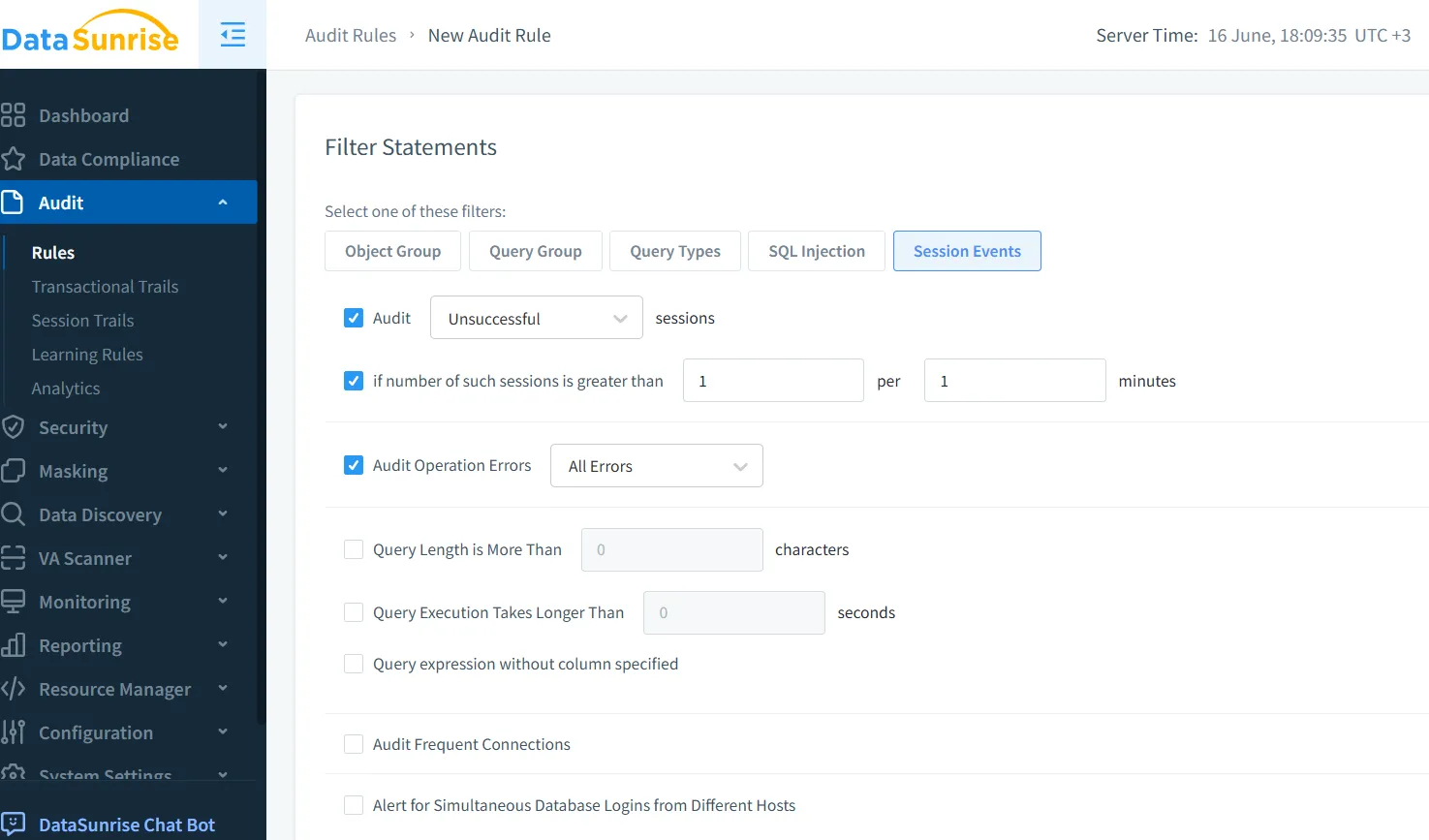

Las interacciones con solicitudes a menudo no dejan rastro a menos que se configuren explícitamente. Herramientas de auditoría en tiempo real, como las ofrecidas por el motor de Audit Trail de DataSunrise, pueden monitorear cada solicitud, consulta y transformación aplicada tanto a la entrada como a la salida.

Esto es especialmente útil cuando la IA está conectada a herramientas descendentes:

-- Ejemplo generado a partir de la solicitud:

SELECT name, ssn FROM employees WHERE clearance_level = 'high';

Una auditoría en tiempo real puede detectar de inmediato consultas que acceden a campos sensibles y señalar usos no autorizados antes de que se devuelvan los resultados. Más información sobre la configuración de reglas de auditoría para solicitudes de IA está disponible en esta guía de auditoría.

Enmascaramiento Dinámico: Proteger Mientras se Responde

Si la salida del modelo incluye datos sensibles, éstos deben enmascararse en tiempo real. El enmascaramiento dinámico asegura que, incluso si la solicitud intenta extraer campos privados, lo que se devuelva esté ofuscado.

Por ejemplo:

Solicitud: Muéstrame transacciones recientes de clientes VIP.

LLM Salida: Nombre: John D*****, Monto: $45,000

Las reglas de enmascaramiento pueden variar según los roles del usuario, el contexto de la sesión o el nivel de amenaza. DataSunrise lo posibilita mediante políticas flexibles sin modificar los datos subyacentes.

Descubrimiento de Datos: Conociendo lo que Está en Juego

Antes de aplicar el enmascaramiento, es necesario saber qué es sensible. Los LLMs suelen trabajar en múltiples esquemas y repositorios, haciendo que la clasificación manual no sea escalable.

Las herramientas automatizadas de descubrimiento de datos buscan PII, PHI, credenciales y otros campos confidenciales. Los resultados impulsan políticas automatizadas que bloquean la generación de salidas que contengan dichos datos, aplican reglas de enmascaramiento y notifican instantáneamente a los equipos de cumplimiento.

Para comprender los riesgos más amplios en torno a los datos no estructurados, el Marco de Gestión de Riesgos en IA del NIST ofrece una orientación estructurada para la gobernanza a lo largo del ciclo de vida de la IA.

Asegurando el Ciclo de Vida de las Solicitudes

La seguridad en las interacciones con LLMs va más allá del filtrado de solicitudes. Incluye gobernar el acceso a los registros del modelo, gestionar el historial de solicitudes y prevenir la exfiltración de datos mediante consultas astutamente estructuradas.

Utilice un proxy inverso para interceptar e inspeccionar las solicitudes antes de que lleguen al modelo. Almacene de manera segura los registros de auditoría de solicitudes y respuestas para respaldar el cumplimiento de SOX y PCI-DSS. Aplique análisis del comportamiento del usuario para identificar desviaciones en los patrones de uso o estructuras sospechosas en las solicitudes.

Una buena referencia de código abierto para los patrones de prevención de inyección de solicitudes es mantenida por Prompt Injection, que cataloga ejemplos reales de ataques y sus mitigaciones.

Cumplimiento de Datos y Seguridad de Prompts

Los sistemas de IA que manejan datos de clientes deben mantenerse alineados con regulaciones como el GDPR y HIPAA. La seguridad de solicitudes respalda esto mediante la auditoría del acceso a datos impulsado por IA, el enmascaramiento de atributos protegidos y el registro de actividades para su posterior revisión.

Plataformas como el Compliance Manager de DataSunrise automatizan estos procesos y alinean las interacciones de IA con las obligaciones legales que evolucionan constantemente.

Reflexiones Finales: Confianza entre Humanos y Máquinas

A medida que la GenIA se integra profundamente en la toma de decisiones y las operaciones, la seguridad de las solicitudes se convierte en una capa fundamental para generar confianza. La observabilidad en tiempo real, los controles de respuesta y la alineación regulatoria aseguran que la innovación no supere la seguridad.

Este enfoque no solo refuerza la solidez de los sistemas, sino que también incrementa la confianza en el desarrollo responsable de la IA.

Para una lectura adicional, vea cómo las herramientas LLM y ML se integran con los flujos de trabajo modernos de cumplimiento.

Y si está listo para probar o implementar, puede descargar DataSunrise o solicitar una demostración.