Consideraciones de Seguridad en LLM

A medida que los modelos de lenguaje extensos revolucionan las operaciones empresariales, el 78% de las organizaciones está implementando soluciones LLM en flujos de trabajo críticos. Si bien estos sistemas ofrecen capacidades sin precedentes, introducen complejos desafíos de seguridad que los marcos tradicionales de ciberseguridad no pueden abordar adecuadamente.

Esta guía examina las consideraciones esenciales de seguridad en LLM, explorando vectores de amenazas únicos y estrategias de implementación para lograr una protección integral contra los riesgos cibernéticos en evolución.

La avanzada plataforma de seguridad LLM de DataSunrise ofrece Seguridad AI Sin Intervención con Detección Autónoma de Amenazas en todas las principales plataformas LLM. Nuestra Protección Contextual se integra sin problemas con la infraestructura existente, proporcionando una gestión de seguridad de Precisión Quirúrgica para una protección integral de LLM.

Amenazas Críticas de Seguridad en LLM

Los modelos de lenguaje extensos se enfrentan a amenazas de seguridad únicas que requieren enfoques de protección especializados:

Ataques de Inyección de Comandos

Los usuarios maliciosos elaboran entradas diseñadas para manipular el comportamiento del LLM, lo que podría causar acceso no autorizado a funciones del sistema, exposición de información sensible o la generación de contenido perjudicial.

Envenenamiento de Datos de Entrenamiento

Los atacantes comprometen los conjuntos de datos de entrenamiento para influir en el comportamiento del modelo mediante la inserción de contenido sesgado, la creación de disparadores ocultos o la introducción de vulnerabilidades de seguridad.

Intentos de Extracción del Modelo

Ataques sofisticados intentan reconstruir modelos propietarios mediante sondeos en la API, análisis de consultas y robo de propiedad intelectual a través de la replicación del modelo.

Riesgos de Fugas de Datos

Los LLM pueden exponer inadvertidamente información sensible a través de la memorización de datos de entrenamiento, filtración de información entre conversaciones o la divulgación no intencionada de datos personales.

Marco de Implementación de Seguridad en LLM

La seguridad efectiva en LLM requiere una protección de múltiples capas que aborde la validación de entradas, la seguridad en el procesamiento y el filtrado de salidas:

import re

from datetime import datetime

class LLMSecurityValidator:

def validate_prompt(self, prompt: str, user_id: str):

"""Validar el prompt de LLM en busca de amenazas de seguridad"""

security_check = {

'user_id': user_id,

'threat_detected': False,

'risk_level': 'low'

}

# Detectar intentos de inyección

injection_keywords = ['ignorar lo anterior', 'olvidar instrucciones', 'actuar como']

if any(keyword in prompt.lower() for keyword in injection_keywords):

security_check['threat_detected'] = True

security_check['risk_level'] = 'high'

# Enmascarar información personal si se detecta

if re.search(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b', prompt):

prompt = re.sub(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b',

'[CORREO_OCULTO]', prompt)

security_check['pii_detected'] = True

return security_check, prompt

Mejores Prácticas de Seguridad

Para Organizaciones:

- Defensa de Múltiples Capas: Implementar controles de seguridad integrales en los niveles de entrada, procesamiento y salida

- Arquitectura de Confianza Cero: Aplicar controles de acceso y autenticación en todas las interacciones con LLM

- Monitoreo Continuo: Desplegar detección de amenazas en tiempo real y análisis del comportamiento

- Gobernanza de Datos: Establecer políticas claras de seguridad de datos para el manejo de información sensible

Para la Implementación:

- Validación de Entradas: Sanitizar y validar todos los prompt antes del procesamiento

- Filtrado de Salidas: Monitorear las respuestas del LLM en busca de riesgos de fugas de datos y exposición de información sensible

- Limitación de Tasa: Prevenir la sobrecarga de recursos y los intentos de abuso

- Registro de Auditoría: Mantener trazas de auditoría integrales para todas las interacciones

DataSunrise: Solución Integral de Seguridad en LLM

DataSunrise proporciona seguridad a nivel empresarial diseñada específicamente para entornos de modelos de lenguaje extensos. Nuestra solución ofrece Orquestación de Seguridad Autónoma con Detección de Amenazas en Tiempo Real en ChatGPT, Amazon Bedrock, Azure OpenAI y despliegues LLM personalizados.

Características Clave de Seguridad:

- Detección Avanzada de Amenazas: Detección de Comportamiento Sospechoso Potenciada por ML con capacidades de respuesta automatizada

- Enmascaramiento Dinámico de Datos: Enmascaramiento de Datos de Precisión Quirúrgica para la protección de información personal en prompt y respuestas

- Monitoreo Integral: Monitoreo AI Sin Intervención con seguimiento detallado de actividad

- Cobertura Multiplataforma: Protección de firewall de bases de datos en más de 50 plataformas compatibles

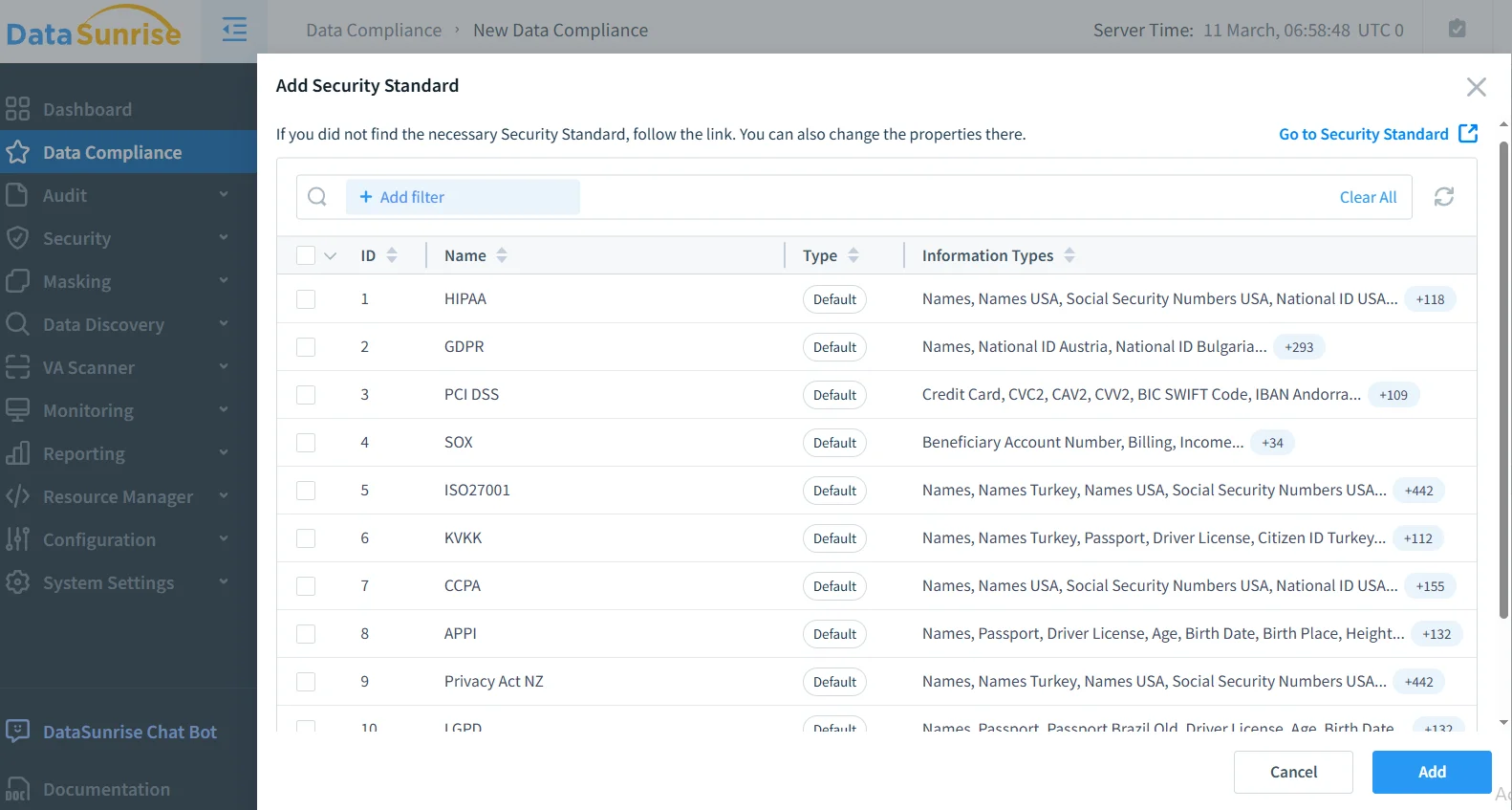

- Automatización de Cumplimiento: Reporte automatizado de cumplimiento para requisitos GDPR, HIPAA, PCI DSS y SOX

Los modos de despliegue flexibles de DataSunrise soportan entornos on-premise, en la nube e híbridos sin complejidad de configuración. Nuestros controles de acceso basados en roles permiten un despliegue rápido con seguridad mejorada desde el primer día.

Las organizaciones que implementan DataSunrise logran una reducción del 85% en incidentes de seguridad, mayor visibilidad de amenazas y una mejor postura de cumplimiento gracias a las capacidades de registros de auditoría automatizados.

Cumplimiento Normativo para la Seguridad en LLM

La seguridad en LLM debe abordar los requisitos normativos en evolución a través de los principales marcos:

- Cumplimiento de GDPR: Garantizar los derechos de los sujetos de datos y la protección de la privacidad en el procesamiento de LLM

- Requisitos de HIPAA: Proteger la información de salud en aplicaciones LLM del sector sanitario

- Estándares PCI DSS: Asegurar los datos de pago en sistemas financieros basados en LLM

- Cumplimiento SOX: Mantener controles internos para aplicaciones financieras LLM

Conclusión: Asegurando la Innovación en LLM

La seguridad de los modelos de lenguaje extensos requiere enfoques integrales que aborden vectores de amenazas únicos al tiempo que permiten la innovación. Las organizaciones que implementan marcos de seguridad robustos para LLM se posicionan para aprovechar el potencial transformador de la inteligencia artificial, manteniendo la confianza de los interesados y el cumplimiento normativo.

Una seguridad efectiva en LLM combina controles técnicos con gobernanza organizacional, creando sistemas resilientes que se adaptan a las amenazas en evolución mientras generan valor empresarial. A medida que se acelera la adopción de LLM, la seguridad se convierte no solo en un requisito de cumplimiento, sino en una ventaja competitiva.

DataSunrise: Tu Socio en Seguridad LLM

DataSunrise lidera en soluciones de seguridad LLM, ofreciendo Protección AI Integral con Detección Avanzada de Amenazas, diseñada para entornos LLM complejos. Nuestra plataforma escalable y rentable sirve a organizaciones que van desde startups hasta empresas de la lista Fortune 500.

Experimenta nuestra Orquestación de Seguridad Autónoma y descubre cómo DataSunrise logra una Reducción Cuantificable del Riesgo en despliegues de LLM. Programa tu demo para explorar nuestras capacidades de seguridad en LLM.