Cómo Asegurar Canalizaciones de IA Generativa

La IA generativa (GenAI) ha transformado industrias al permitir la creación de texto, imágenes y código con características humanas. Pero detrás de esta innovación se esconde una canalización de datos sensibles, modelos de aprendizaje automático y cargas de trabajo dinámicas que son cada vez más vulnerables al uso indebido. Asegurar estas canalizaciones es fundamental para mantener la privacidad, garantizar la confianza y lograr el cumplimiento.

Este artículo explora cómo asegurar las canalizaciones de IA generativa utilizando auditoría en tiempo real, enmascaramiento dinámico y descubrimiento automatizado de datos. También incluye un ejemplo básico y enlaces a recursos adicionales.

Qué Hace Vulnerables a las Canalizaciones de IA Generativa

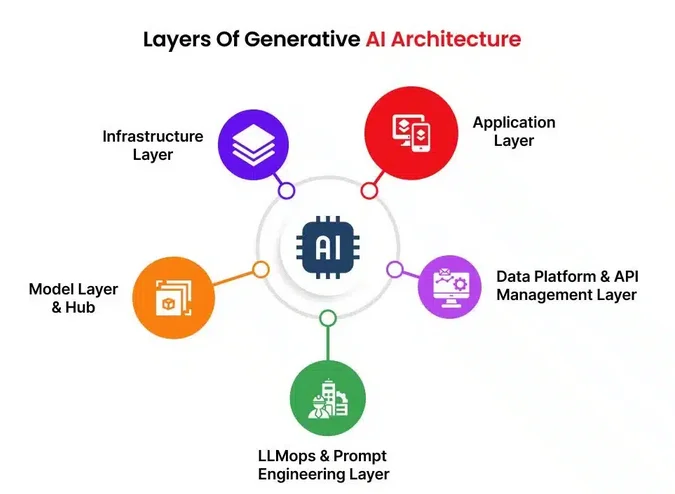

Los flujos de trabajo de GenAI típicamente implican el entrenamiento de modelos y la inferencia utilizando conjuntos de datos masivos. Estas canalizaciones incluyen la ingestión de datos, el preprocesamiento, el alojamiento de modelos, las indicaciones y las salidas generadas. En cada etapa, se pueden exponer datos sensibles como información de identificación personal (PII), propiedad intelectual exclusiva o registros financieros.

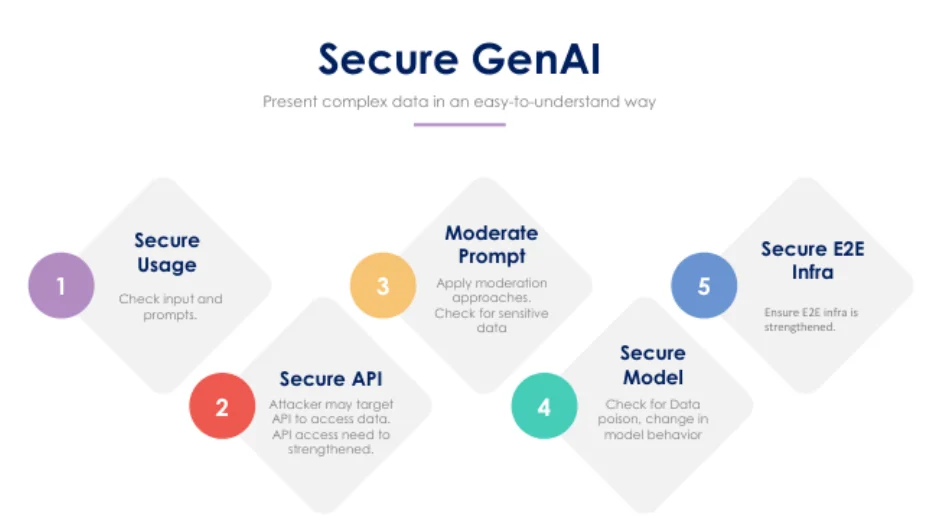

Entre las vulnerabilidades típicas se encuentran las inyecciones en las indicaciones, los ataques de jailbreak y la exposición de datos sensibles de entrenamiento o inferencia. Con frecuencia, estas canalizaciones carecen de supervisión en tiempo real y sufren de prácticas deficientes de control de acceso. Incluso los LLM bien ajustados pueden devolver fragmentos de datos no intencionados de la memoria o generar salidas que violen los límites de cumplimiento.

Auditoría en Tiempo Real: La Primera Línea de Defensa

La auditoría en tiempo real permite a las organizaciones monitorear cada acceso y acción que involucre datos, indicaciones o el uso del modelo. Al registrar consultas e interacciones de usuarios, se crea una pista de responsabilidad que respalda las investigaciones y detecta anomalías a medida que ocurren.

Un ejemplo básico con PostgreSQL:

CREATE EVENT TRIGGER audit_prompt_access

ON sql_drop

EXECUTE FUNCTION log_prompt_usage();

Con una herramienta como DataSunrise Database Activity Monitoring, se puede ampliar esto para incluir análisis de comportamiento, rastrear quién consultó qué modelo y recibir alertas sobre patrones de entrada riesgosos.

Enmascaramiento Dinámico de Datos para Entradas y Salidas de Indicaciones

El enmascaramiento a nivel de indicaciones es crucial cuando se trabaja con datos regulados. Por ejemplo, un modelo de GenAI al que se le solicite generar un informe nunca debería ver los nombres reales de los pacientes. El enmascaramiento dinámico oculta o redacciona campos en el momento de la consulta, sin alterar los datos fuente. Esto protege las consultas de inferencia, previene la fuga de salidas sensibles y reduce el radio de impacto en caso de fuga de indicaciones o vulnerabilidad de memoria.

Ejemplo:

SELECT name, diagnosis, treatment

FROM patients

WHERE region = 'EU'

MASKED WITH (name = 'XXXX', treatment = '***');

Herramientas como DataSunrise aplican reglas dinámicas basadas en roles y en el contexto de la consulta.

Descubrimiento Automatizado de Datos: Conozca lo que Está en Juego

Antes de asegurar la GenAI, se debe saber qué se está protegiendo. Las herramientas de descubrimiento de datos escanean automáticamente las bases de datos y las canalizaciones para detectar información de identificación personal (PII), información de salud protegida (PHI), datos PCI y cualquier contenido no estructurado compartido con los LLM. Estas herramientas también pueden inspeccionar el almacenamiento de blobs o las bases de datos vectoriales en busca de contenido sensible.

Al aprovechar los motores de descubrimiento de datos integrados con herramientas de seguridad, las organizaciones pueden clasificar activos y aplicar automáticamente las políticas de enmascaramiento o registro apropiadas.

Alineación con las Regulaciones de Cumplimiento de Datos

Ya sea en el sector salud, financiero o del comercio electrónico, el uso de la IA generativa debe alinearse con las leyes de cumplimiento de datos, como GDPR, HIPAA o PCI DSS.

Para mantenerse en cumplimiento, es importante aplicar controles de acceso basados en roles, clasificar los datos según sus niveles de sensibilidad y utilizar pistas de auditoría y técnicas de enmascaramiento para cumplir con los requerimientos legales. Las verificaciones de cumplimiento en tiempo real actúan como una salvaguarda, previniendo potenciales violaciones antes de que ocurran.

Mejores Prácticas para la Seguridad en la GenAI

El uso de proxies inversos o gateways de API con filtrado ayuda a controlar el tráfico hacia y desde los modelos de GenAI. Registrar cada interacción con el modelo y los datos a los que se accede garantiza responsabilidad. Es igualmente importante establecer reglas de alerta basadas en el comportamiento del usuario y en entradas riesgosas. Las indicaciones y respuestas deben ser analizadas en busca de información de identificación personal (PII), y cuando sea posible, se deben reemplazar datos reales por datos sintéticos en tareas de entrenamiento del modelo.

Reflexiones Finales

A medida que la IA generativa se integra cada vez más en las operaciones empresariales, su seguridad debe tratarse con el mismo rigor que los sistemas tradicionales de TI. La combinación de auditoría en tiempo real, enmascaramiento, descubrimiento y aplicación de cumplimiento crea una defensa robusta contra violaciones de datos y multas regulatorias.

Para profundizar en estos temas, explore:

- Herramientas de LLM y ML para la Seguridad de Bases de Datos

- Guía de Auditoría

- Políticas de Seguridad para Bases de Datos

También consulte este artículo de OpenAI sobre la alineación de seguridad en LLM y El Marco de IA Segura (SAIF) de Google para conceptos de seguridad más amplios.