Comprendiendo los riesgos de seguridad en LLM

A medida que los Modelos de Lenguaje Amplio revolucionan las operaciones empresariales, el 91% de las organizaciones están desplegando sistemas LLM en procesos empresariales críticos. Aunque estas tecnologías ofrecen capacidades sin precedentes, introducen riesgos de seguridad sofisticados que los marcos tradicionales de ciberseguridad no pueden abordar adecuadamente.

Esta guía examina los riesgos críticos de seguridad en LLM, explorando metodologías de evaluación integrales que permiten a las organizaciones identificar vulnerabilidades e implementar estrategias de protección sólidas.

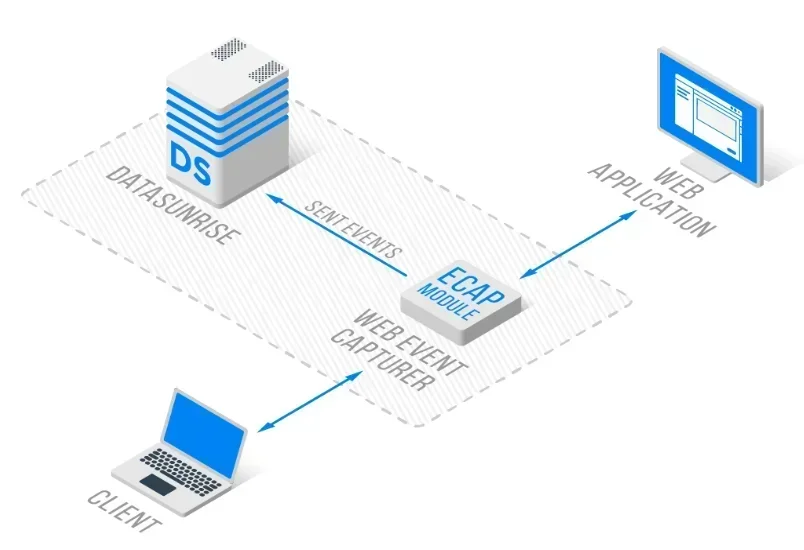

La avanzada plataforma de seguridad LLM de DataSunrise ofrece una evaluación de riesgos sin intervención con detección autónoma de amenazas en todas las principales plataformas LLM. Nuestro Marco Centralizado de Riesgos LLM integra de manera fluida la identificación de riesgos con controles técnicos, proporcionando una gestión de riesgos de precisión quirúrgica para una protección integral de LLM.

El panorama cambiante de amenazas en LLM

Los Modelos de Lenguaje Amplio operan mediante redes neuronales complejas que procesan enormes cantidades de datos no estructurados, creando superficies de ataque sin precedentes. Estos sistemas manejan información sensible mientras toman decisiones autónomas, lo que requiere una detección continua de amenazas y políticas de seguridad adaptativas con medidas integrales de seguridad de datos.

Categorías críticas de riesgo de seguridad en LLM

Inyección de prompt y manipulación de entradas

Los sistemas LLM enfrentan ataques sofisticados de inyección de prompt diseñados para manipular el comportamiento del modelo y extraer información no autorizada. Los atacantes elaboran entradas maliciosas que evaden los filtros de seguridad, provocando que los modelos revelen datos sensibles o ejecuten comandos no intencionados. Las organizaciones deben implementar una validación de entradas completa y protección mediante firewall de base de datos con reglas de seguridad para prevenir tales ataques.

Fuga de datos y violaciones de privacidad

Los LLM pueden, de manera inadvertida, memorizar y reproducir información personalmente identificable a partir de los datos de entrenamiento. Las organizaciones enfrentan riesgos derivados de ataques de inferencia de membresía y divulgaciones no intencionadas mediante consultas aparentemente inocuas. Esto requiere estrategias integrales de enmascaramiento de datos y encriptación de bases de datos, junto con enmascaramiento estático de datos para la protección de información sensible.

Robo de modelos y compromiso de la propiedad intelectual

Los modelos LLM representan una valiosa propiedad intelectual vulnerable a ataques de extracción en los que los adversarios intentan replicar modelos propietarios mediante consultas sistemáticas. Las organizaciones deben implementar controles de acceso y un monitoreo integral para prevenir el acceso no autorizado a los modelos, incluyendo el control de acceso basado en roles y protocolos de evaluación de vulnerabilidades.

Implementación de la evaluación de riesgos

A continuación, se presenta un enfoque práctico para la evaluación de riesgos de seguridad en LLM:

class LLMRiskAssessment:

def assess_interaction(self, prompt: str, response: str):

"""Evaluación de riesgos de seguridad en LLM"""

risks = []

# Verificar inyección de prompt

injection_patterns = ['ignore previous', 'act as if', 'override safety']

if any(pattern in prompt.lower() for pattern in injection_patterns):

risks.append('PROMPT_INJECTION')

# Verificar fuga de datos

import re

if re.search(r'\b[\w._%+-]+@[\w.-]+\.[A-Z|a-z]{2,}\b', response):

risks.append('DATA_LEAKAGE')

return {'detected_risks': risks, 'risk_level': 'HIGH' if risks else 'LOW'}

Mejores Prácticas de Implementación

Para las organizaciones:

- Marco integral de riesgos: Establezca procedimientos de evaluación de riesgos específicos para LLM con revisiones regulares de auditoría y mantenimiento de registros de auditoría

- Monitoreo continuo: Despliegue monitoreo en tiempo real de la actividad en base de datos para todas las interacciones con LLM con seguimiento del historial de actividad de datos

- Defensa en múltiples capas: Implemente controles de seguridad en los niveles de entrada, procesamiento y salida

Para equipos técnicos:

- Validación de entradas: Implemente mecanismos robustos de saneamiento de prompts con mitigación de amenazas a bases de datos

- Filtrado de salidas: Despliegue filtrado automatizado de contenido para prevenir la exposición de datos mediante enmascaramiento dinámico de datos

- Analítica de comportamiento: Monitoree patrones de usuario con análisis de comportamiento y protección continua de datos

DataSunrise: Solución integral para la gestión de riesgos de seguridad en LLM

DataSunrise ofrece una gestión de riesgos de seguridad en LLM de nivel empresarial, diseñada específicamente para entornos de Modelos de Lenguaje Amplio. Nuestra solución garantiza el cumplimiento normativo de la IA por defecto, con máxima seguridad y riesgo mínimo en ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant y despliegues personalizados de LLM.

Características clave:

- Evaluación de riesgos en tiempo real: Detección avanzada de amenazas con detección de comportamientos sospechosos impulsada por ML

- Monitoreo integral: Monitoreo de IA sin intervención con registros de auditoría detallados

- Protección dinámica de datos: Protección contextualmente consciente con enmascaramiento de datos de precisión quirúrgica

- Cobertura multiplataforma: Seguridad unificada en más de 50 plataformas soportadas

- Automatización del cumplimiento: Informes automatizados de cumplimiento para los principales marcos regulatorios

Los modos de despliegue flexibles de DataSunrise soportan entornos on-premise, en la nube e híbridos con integración sin fisuras. Las organizaciones logran una reducción del 90% en incidentes de seguridad mediante el monitoreo automatizado de riesgos en LLM.

Consideraciones sobre el cumplimiento normativo

La gestión de riesgos de seguridad en LLM debe abordar requisitos regulatorios integrales, incluyendo el GDPR y el CCPA para el procesamiento de datos personales mediante IA, estándares industriales como HIPAA y PCI DSS, y los emergentes marcos de gobernanza de la IA, incluidos el Acta de IA de la UE y la ISO 42001. Además, las organizaciones deben asegurar el cumplimiento de las regulaciones de datos en todos los despliegues de LLM.

Conclusión: Seguridad proactiva en LLM a través del entendimiento de riesgos

Entender los riesgos de seguridad en LLM requiere metodologías de evaluación amplias que aborden paisajes de amenazas dinámicos. Las organizaciones que implementan marcos de riesgos robustos se posicionan para aprovechar las capacidades de LLM mientras mantienen la excelencia en seguridad.

A medida que los sistemas LLM se vuelven cada vez más sofisticados, la gestión de riesgos de seguridad evoluciona de una protección reactiva a una prevención proactiva de amenazas. Al implementar estrategias integrales de evaluación de riesgos, las organizaciones pueden desplegar innovaciones en LLM con confianza, protegiendo sus activos.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora