Encuestas y Perspectivas de Seguridad LLM

Conforme las organizaciones integran modelos de lenguaje a gran escala (LLM) en sus operaciones diarias, el enfoque en la seguridad de LLM ha crecido rápidamente. Estos modelos manejan datos sensibles y deben seguir estándares estrictos para auditorías, enmascaramiento y cumplimiento. Este artículo explora las Encuestas y Perspectivas de Seguridad LLM con técnicas del mundo real para fortalecer los despliegues de GenAI y alinearse con regulaciones como GDPR y HIPAA.

LLMs en Casos de Uso Orientados a la Seguridad

Los LLM ahora soportan tareas como la detección de phishing, la resumición de registros y la generación de reglas. Sin embargo, el acceso al código, los registros o los datos de usuarios crea el riesgo de fugas accidentales. Por ello, el uso de herramientas para el monitoreo de cumplimiento en tiempo real y el enmascaramiento dinámico es crítico cuando los LLM operan en entornos de producción.

Modelos de amenazas más detallados están disponibles en este post del blog de MITRE ATLAS, que describe tácticas adversariales específicas para LLM.

Auditoría en Tiempo Real para Inferencia y Entrenamiento

El acceso a los datos del LLM debe ser monitoreado al igual que las consultas de base de datos. Las auditorías en tiempo real registran detalles del mensaje, el contexto recuperado y las búsquedas vectoriales. Por ejemplo, si tu LLM utiliza PostgreSQL con pgvector, puedes registrar estas consultas usando el módulo de Monitoreo de Actividad en Base de Datos.

SELECT content FROM documents

WHERE embedding <#> '[0.134, -0.256, 0.789, ...]' < 0.75

LIMIT 5;

Esta consulta puede ser revisada al instante para la clasificación de la fuente de datos o para detectar violaciones de cumplimiento. También puedes explorar métodos de auditoría en el blog de ingeniería de Pinecone, que destaca desafíos relacionados con vectores.

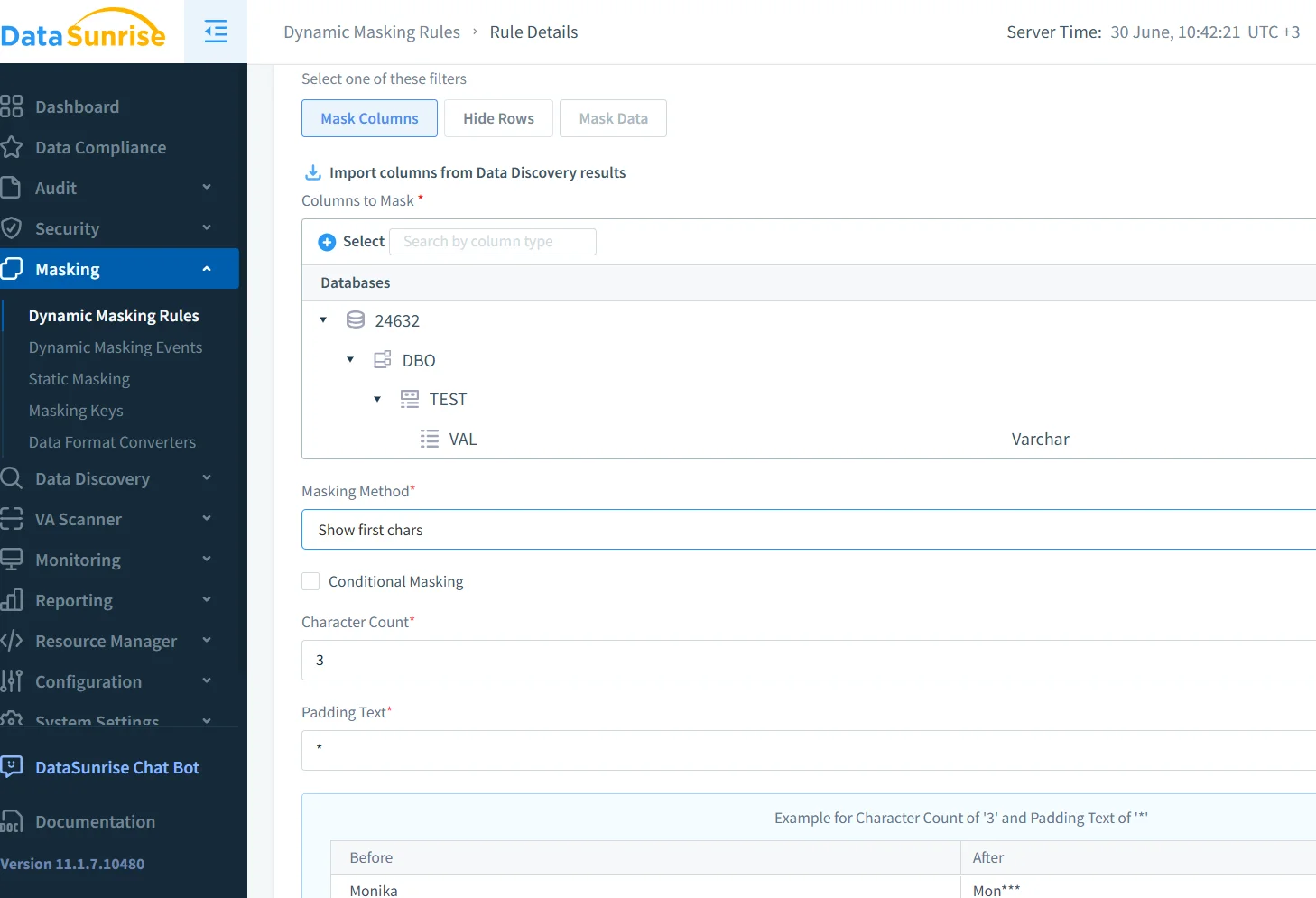

Enmascaramiento Dinámico para la Seguridad en los Mensajes

El enmascaramiento dinámico oculta elementos sensibles como correos electrónicos o identificaciones antes de que lleguen al modelo. Se aplica de manera contextual y puede variar según el rol o el patrón. En DataSunrise, el enmascaramiento de datos funciona en los mensajes utilizando plantillas basadas en reglas.

{"user_id": "u-4982", "email": "[email protected]", "error": "access denied"}Se convierte en:

{"user_id": "u-4982", "email": "*****@company.com", "error": "access denied"}El artículo de OpenAI sobre aprender a rechazar explora estrategias de enmascaramiento relacionadas.

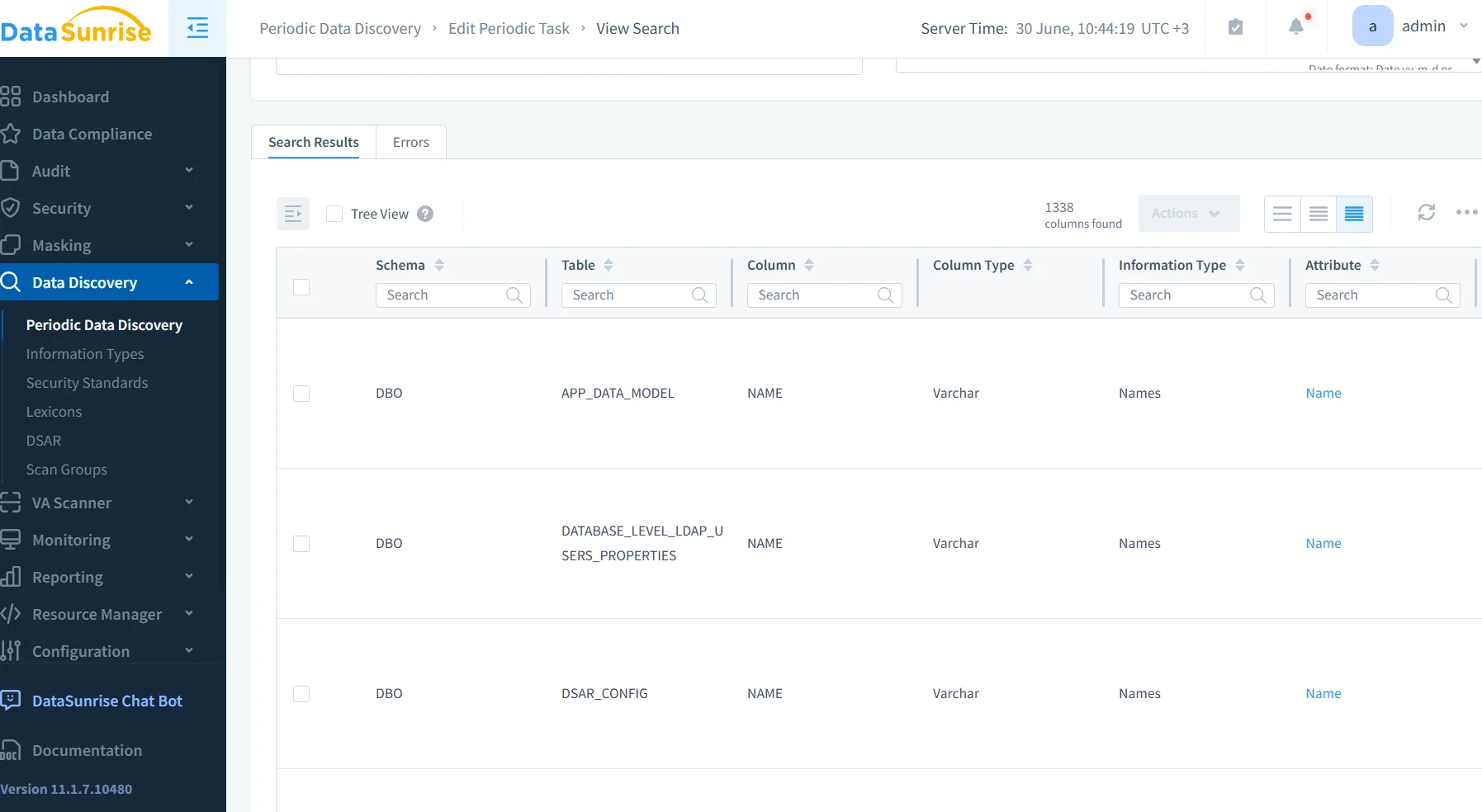

Descubrimiento de Datos en Pipelines de Embedding

En muchos sistemas, la vectorización comienza antes de que el contenido sea analizado. Este enfoque es arriesgado. En su lugar, utiliza herramientas de descubrimiento de datos para inspeccionar los registros antes de indexarlos.

Los registros con PII o PHI pueden ser marcados y redirigidos. DataSunrise se integra con flujos de trabajo como Airflow o dbt para aplicar estos análisis de forma automática.

La guía de Cohere sobre privacidad en LLM muestra cómo aplicar prácticas recomendadas similares.

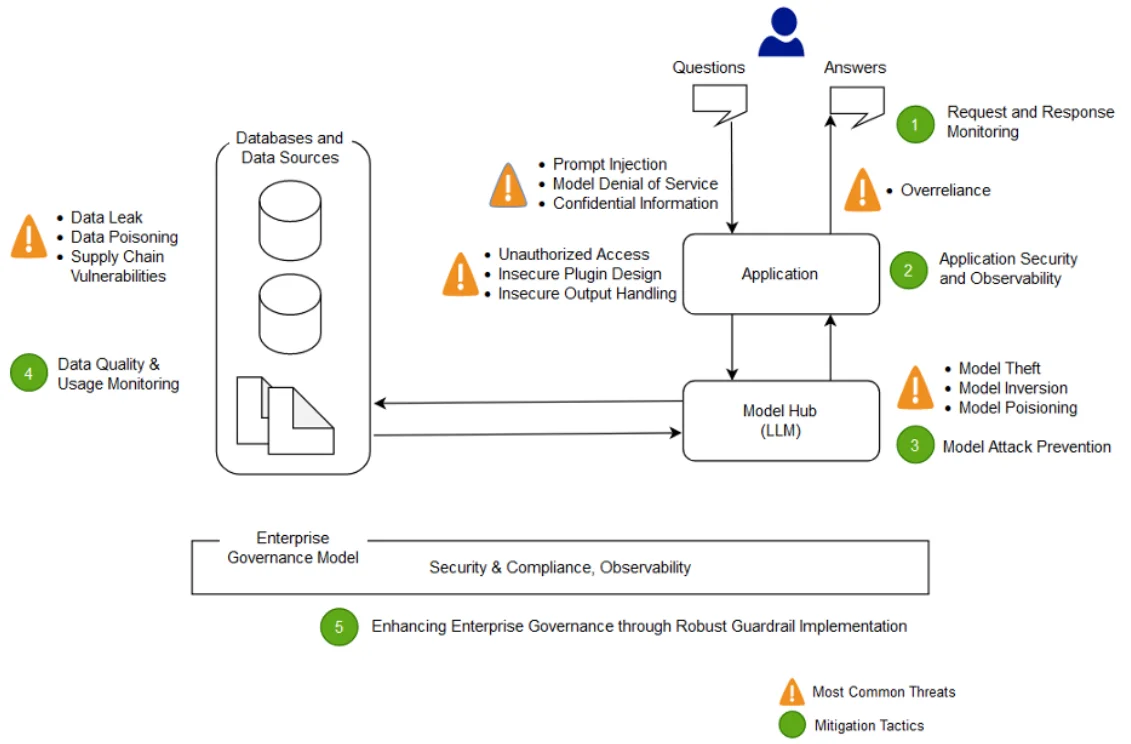

Perspectivas de Seguridad en Despliegues de LLM

Las encuestas de los equipos de seguridad destacan problemas recurrentes. La inyección de mensajes sigue siendo una preocupación. La ausencia de reglas de enmascaramiento permite que se memorice contenido sensible. Las lagunas en los rastros de auditoría vectorial retrasan las investigaciones, y los cambios en el modelo pasan desapercibidos.

Para abordar esto, muchos equipos incorporan etiquetas de auditoría, restringen los mensajes y utilizan pasarelas para el tráfico de inferencias. Puedes explorar mitigaciones más profundas en LLMGuard, que examina tanto los controles de proxy como los métodos de filtrado de tokens.

Operaciones LLM Preparadas para el Cumplimiento

Para cumplir con GDPR, HIPAA o PCI-DSS, tu sistema debe registrar el acceso a los datos, clasificar las fuentes y aplicar enmascaramiento cuando sea necesario. El aislamiento entre los LLM y los datos en vivo también es clave.

El DataSunrise Compliance Manager soporta todos estos controles e se integra fácilmente con plataformas SIEM externas. También puedes revisar el Marco de Riesgos de IA de NIST para obtener una guía más amplia.

Mirando Hacia el Futuro: Firewalls de Datos Conscientes de los LLM

La próxima generación de firewalls no solo inspeccionará SQL, sino que analizará mensajes, embeddings y completaciones. Estas herramientas detectarán usos indebidos, evitarán el exceso de compartición y bloquearán flujos peligrosos. Al igual que un firewall de bases de datos, pero consciente de los LLM.

Proyectos como Guardrails AI y LLM-Defender están desarrollando esta visión. Cuando se combinan con políticas de seguridad basadas en reglas de DataSunrise, el resultado es una protección fuerte y adaptativa.

Este concepto se refleja en la IA Constitucional de Anthropic, la cual propone LLM que aplican controles internos de políticas por diseño.

Reflexiones Finales

Los LLM actuales necesitan más que rendimiento: necesitan protección. Las auditorías en tiempo real, el enmascaramiento dinámico y los flujos de trabajo de descubrimiento constituyen el núcleo de las modernas Encuestas y Perspectivas de Seguridad LLM. Con plataformas como DataSunrise, estas salvaguardas se integran en la arquitectura de tu LLM, y no son una ocurrencia tardía.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora