Estrategias de privacidad de datos para modelos de IA y LLM

A medida que la inteligencia artificial transforma las operaciones empresariales, el 87% de las organizaciones está implementando modelos de IA y LLM en flujos de trabajo críticos para el negocio. Aunque estas tecnologías ofrecen capacidades sin precedentes, introducen sofisticados desafíos de privacidad de datos que los marcos de privacidad tradicionales no pueden abordar adecuadamente.

Esta guía examina estrategias integrales de privacidad de datos para modelos de IA y LLM, explorando técnicas de implementación que permiten a las organizaciones mantener una protección robusta de la privacidad mientras maximizan el potencial transformador de la IA.

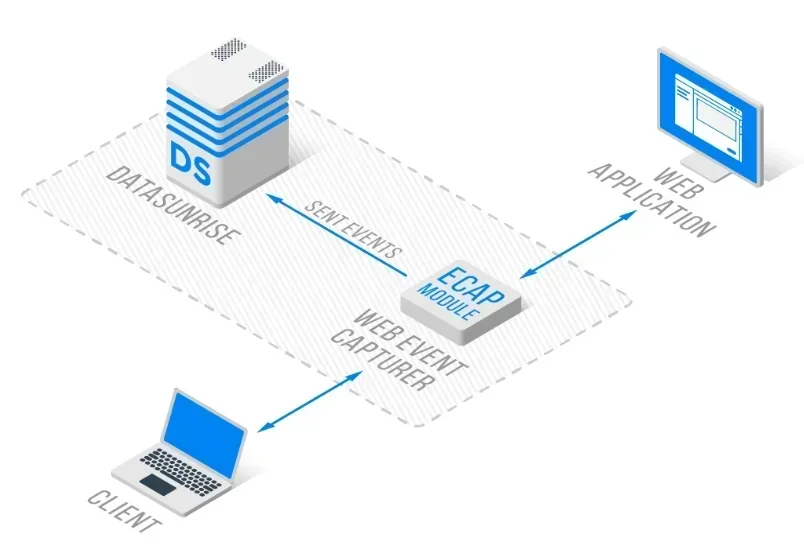

La avanzada plataforma de Protección de Privacidad de IA de DataSunrise ofrece Orquestación de Privacidad sin Intervención con Protección de Datos Autónoma en todas las principales plataformas de IA. Nuestro Marco Centralizado de Privacidad para IA integra de manera fluida las estrategias de privacidad con controles técnicos, proporcionando una gestión de privacidad de Precisión Quirúrgica para una protección integral de IA y LLM con Cumplimiento de IA por Defecto.

Comprendiendo los desafíos de privacidad de datos en la IA

Los modelos de IA y LLM procesan grandes cantidades de datos a lo largo de su ciclo de vida, creando riesgos de exposición de privacidad sin precedentes. A diferencia de las aplicaciones tradicionales, los sistemas de IA aprenden continuamente de diversas fuentes de datos, lo que hace que la protección de la privacidad sea exponencialmente más compleja.

Estos modelos a menudo manejan información sensible que incluye identificadores personales y datos empresariales confidenciales. Las organizaciones deben implementar medidas integrales de seguridad de datos mientras mantienen capacidades de auditoría diseñadas específicamente para entornos de IA con políticas de seguridad adecuadas.

Estrategias críticas de protección de la privacidad

Minimización de datos y limitación de propósito

Las estrategias de privacidad en IA deben implementar principios estrictos de minimización de datos, asegurando que los modelos procesen únicamente la información esencial para su propósito previsto. Las organizaciones deben aplicar técnicas de enmascaramiento dinámico de datos e implementar controles de acceso granulares con protección de firewall de base de datos.

Técnicas de entrenamiento que preservan la privacidad

Las estrategias avanzadas de privacidad incluyen la implementación de privacidad diferencial, enfoques de aprendizaje federado y generación de datos sintéticos para el entrenamiento de modelos. Estas técnicas permiten el desarrollo de IA mientras protegen la privacidad individual mediante garantías matemáticas con la implementación de cifrado de bases de datos.

Monitoreo de privacidad en tiempo real

La privacidad efectiva en la IA requiere un monitoreo continuo de los flujos de datos, detección automatizada de PII y alertas inmediatas de violaciones de privacidad. Las organizaciones deben desplegar sistemas de monitoreo de actividad de bases de datos con análisis del comportamiento y completos registros de auditoría.

Ejemplos de implementación técnica

Preprocesamiento de datos que preserva la privacidad

La siguiente implementación demuestra cómo detectar y enmascarar automáticamente la PII en datos de texto antes del procesamiento por IA. Este enfoque asegura que la información sensible esté protegida, al mismo tiempo que se mantiene la utilidad de los datos para los modelos de IA:

import hashlib

import re

class AIPrivacyPreprocessor:

def __init__(self):

self.pii_patterns = {

'email': r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b',

'phone': r'\b\d{3}-\d{3}-\d{4}\b',

'ssn': r'\b\d{3}-\d{2}-\d{4}\b'

}

def mask_sensitive_data(self, text: str):

"""Enmascarar la información de identificación personal en el texto antes del procesamiento de IA"""

masked_text = text

detected_pii = []

for pii_type, pattern in self.pii_patterns.items():

matches = re.findall(pattern, text)

for match in matches:

masked_value = f"[{pii_type.upper()}_MASKED]"

masked_text = masked_text.replace(match, masked_value)

detected_pii.append({'type': pii_type, 'original': match})

return {

'masked_text': masked_text,

'detected_pii': detected_pii,

'privacy_score': 1.0 if not detected_pii else 0.7

}

Sistema de auditoría de privacidad para modelos de IA

Esta implementación muestra cómo crear un sistema de auditoría integral que monitorea las interacciones de IA en busca de violaciones de privacidad y genera informes de cumplimiento:

from datetime import datetime

import hashlib

import re

class AIModelPrivacyAuditor:

def __init__(self, privacy_threshold: float = 0.8):

self.privacy_threshold = privacy_threshold

self.audit_log = []

def audit_model_interaction(self, user_id: str, prompt: str, response: str):

"""Auditoría integral de la privacidad para las interacciones con el modelo de IA"""

audit_record = {

'timestamp': datetime.utcnow().isoformat(),

'user_id': user_id,

'interaction_id': hashlib.md5(f"{user_id}{datetime.utcnow()}".encode()).hexdigest()[:12]

}

# Analizar riesgos de privacidad

privacy_score = self._calculate_privacy_score(prompt + response)

audit_record['privacy_score'] = privacy_score

audit_record['compliant'] = privacy_score >= self.privacy_threshold

self.audit_log.append(audit_record)

return audit_record

def _calculate_privacy_score(self, text: str):

"""Calcular la puntuación de privacidad basada en la detección de PII"""

pii_patterns = [r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b']

score = 1.0

for pattern in pii_patterns:

if re.search(pattern, text):

score -= 0.3

return max(score, 0.0)

Mejores prácticas de implementación

Para las organizaciones:

- Arquitectura de privacidad por diseño: Incorpore controles de privacidad en los sistemas de IA desde el inicio con control de acceso basado en roles

- Protección multicapa: Despliegue controles de privacidad integrales en las etapas de entrenamiento e inferencia

- Monitoreo continuo: Implemente monitoreo de privacidad en tiempo real con protocolos de evaluación de vulnerabilidades

Para equipos técnicos:

- Controles de privacidad automatizados: Implemente enmascaramiento de datos y mecanismos dinámicos de protección

- Técnicas que preservan la privacidad: Utilice aprendizaje federado y privacidad diferencial con enmascaramiento estático de datos

- Respuesta a incidentes: Cree procedimientos de respuesta específicos para la privacidad con capacidades de detección de amenazas y protección de datos

DataSunrise: Solución integral de privacidad para IA

DataSunrise ofrece protección de privacidad de datos de nivel empresarial, diseñada específicamente para entornos de IA y LLM. Nuestra solución entrega Máxima Seguridad y Mínimo Riesgo con Cumplimiento de IA por Defecto en ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant y despliegues de IA personalizados.

Características clave:

- Monitoreo de privacidad en tiempo real: Monitoreo de IA sin intervención con completos registros de auditoría

- Protección avanzada de PII: Protección consciente del contexto con enmascaramiento de datos de precisión quirúrgica

- Cobertura multiplataforma: Protección de privacidad unificada en más de 50 plataformas compatibles

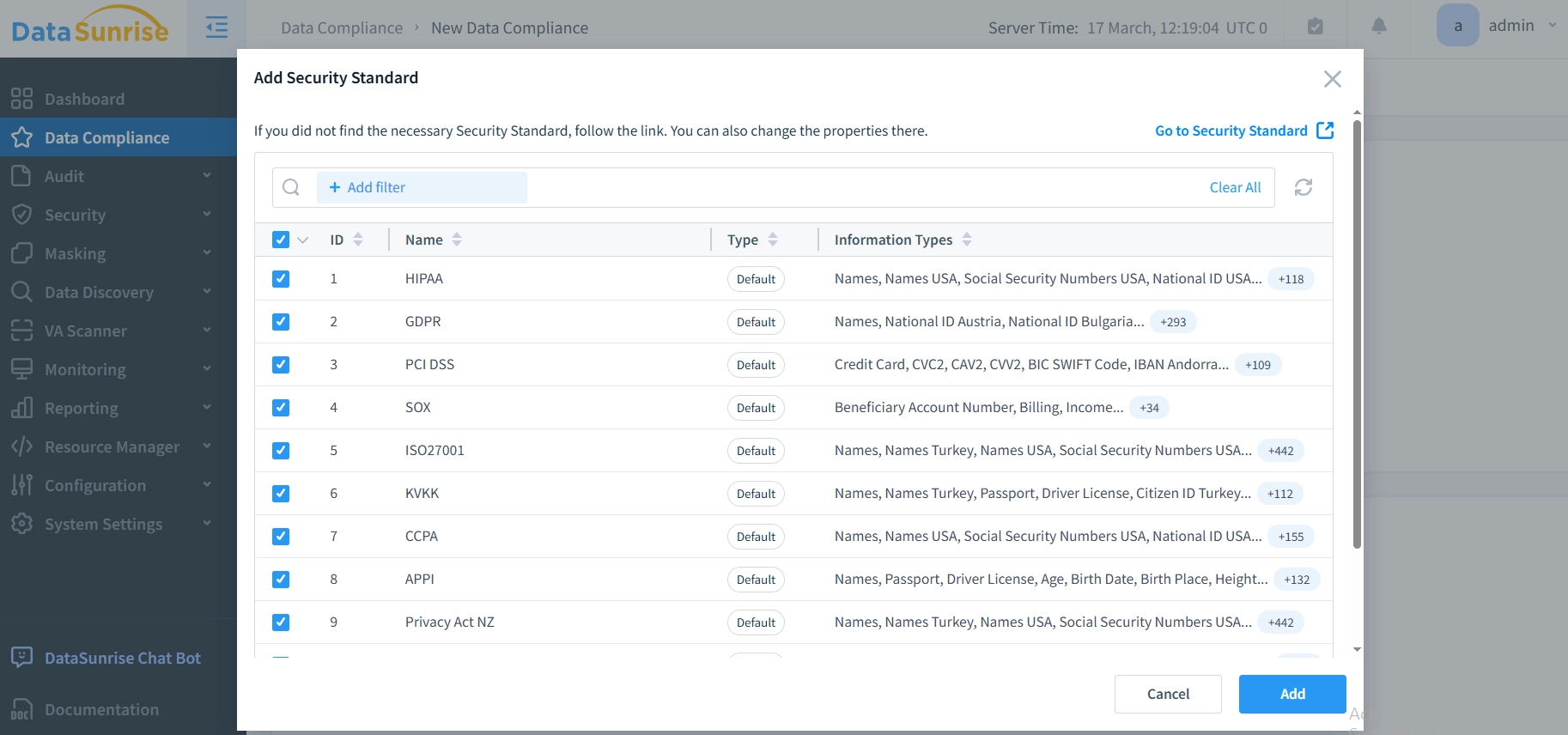

- Cumplimiento automatizado: Piloto automático de cumplimiento para requisitos de GDPR, HIPAA, PCI DSS

- Detección impulsada por ML: Detección de comportamientos sospechosos con identificación de anomalías en la privacidad

Los modos de despliegue flexibles de DataSunrise soportan entornos de IA locales, en la nube e híbridos con una implementación sin intervención. Las organizaciones logran una reducción significativa de los riesgos de privacidad y un mayor cumplimiento regulatorio mediante el monitoreo automatizado.

Consideraciones sobre el cumplimiento regulatorio

Las estrategias de privacidad de datos en IA deben abordar requisitos regulatorios integrales:

- Protección de datos: El GDPR y el CCPA exigen salvaguardias específicas de privacidad para el procesamiento de datos en IA

- Estándares de la industria: El sector sanitario (HIPAA) y los servicios financieros (PCI DSS) tienen requisitos especializados

- Gobernanza emergente de la IA: El EU AI Act y la ISO 42001 exigen privacidad por diseño en los sistemas de IA

Conclusión: Construyendo sistemas de IA con enfoque en la privacidad

Las estrategias de privacidad de datos para modelos de IA y LLM representan requisitos esenciales para el despliegue responsable de la IA. Las organizaciones que implementan marcos integrales de privacidad se posicionan para aprovechar el potencial transformador de la IA, manteniendo la confianza de los interesados y el cumplimiento regulatorio.

La privacidad efectiva en la IA se transforma de una carga de cumplimiento a una ventaja competitiva. Al implementar estrategias robustas de privacidad con monitoreo automatizado, las organizaciones pueden desplegar innovaciones en IA con confianza, protegiendo datos sensibles a lo largo de todo el ciclo de vida de la IA.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora