Evaluación de Seguridad para Modelos de IA Generativa

La IA generativa ha pasado de ser una novedad investigativa a convertirse en una herramienta esencial para las empresas. Desde la creación de contenido de marketing hasta el soporte de asistentes virtuales y el resumen de tickets de clientes, estos modelos ingieren y procesan grandes volúmenes de información sensible. Este nivel de acceso requiere una estrategia robusta de evaluación de seguridad adaptada al comportamiento único de los sistemas de IA generativa.

Una adecuada evaluación de seguridad para modelos de IA generativa no se trata solo de asegurar la infraestructura. Significa monitorear cómo estos modelos interactúan con los datos, garantizar el cumplimiento y adaptar los controles para prevenir fugas accidentales o el uso indebido de salidas sensibles.

Por Qué Importan las Evaluaciones de Seguridad para la IA Generativa

Los sistemas de IA generativa pueden memorizar los datos de entrenamiento, producir respuestas inesperadas e interactuar con los usuarios mediante lenguaje natural, lo cual presenta desafíos de seguridad que los sistemas tradicionales no enfrentan. Una sola instrucción podría extraer información propietaria o datos personales identificables a menos que se implementen sólidas medidas de protección de datos.

Además, introducen desafíos en cuanto al cumplimiento normativo. Si el modelo accede a datos regulados (como información de salud protegida o campos protegidos bajo PCI-DSS), esta interacción debe ser rastreada, enmascarada y auditada de acuerdo a marcos como las directrices de cumplimiento HIPAA o el marco GDPR. Para una visión más amplia sobre prácticas responsables de IA, consulta la guía de Microsoft sobre IA Responsable.

Auditoría en Tiempo Real de Instrucciones y Salidas de la IA Generativa

Las capacidades de auditoría en tiempo real son esenciales para asegurar que los sistemas de IA generativa no operen como cajas negras. Cada instrucción y respuesta generada debe capturarse con metadatos contextuales como el rol del usuario, marca temporal, IP y el modelo utilizado. Estos registros deben almacenarse de forma segura y estar disponibles para consultas en inspecciones de cumplimiento e investigaciones de amenazas.

Aquí hay un ejemplo simple en estilo SQL de cómo podría estructurarse una auditoría de salidas de la IA generativa:

Para explorar más, revisa esta referencia de registros de DataSunrise.

Enmascaramiento Dinámico en las Salidas de la IA

Los modelos generativos pueden exponer datos sensibles de manera involuntaria a través de finalizaciones o respuestas mejoradas mediante recuperación. Para mitigar esto, se debe aplicar enmascaramiento dinámico de datos a dos niveles:

- Enmascaramiento previo a la inferencia, donde la entrada al modelo de lenguaje se enmascara dinámicamente si contiene campos sensibles.

- Enmascaramiento posterior a la inferencia, donde las salidas del modelo se revisan y redactan antes de ser entregadas al usuario final.

El enmascaramiento dinámico también puede basarse en el control de acceso basado en roles, asegurando que solo los roles autorizados vean los valores sin procesar. Por ejemplo, si un modelo recupera los últimos cuatro dígitos del SSN de un cliente:

Un concepto complementario es la aplicación de confianza cero, explicado en este resumen de la Arquitectura de Confianza Cero del NIST.

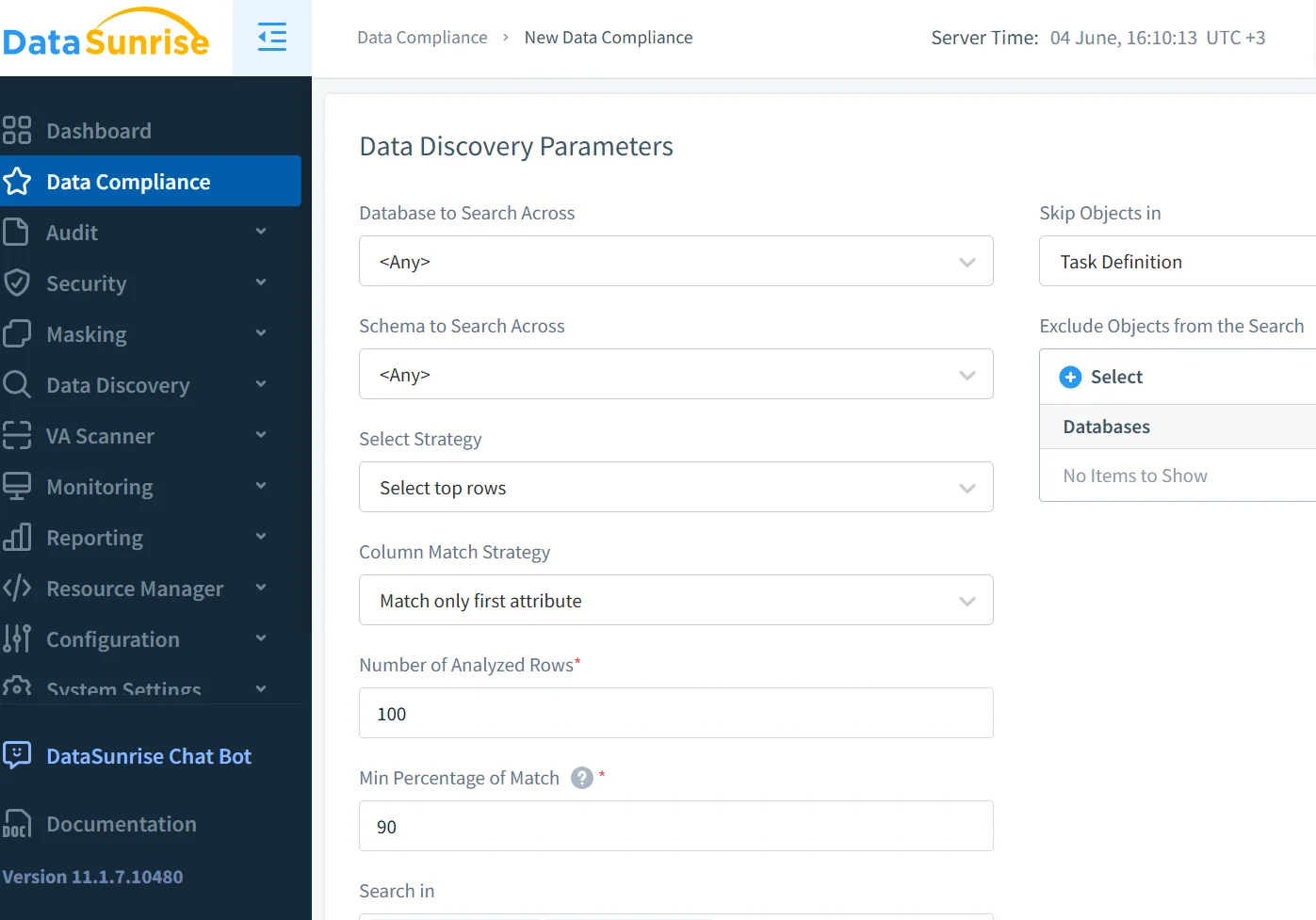

Descubrimiento de Datos Antes del Entrenamiento del Modelo

Antes de entrenar o ajustar finamente un modelo de lenguaje en conjuntos de datos internos, las empresas deben clasificar y mapear todos los campos de datos que puedan contener contenido sensible. La integración de herramientas automatizadas de descubrimiento de datos garantiza visibilidad en fuentes estructuradas y semiestructuradas.

Por ejemplo, etiquetar campos como:

- PII (por ejemplo, nombre, correo electrónico, teléfono)

- PHI (por ejemplo, historial médico)

- PCI (por ejemplo, número de tarjeta)

… puede activar automáticamente políticas de enmascaramiento y auditoría.

Combinado con el monitoreo de actividad, esto garantiza que el modelo nunca ingiera campos no rastreados o de alto riesgo.

Puedes encontrar prácticas adicionales de clasificación de datos en la guía de gobernanza de datos de Google Cloud.

Aplicación de Políticas de Seguridad y Cumplimiento para la IA Generativa

Para alinear los despliegues de IA generativa con las políticas empresariales, es necesario integrarlos en una plataforma de seguridad de datos capaz de:

| Capacidad de Seguridad | Descripción |

|---|---|

| Monitoreo de Acceso al Modelo | Registro en tiempo real de quién accede a qué y cuándo |

| Prevención de Inyección de Instrucciones y Abuso | Filtros y salvaguardas para detectar o bloquear entradas sospechosas |

| Informes para Auditoría y Cumplimiento | Genera informes estructurados listos para el cumplimiento |

| Clasificación de Campos y Tokenización | Identifica y protege automáticamente los campos sensibles |

Herramientas como el DataSunrise Compliance Manager automatizan gran parte de este esfuerzo.

También puedes referirte al documento de IBM sobre los Principios de Gobernanza de IA para obtener una orientación operativa más amplia.

Ejemplo: Bloqueo del Acceso de la IA a Campos Financieros

Supongamos que tu modelo generativo consulta una base de datos PostgreSQL para obtener registros financieros. Puedes restringir que las instrucciones de la IA accedan jamás a columnas como salary o card_number utilizando una política de enmascaramiento:

Dichos controles son esenciales para mantener los requisitos internos de cumplimiento de datos.

Amenazas Modernas en la Seguridad de la IA Generativa

Los sistemas de IA enfrentan nuevas clases de amenazas:

- Inyección de instrucciones: Los usuarios engañan al modelo para que revele datos

- Fuga durante el entrenamiento: Los datos sensibles se memorizan durante el ajuste fino

- Acceso en la sombra: Consultas no autorizadas ejecutadas a través de envoltorios de IA

Prevenir estas amenazas requiere análisis de comportamiento, limitación de tasa y modelos de detección diseñados específicamente para contextos de IA generativa. Técnicas como el análisis del comportamiento del usuario ayudan a identificar anomalías en las sesiones de los usuarios.

Para profundizar, consulta el Top 10 de OWASP para Aplicaciones de Modelos de Lenguaje Extensos y las notas de OpenAI sobre las mejores prácticas de seguridad.

Reflexiones Finales

Una evaluación de seguridad moderna para modelos de IA generativa debe ir más allá de los controles estáticos. Requiere protección dinámica, observabilidad en tiempo real y aplicación de políticas contextuales. Con las herramientas adecuadas, desde el descubrimiento de datos hasta el enmascaramiento y registros de auditoría, las organizaciones pueden escalar el uso de la IA generativa de forma segura sin sacrificar la confianza ni el cumplimiento.

Explora cómo las características de seguridad para IA generativa de DataSunrise respaldan una adopción de IA segura y conforme a las normativas a gran escala.