Gestión de la Postura de Seguridad en entornos de IA y LLM

En la era de la IA Generativa (GenAI) y los Modelos de Lenguaje Extensos (LLM), los datos no son solo un recurso, sino un participante activo en cada interacción. Estos modelos analizan, memorizan y responden a las indicaciones con una fluidez sorprendente; pero al hacerlo, se entrelazan profundamente con información sensible, regulada o propietaria. La lista de verificación de seguridad tradicional ya no es suficiente. En cambio, se requiere una estrategia dinámica y adaptativa, y eso comienza con un enfoque en Gestión de la Postura de Seguridad en entornos de IA y LLM.

¿Qué hace diferente la seguridad en IA y LLM?

A diferencia de los sistemas de software estáticos, los LLM operan en base a resultados probabilísticos derivados de conjuntos de datos masivos. Esto introduce nuevos retos. Los datos de entrenamiento pueden contener Información de Identificación Personal (PII) o secretos comerciales. Las salidas de inferencia podrían revelar accidentalmente dicha información. Las indicaciones maliciosas incluso pueden desencadenar comportamientos no intencionados o dañinos. Estos riesgos significan que la gestión de la postura de seguridad debe extenderse a lo largo de todo el ciclo de vida de la IA —desde la ingestión y el entrenamiento hasta el despliegue y la interacción con el usuario.

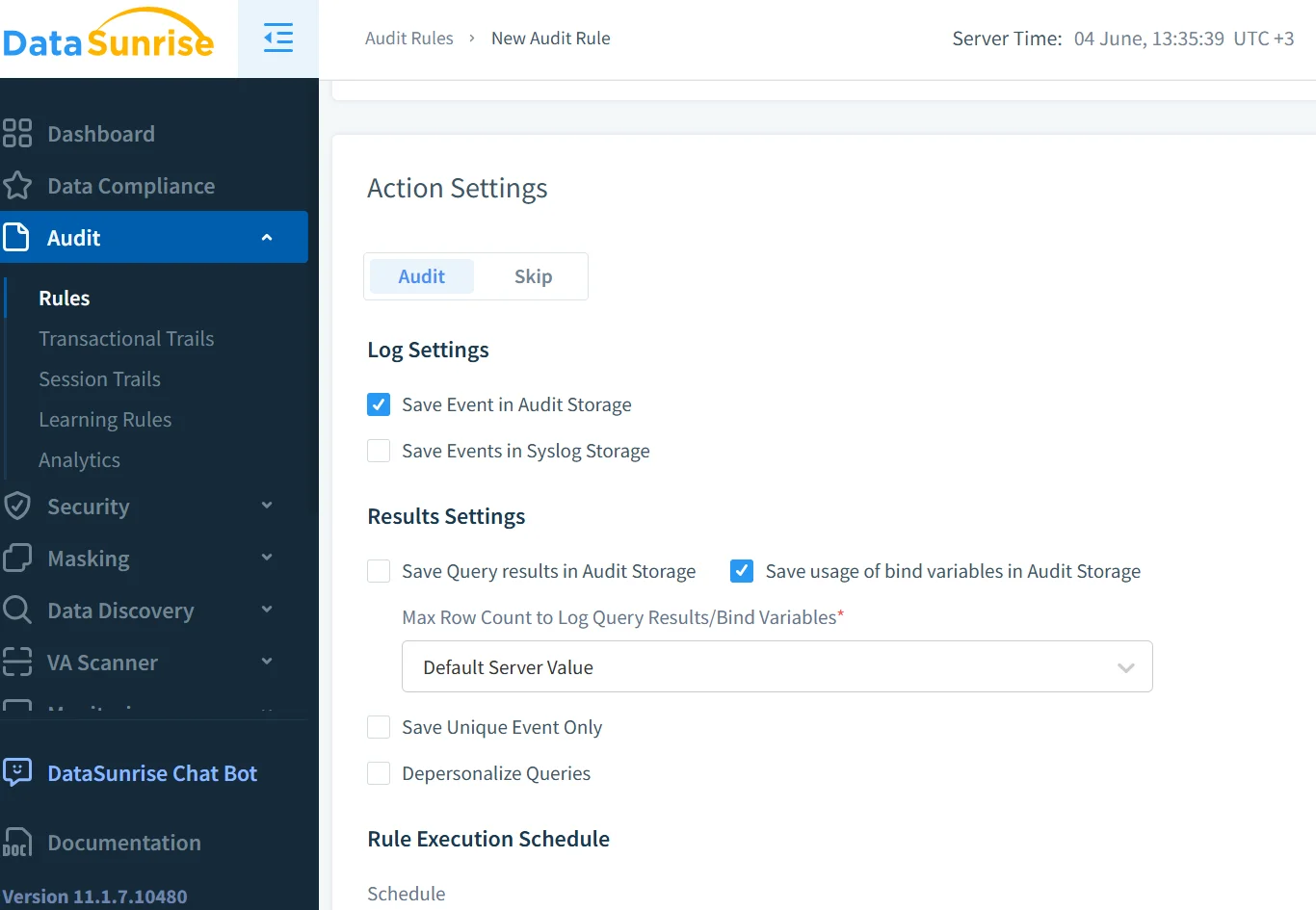

Auditoría en Tiempo Real para Interacciones con LLM

Los registros de auditoría son la columna vertebral de cualquier marco efectivo de gestión de la postura de seguridad. Pero en la IA Generativa, necesitamos capacidades de auditoría en tiempo real que van más allá de las operaciones básicas. Por ejemplo, considere este patrón de consulta similar a SQL para registrar el acceso a las indicaciones de la IA:

INSERT INTO audit_logs (user_id, prompt, timestamp, model_version)

SELECT CURRENT_USER, :prompt_text, NOW(), :model_id;

Al combinar esto con una herramienta de monitoreo en tiempo real se garantiza que las presentaciones de indicaciones, sus completaciones e incluso las incrustaciones sean capturadas, marcadas y atendidas. Con el monitoreo de actividad de la base de datos, los equipos de seguridad pueden ser alertados cuando una indicación toca conjuntos de datos sensibles o genera una salida de alto riesgo.

Descubriendo Datos Sensibles Antes de que Alcancen su Modelo

Los LLM son voraces en cuanto a datos, pero no todos los datos deberían ser introducidos en un modelo. Ahí es donde entra en juego el descubrimiento de datos. Permite a las organizaciones identificar, clasificar y etiquetar contenido sensible antes de que llegue a la línea de capacitación. Un escáner basado en comportamientos puede marcar credenciales en texto plano o frases relacionadas con la salud, garantizando que los datos problemáticos sean puestos en cuarentena.

Las herramientas de descubrimiento de datos integradas en las tuberías ayudan a aplicar controles de acceso basados en roles de modo que solo los usuarios autorizados puedan aprobar conjuntos de datos. Plataformas externas como AWS Macie también ofrecen una inspección avanzada de contenidos para detectar PII en grandes lagos de datos.

Enmascaramiento Dinámico para la Protección a Nivel de Indicación

Una indicación como “Cuéntame sobre mi cuenta” puede parecer segura hasta que recupera detalles reales del cliente. El enmascaramiento dinámico intercepta este proceso, limpiando o reemplazando valores sensibles en tiempo real. Esto evita que información confidencial se filtre durante los ciclos de indicación-respuesta.

# Ejemplo: enmascarar el número de cuenta en la indicación antes de enviarla al modelo

if "account_number" in prompt:

prompt = prompt.replace(user_account_number, "***-****-1234")

En los sistemas de generación aumentada por recuperación (RAG), el enmascaramiento dinámico garantiza que los resultados de documentos vectorizados no reintroduzcan contenido redactado. LangChain también soporta capas de aplicación de políticas para gestionar las entradas/salidas enmascaradas.

Construyendo una Estrategia de Seguridad Adaptativa y en Cumplimiento

El cumplimiento de la seguridad se está convirtiendo en central para el despliegue de LLM. Regulaciones como el GDPR, HIPAA y las propuestas leyes de gobernanza de la IA exigen una responsabilidad clara.

Una sólida postura de seguridad incluye registros de auditoría, alertas en tiempo real, enmascaramiento vinculado a reglas de cumplimiento y reportes automatizados. El gestor de cumplimiento de DataSunrise facilita el seguimiento de violaciones. De manera similar, el Secure AI Framework (SAIF) de Google proporciona principios para asegurar los ecosistemas de IA.

Ejemplo: Asegurando un Asistente Interno Basado en RAG

Considere un asistente LLM corporativo que utiliza RAG para responder preguntas de recursos humanos. Una indicación como “Muéstrame el desglose salarial para ejecutivos” podría revelar información restringida.

Para mitigar esto:

- Los registros en tiempo real rastrean las consultas y detectan palabras clave.

- El enmascaramiento elimina valores numéricos en la respuesta.

- El descubrimiento de datos marca archivos sensibles como las hojas de cálculo salariales.

- Las reglas de seguridad restringen el acceso según el rol del usuario.

El sistema se vuelve consciente del contexto y en cumplimiento, manteniendo tanto la funcionalidad como la seguridad.

El Futuro de la Postura de Seguridad en GenAI

La gestión de la postura de seguridad en los LLM debe evolucionar junto con los propios modelos. No se trata solo de proteger el acceso con cortafuegos, sino de diseñar sistemas de IA con una resiliencia incorporada. Esto significa combinar técnicas clásicas como la protección de datos con la detección de amenazas en tiempo real y el análisis del comportamiento del usuario.

Están surgiendo más herramientas para cubrir estas brechas, desde los filtros de contenido de Azure AI de Microsoft hasta la IA constitucional de Anthropic, que impone restricciones éticas a nivel del modelo.

Las organizaciones deben tratar la GenAI no como una caja negra, sino como un sistema vivo. El monitoreo, la auditoría, el enmascaramiento y el cumplimiento deben ser parte del proceso de diseño de la IA.

Para obtener más información, vea cómo DataSunrise soporta más de 40 plataformas de bases de datos con herramientas de postura de seguridad tanto para sistemas tradicionales como de GenAI.