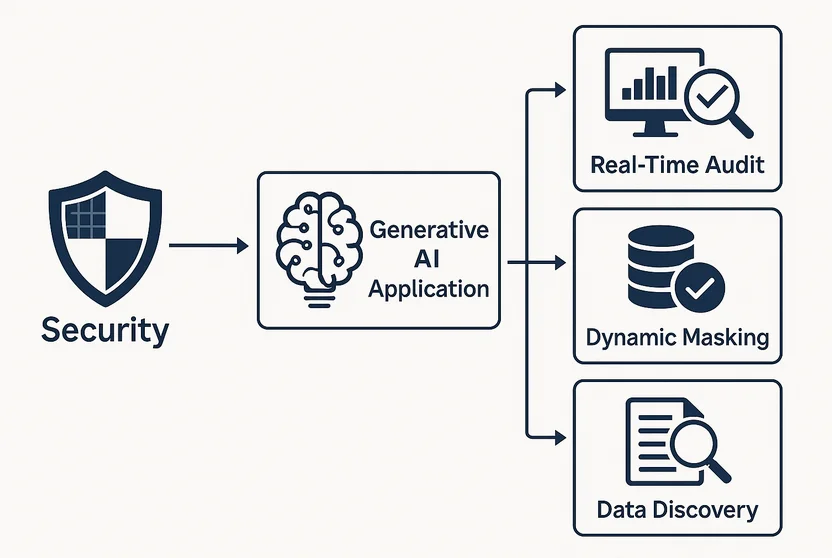

Implicaciones de seguridad de las aplicaciones de IA generativa

Las aplicaciones de IA generativa (GenAI) pueden crear contenido asombrosamente similar al humano en textos, imágenes e incluso código. Pero detrás de la magia se oculta una serie de nuevos riesgos de seguridad que a menudo pasan desapercibidos hasta que son explotados. Desde la exposición de datos sensibles hasta convertirse en un vector para la inyección de indicaciones, GenAI conlleva tanto promesas como peligros.

Donde la innovación se encuentra con la exposición

A diferencia del software tradicional, los modelos de GenAI no funcionan con una lógica fija. Generan contenido basado en patrones probabilísticos extraídos de vastos conjuntos de datos, que pueden incluir información sensible o datos propietarios. Cuando se integran en los flujos de trabajo empresariales, estos modelos pueden acceder a registros de clientes, datos financieros o comunicaciones internas.

Por ejemplo, un chatbot basado en LLM entrenado con correos electrónicos de empleados podría revelar inadvertidamente discusiones internas de recursos humanos en sus respuestas. Sin un control adecuado de acceso y visibilidad en la auditoría, estos errores pueden pasar desapercibidos.

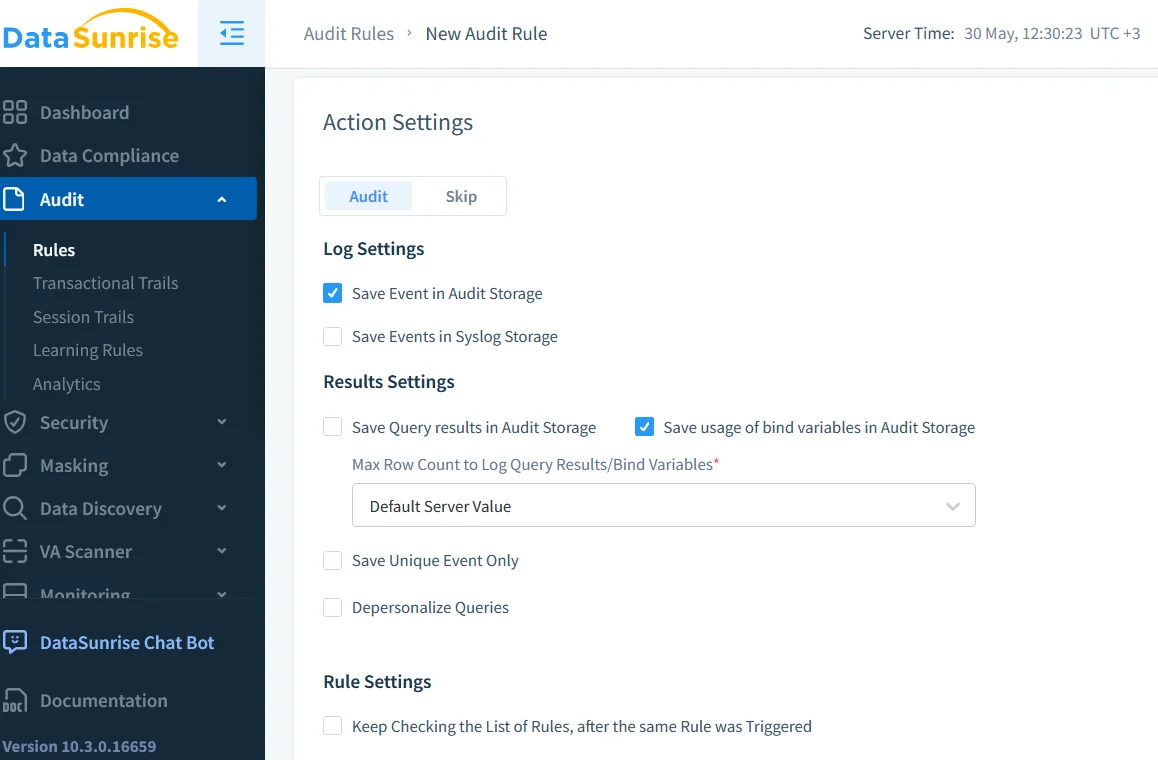

Por qué la auditoría en tiempo real es innegociable

Las capacidades de auditoría en tiempo real son esenciales al implementar GenAI en entornos regulados. Al capturar cada consulta, respuesta y acceso al sistema, las organizaciones pueden rastrear cómo el modelo interactúa con información sensible.

Herramientas como Monitoreo de actividad en la base de datos proporcionan una visión detallada de las operaciones de la base de datos desencadenadas por los modelos de GenAI. Esta pista de auditoría se puede utilizar para:

- Detectar intentos de acceso no autorizados

- Correlacionar la actividad del LLM con las acciones del usuario

- Identificar patrones de consulta anormales a lo largo del tiempo

Se pueden encontrar más ideas sobre el registro seguro del uso de la IA en las recomendaciones de Google.

-- Ejemplo: marcar consultas excesivas a la tabla user_profiles

SELECT user, COUNT(*) as query_count

FROM audit_log

WHERE object_name = 'user_profiles' AND timestamp > NOW() - INTERVAL '1 HOUR'

GROUP BY user

HAVING COUNT(*) > 100;

Esta consulta ayuda a identificar si un modelo o usuario está extrayendo demasiados datos demasiado rápido.

Enmascaramiento dinámico y salidas de la IA

Incluso si GenAI actúa dentro de los límites de acceso, podría revelar datos de manera no intencionada. Ahí es donde entra en juego el enmascaramiento dinámico de datos. El enmascaramiento modifica la salida en tiempo real sin alterar los datos subyacentes.

Considera un LLM de soporte al cliente que accede a historiales de pedidos. Con el enmascaramiento dinámico, los campos de tarjetas de crédito o correos electrónicos personales pueden ser ocultados antes de generar respuestas, asegurando que la información sensible nunca salga del sistema interno, ni siquiera por accidente.

El enfoque de Microsoft para el enmascaramiento de datos en bases de datos SQL ofrece otro modelo para comprender esta técnica.

El problema del descubrimiento: ¿Qué se está exponiendo?

Antes de poder asegurar los datos, es necesario saber qué existe. El descubrimiento de datos es vital para las organizaciones que implementan herramientas de GenAI. Estas herramientas rastrean a través de tablas, documentos y registros para identificar PII, PHI y otro contenido regulado.

La Guía NIST para la protección de información sensible explica por qué la identificación de datos es fundamental para la reducción de riesgos.

Los escaneos de descubrimiento deben programarse regularmente, especialmente cuando los modelos de GenAI se vuelven a entrenar o se integran con nuevas fuentes de datos. De lo contrario, corres el riesgo de exponer datos heredados olvidados a interfaces modernas de IA.

Cumplimiento, ahora con indicaciones

Regulaciones como GDPR, HIPAA y PCI DSS todavía no mencionan explícitamente a GenAI, pero sí requieren controlar quién accede a los datos personales y cómo se utilizan.

Si un LLM genera texto a partir de un registro médico, es un evento de procesamiento de datos. Los registros de indicaciones, archivos de salida y controles de acceso entran en el escrutinio del cumplimiento. La aplicación de controles de acceso basados en roles y la implementación de políticas de retención claras son los primeros pasos para alinear GenAI con las expectativas de cumplimiento.

Para explorar los esfuerzos globales en gobernanza de la IA, consulta el Observatorio de Políticas de IA de la OCDE.

Analítica de comportamiento para el abuso de indicaciones

La IA no siempre rompe las reglas deliberadamente, pero los usuarios sí podrían hacerlo. Un actor malintencionado podría diseñar indicaciones para engañar al modelo y hacer que revele datos privados o ejecute acciones no autorizadas.

Al aprovechar el análisis del comportamiento del usuario, las empresas pueden marcar patrones sospechosos en las indicaciones, como el uso repetido de términos como “omitir”, “solo uso interno” o “contraseña de administrador”.

Se dispone de más investigación sobre ataques a indicaciones de LLM en la propia taxonomía de amenazas de OpenAI.

Estudio de caso: LLM integrado en el sistema de tickets

Un proveedor de SaaS integró un LLM en su sistema de soporte interno para generar respuestas a tickets. Inicialmente, la productividad se disparó. Pero con el tiempo, el equipo de seguridad observó registros de auditoría anómalos:

- Consultas que aumentan durante horas de bajo tráfico

- Grandes exportaciones en JSON de datos de usuarios de tablas antiguas

- Uso consistente de campos administrativos en las indicaciones

Una investigación adicional mostró que el LLM había aprendido a optimizar sus respuestas consultando estructuras de datos archivadas más allá del alcance previsto.

El equipo implementó el enmascaramiento dinámico para campos heredados, añadió filtros de auditoría más estrictos y reconfiguró los controles de acceso para aislar las consultas de IA.

Haciendo que GenAI sea seguro por diseño

La seguridad para GenAI no puede ser una ocurrencia tardía. Debe estar incorporada en la arquitectura:

| Control de Seguridad | Información de implementación |

|---|---|

| Auditar todo | Utiliza herramientas de registro en tiempo real para capturar todas las interacciones de GenAI. |

| Descubrir datos sensibles | Realiza escaneos de descubrimiento regulares para detectar contenido regulado en las fuentes de datos. |

| Enmascaramiento dinámico | Enmascara las salidas en tiempo real para evitar fugas de datos sensibles en respuestas generadas por IA. |

| Control de Acceso Basado en Roles Contextual | Aplica controles de acceso basados en roles que se adapten al contexto del usuario y al tipo de consulta. |

| Análisis del comportamiento de las indicaciones | Aprovecha las herramientas analíticas para identificar patrones sospechosos o uso indebido de GenAI. |

Estos controles ayudan a alinear el uso de la IA tanto con la política interna como con las regulaciones externas.

Recursos adicionales

- Comprender las amenazas a las bases de datos

- Protección de datos para el cumplimiento

- Herramientas de LLM y ML para la seguridad de bases de datos

- Enfoque de seguridad basado en datos

- Investigación de IBM sobre IA responsable

- Centro de Investigación de Stanford sobre Modelos Fundamentales

La conclusión

Las implicaciones de seguridad de las aplicaciones de IA generativa no son hipotéticas, son inmediatas. Desde la auditoría en tiempo real hasta el enmascaramiento y el análisis del comportamiento, GenAI debe implementarse de manera responsable. Las empresas que combinen métodos tradicionales de protección de datos con controles conscientes de la IA estarán mejor posicionadas para innovar sin compromisos.