Riesgos y Mitigaciones de OWASP LLM

El creciente interés en los modelos de lenguaje a gran escala (LLMs) ha revolucionado la forma en que las organizaciones interactúan con los datos, automatizan decisiones y extraen conocimientos. Sin embargo, con esta capacidad transformadora surge un nuevo conjunto de riesgos de seguridad y cumplimiento. El Top 10 de OWASP para Aplicaciones LLM resalta estas vulnerabilidades y ofrece estrategias de mitigación cruciales para cualquier organización que utiliza inteligencia artificial generativa.

Este artículo explora esos riesgos con un enfoque práctico en la auditoría en tiempo real, enmascaramiento dinámico, descubrimiento de datos y cómo mantener el cumplimiento de datos en entornos impulsados por GenAI.

Entendiendo el Panorama: Categorías de Riesgo de LLM

OWASP categoriza los riesgos específicos de LLM en áreas como la inyección de prompts, la filtración de datos, el uso indebido del modelo, plugins inseguros y el envenenamiento de los datos de entrenamiento. Estas amenazas explotan las mismas fortalezas de la GenAI: su adaptabilidad y aprendizaje contextual. Pueden engañar al modelo para que evada las barreras internas y filtre salidas sensibles.

Auditoría en Tiempo Real: Vigila Todo, Responde al Instante

La mitigación de riesgos en entornos dinámicos de LLM comienza con la visibilidad. Las capacidades de auditoría en tiempo real permiten a las organizaciones monitorear consultas, respuestas y patrones de acceso a datos mientras ocurren. Herramientas como DataSunrise Audit Logs pueden señalar inmediatamente intentos de acceso no autorizado a datos o patrones sospechosos de prompts.

Por ejemplo, una regla de seguridad podría detectar intentos repetidos de enumerar campos sensibles del esquema y activar alertas a través de Slack o MS Teams:

{

"event_type": "query_attempt",

"query": "SELECT * FROM information_schema.columns WHERE ...",

"action": "alert_and_block"

}

Con soporte para notificaciones en tiempo real y reglas de auditoría basadas en aprendizaje, los equipos pueden adaptar la lógica de auditoría a las amenazas de LLM en evolución.

Enmascaramiento Dinámico: No Solo Bloquees, Sino que Ocultes

El enmascaramiento dinámico de datos protege la información personal identificable (PII) y campos sensibles durante las interacciones con LLM sin afectar la funcionalidad de la aplicación. En lugar de eliminar por completo el acceso, sustituye los valores reales por marcadores enmascarados.

Por ejemplo, la respuesta a una consulta vectorial:

SELECT name, credit_card_number FROM customers LIMIT 1;

podría devolver:

John Doe | XXXX-XXXX-XXXX-1234

Esta capacidad es vital para casos de uso que involucran la ampliación de prompts o RAG (Generación Aumentada por Recuperación), donde el LLM debe obtener y sintetizar datos empresariales sin violar las normas de privacidad. El enmascaramiento dinámico en DataSunrise permite políticas ajustadas por rol o comportamiento del modelo.

Descubrimiento de Datos: Conoce lo que Tienes Antes de que lo Hagan los LLM

Antes de implementar medidas de seguridad para LLM, es esencial comprender dónde residen los datos sensibles. Ahí es donde entran en juego las herramientas automatizadas de descubrimiento de datos.

Mapear activos de datos a través de fuentes no estructuradas, bases de datos relacionales e índices vectoriales puede ayudar a priorizar controles y reducir la exposición. La integración con los flujos de trabajo de LLM garantiza que solo los datos cumplidores y clasificados sean elegibles para la ampliación o inferencia.

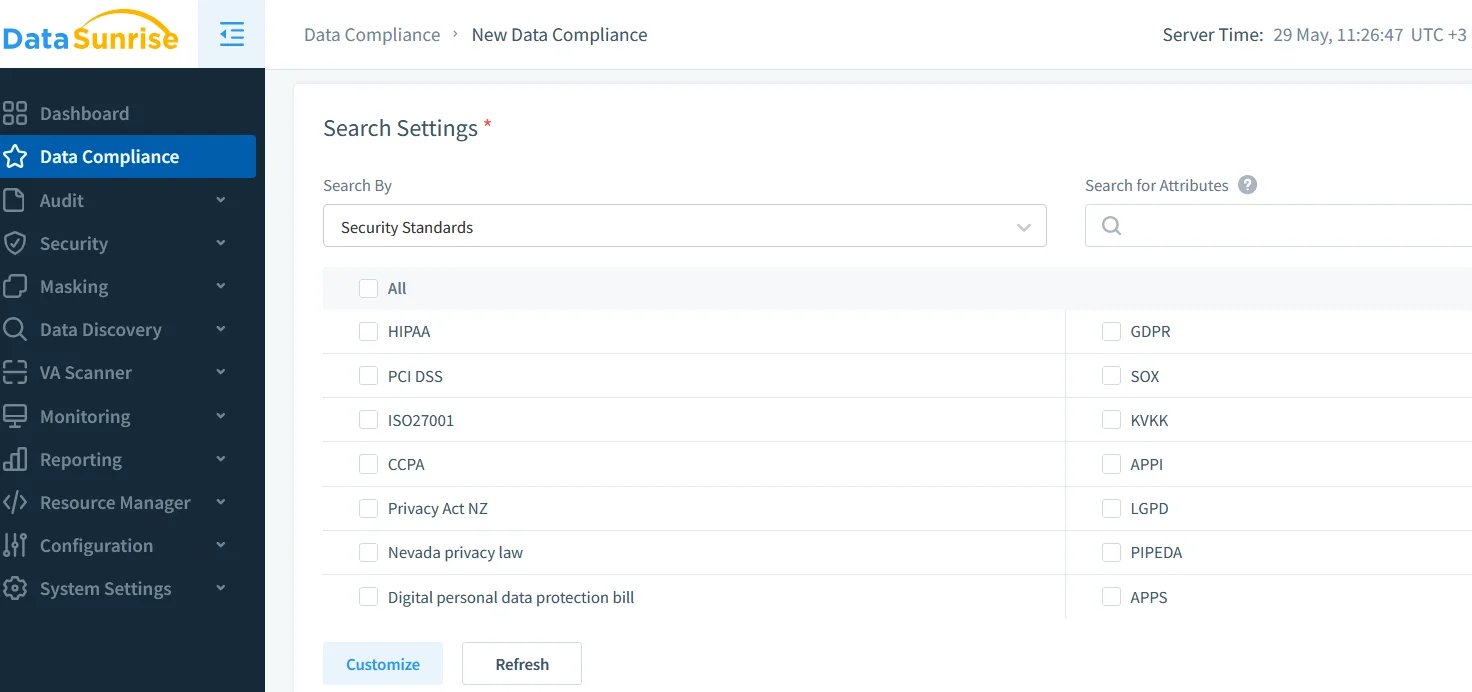

Cumplimiento de Datos: Alineando el Uso de LLM con Normas Globales

El GDPR, HIPAA, PCI DSS y otras regulaciones se aplican independientemente de si los datos son procesados por humanos o máquinas. Por lo tanto, integrar LLM en los flujos de datos exige trazabilidad, control de acceso y registros de auditoría claros.

Soluciones como el DataSunrise Compliance Manager ofrecen un panel centralizado para gestionar artefactos de cumplimiento, políticas de enmascaramiento y resultados de auditorías. Esto ayuda a las organizaciones a pasar auditorías y demostrar un uso responsable de LLM.

Además, el soporte para GDPR y HIPAA está integrado en las capas de auditoría y enmascaramiento, garantizando que las salidas de LLM nunca filtren información de salud o personal protegida.

Interfaces de Prompts Seguras y Controles Basados en Roles

Aplicar el control de acceso basado en roles (RBAC) garantiza que los prompts de diferentes tipos de usuarios (administrador, analista, API externa) se rijan por políticas distintas. Combinado con técnicas de seguridad inspiradas en los datos, esto ayuda a alinear el uso de LLM con estándares de grado empresarial.

Los sistemas de plugins seguros, los entornos de ejecución aislados y las reglas de seguridad contra inyección SQL también juegan un papel vital en la protección contra exploits comunes de LLM.

Conclusión: Un Futuro Equilibrado, Auditado y Enmascarado para GenAI

La integración de la GenAI en entornos empresariales es inevitable, pero debe hacerse de manera responsable. Al adoptar el marco de riesgos de LLM de OWASP, reforzar la auditoría en tiempo real, aplicar enmascaramiento dinámico, habilitar un descubrimiento de datos integral y adherirse a las normas de cumplimiento, las organizaciones pueden desbloquear de manera segura el potencial completo de la inteligencia artificial generativa.

Para saber más acerca de la construcción de sistemas seguros de GenAI con auditoría y enmascaramiento, explora nuestros recursos sobre Monitoreo de la Actividad de la Base de Datos y Seguridad de Datos.