Perspectivas de seguridad en aplicaciones de ML

A medida que el aprendizaje automático transforma las operaciones empresariales, la mayoría de las organizaciones están desplegando aplicaciones de ML en procesos empresariales críticos. Aunque el ML ofrece capacidades transformadoras, introduce desafíos de seguridad sofisticados que los marcos de protección tradicionales no pueden abordar adecuadamente.

Esta guía examina las perspectivas de seguridad en aplicaciones de ML, explorando estrategias de implementación que permiten a las organizaciones construir infraestructuras de ML seguras y resilientes, manteniendo la excelencia operativa.

La plataforma de seguridad de ML de vanguardia de DataSunrise ofrece Orquestación de Seguridad sin Intervención con Protección Autónoma de ML en todas las principales plataformas de aprendizaje automático. Nuestra Protección Consciente del Contexto se integra de manera perfecta con los controles técnicos, proporcionando una gestión de seguridad de precisión quirúrgica para la protección integral de aplicaciones de ML con Cumplimiento de IA por Defecto.

Comprendiendo los fundamentos de la seguridad en aplicaciones de ML

Las aplicaciones de aprendizaje automático operan mediante algoritmos complejos que procesan vastos conjuntos de datos, realizan predicciones de forma autónoma y se adaptan continuamente mediante mecanismos de aprendizaje. A diferencia de las aplicaciones tradicionales, los sistemas de ML crean superficies de ataque dinámicas donde el comportamiento del modelo, los datos de entrenamiento y los procesos de inferencia presentan vulnerabilidades de seguridad únicas que requieren enfoques de protección especializados.

La seguridad efectiva en ML abarca la protección de los canales de datos, la verificación de la integridad del modelo, el monitoreo de la inferencia y capacidades de auditoría integrales diseñadas específicamente para entornos de aprendizaje automático.

Vectores de amenazas críticas en la seguridad de ML

Las aplicaciones de ML enfrentan desafíos de seguridad únicos que requieren estrategias de protección especializadas:

- Envenenamiento de datos de entrenamiento: Inyección maliciosa de muestras corruptas en conjuntos de datos de entrenamiento para manipular el comportamiento del modelo y comprometer la integridad de los datos

- Ataques de extracción de modelos: Intentos basados en API de reconstruir modelos propietarios y robar propiedad intelectual mediante accesos no autorizados

- Inferencia adversaria: Entradas cuidadosamente elaboradas diseñadas para engañar a los sistemas de predicción y extraer información sensible

- Fuga de datos: Ataques de inversión de modelos e inferencia de membresía que exponen datos de entrenamiento a través de violaciones de datos que requieren protocolos de descubrimiento de datos

Marco de implementación de seguridad

La seguridad efectiva en ML requiere enfoques de validación práctica tanto para las fases de entrenamiento como de inferencia:

Validación de seguridad de datos de entrenamiento

La siguiente implementación demuestra cómo validar la integridad de los datos de entrenamiento y detectar anomalías estadísticas que podrían indicar intentos de envenenamiento. Este validador verifica los hashes de los datos con respecto a líneas base y monitorea propiedades estadísticas inusuales que puedan sugerir manipulaciones maliciosas.

import hashlib

import numpy as np

from datetime import datetime

class MLDataSecurityValidator:

def __init__(self):

self.anomaly_threshold = 2.0

self.integrity_baseline = {}

def validate_training_data(self, dataset, dataset_id):

"""Validación de seguridad integral para los datos de entrenamiento de ML"""

validation_result = {

'timestamp': datetime.utcnow().isoformat(),

'dataset_id': dataset_id,

'security_score': 100,

'threats_detected': [],

'recommendations': []

}

# Verificación de integridad de los datos

current_hash = hashlib.sha256(str(dataset).encode()).hexdigest()

baseline_hash = self.integrity_baseline.get(dataset_id)

if baseline_hash and current_hash != baseline_hash:

validation_result['threats_detected'].append({

'type': 'DATA_TAMPERING',

'severity': 'HIGH',

'description': 'Integridad del conjunto de datos comprometida'

})

validation_result['security_score'] -= 30

# Almacenar línea base para futuras comparaciones

if not baseline_hash:

self.integrity_baseline[dataset_id] = current_hash

return validation_result

Monitor de seguridad en la inferencia del modelo

Este monitor de seguridad demuestra la protección en tiempo real para puntos finales de inferencia de ML. Realiza el seguimiento de patrones de solicitud para detectar posibles intentos de extracción de modelos e identifica patrones de entrada sospechosos que podrían indicar ataques adversarios.

class MLInferenceSecurityMonitor:

def __init__(self, model_name):

self.model_name = model_name

self.request_history = []

self.rate_limit_threshold = 100 # solicitudes por minuto

def monitor_inference_request(self, user_id, input_data, prediction):

"""Monitoreo de seguridad en tiempo real para las solicitudes de inferencia de ML"""

security_assessment = {

'timestamp': datetime.utcnow().isoformat(),

'user_id': user_id,

'model_name': self.model_name,

'risk_level': 'LOW',

'security_flags': []

}

# Detección de límite de velocidad

recent_requests = len([r for r in self.request_history

if r['user_id'] == user_id and

(datetime.utcnow() - datetime.fromisoformat(r['timestamp'])).seconds < 60])

if recent_requests > self.rate_limit_threshold:

security_assessment['security_flags'].append({

'type': 'RATE_LIMIT_EXCEEDED',

'severity': 'HIGH',

'description': 'Posible intento de extracción de modelo'

})

security_assessment['risk_level'] = 'HIGH'

return security_assessment

Mejores prácticas de implementación

Para las organizaciones:

- Establecer la gobernanza de seguridad en ML: Crear equipos especializados en seguridad de ML con políticas de seguridad integrales y alineación con regulaciones de cumplimiento

- Desplegar monitoreo en tiempo real: Implementar monitoreo de actividad en bases de datos a lo largo de los canales de ML con análisis del comportamiento del usuario

- Mantener la documentación de seguridad: Crear registros de auditoría completos con una optimización adecuada del almacenamiento de auditorías

- Evaluaciones de seguridad periódicas: Realizar evaluaciones de vulnerabilidad periódicas y pruebas de seguridad

Para los equipos técnicos:

- Asegurar las cadenas de datos de ML: Implementar encriptación de bases de datos para los datos de entrenamiento utilizando protocolos de gestión de datos de prueba

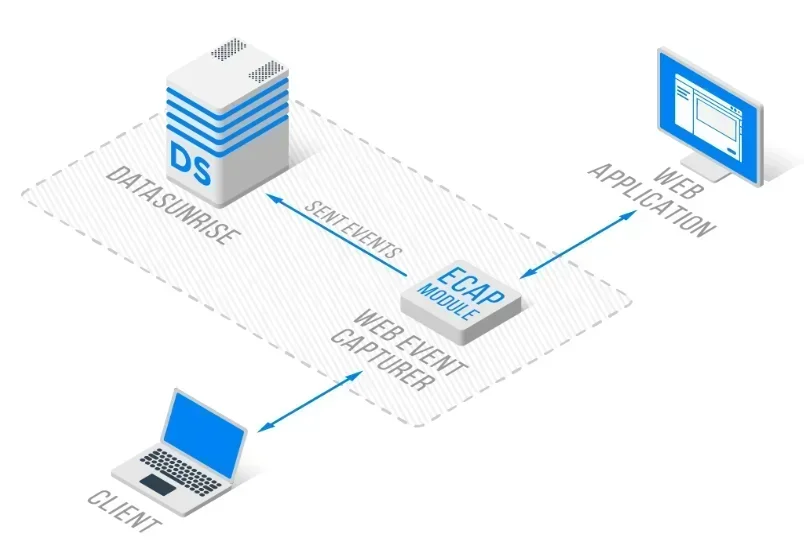

- Protección del modelo: Desplegar controles de acceso y protección de la propiedad intelectual utilizando una arquitectura de proxy inverso

- Detección en tiempo real: Configurar la detección automatizada de amenazas con capacidades de firewall de bases de datos

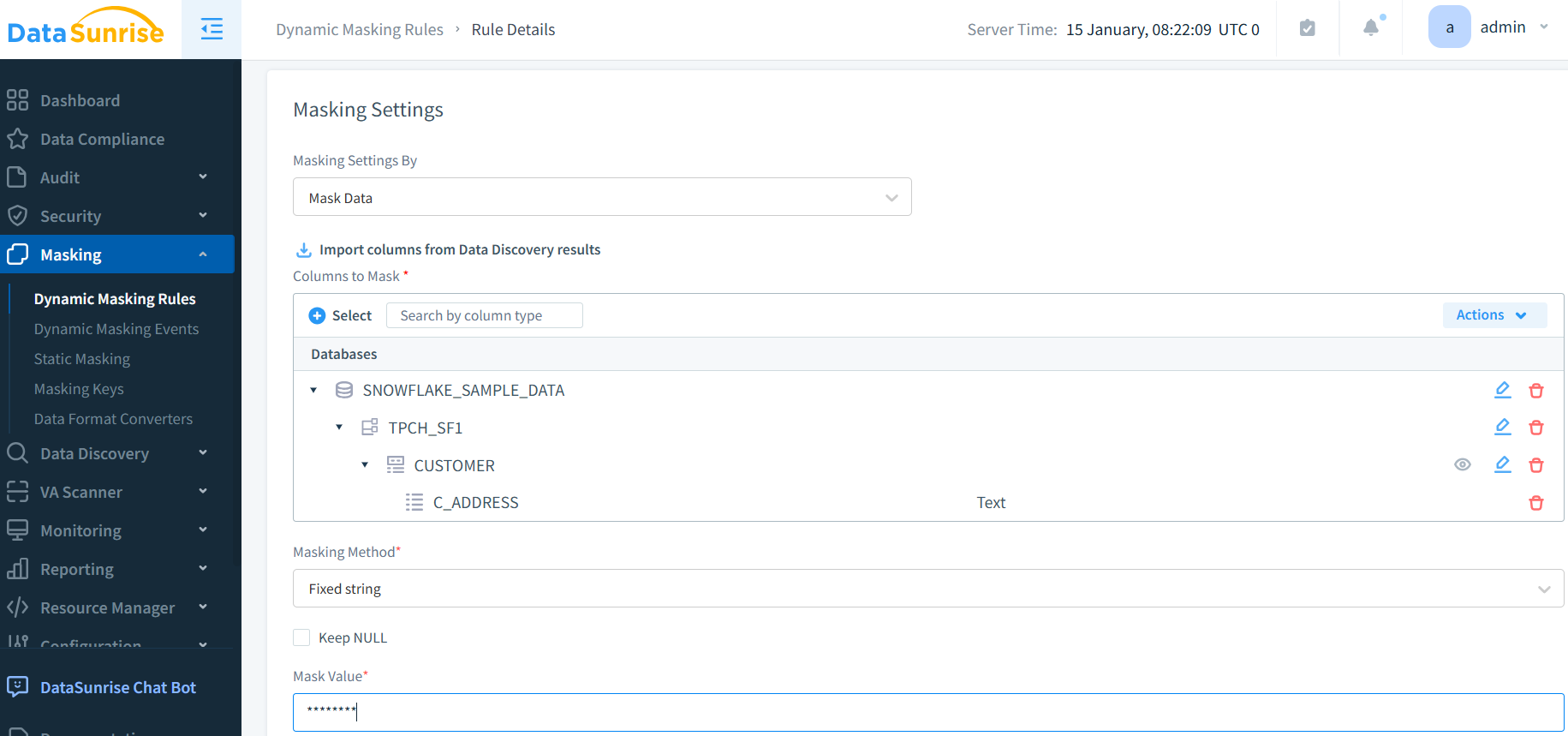

- Controles de privacidad: Implementar técnicas integrales de enmascaramiento de datos y generación de datos sintéticos

DataSunrise: Solución integral de seguridad en ML

DataSunrise proporciona soluciones de seguridad a nivel empresarial diseñadas específicamente para aplicaciones de ML. Nuestra plataforma ofrece Máxima Seguridad, Mínimo Riesgo con protección en tiempo real para ML en todas las principales plataformas de ML, incluyendo TensorFlow, PyTorch y servicios de ML basados en la nube.

Características clave:

- Monitoreo en tiempo real de la actividad en ML: Seguimiento completo con registros de auditoría para todas las interacciones de ML

- Detección avanzada de amenazas: Detección de comportamiento sospechoso impulsada por ML con Protección Consciente del Contexto

- Protección dinámica de datos: Enmascaramiento de datos de precisión quirúrgica para la protección de información personal (PII) en conjuntos de datos de entrenamiento

- Cobertura multiplataforma: Seguridad unificada a través de más de 50 plataformas compatibles

- Automatización del cumplimiento: Informes de cumplimiento automatizados para los principales marcos regulatorios a través de herramientas de reporte

Los modos de implementación flexibles de DataSunrise soportan entornos de ML locales, en la nube e híbridos con una implementación sin intervención. Las organizaciones logran una reducción significativa en incidentes de seguridad y una mayor protección del modelo mediante el monitoreo automatizado.

Conclusión: Construyendo bases seguras para ML

Las perspectivas de seguridad en aplicaciones de ML revelan la importancia crítica de contar con marcos de protección integrales que aborden las amenazas únicas del aprendizaje automático. Las organizaciones que implementan estrategias robustas de seguridad en ML se posicionan para aprovechar el potencial transformador del ML, manteniendo la confianza de los interesados y una resiliencia operativa.

A medida que las aplicaciones de ML se vuelven cada vez más centrales en las operaciones empresariales, la seguridad evoluciona de ser una mejora opcional a una capacidad esencial de negocio. Al implementar marcos de seguridad avanzados con monitoreo automatizado, las organizaciones pueden desplegar innovaciones en ML con confianza mientras protegen sus valiosos activos de datos.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora