Prevención de Pérdida de Datos para Pipelines de GenAI y LLM

La IA generativa (GenAI) y los modelos de lenguaje grande (LLMs) han transformado la innovación basada en datos, pero su dependencia de conjuntos de datos inmensos y el acceso impulsado por solicitudes crea un punto ciego peligroso: la fuga incontrolada de datos. Desde el entrenamiento con registros sensibles hasta la generación de salidas que exponen, de manera inadvertida, información propietaria o personal, el riesgo ya no es teórico. Prevenir la pérdida de datos a lo largo de estos pipelines es esencial.

Este artículo explora métodos prácticos de Prevención de Pérdida de Datos para Pipelines de GenAI y LLM, centrándose en la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento de datos y la aplicación de controles de seguridad. Estas técnicas proporcionan controles accionables que ayudan a las organizaciones a mantenerse en cumplimiento y seguras sin comprometer la innovación.

Por qué las herramientas tradicionales de DLP no son suficientes

La mayoría de los sistemas convencionales de prevención de pérdida de datos operan a nivel de archivo. Monitorizan correos electrónicos salientes, transferencias de datos o actividades del portapapeles y se basan en coincidencias de patrones predefinidos. Estos métodos tienen dificultades en contextos de GenAI donde los datos fluyen a través de modelos en lugar de archivos. Los pipelines de LLM acceden a fuentes en tiempo real como bases de datos y APIs, combinan datos sensibles y públicos, y almacenan contenido potencialmente regulado durante el entrenamiento.

Por ejemplo, una solicitud como “Resume la revisión interna de desempeño del último trimestre” puede desencadenar una fuga de datos si el modelo tiene acceso a la memoria o registra consultas previas. Esto significa que los controles de DLP deben estar integrados en la interfaz entre los datos y el modelo. Como destaca el NIST AI Risk Management Framework, los sistemas de IA requieren salvaguardas a medida que evolucionan junto con los modelos que soportan.

Descubriendo los datos antes de protegerlos

Antes de implementar cualquier medida preventiva, las organizaciones deben entender qué datos tienen, dónde se encuentran y quién los accede. Esto comienza con el descubrimiento automatizado de datos que escanea el almacenamiento estructurado y no estructurado en busca de elementos sensibles tales como datos de identificación personal (PII), información de salud (PHI) y propiedad intelectual.

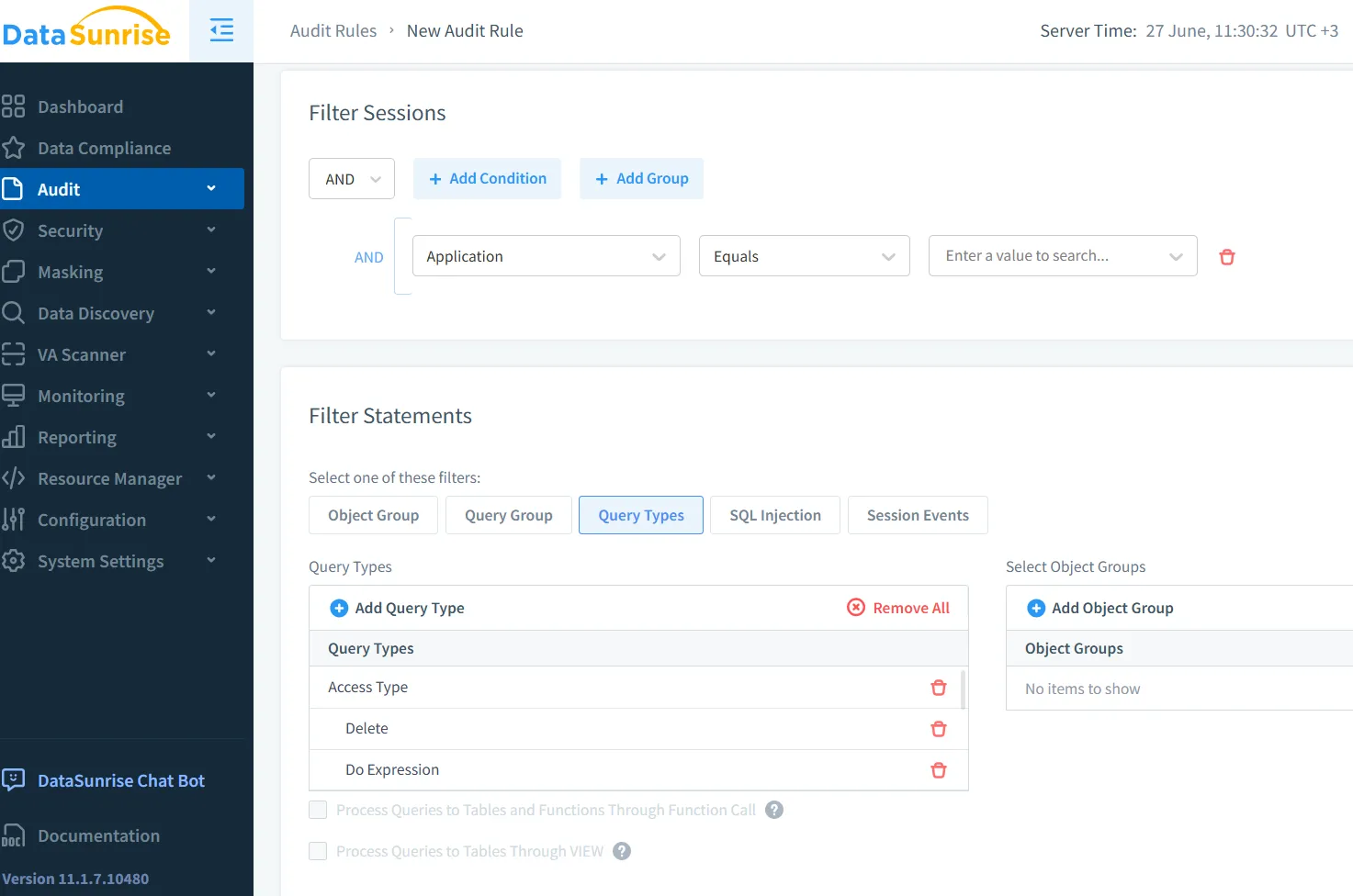

Las herramientas de descubrimiento de DataSunrise escanean de manera continua en busca de campos sensibles, los asocian con los requisitos de cumplimiento relevantes y mantienen actualizada la clasificación. Esta visibilidad proactiva es esencial antes de aplicar políticas de auditoría o enmascaramiento.

Investigaciones emergentes de Google DeepMind muestran cómo incluso los datos de entrenamiento anonimizados pueden ser re-identificados por los LLMs, haciendo del descubrimiento temprano un requisito innegociable.

Auditoría en tiempo real y trazabilidad

Una vez establecida la visibilidad, la auditoría en tiempo real se convierte en la columna vertebral del despliegue seguro de GenAI. Cada solicitud al LLM, cada consulta a la base de datos y toda actividad de inferencia debe registrarse. Rastrear la identidad del solicitante, los datos a los que se accede y el resultado permite una seguridad proactiva.

Tome este seguimiento SQL como ejemplo:

SELECT customer_ssn, diagnosis FROM patient_records WHERE status = 'active';

Si es emitida por una cuenta del sistema GenAI que carece de acceso a PHI, un motor de auditoría como DataSunrise puede bloquear o marcar la consulta, emitiendo alertas en tiempo real a los analistas de seguridad. Los registros de auditoría aseguran que incluso las interacciones transitorias sean contabilizadas.

Además, plataformas como Microsoft Purview proporcionan registros de auditoría integrados con análisis basados en roles, ofreciendo visibilidad sobre las interacciones de datos a nivel de usuario dentro de los pipelines de IA.

Enmascaramiento de datos para salidas seguras en IA

El enmascaramiento estático funciona para entornos de prueba, pero no es suficiente para LLMs que operan con datos en vivo. Los pipelines de GenAI requieren un enmascaramiento dinámico de datos, el cual intercepta las respuestas en función de la identidad del usuario y la política.

Considere la solicitud:

“Enumere los clientes VIP en California junto con sus correos electrónicos.”

El enmascaramiento dinámico asegura que salidas como:

Name: [REDACTED] | Email: [MASKED]@domain.com

se muestren a usuarios no privilegiados. Esta técnica, soportada por DataSunrise Dynamic Masking, permite una interacción segura sin comprometer la integridad o disponibilidad de la base de datos.

Modelos de código abierto como PySyft de OpenMined también están comenzando a soportar pipelines de inferencia que preservan la privacidad, demostrando el creciente enfoque de la comunidad en este tema.

Aplicando reglas de seguridad a las interfaces de solicitud

Las interfaces de GenAI a menudo incluyen APIs, bots de Slack, dashboards o asistentes internos. Estas interfaces son vulnerables a entradas no monitoreadas. Aplicar reglas de seguridad directamente en la capa de consulta puede prevenir explotaciones.

Estrategias útiles incluyen bloquear solicitudes que contengan palabras clave como SSN, contraseña o datos financieros, y limitar la frecuencia de acceso. El control de acceso basado en roles asegura que solo los usuarios autorizados puedan interactuar con solicitudes sensibles. Estos controles se pueden hacer cumplir a través de políticas de seguridad integradas con auditoría y enmascaramiento.

Además, la IA Constitucional de Anthropic propone incorporar principios de seguridad directamente en el razonamiento del modelo, complementando las reglas de seguridad basadas en perímetros.

Cumplimiento en los pipelines de GenAI

Marcos de cumplimiento como el GDPR, HIPAA y PCI-DSS exigen un manejo estricto de datos personales y financieros. Los LLMs sin mecanismos de aplicación integrados pueden violar fácilmente estos estándares.

Para mantenerse en cumplimiento:

- Mantener registros de auditoría completos para toda la actividad de GenAI.

- Enmascarar de forma dinámica los datos personales en las salidas de entrenamiento e inferencia.

- Aprovechar un gestor de cumplimiento para automatizar la aplicación de políticas y la generación de informes.

La orientación de la Junta Europea de Protección de Datos sobre IA refuerza la necesidad de salvaguardas demostrables y transparencia en todos los sistemas generativos.

Hacia un GenAI transparente y seguro

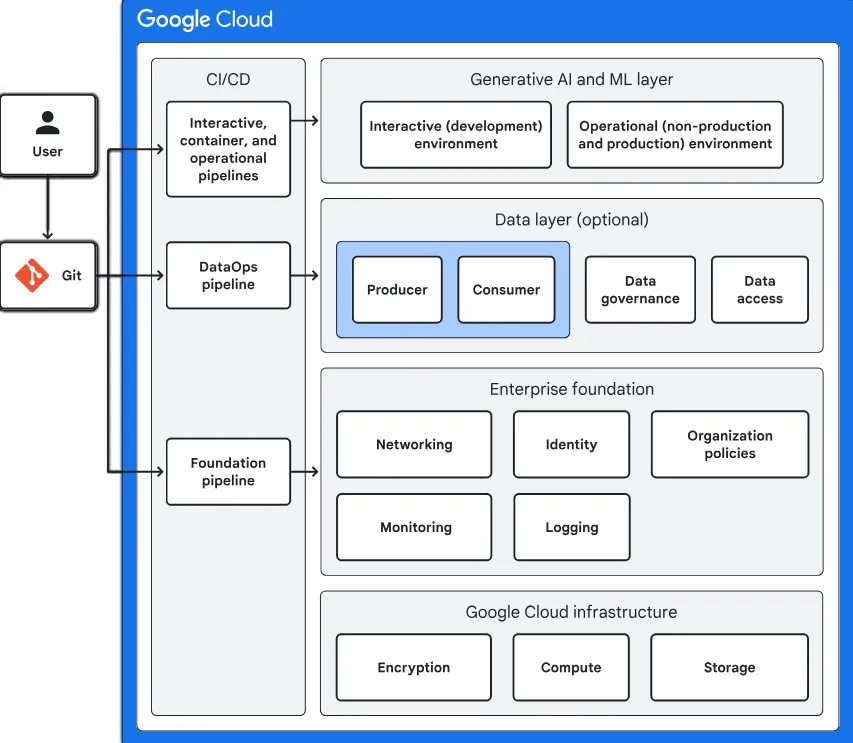

Asegurar los pipelines de GenAI requiere más que parchear vulnerabilidades después de que ocurren. Exige un enfoque consciente del contexto, donde la clasificación de datos, la auditoría, el enmascaramiento y la aplicación de políticas sean inherentes al pipeline.

Con herramientas como DataSunrise, las organizaciones pueden construir aplicaciones de LLM seguras, en cumplimiento y transparentes. Aplicar la Prevención de Pérdida de Datos para Pipelines de GenAI y LLM no es solo un requisito regulatorio — es una ventaja competitiva que protege tanto la innovación como la reputación.

A medida que la gobernanza de IA se vuelve central tanto para el riesgo como para la oportunidad, adoptar DLP en tiempo real y consciente del contexto en los flujos de trabajo de GenAI ya no es opcional — es fundamental.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora