Empresas Líderes en Seguridad de LLM

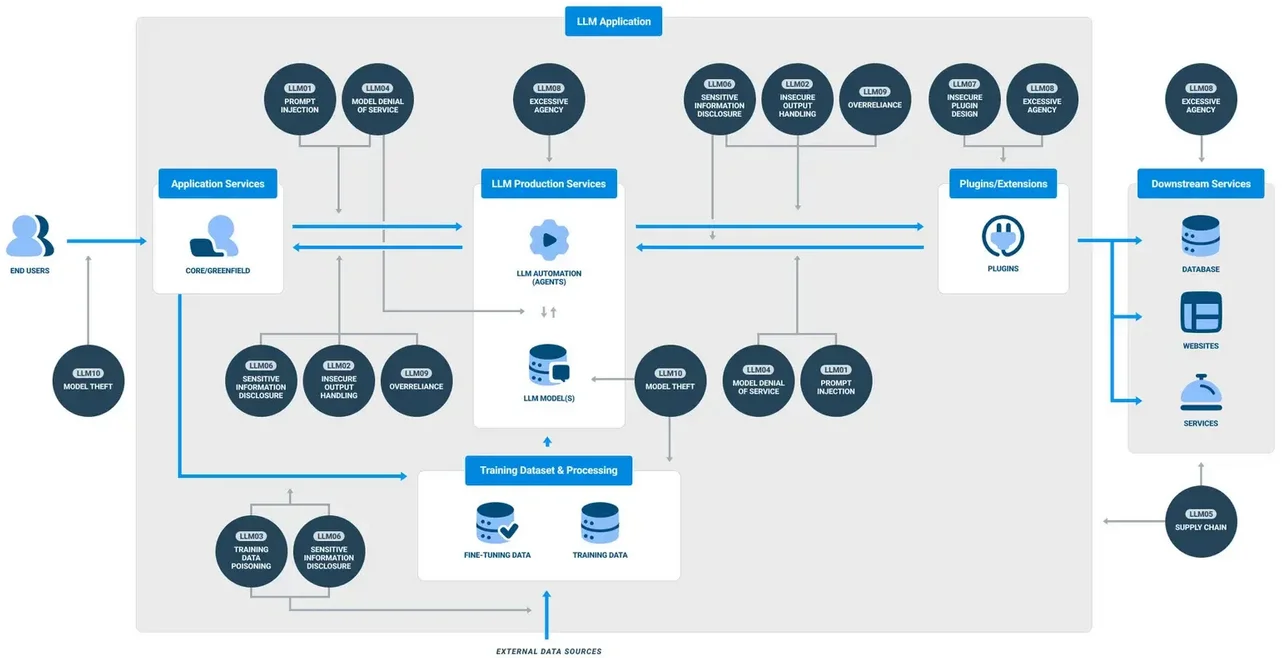

Al volverse críticos los sistemas de IA generativa (GenAI) en los flujos de trabajo empresariales, crece la necesidad de una seguridad robusta y en tiempo real. Estos grandes modelos de lenguaje (LLMs) procesan vastas cantidades de información sensible, desde registros de clientes hasta algoritmos propietarios. Con amenazas que varían desde la inyección de prompts hasta la fuga de datos, las organizaciones recurren a plataformas avanzadas especializadas en la observabilidad, auditoría, enmascaramiento y cumplimiento de LLM. En este panorama, varios proveedores destacan. Este artículo explora a las Empresas Líderes en Seguridad de LLM y cómo potencian una adopción segura de GenAI a través de capacidades fundamentales como la auditoría en tiempo real, el enmascaramiento dinámico y la aplicación automatizada de cumplimiento.

Protegiendo GenAI: Los Fundamentos Técnicos

La seguridad para los LLM va más allá de cifrar el almacenamiento o habilitar un registro básico. Una línea de producción segura para GenAI exige una visibilidad total, desde la entrada del prompt hasta la respuesta final del LLM, junto con la aplicación de políticas en línea y la clasificación de datos. Esto incluye:

- Auditoría en tiempo real de las interacciones de los usuarios y las decisiones del LLM

- Enmascaramiento dinámico de PII/PHI durante la inferencia

- Descubrimiento y clasificación de datos antes de la ingestión en el modelo

- Políticas de acceso que evolucionan con los patrones de uso

- Flujos de trabajo de cumplimiento mapeados a estándares como GDPR o HIPAA

Según MIT Sloan, una práctica recomendada clave es tratar los LLM tanto como superficies de riesgo y puntos finales inteligentes.

Veamos cómo los principales proveedores de seguridad en este ámbito satisfacen estas necesidades.

DataSunrise: Políticas Granulares para LLM y Flujos de Trabajo de Base de Datos

Originalmente centrado en la seguridad de bases de datos, DataSunrise ha ampliado sus capacidades para soportar la seguridad en GenAI. Su motor de auditoría en tiempo real permite a las organizaciones rastrear consultas LLM emitidas mediante SQL embebido o APIs conectadas a prompts. El enmascaramiento se aplica de forma dinámica según el rol del usuario y el contexto de la regla, utilizando reglas flexibles de enmascaramiento dinámico. Estas políticas se adaptan en función del análisis de comportamiento y el contexto de acceso.

El descubrimiento de datos también es una fortaleza clave. La plataforma escanea automáticamente los almacenes de datos estructurados y semiestructurados para identificar campos sensibles o PII antes de que alcancen las etapas de entrenamiento o inferencia del modelo. Combinado con políticas de seguridad y técnicas de optimización de almacenamiento de auditorías, DataSunrise garantiza que los despliegues de GenAI se mantengan verificables, enmascarados y conformes en entornos de producción.

-- Ejemplo: Aplicar enmascaramiento dinámico en una columna accedida por un LLM

CREATE MASKING RULE mask_llm_sensitive_data

ON schema.customer_data (ssn, email)

WHEN ROLE IN ('llm_user', 'analyst')

USING 'XXXX-XX-####', '***@example.com';

Securiti.ai: Inteligencia de Datos Autónoma para GenAI

Securiti ofrece una plataforma en la nube de control de datos impulsada por IA que automatiza el descubrimiento, la clasificación y la gobernanza del acceso en entornos híbridos. Sus soluciones se utilizan cada vez más en flujos de trabajo de GenAI, donde los desarrolladores afinan modelos con datos empresariales o integran LLM en flujos de trabajo analíticos.

Alertas de cumplimiento en tiempo real, enmascaramiento respaldado por clasificación y políticas de acceso gobernadas por IA son puntos clave. La integración de Securiti con herramientas nativas de la nube como Snowflake, Azure SQL y Cosmos DB asegura la aplicación sin fisuras de obligaciones como GDPR y HIPAA desde la inferencia hasta el almacenamiento.

La plataforma fue reconocida recientemente en el Forrester Wave para Software de Gestión de Privacidad por su liderazgo en la aplicación automatizada de políticas.

Duality Technologies: Colaboración GenAI que Preserva la Privacidad

Duality se centra en la colaboración segura de datos y el entrenamiento de IA mediante cifrado homomórfico y computación multipartita segura. Aunque no es una herramienta de protección completa para LLM, Duality habilita casos de uso en los que GenAI se entrena con conjuntos de datos conjuntos sin exponer la información sin procesar. Esto es crucial para sectores como servicios financieros o salud, donde el cumplimiento con PCI-DSS o las leyes de localización de datos es estricto.

IDC informa que el aprendizaje federado y la computación que preserva la privacidad están ganando tracción en las iniciativas de gobernanza de IA, siendo Duality uno de los principales proveedores.

HiddenLayer: Detección de Amenazas Específicas para ML

HiddenLayer ofrece una plataforma de seguridad adaptada a sistemas de aprendizaje automático. Para organizaciones que implementan LLM, proporciona protección contra prompts adversos, extracción de modelos y ataques de evasión. La capa de monitoreo en tiempo de ejecución de la plataforma puede detectar anomalías en las salidas de GenAI o en los comportamientos de acceso y activar defensas automatizadas.

Aunque HiddenLayer no realiza nativamente el descubrimiento o enmascaramiento de datos, su enfoque especializado en la seguridad de los modelos de IA durante y después del entrenamiento lo convierte en un candidato sólido para entornos de alto riesgo. Su motor de detección se alinea con el Marco de Gestión de Riesgos de IA del NIST, mejorando las prácticas de aseguramiento del modelo.

Protegiendo el Futuro: Mejores Prácticas Más Allá de las Herramientas

Elegir la plataforma adecuada es fundamental, pero asegurar GenAI también requiere prácticas operativas bien definidas. Algunos puntos a destacar:

- Siempre escanee y clasifique los datos de entrada antes del entrenamiento

- Habilite auditorías en cada invocación de prompt

- Utilice seguridad inspirada en datos para definir un enmascaramiento adaptable

- Alinee los registros de LLM con las políticas de cumplimiento y los plazos de retención

Una lectura adicional de Google DeepMind destaca por qué el ajuste fino, las salvaguardas y los bucles de auditoría continuos son esenciales para la seguridad de los LLM en dominios de alto riesgo.

Los equipos de seguridad deben tratar a los LLM como consumidores y generadores dinámicos de datos, lo que requiere no solo defensas perimetrales sino también una profunda observabilidad y una aplicación detallada de políticas de acceso.

Conclusión

A medida que la adopción de los LLM se acelera, las empresas deben adaptar su pila de seguridad a los nuevos riesgos y presiones regulatorias. Las Empresas Líderes en Seguridad de LLM presentadas aquí—DataSunrise, Securiti.ai, Duality y HiddenLayer—ofrecen diferentes fortalezas. Ya sea mediante auditorías, enmascaramiento, colaboración cifrada o detección de amenazas, cada una proporciona salvaguardias esenciales adaptadas a las cargas de trabajo de GenAI. Un enfoque por capas que combine estas capacidades es la forma más efectiva de asegurar la inteligencia artificial generativa en entornos empresariales.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora