Amenazas de IA y Riesgos de Seguridad

La inteligencia artificial se ha convertido en un pilar central de la tecnología empresarial moderna — optimizando decisiones, detectando fraudes y permitiendo análisis en tiempo real en diversas industrias.

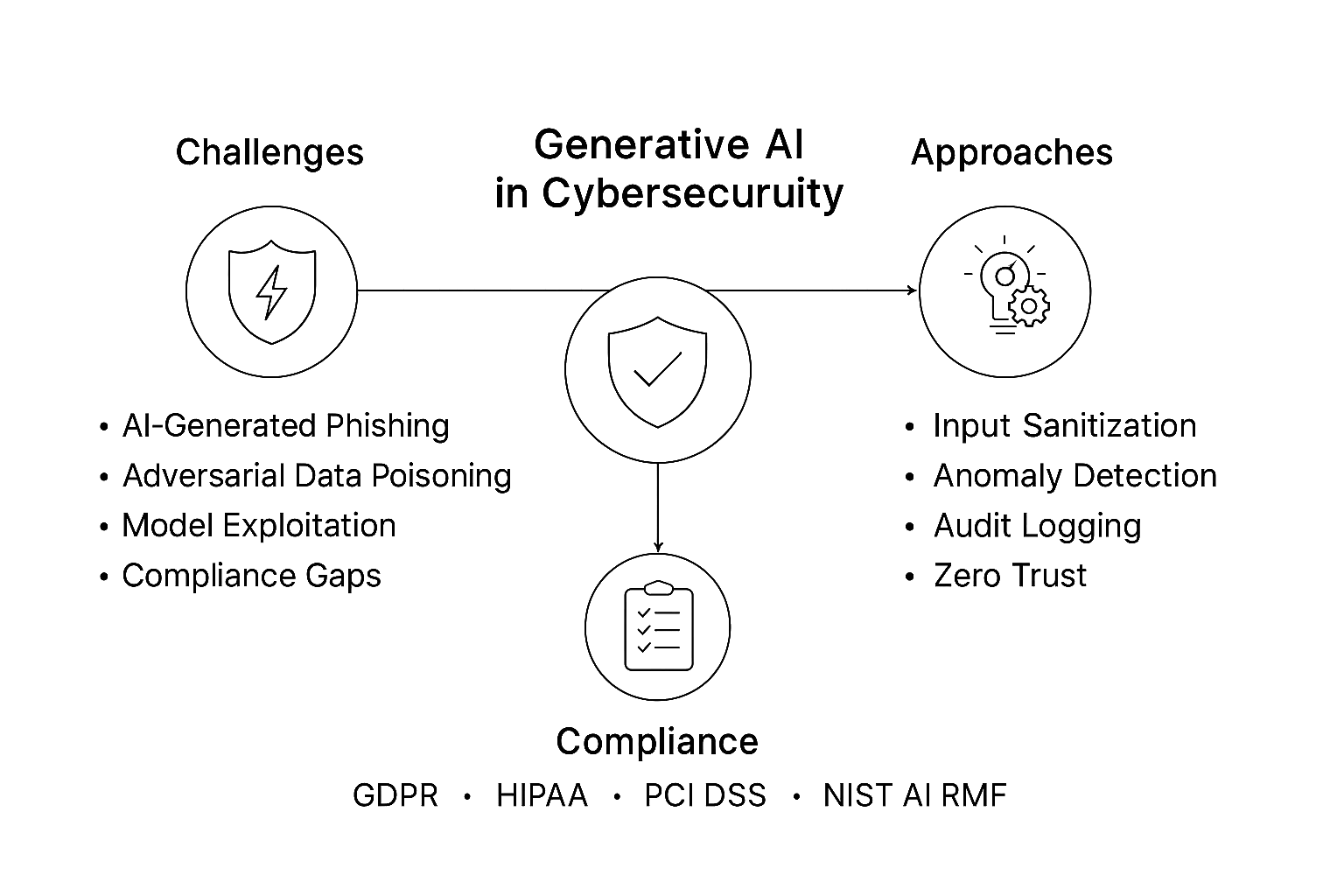

Sin embargo, a medida que los sistemas de IA crecen en complejidad y autonomía, también lo hacen las amenazas de IA y las superficies de ataque. Los adversarios han comenzado a militarizar la propia IA, utilizando modelos generativos, entrenamiento adversarial y técnicas de explotación automatizada para superar a los defensores humanos.

Hoy en día, cada vez más organizaciones enfrentan nuevas categorías de riesgo cibernético directamente vinculadas a la adopción de la IA. Desde la manipulación de modelos hasta la extracción de datos, las ventajas de la IA pueden convertirse fácilmente en vulnerabilidades cuando se dejan sin protección.

Comprendiendo las Amenazas de la IA

Los sistemas de IA procesan conjuntos de datos masivos, se adaptan de forma autónoma y toman decisiones de alto impacto — atributos que también los hacen atractivos para los atacantes.

Las amenazas pueden ocurrir en cada etapa del ciclo de vida de la IA: desde la ingesta de datos hasta la inferencia del modelo.

1. Envenenamiento de Datos

Los modelos de IA aprenden de lo que se les proporciona. Conjuntos de datos envenenados — que contienen muestras manipuladas o mal etiquetadas — pueden alterar los límites de decisión de un modelo.

En la detección de intrusiones, esto podría hacer que una actividad maliciosa parezca benigna. Incluso una contaminación menor puede reducir significativamente la precisión, un fenómeno a menudo invisible hasta que se explota en producción.

2. Inversión y Extracción de Modelos

Cuando los usuarios consultan repetidamente un modelo desplegado, pueden inferir patrones que revelan datos internos o parámetros.

Los atacantes han reconstruido conjuntos de datos propietarios y atributos sensibles (como detalles médicos o indicadores financieros) únicamente a partir de las respuestas del modelo — realizando efectivamente espionaje de IA.

3. Ejemplos Adversariales

Pequeñas perturbaciones cuidadosamente diseñadas en las entradas — tales como cambios imperceptibles en los píxeles o embeddings modificados — pueden engañar por completo a los sistemas de IA.

Un coche autónomo podría interpretar erróneamente una señal de alto como un límite de velocidad, o un detector de fraudes podría clasificar transacciones sospechosas como normales. Estos exploits no requieren acceso al código, sino únicamente a la interfaz expuesta del modelo.

4. Deepfakes Generativos

Modelos de generación de texto, imagen y voz están siendo utilizados para fabricar identidades, difundir desinformación y ejecutar campañas de ingeniería social a gran escala.

Combinados con sistemas automatizados de distribución, los deepfakes generan ataques de phishing o suplantación altamente convincentes que evaden los filtros tradicionales.

5. Exploits de Agentes Autónomos

Agentes de IA capaces de ejecutar comandos, programar acciones o acceder a APIs pueden ser manipulados para realizar operaciones dañinas.

Indicaciones maliciosas, conocidas como inyecciones de indicaciones, pueden anular reglas, provocar fugas de datos o ejecutar flujos de trabajo no autorizados mediante manipulación indirecta.

Soluciones Técnicas para la Seguridad de la IA

Proteger los sistemas de IA requiere una fusión de la disciplina clásica de ciberseguridad y la inteligencia adaptativa de las máquinas. El diseño defensivo comienza en la capa de datos y se extiende al monitoreo continuo y la auditoría.

1. Validación de la Integridad de los Datos

Antes del entrenamiento, cada conjunto de datos debe ser verificado en cuanto a autenticidad e integridad.

El siguiente fragmento ilustra un método de validación basado en hashing para asegurar que solo los datos aprobados ingresen a la cadena.

import hashlib

import os

def verify_dataset(path: str, expected_hash: str) -> bool:

"""Validar la integridad del conjunto de datos utilizando SHA-256."""

if not os.path.exists(path):

raise FileNotFoundError("Conjunto de datos no encontrado")

hasher = hashlib.sha256()

with open(path, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

hasher.update(chunk)

return hasher.hexdigest() == expected_hash

# Ejemplo de uso

if not verify_dataset("train.csv", "a91b...c2d"):

raise ValueError("¡Integridad del conjunto de datos comprometida!")

Al registrar las huellas digitales del conjunto de datos en registros de auditoría, las organizaciones pueden detectar manipulaciones tempranas — mucho antes de que muestras envenenadas lleguen a los modelos de producción.

2. Entrenamiento Adversarial Defensivo

La mejor forma de defenderse contra entradas adversariales es aprender de ellas.

Los equipos de IA pueden generar intencionadamente perturbaciones y reentrenar modelos para mejorar la robustez.

import numpy as np

def adversarial_noise(x, epsilon=0.01):

"""Agregar pequeñas perturbaciones para simular ataques adversariales."""

noise = epsilon * np.sign(np.random.randn(*x.shape))

return np.clip(x + noise, 0, 1)

# Ejemplo: aumentar los datos de entrenamiento con ruido

x_train_adv = adversarial_noise(x_train)

model.fit(x_train_adv, y_train)

Esta exposición controlada fortalece los modelos contra ataques en el mundo real y complementa los sistemas de analítica de comportamiento que rastrean anomalías en las solicitudes de inferencia.

3. Auditoría Continua y Explicabilidad

Los marcos de trabajo de IA explicable (XAI) combinados con registros inmutables permiten a los investigadores reconstruir qué decisiones se tomaron — y por qué.

Registrar cada evento de inferencia proporciona tanto transparencia operativa como documentación de cumplimiento.

import datetime, json

def log_inference(user, input_summary, prediction):

timestamp = datetime.datetime.utcnow().isoformat()

entry = {"time": timestamp, "user": user, "input": input_summary, "prediction": prediction}

print(json.dumps(entry))

log_inference("analyst01", "intento de inicio de sesión desde IP desconocida", "marcado_sospechoso")

Estos registros de auditoría pueden correlacionarse con la monitorización de la actividad de la base de datos para detectar anomalías en sistemas cruzados — relacionando la lógica de decisión de la IA con los rastros de transacciones de backend.

Estrategias Organizacionales para la Gestión de Riesgos de la IA

La tecnología solo puede llegar hasta cierto punto sin una gobernanza estructurada. La gestión de riesgos de IA debe integrarse en la política corporativa, en los flujos de trabajo de ingeniería y en los informes de cumplimiento.

1. Establecer Marcos de Riesgo para la IA

Adopta marcos alineados con el NIST AI RMF o las directrices del Paisaje de Amenazas de la IA de ENISA.

Estos ayudan a definir responsabilidades claras entre los equipos — científicos de datos, DevOps, oficiales de cumplimiento — asegurando que cada componente de la IA pase por una evaluación de riesgos y control de cambios consistente.

2. Asegurar las Cadenas de Suministro de la IA

Las cadenas de IA dependen de datos de terceros, modelos preentrenados y dependencias de código abierto.

Todos los artefactos deben ser verificados utilizando firmas criptográficas y rastreados mediante registros inmutables de procedencia.

Una sola biblioteca comprometida puede infectar todo el entorno de inferencia — al igual que los ataques a la cadena de suministro observados en el DevOps tradicional.

3. Construir Integración entre Equipos Red-Team y Blue-Team

El red-teaming en IA significa atacar tus propios modelos antes de que lo hagan los adversarios.

Al ejecutar indicaciones de explotación simuladas, intentos de extracción de modelos e insumos adversariales, las organizaciones pueden identificar puntos débiles desde el inicio.

Luego, los equipos Blue adaptan las reglas de seguridad y los manuales de respuesta en consecuencia.

4. Implementar Controles de Acceso Contextuales

Los sistemas de IA que acceden a bases de datos de producción deben operar bajo el principio de privilegio mínimo.

Integra el control de acceso basado en roles con señales contextuales de riesgo — ubicación del usuario, comportamiento de la sesión y tipo de consulta — para restringir dinámicamente el acceso a conjuntos de datos sensibles.

La Dimensión de Cumplimiento

Los requisitos regulatorios convergen hacia una mayor responsabilidad en la IA, garantizando que los sistemas sean tanto explicables como seguros.

El incumplimiento ya no solo implica multas; puede paralizar operaciones en sectores regulados como la salud o las finanzas.

| Regulación | Enfoque de Seguridad de la IA | Control Recomendado |

|---|---|---|

| GDPR | Transparencia en la toma de decisiones automatizadas | Mantener modelos explicables con registros de auditoría completos |

| HIPAA | Protección de la información de salud protegida (PHI) usada en diagnósticos con IA | Implementar enmascaramiento dinámico y cifrado |

| PCI DSS 4.0 | Modelos de IA que analizan datos de pago | Aplicar tokenización y segmentación de acceso |

| SOX | Responsabilidad de modelos financieros | Usar registros de auditoría y logs inmutables para trazabilidad |

| NIST AI RMF | Documentación de riesgos y procedencia | Implementar descubrimiento continuo de datos y validación de integridad |

Una estrategia de cumplimiento robusta para la IA no solo reduce la exposición al riesgo, sino que también genera confianza entre reguladores, clientes e inversores — demostrando que la IA puede ser tanto innovadora como responsable.

Conclusión: Construir Sistemas de IA Resilientes

Las amenazas de la IA continuarán evolucionando tan rápido como la propia tecnología.

Los atacantes ya no solo irrumpen en redes: están corrompiendo algoritmos, manipulando datos y explotando debilidades cognitivas en las interacciones entre humanos y máquinas.

Defenderse contra estos riesgos requiere una postura de seguridad en múltiples capas:

- Prevención — validar los datos y asegurar la cadena de suministro

- Detección — monitorear comportamientos utilizando modelos adaptativos y generativos

- Respuesta — mantener logs inmutables y explicabilidad para las auditorías

- Gobernanza — alinearse con marcos de cumplimiento globales y estándares éticos

La IA seguirá siendo tanto una arma como un escudo. Las organizaciones que prosperen serán aquellas que la traten como ambas — construyendo sistemas que anticipen, resistan y evolucionen más rápido que las amenazas que enfrentan.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora