Aprendizaje Automático Adversarial

A medida que la inteligencia artificial se expande a través de flujos de trabajo críticos para el negocio, alrededor del 91% de los bancos de EE. UU. ahora utilizan la IA para la detección de fraudes, según Elastic Insights (2025).

Mientras que la mayoría de las organizaciones invierte fuertemente en seguridad de bases de datos y controles de infraestructura, el aprendizaje automático adversarial (AML) expone una amenaza nueva y más sutil: una que apunta a los propios algoritmos en lugar de a los sistemas que los rodean.

Este artículo explora cómo funcionan los ataques adversariales, por qué son tan peligrosos para las canalizaciones de IA y cómo tecnologías como el enfoque de seguridad inspirada en datos de DataSunrise pueden reforzar la integridad del modelo desde el entrenamiento hasta el despliegue.

Comprensión del Aprendizaje Automático Adversarial

El aprendizaje automático adversarial se centra en diseñar intencionalmente entradas que provoquen que los modelos de IA cometan errores, desde clasificar incorrectamente imágenes hasta generar predicciones falsas. En esencia, es la ciencia de convertir la inteligencia de un modelo en una debilidad.

A diferencia de las amenazas cibernéticas clásicas que explotan fallas en el software, los ataques adversariales tienen como objetivo el núcleo estadístico del propio aprendizaje automático. Unos pocos bytes de entrada alterada pueden manipular la salida del modelo sin que los humanos noten ningún cambio. Por eso, defender los sistemas de IA exige una combinación de monitoreo en tiempo real, detección de anomalías y seguimiento de la procedencia de los datos a lo largo de todas las etapas de aprendizaje.

Las Amenazas Adversariales Fundamentales

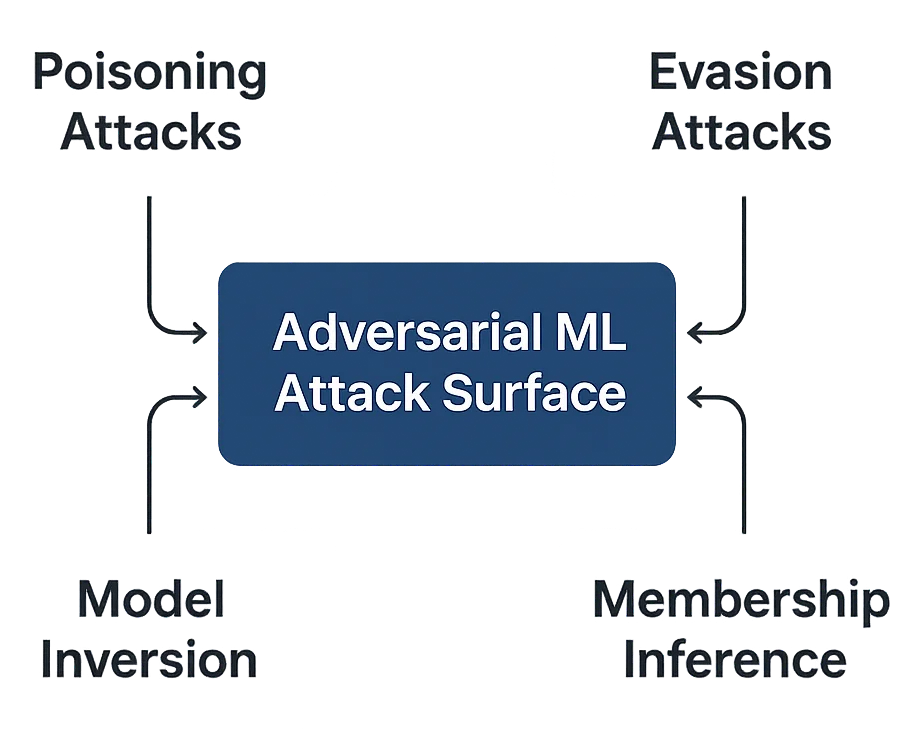

El aprendizaje automático adversarial puede manifestarse en varias formas, dependiendo de cuándo y cómo los atacantes intervienen:

- Ataques de Envenenamiento – Corromper los conjuntos de datos de entrenamiento con ejemplos maliciosos. Incluso una contaminación leve de los datos puede sesgar los modelos y sabotear predicciones críticas para el cumplimiento.

- Ataques de Evasión – Diseñar entradas que evaden la detección del modelo. Común en el reconocimiento facial, filtros de spam y detección de fraudes.

- Inversión del Modelo – Reconstruir datos sensibles de entrenamiento a partir de las salidas del modelo, amenazando la exposición de PII.

- Inferencia de Pertenencia – Adivinar si un registro en particular formó parte del conjunto de entrenamiento, socavando las garantías de confidencialidad de los datos.

Detección del Comportamiento Adversarial en Tiempo Real

Las herramientas tradicionales de monitoreo no pueden reconocer fácilmente una entrada adversarial. Una matriz de píxeles ligeramente alterada o una incrustación de texto puede parecer normal, pero puede desviar completamente el comportamiento del modelo. Para abordar esto, los equipos de seguridad dependen de detectores basados en ML que señalan anomalías en el comportamiento del gradiente, la varianza de las características o la entropía de la salida.

A continuación se muestra un ejemplo simplificado de dicho detector:

import numpy as np

class AdversarialDetector:

"""Detecta perturbaciones adversariales basadas en el análisis de desviación de características."""

def __init__(self, baseline_vector: np.ndarray, threshold: float = 0.15):

self.baseline = baseline_vector

self.threshold = threshold

def detect(self, input_vector: np.ndarray) -> dict:

delta = np.linalg.norm(input_vector - self.baseline) / len(input_vector)

is_adversarial = delta > self.threshold

return {

"amenaza_detectada": is_adversarial,

"puntuación_de_riesgo": float(delta * 100),

"gravedad": "ALTO" if is_adversarial else "BAJO",

"recomendaciones": ["Reentrenar con datos verificados"] if is_adversarial else []

}

Esta rutina compara nuevas entradas contra una línea base de distribuciones de datos confiables, proporcionando indicadores tanto cuantitativos como cualitativos para el análisis de comportamiento posterior.

Fortalecimiento de Modelos con Entrenamiento Defensivo

Más allá de la detección, las organizaciones deben fortalecer sus modelos contra manipulaciones futuras. Una técnica efectiva es el entrenamiento adversarial: exponer deliberadamente el modelo a muestras modificadas durante el aprendizaje para que aprenda a resistirlas.

class RobustTrainer:

"""Realiza entrenamiento adversarial para mejorar la resiliencia del modelo."""

def __init__(self, model, epsilon: float = 0.1):

self.model = model

self.epsilon = epsilon

def perturb(self, x):

noise = np.random.uniform(-self.epsilon, self.epsilon, x.shape)

return np.clip(x + noise, 0, 1)

def train(self, data, labels):

adv_data = self.perturb(data)

combined = np.vstack((data, adv_data))

combined_labels = np.concatenate((labels, labels))

self.model.fit(combined, combined_labels)

return {"estado": "Modelo entrenado con robustez adversarial"}

Mejores Prácticas para la Seguridad del Aprendizaje Automático Adversarial

Para Organizaciones

- Asegura el Ciclo de Vida de los Datos – Establece un seguimiento continuo de la historia de actividad para detectar anomalías tempranas.

- Establece la Gobernanza del Modelo – Define la propiedad y las políticas que se alineen con marcos de cumplimiento tales como GDPR y HIPAA.

- Audita Todo – Habilita rastros de auditoría unificados para verificar la procedencia del modelo y la integridad del entrenamiento.

- Educa a los Interesados – Asegura que los científicos de datos comprendan las implicaciones de seguridad del ruido adversarial.

Para Equipos Técnicos

- Utiliza Herramientas de IA Explicable – Interpreta las salidas del modelo y rastrea anomalías a través de paneles de seguridad.

- Integra Validación Continua – Automatiza las comprobaciones dentro de las canalizaciones utilizando controles de proxy inverso para filtrar solicitudes.

- Aplica Acceso Basado en Roles – Restringe el acceso al entrenamiento e inferencia del modelo con control de acceso basado en roles (RBAC).

- Encripta los Conjuntos de Datos – Utiliza encriptación a nivel de campo para evitar la recuperación no autorizada de datos.

DataSunrise: Protección Integral contra el Aprendizaje Automático Adversarial

DataSunrise extiende la protección más allá de la infraestructura, incorporando resiliencia directamente en el flujo de trabajo de la IA. Su plataforma ofrece Orquestación de Seguridad sin Intervención con Protección Contextual y Detección Autónoma de Amenazas en más de 50 plataformas compatibles.

Capacidades Clave

- Detección de Anomalías Potenciada por ML – Correla el comportamiento anormal del gradiente y de las características.

- Seguimiento de la Procedencia de Datos – Asegura que cada registro utilizado en el entrenamiento del modelo sea verificable.

- Piloto Automático de Cumplimiento – Mapea las operaciones del modelo y de los datos a los controles regulatorios.

- Marco Unificado de Auditoría – Vincula registros, eventos y actividad de usuarios en un único panel.

- Motor de Enmascaramiento Adaptativo – Oculta dinámicamente las características de alto riesgo durante la evaluación del modelo.

Juntos, estos módulos aseguran el cumplimiento de la IA por defecto, evitando tanto manipulaciones adversariales intencionales como accidentales en entornos empresariales.

Conclusión: Construyendo Modelos de IA Confiables

El aprendizaje automático adversarial nos recuerda que los sistemas inteligentes pueden ser engañados tan fácilmente como los humanos, y que su protección requiere una defensa igualmente inteligente.

Al combinar controles de datos robustos, modelos explicables y una aplicación continua de firewall de bases de datos, las organizaciones pueden transformar la vulnerabilidad en vigilancia.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora