Lista de Verificación de Seguridad de Aplicaciones LLM

Introducción

A medida que las organizaciones integran Modelos de Lenguaje a Gran Escala (LLMs) en producción, la superficie de ataque se expande más allá de las fugas de datos y la inyección de indicaciones. Cada sistema conectado a un LLM, ya sea incrustado en chatbots, herramientas analíticas o en la búsqueda empresarial, debe equilibrar la usabilidad con la seguridad de los datos y el cumplimiento.

Si bien las API modernas de IA protegen los puntos finales del modelo, las vulnerabilidades a menudo se encuentran en los puntos de integración: la sanitización de entradas, los permisos de plugins, el almacenamiento vectorial o la lógica de indicaciones sin protección. Construir aplicaciones de IA seguras significa implementar un monitoreo continuo, encriptación y políticas de privilegio mínimo desde la indicación hasta la respuesta.

Comprendiendo la Seguridad de Aplicaciones LLM

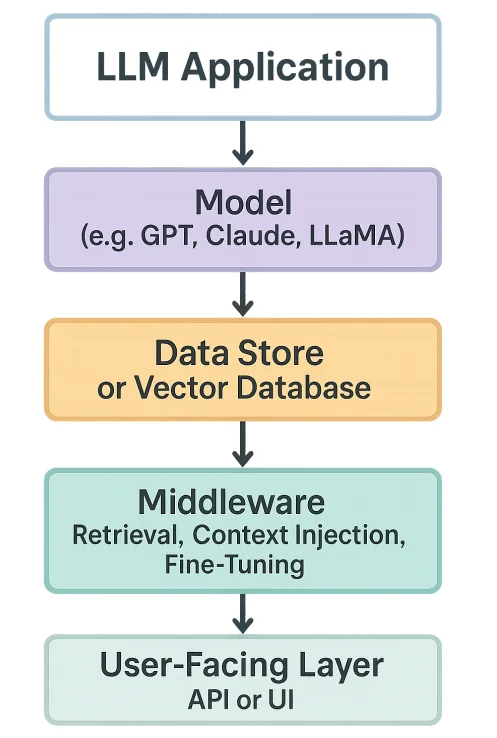

Una aplicación LLM típicamente combina cuatro elementos:

- El modelo (por ejemplo, GPT, Claude, LLaMA)

- El almacén de datos o base de datos vectorial

- El middleware (recuperación, inyección de contexto, ajuste fino)

- La capa orientada al usuario (API o interfaz de usuario)

Cada capa introduce riesgos:

- El modelo puede memorizar datos sensibles.

- La capa de recuperación podría exponer incrustaciones privadas.

- Los complementos podrían ejecutar acciones no intencionadas.

- Los registros pueden almacenar PII o tokens confidenciales.

La seguridad aquí significa proteger tanto la cadena de procesos como la inteligencia que genera.

Principales Desafíos de Seguridad

- Ataques de Inyección de Indicaciones – Entradas maliciosas que manipulan el comportamiento del modelo para filtrar o modificar datos sensibles.

- Exfiltración de Datos a través de Complementos – APIs de complementos sin restricciones o llamadas a herramientas externas que exportan datos privados.

- Envenenamiento de Datos de Entrenamiento – Conjuntos de datos de ajuste fino o de recuperación corruptos que inyectan hechos falsos o vulnerabilidades.

- Inyección en la Salida del Modelo – Atacantes que incrustan cargas maliciosas en las respuestas (por ejemplo, scripts entre sitios).

- Deriva de Cumplimiento – Cuando los LLM procesan datos sensibles sin registros de auditoría, violando los estándares de GDPR o HIPAA.

Capas Esenciales de Seguridad para Aplicaciones LLM

1. Seguridad de Datos y Cumplimiento Normativo

- Encripte las incrustaciones almacenadas y los índices vectoriales utilizando encriptación de bases de datos.

- Clasifique y oculte datos sensibles con enmascaramiento dinámico o enmascaramiento estático antes de proporcionarlos al modelo.

- Valide la alineación con marcos como GDPR y PCI DSS.

2. Control de Acceso y Monitoreo

- Haga cumplir el control de acceso basado en roles (RBAC).

- Implemente pasarelas de proxy inverso para autenticación, límites de velocidad y detección de anomalías.

- Centralice el monitoreo de actividad para cada llamada a la API y consulta al modelo.

3. Protección de Indicaciones y Contexto

- Sane las entradas del usuario y oculte secretos antes de pasarlos al LLM.

- Aplique “barreras de seguridad” que validen las respuestas y eliminen identificadores confidenciales.

- Registre todas las indicaciones de manera segura utilizando registros de auditoría.

4. Seguridad en el Ciclo de Vida del Modelo

- Firme y versiona cada modelo y conjunto de datos.

- Revise todos los conjuntos de datos de ajuste fino para detectar inyección o contenido malicioso.

- Aplique comprobaciones de integridad continuas utilizando hashing o firmas digitales.

5. Defensa de Red y API

- Utilice HTTPS/TLS para todo el tráfico del modelo.

- Limite las conexiones salientes de las aplicaciones LLM.

- Monitoree todas las llamadas de complementos y APIs externas para detectar exfiltración de datos.

Prácticas Recomendadas de Implementación

Para Organizaciones

- Primero, Clasificación de Datos: Identifique qué entradas son sensibles o están reguladas.

- Vista Unificada de Cumplimiento: Aproveche el descubrimiento de datos y los informes de cumplimiento de DataSunrise para monitorear el uso.

- Despliegue de IA de Confianza Cero: Asuma que cada indicación o respuesta podría ser un vector de ataque.

- Pruebas de Seguridad Regulares: Realice evaluaciones del equipo rojo y adversarias en las salidas de los LLM.

Para Equipos Técnicos

- Higiene en el Ajuste Fino: Valide los conjuntos de datos antes del ajuste fino o la ingesta RAG.

- Gestión Segura de Secretos: Nunca incruste claves API en las indicaciones o en las variables de entorno sin encriptación.

- Análisis de Comportamiento: Utilice análisis de comportamiento para detectar patrones inusuales en las consultas.

- Política de Mínimos Privilegios: Siga el principio de privilegio mínimo en todas las APIs y capas de acceso al modelo.

Lista de Verificación de Seguridad de Aplicaciones LLM (Resumen)

| Área | Controles Clave | Herramientas / Técnicas |

|---|---|---|

| Capa de Datos | Encriptación, enmascaramiento, etiquetado de conformidad | Encriptación de Bases de Datos, Enmascaramiento Dinámico |

| Control de Acceso | RBAC, MFA, proxies | Proxy Inverso, RBAC |

| Capa de Indicaciones | Sanitización, filtros de contexto | Barreras de seguridad personalizadas, scripts de validación |

| Ciclo de Vida del Modelo | Versionado, firma, validación | GitOps, escaneo CI/CD |

| Monitoreo | Auditoría centralizada y detección de anomalías | Monitoreo de Actividad, Registros de Auditoría |

Preguntas Frecuentes: Seguridad en Aplicaciones LLM

P1. ¿Cuál es el mayor riesgo de seguridad en los LLM?

Inyección de indicaciones y exfiltración de datos a través de complementos conectados o APIs externas.

P2. ¿Puede un LLM filtrar datos de entrenamiento?

Sí — especialmente en modelos ajustados o RAG entrenados en conjuntos de datos sensibles sin enmascaramiento o encriptación.

P3. ¿Cómo puedo asegurar el cumplimiento de GDPR o HIPAA?

Habilite el enmascaramiento de datos, el seguimiento de consentimientos y los registros de auditoría para todas las interacciones con el modelo.

P4. ¿Cuál es la mejor manera de detectar actividad maliciosa?

Utilice análisis de comportamiento y monitoreo en tiempo real para detectar patrones inusuales de consulta o uso excesivo de tokens.

P5. ¿Cómo asegura DataSunrise los flujos de trabajo de LLM?

Combinando monitoreo de actividad basado en proxy, enmascaramiento, encriptación y automatización de cumplimiento dentro de un marco unificado.

Conclusión

Así como el aprendizaje federado enseñó al mundo que la colaboración que preserva la privacidad es posible, asegurar los LLM demuestra que la inteligencia y la gobernanza pueden coexistir.

DataSunrise permite a las organizaciones imponer encriptación, monitoreo y cumplimiento en todo el ecosistema de LLM — desde almacenamientos vectoriales hasta modelos ajustados — asegurando que ningún conocimiento se obtenga a costa de la seguridad.

Lecturas Recomendadas: