Computación Confidencial para IA

Introducción

A medida que las empresas despliegan inteligencia artificial (IA) en entornos híbridos y en la nube, la confidencialidad de los datos se convierte en una preocupación principal.

El entrenamiento de modelos modernos requiere vastas cantidades de información privada — desde imágenes médicas y registros financieros hasta interacciones con clientes — que a menudo se procesan en infraestructuras compartidas o multiinquilino.

Las medidas tradicionales de seguridad protegen los datos en reposo mediante cifrado y en tránsito a través de protocolos seguros como TLS. Sin embargo, los datos permanecen expuestos durante su uso en el proceso de cómputo, una brecha que los atacantes pueden explotar.

La Computación Confidencial cierra esta brecha. Protege los datos mientras se procesan activamente utilizando Entornos de Ejecución Confiables (TEE, por sus siglas en inglés) — enclaves aislados y protegidos por hardware dentro de las CPU. Dentro de estos enclaves, los datos permanecen cifrados y son inaccesibles incluso para usuarios privilegiados, hipervisores o el mismo proveedor de la nube.

Obtén más información en la guía de Computación Confidencial para IA de Google Cloud para conocer detalles arquitectónicos.

La Necesidad de una IA Confidencial

Los sistemas de IA involucran varias capas interdependientes — ingestión, preprocesamiento, entrenamiento e inferencia. Cada capa introduce su propia superficie de exposición:

- Datos en Tránsito: La información enviada entre servicios en la nube puede ser interceptada.

- Datos en Reposo: Un cifrado inadecuado o políticas de acceso inadecuadas pueden conducir a la recuperación no autorizada de datos.

- Datos en Uso: Cuando los datos se descifran en la memoria, pueden ser accesados por usuarios internos o sistemas operativos comprometidos.

La mayoría de las empresas ya gestionan los dos primeros estados con herramientas de seguridad consolidadas como la cifrado de bases de datos y la protección a nivel de red. Sin embargo, los datos en uso siguen siendo vulnerables, ya que el cifrado debe ser temporalmente levantado para el procesamiento.

La Computación Confidencial elimina ese requisito. Mantiene el cómputo cifrado, asegurando que los datos sin formato nunca abandonen el enclave seguro. Esto la hace indispensable para el aprendizaje federado, la analítica transfronteriza y las industrias reguladas donde el cumplimiento de GDPR, HIPAA y PCI DSS es obligatorio.

Cómo Funciona la Computación Confidencial

La Computación Confidencial aprovecha los TEE basados en hardware, como Intel SGX, AMD SEV y ARM TrustZone. Estos enclaves son pequeñas porciones dedicadas de la memoria de la CPU que garantizan la integridad, confidencialidad y validación.

Dentro de un TEE:

- Los datos se descifran y procesan únicamente dentro de los límites del enclave.

- La ejecución del código permanece aislada del sistema operativo, el hipervisor y otras máquinas virtuales.

- La validación remota verifica que solo se ejecute código autorizado y sin alteraciones dentro del enclave antes de provisionar claves sensibles.

Este modelo asegura que incluso los administradores del sistema, usuarios internos o hipervisores comprometidos no puedan espiar o modificar la carga de trabajo.

Transforma los entornos de IA en la nube en zonas de cómputo de confianza, ideales para cargas de trabajo confidenciales como el entrenamiento de modelos entre múltiples partes o la inferencia segura sobre datos de usuarios.

Flujos de Trabajo de IA Asegurados por la Computación Confidencial

1. Entrenamiento de Modelos Sensibles

Conjuntos de datos de alto riesgo, como datos genómicos o financieros, pueden ser procesados de forma segura dentro de los TEE sin ser expuestos.

Esto permite a las instituciones entrenar modelos de manera colaborativa a través de diferentes jurisdicciones, manteniendo los registros sensibles confidenciales.

2. Aprendizaje Federado y Colaboración de Datos

Las organizaciones pueden aportar datos cifrados a un proceso de entrenamiento compartido.

Solamente los parámetros resultantes del modelo — y no los datos sin procesar — abandonan el enclave, permitiendo una colaboración que preserva la privacidad entre hospitales, bancos o centros de investigación.

3. Inferencia y Predicción Segura

La entrada del usuario (por ejemplo, una imagen médica o una solicitud de préstamo) puede ser analizada de forma segura dentro del enclave, protegiendo tanto la entrada como los pesos del modelo del acceso externo.

4. Cumplimiento Regulatorio

La Computación Confidencial permite el cumplimiento continuo de regulaciones de privacidad como GDPR, HIPAA y PCI DSS.

Asegura un procesamiento listo para auditorías sin comprometer el rendimiento o la accesibilidad.

Visión General de la Arquitectura

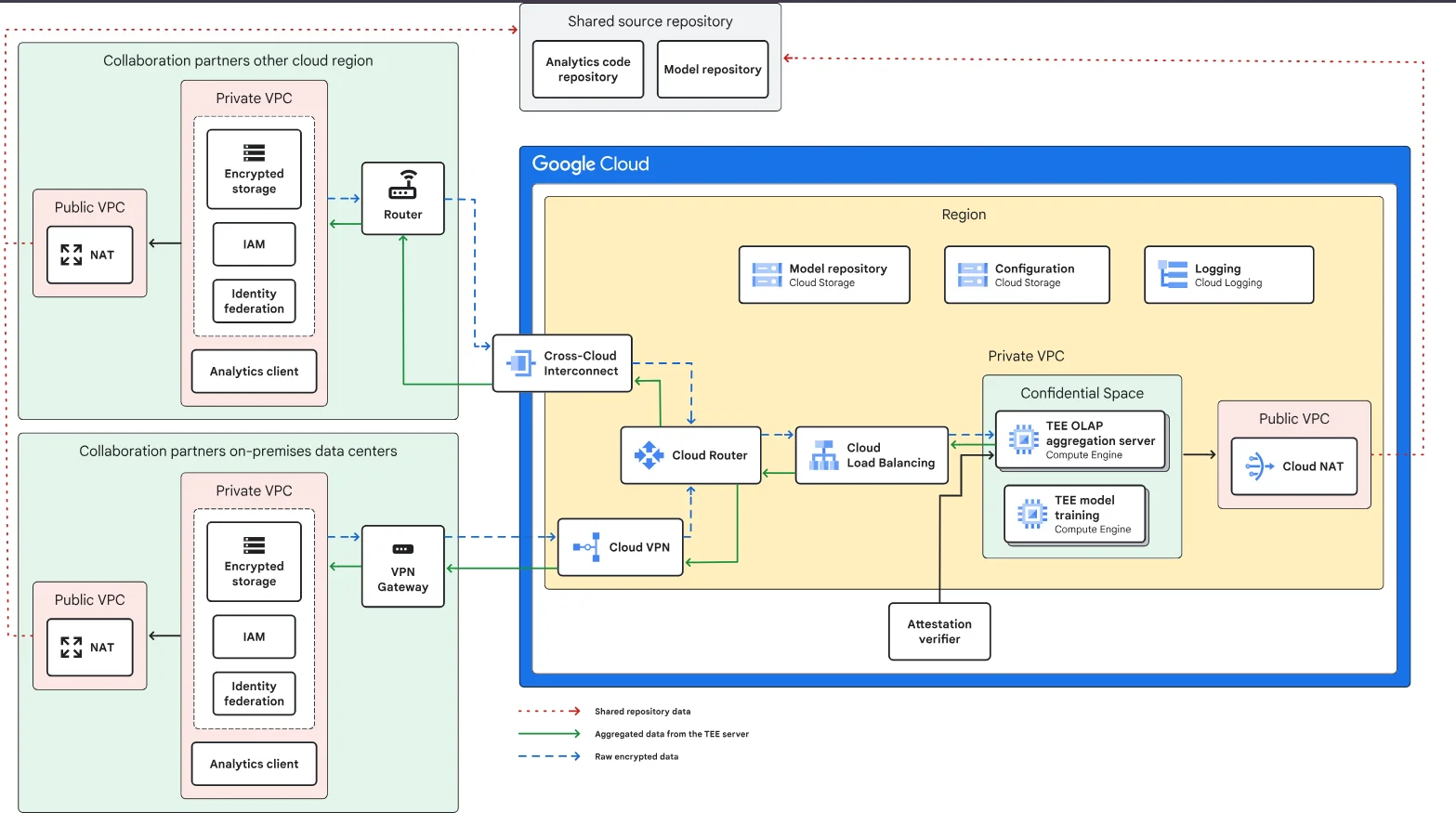

A continuación se muestra una arquitectura conceptual de referencia extraída de la Guía de IA Confidencial de Google Cloud.

Desglose de la Arquitectura

| Componente | Función | Función de Seguridad |

|---|---|---|

| Espacio Confidencial (TEE) | Ejecuta cómputos sensibles | Cifra y aísla los datos en uso |

| Almacenamiento Cifrado | Almacena conjuntos de datos para el entrenamiento | Protege los datos en reposo con claves gestionadas |

| Balanceador de Carga y Router en la Nube | Dirige el tráfico entre enclaves | Mantiene la segmentación de la red y el cifrado |

| Interconexión entre Nubes / VPN | Conecta los entornos de los socios | Asegura una comunicación cifrada |

| Verificador de Validación | Confirma la integridad del enclave | Previene la ejecución de código no verificado |

| Registro y Monitoreo | Rastrea eventos del enclave | Soporta registros de auditoría y la verificación del cumplimiento |

Ejemplo: Ejecución de Modelo Basada en Enclave

A continuación se muestra un ejemplo simplificado de la ejecución de un modelo basado en enclave con validación remota antes de ejecutar código sensible:

class ConfidentialEnclave:

def __init__(self, enclave_id: str):

self.enclave_id = enclave_id

self.attested = False

def attest(self, signature: str):

"""Verifica la integridad del enclave mediante validación."""

if signature == "valid_signature":

self.attested = True

print("Enclave verificado y de confianza.")

else:

raise PermissionError("¡La validación falló!")

def run_model(self, data: list):

if not self.attested:

raise PermissionError("El modelo no puede ejecutarse en un enclave no verificado.")

print(f"Procesando {len(data)} registros de forma segura dentro del enclave {self.enclave_id}.")

# Ejemplo de uso

enclave = ConfidentialEnclave("TEE-01")

enclave.attest("valid_signature")

enclave.run_model(["record1", "record2"])

En entornos de producción, el proceso incluye la provisión segura de claves y verificaciones basadas en hardware de la firma antes de permitir el acceso a los pesos del modelo cifrados o a conjuntos de datos sensibles.

Ventajas Operativas y de Seguridad

La Computación Confidencial introduce mejoras medibles tanto en la eficiencia operativa como en la garantía de cumplimiento:

- Privacidad Mejorada: La memoria cifrada previene fugas de datos a través de herramientas del sistema o volcados de memoria.

- Confianza Verificable: La validación basada en hardware proporciona prueba de la integridad del enclave para auditores externos.

- Colaboración Segura: Múltiples organizaciones pueden procesar datos compartidos sin revelar detalles propietarios.

- Alineación con el Cumplimiento: Los mecanismos integrados de cifrado simplifican las auditorías bajo marcos normativos como SOX o GDPR.

- Resistencia contra Amenazas Internas: Incluso las cuentas privilegiadas no pueden ver o manipular los datos del enclave.

Estas capacidades hacen que la Computación Confidencial sea esencial para gestionar de forma segura el ciclo de vida de los modelos de IA, desde la ingestión de datos hasta la inferencia.

Integrando la Computación Confidencial en los Flujos de Trabajo de IA

Las organizaciones pueden integrar los TEE en sus actuales flujos de trabajo de aprendizaje automático con un rediseño mínimo.

Un flujo de implementación típico incluye:

import hashlib

def secure_pipeline_hash(stage: str, payload: bytes) -> str:

"""Genera un hash inmutable para cada etapa del flujo de trabajo de IA."""

stage_hash = hashlib.sha256(stage.encode() + payload).hexdigest()

print(f"Etapa '{stage}' registrada con hash: {stage_hash}")

return stage_hash

# Ejemplo: registrar etapas seguras del entrenamiento

secure_pipeline_hash("data_preprocessing", b"normalized_features")

secure_pipeline_hash("model_training", b"weights_v3.4")

secure_pipeline_hash("evaluation", b"accuracy_0.98")

El hashing inmutable y los registros de validación aseguran una trazabilidad completa para auditorías de cumplimiento y análisis forense de incidentes, alineándose con las mejores prácticas en monitoreo de la actividad de bases de datos.

Desafíos y Consideraciones

Si bien la Computación Confidencial ofrece un fuerte aislamiento, las organizaciones deben considerar factores prácticos antes de su implementación a gran escala:

- Impacto en el Rendimiento: El cómputo cifrado puede introducir una leve latencia, lo que requiere una planificación de la capacidad.

- Maduridad del Ecosistema: La integración con GPUs, TPUs y aceleradores aún está en evolución.

- Compatibilidad de Aplicaciones: El código heredado puede requerir refactorización para funcionar dentro de los TEE.

- Gestión de Claves: La seguridad depende de una robusta gestión del ciclo de vida de las claves de cifrado.

La combinación de la Computación Confidencial con las políticas de seguridad existentes y evaluaciones continuas de vulnerabilidad ayuda a mitigar estos desafíos de manera efectiva.

Mapeo de Cumplimiento

La IA Confidencial soporta directamente varios requisitos de cumplimiento que regulan la protección de datos durante su procesamiento.

| Regulación | Requisito de IA Confidencial | Enfoque de Solución |

|---|---|---|

| GDPR | Minimización de datos y seudonimización durante el cómputo de IA | Aislar y cifrar conjuntos de datos en enclaves seguros |

| HIPAA | Proteger la información de salud del paciente durante análisis basados en IA | Realizar el entrenamiento y la inferencia de modelos dentro de los TEE |

| PCI DSS 4.0 | Prevenir la exposición de datos de pago durante la inferencia del modelo | Procesar registros sensibles únicamente en entornos validados |

| SOX | Asegurar la responsabilidad y auditabilidad en el procesamiento de datos de IA | Mantener registros de auditoría verificables para las operaciones en el enclave |

| NIST AI RMF | Integridad y resiliencia de la ejecución confiable de la IA | Aprovechar la validación basada en hardware y la verificación en tiempo de ejecución |

Conclusión

La seguridad de los sistemas de IA requiere proteger los datos a lo largo de todo su ciclo de vida — en reposo, en tránsito y ahora durante su uso.

La Computación Confidencial completa este modelo de protección cifrando los datos durante el cómputo, asegurando que ni siquiera los usuarios internos más privilegiados o los proveedores de la nube puedan acceder a ellos.

Las organizaciones que implementen este enfoque podrán habilitar colaboración en IA a través de nubes, analítica que preserva la privacidad y cumplimiento regulatorio sin comprometer la escalabilidad.

Al extender el diseño de confianza cero hacia la capa de cómputo, establecen una base de confianza, transparencia y responsabilidad para los sistemas de IA de próxima generación.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora