Seguridad LLM vs Seguridad

Los Modelos de Lenguaje Extenso (LLMs) están transformando el desarrollo de software, la educación y la analítica. Sin embargo, la prisa por implementarlos ha generado un creciente debate: seguridad LLM vs seguridad — y cuál es más importante.

Los dos conceptos a menudo se superponen, pero representan desafíos muy diferentes en el despliegue responsable de la IA.

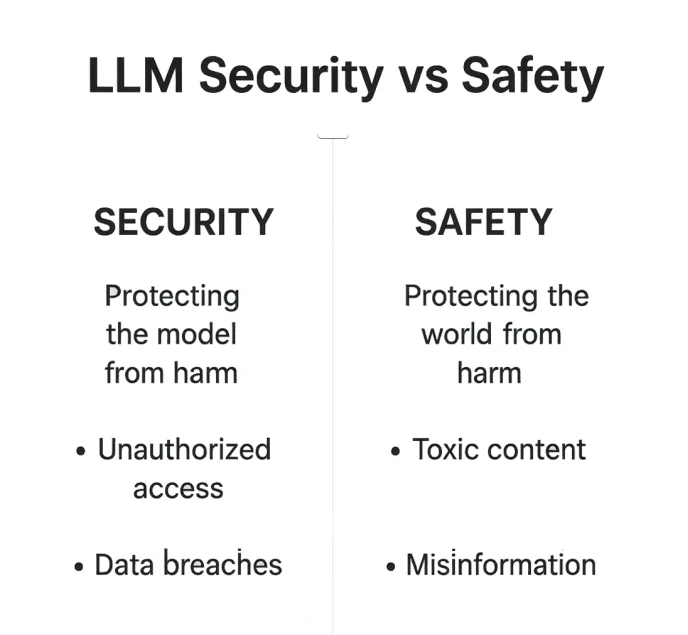

Seguridad LLM vs Seguridad: Entendiendo la Diferencia

Cuando se habla de asegurar los Modelos de Lenguaje Extenso, a menudo se utilizan los términos seguridad y safety de manera indistinta, pero operan en capas muy diferentes del ecosistema de la IA.

La seguridad LLM se trata de reforzar el entorno del modelo: protegiendo bases de datos, puntos de acceso y APIs de posibles explotaciones. Mientras tanto, la seguridad (safety) LLM se centra en lo que el modelo dice — asegurando que sus respuestas se mantengan éticas, factuales y dentro de límites aceptables.

La seguridad es una lucha contra la manipulación externa. La seguridad (safety) es una salvaguarda contra la desalineación interna. En la práctica, ambas se superponen. Un modelo comprometido puede producir salidas inseguras, y un modelo inseguro puede convertirse en un riesgo de seguridad a través de ingeniería social o fugas de datos. Comprender las diferencias entre estas dos dimensiones es esencial para construir sistemas de IA que sean tanto confiables como resilientes.

| Aspecto | Seguridad LLM | Seguridad (Safety) LLM |

|---|---|---|

| Enfoque | Protección de la infraestructura, datos y modelos contra accesos no autorizados | Prevención de salidas dañinas, sesgadas o poco éticas |

| Amenazas | Ataques de inyección, accesos no autorizados, violaciones de datos | Contenido tóxico, desinformación, violaciones éticas |

| Objetivo | Mantener el modelo y los datos seguros | Mantener las salidas seguras y alineadas |

| Ejemplo | Prevención de inyección SQL | Filtrado de contenido mediante RLHF |

Ambas juntas forman la columna vertebral del despliegue responsable de la IA — donde la protección técnica asegura la confianza y la alineación ética asegura la rendición de cuentas.

1. Lo que Significa la Seguridad en los LLMs

La seguridad en los LLM se centra en proteger la infraestructura, modelos y flujos de datos de accesos o manipulaciones no autorizadas.

Es el escudo técnico que salvaguarda datos confidenciales, propiedad intelectual e integridad del sistema — la barrera silenciosa entre una operación segura y una catástrofe de datos.

Riesgos Comunes de Seguridad

Los atacantes exploran constantemente los sistemas LLM en busca de puntos débiles: inyectando instrucciones ocultas, explotando solicitudes sin filtrar o recolectando tokens de registros no seguros.

Incluso el modelo más avanzado puede ser comprometido si depende de un flujo de recuperación sin protección o expone incrustaciones confidenciales.

Los puntos débiles típicos incluyen:

- Acceso no autorizado a los datos mediante inyección de solicitudes o APIs mal configuradas

- Exposición de campos sensibles o tokens en los registros

- Falta de cifrado en los flujos de recuperación o de ajuste fino

Estas amenazas convierten a los modelos inteligentes en vectores de responsabilidad — a menos que se implementen capas de defensa robustas.

Controles de Mitigación

La seguridad LLM no es una sola barrera — es un sistema de defensas en capas:

- Firewall de base de datos para la protección perimetral

- Protección de datos y cifrado para datos almacenados y transmitidos

- Monitoreo de actividad de bases de datos para identificar comportamientos anómalos antes de que se propaguen

2. Lo que Significa la Seguridad (Safety) en los LLMs

La seguridad (safety) se ocupa de cómo se comporta un LLM — sus límites éticos, confiabilidad factual y capacidad para evitar daños.

Si la seguridad es la bóveda alrededor del modelo, la seguridad (safety) es la conciencia en su interior.

La seguridad (safety) se enfoca menos en detener hackers y más en prevenir daños sociales, reputacionales o morales que pueden resultar de salidas sin control.

Un modelo inseguro puede difundir desinformación tan fácilmente como uno comprometido puede filtrar credenciales.

Riesgos de Seguridad (Safety)

Los modelos mal ajustados podrían producir:

- Contenido tóxico, sesgado u ofensivo

- Información alucinada o engañosa

- Alteraciones en las solicitudes que anulan filtros de moderación

Cada una de estas fallas erosiona la confianza del usuario — y en sectores regulados, puede conllevar serias consecuencias de cumplimiento.

Medidas de Seguridad (Safety)

Los desarrolladores contrarrestan estos riesgos combinando estrategias de entrenamiento y controles de datos:

- Aprendizaje por refuerzo a partir de retroalimentación humana (RLHF)

- Descubrimiento de datos y detección de PII para identificar información sensible

- Enmascaramiento estático de datos antes del entrenamiento para prevenir la exposición

# Ejemplo simple de barrera de salida segura

def safe_response(output: str) -> str:

banned = ["password", "SSN", "card number"]

return "[REDACTED]" if any(b in output.lower() for b in banned) else output

3. Dónde se Intersectionan la Seguridad LLM y la Seguridad (Safety)

La línea se difumina en la interfaz del modelo — donde se unen las solicitudes, la recuperación y la generación.

Esta es la zona gris donde un sistema seguro aún puede producir salidas inseguras, y un modelo “seguro” podría exponer datos internos de manera involuntaria.

Un sistema puede estar seguro pero ser inseguro (filtrando datos privados almacenados de manera responsable) o seguro (safety) pero inseguro (censurado pero susceptible a hacking). Los marcos más robustos abordan ambos frentes simultáneamente.

Controles Compartidos

En esta zona de convergencia, ciertos mecanismos protegen tanto la infraestructura como la calidad de la salida:

- Control de acceso basado en roles (RBAC)

- Detección de inyección SQL

- Manejo de solicitudes con barreras y filtros de moderación de contenido

| Área de Superposición | Control Ejemplo | Propósito |

|---|---|---|

| Validación de Entrada | Saneamiento de solicitudes | Prevenir inyección o fuga de información sensible |

| Control de Acceso | RBAC / proxy inverso | Restringir herramientas y plugins del modelo |

| Revisión de Salida | Filtro posterior a la generación | Eliminar datos poco éticos o privados |

La intersección de la seguridad y la seguridad (safety) no es teórica — es operativa. Los entornos LLM más resilientes fusionan la gestión de accesos, el análisis de solicitudes y la moderación ética en un proceso continuo.

4. Seguridad LLM en la Práctica

En producción, la seguridad LLM implica una protección en capas — no sólo cifrar los datos, sino controlar cómo fluyen.

Cada llamada a la API, búsqueda vectorial o consulta de incrustaciones debe tratarse como un potencial vector de ataque.

Prácticas Fundamentales

- Protección continua de datos durante todo el ciclo de vida del modelo

- Registros de auditoría para una trazabilidad transparente

- Validación automatizada de cumplimiento integrada con monitoreo de actividad

La arquitectura a nivel de proxy de DataSunrise filtra y anonimiza las cargas útiles antes de que alcancen los puntos finales del modelo, asegurando que incluso los flujos de trabajo complejos de RAG o de ajuste fino se mantengan conformes y protegidos.

5. Seguridad (Safety) LLM en la Práctica

La seguridad (safety), a diferencia de la seguridad, a menudo se evalúa a posteriori. Pero los mecanismos proactivos de seguridad (safety) pueden detener la mayoría de los incidentes éticos o reputacionales antes de que ocurran.

Técnicas

- Aprendizaje por refuerzo (RLHF) para la adaptación ética

- Filtros de moderación de contexto para el control de las salidas

- Alineación de cumplimiento a través de diferentes jurisdicciones

- Enmascaramiento estático de datos para prevenir la exposición a entrenamientos dañinos

Ejemplo: Lógica de Filtrado de Salida

def moderation_layer(text):

if "hate speech" in text.lower():

return "Contenido bloqueado por seguridad"

return text

A través de una moderación en capas, las organizaciones pueden alinear el comportamiento de la IA con las normas sociales, culturales y legales — no como una reflexión posterior, sino como parte integral del proceso de entrenamiento y despliegue.

6. Hacia un Marco Unificado

La seguridad y la seguridad (safety) deben reforzarse mutuamente, no competir.

Una estrategia madura de gobernanza de la IA las integra en un solo hilo operativo — asegurando que el modelo sea técnicamente robusto y socialmente responsable al mismo tiempo.

Enfoque Unificado

- Análisis de comportamiento para la detección de anomalías y sesgos

- Registros de auditoría para la transparencia y trazabilidad

- Clasificación de datos para la gestión contextual de riesgos

| Capa | Objetivo de Seguridad | Objetivo de Seguridad (Safety) |

|---|---|---|

| Datos | Cifrado y Enmascaramiento | Datos de entrenamiento éticos |

| Modelo | Aislamiento y Control de Acceso | Alineación y Barreras de Seguridad |

| Salida | Registro y Validación | Filtros de Toxicidad y Transparencia |

Al unificar controles de seguridad y políticas éticas, las empresas crean sistemas de IA que no solo resisten presiones externas, sino que también mantienen valores humanos internamente.

Conclusión

La seguridad mantiene el modelo protegido del mundo.

La seguridad (safety) mantiene al mundo protegido del modelo.

Ambas dimensiones definen la credibilidad de cualquier sistema de IA.

Sólo cuando coexisten — armonizadas por políticas, monitoreo y automatización de cumplimiento — las empresas pueden desbloquear el pleno potencial de los LLM sin comprometer la privacidad, la integridad o la confianza.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración

Descargar Ahora

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora