Técnicas de Mitigación de Riesgos de GenAI

La IA generativa (GenAI) ha cambiado la forma en que las empresas interactúan con los datos. Estos modelos escriben contenido, generan código, resumen documentos y automatizan decisiones. Pero también plantean preocupaciones sobre la privacidad de los datos, la seguridad y el cumplimiento. El riesgo aumenta cuando los sistemas GenAI procesan datos sensibles o regulados sin los controles adecuados.

Este artículo explora las Técnicas de Mitigación de Riesgos de GenAI esenciales, incluyendo la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento de datos y otras protecciones fundamentales. Cada técnica cumple un papel específico en la reducción de la exposición a amenazas mientras permite la innovación.

Por qué GenAI Introduce Riesgos de Seguridad Únicos

A diferencia de los sistemas basados en reglas, GenAI aprende de grandes conjuntos de datos y utiliza un razonamiento probabilístico. Puede inferir relaciones, reconstruir datos privados y producir resultados que violan políticas internas. Estos problemas a menudo surgen debido a controles débiles en las solicitudes, entrenamiento en conjuntos de datos sin filtrar y una transparencia limitada sobre el comportamiento del modelo. Sin un registro o aplicación adecuados, esto se convierte en un vector de amenaza importante en entornos regulados.

Para obtener más información, consulte el Índice de IA de Stanford, que destaca los desafíos en la alineación del modelo y la transparencia de los datos.

Auditoría en Tiempo Real para la Visibilidad de Solicitudes y Datos

El monitoreo de actividad de base de datos en tiempo real ayuda a las organizaciones a rastrear las consultas de GenAI para asegurar el cumplimiento. Registra cada solicitud que toca la capa de datos, capturando consultas SQL, roles de usuario, direcciones IP y datos de sesión.

Esto es esencial al trabajar con herramientas como LangChain o la llamada de funciones de OpenAI, donde las consultas a la base de datos se generan dinámicamente. Por ejemplo:

SELECT full_name, email FROM customers WHERE preferences LIKE '%personal%';Esta consulta, cuando es activada por un LLM, puede ser registrada y revisada utilizando las mejores prácticas de registro de auditoría para detectar el acceso a datos sensibles. Garantiza la responsabilidad y respalda la respuesta a incidentes de seguridad.

Enmascaramiento Dinámico de Datos para Controlar la Salida

El enmascaramiento dinámico protege los datos sensibles incluso cuando son accedidos. Funciona en tiempo real, aplicando políticas contextuales que ocultan números de tarjetas de crédito, identificadores personales y más.

Ejemplo:

SELECT name, credit_card_number FROM payments;

-- resultado enmascarado: SELECT name, '****-****-****-1234'El enmascaramiento es crucial al integrar GenAI con bases de datos relacionales o almacenes vectoriales. Según las directrices del NIST sobre la seguridad de la IA, los controles dinámicos ayudan a garantizar que los LLM no puedan filtrar datos privados incluso si se concede acceso. Consulte también las directrices de IBM sobre la privacidad en la IA.

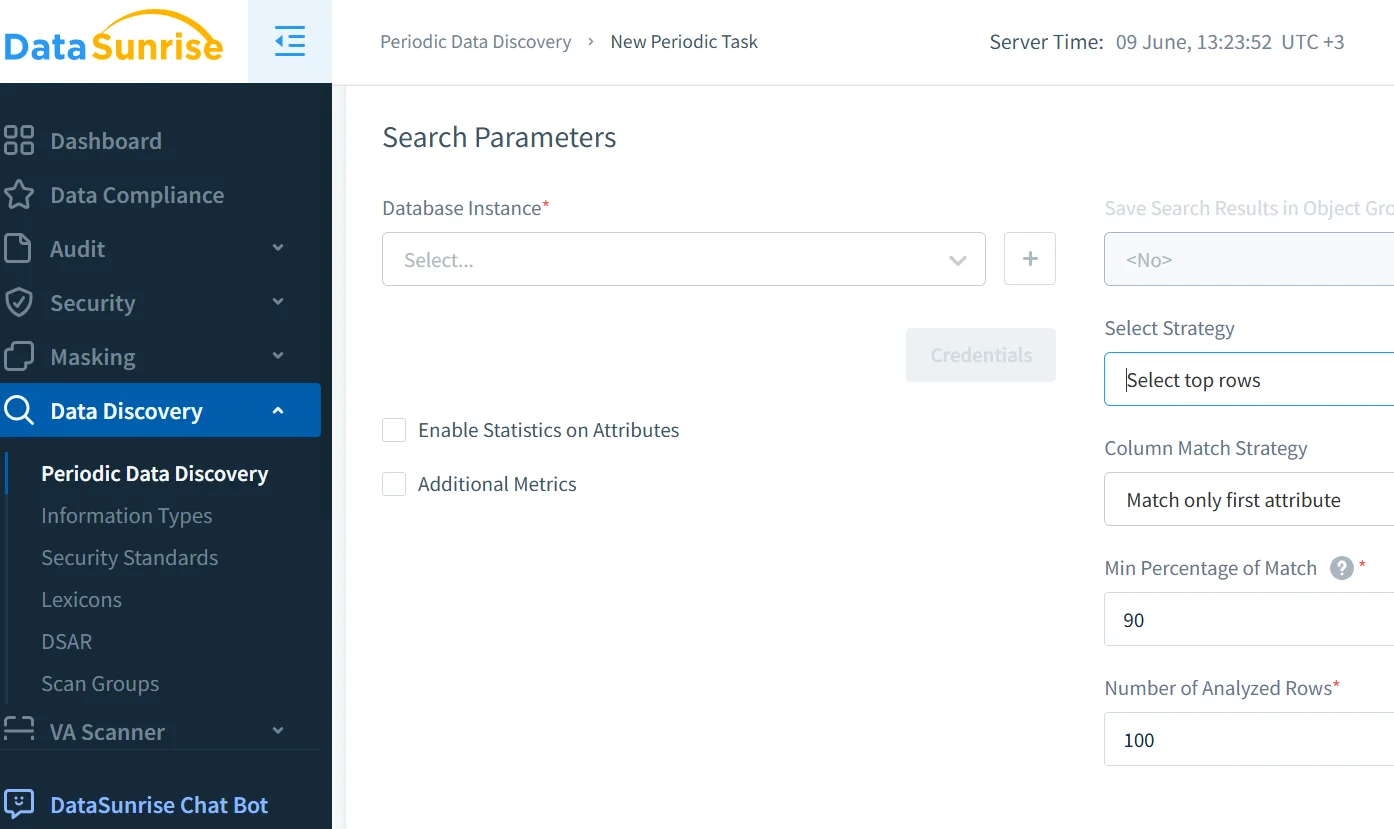

Descubrimiento y Clasificación de Datos Antes del Ajuste Fino

Antes de utilizar los datos en canalizaciones RAG o en el entrenamiento de GenAI, el descubrimiento de datos es clave. Identifica y etiqueta contenido regulado como PII, PHI y credenciales, previniendo exposiciones accidentales.

En combinación con la generación de datos sintéticos y las técnicas descritas por Google Cloud, esto permite operaciones de entrenamiento, ajuste fino y recuperación de datos más seguras.

Una clasificación adecuada ayuda a hacer cumplir las políticas de seguridad, activar las reglas de enmascaramiento y demostrar el cumplimiento de GDPR, HIPAA y PCI DSS. El Future of Privacy Forum también proporciona directrices sólidas sobre el uso responsable de datos en IA.

Cumplimiento y Gobernanza para Canalizaciones de IA

El cumplimiento para GenAI va más allá del registro: debe integrar evaluaciones continuas de riesgo, controles de acceso, enmascaramiento y aplicación automatizada.

El DataSunrise Compliance Manager soporta informes automatizados, una aplicación coherente de políticas y alertas en tiempo real. Se integra con herramientas externas para una observabilidad más amplia de riesgos y reduce el esfuerzo de preparación para auditorías. Otros marcos se detallan en los Principios de IA de la OCDE.

Capas de Seguridad Adaptadas para Canalizaciones de GenAI

Las defensas estándar, como los firewalls, son insuficientes. Los sistemas GenAI necesitan controles de acceso basados en roles (RBAC), protección contra inyección SQL y filtros basados en el comportamiento para inyección de solicitudes.

Considere alinear las defensas con el OWASP Top 10 para LLMs, que recomienda enmascarar salidas, validar entradas y aislar en entornos de prueba (sandboxing) los servicios de IA. También explore el Panorama de Amenazas de IA de ENISA para una visión integral de los riesgos.

Para entornos nativos en la nube, los proxies conscientes de la IA y los firewalls de bases de datos ayudan a proteger los puntos de entrada. El firewall de bases de datos de DataSunrise ofrece esta funcionalidad con soporte para más de 40 plataformas de datos.

Caso de Uso Ejemplo: Chatbot de Soporte al Cliente con RAG

Un chatbot de soporte utiliza la Generación Aumentada por Recuperación (RAG) para extraer datos del conocimiento interno y de registros de clientes basados en PostgreSQL. Si no se controla, podría revelar información personal sensible.

Al habilitar el enmascaramiento a nivel de SQL, registrar cada consulta del chatbot, escanear los datos de entrenamiento en busca de PII y clasificar las solicitudes en función del riesgo, la empresa mantiene el chatbot tanto receptivo como cumplidor.

Esto se alinea con el Estándar de IA Responsable de Microsoft y ayuda a garantizar la privacidad desde la concepción.

Conclusión: Técnicas de Mitigación de Riesgos de GenAI en la Práctica

Los sistemas modernos de IA necesitan más que confianza. Necesitan control. Al combinar auditoría, enmascaramiento, descubrimiento y gobernanza impulsada por políticas, las organizaciones reducen el riesgo de fugas de datos impulsadas por la IA y fallos en el cumplimiento.

Las técnicas efectivas de mitigación de riesgos de GenAI se integran en toda la pila, desde el filtrado de solicitudes hasta la aplicación de políticas en la base de datos, ofreciendo trazabilidad y defensa en tiempo real.

Para profundizar en las aplicaciones prácticas, visite:

- Análisis de Comportamiento

- Marco de Gestión de Riesgos de IA de NIST

- Herramientas de Seguridad y Monitoreo para LLM

- Marco de IA Segura de Google (SAIF)

- Prácticas de Protección de Datos

- Partnership on AI

- Base de Datos de Incidentes de IA

Con las prácticas adecuadas, GenAI puede impulsar la innovación de manera segura y responsable.