Visión General de Amenazas de Ciberseguridad de la IA

La IA Generativa (GenAI) está transformando la ciberseguridad. Estos modelos no solo analizan datos, sino que también los crean. Escriben textos, generan código y automatizan decisiones. Pero a medida que adquieren capacidades, también abren nuevas superficies de ataque. Desde la fuga de datos sensibles a través de la salida del modelo hasta ser explotados mediante inyecciones de comandos, GenAI introduce amenazas que las herramientas de seguridad tradicionales no abarcan completamente.

Este artículo proporciona una visión global de las amenazas de ciberseguridad de la IA y explica cómo la auditoría en tiempo real, el enmascaramiento dinámico, el descubrimiento de datos y las herramientas de cumplimiento pueden mitigar los riesgos asociados con los sistemas de GenAI.

Los riesgos de GenAI van más allá de las brechas de seguridad clásicas

A diferencia de las aplicaciones tradicionales, GenAI utiliza el lenguaje natural y la similitud basada en vectores para devolver contenido relevante. Esto significa que un modelo podría revelar inadvertidamente información confidencial si fue expuesto durante el entrenamiento o si un atacante formula el comando adecuado.

Por ejemplo, una consulta de búsqueda interna utilizando PostgreSQL con pgvector podría verse así:

SELECT * FROM documents

WHERE embedding <#> '[0.1, 0.5, 0.9, ...]'

ORDER BY similarity

LIMIT 1;

Si el vector representa un concepto sensible, el resultado podría ser un memorando interno privado. Sin reglas de enmascaramiento o auditoría implementadas, este acceso podría pasar desapercibido.

Otro ejemplo: si un chatbot interno utiliza LLM para generar respuestas basadas en datos SQL, un comando elaborado podría extraer más de lo esperado.

PROMPT: List recent customer transactions above $10,000

-- SQL generated by LLM --

SELECT customer_name, amount, transaction_date

FROM transactions

WHERE amount > 10000;

Si el acceso no está limitado o enmascarado, esto podría revelar información financiera de carácter personal (PII).

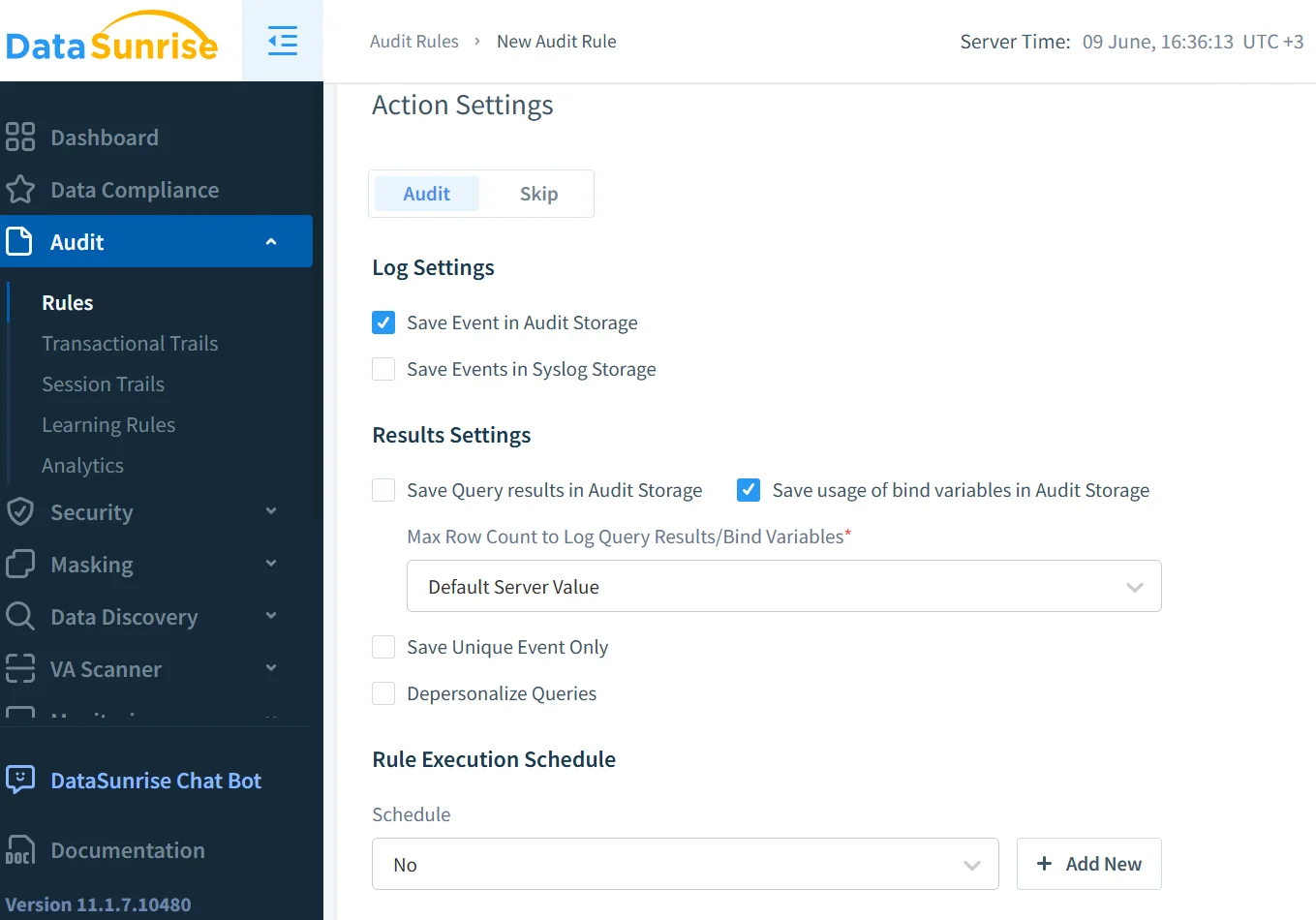

La auditoría en tiempo real ayuda a detectar amenazas instantáneamente

La auditoría en tiempo real es esencial en entornos de GenAI. Registra los accesos y alerta a los equipos de seguridad cuando se detecta un comportamiento sospechoso. Por ejemplo, un atacante podría sondear un modelo enviando comandos modificados repetidamente. Una solución de auditoría en tiempo real, como la descrita en los registros de auditoría de DataSunrise, permite a los equipos responder a tales amenazas a medida que ocurren.

Los datos de auditoría de comportamiento también pueden ayudar a rastrear cómo y cuándo se accedió a información sensible, aportando profundidad a la investigación forense de incidentes y a la generación de informes de cumplimiento. Consulte cómo Historial de Actividad de Datos construye esa visibilidad.

El enmascaramiento garantiza que los modelos no expongan lo que no deberían

Incluso el mejor registro de auditoría no puede prevenir la exposición; simplemente la documenta. Para evitar fugas accidentales, es necesario impedir que el contenido sensible aparezca en las respuestas del modelo. Ahí es donde entra en juego el enmascaramiento dinámico de datos.

El enmascaramiento dinámico intercepta y redacta los campos sensibles en el momento de la consulta. Por ejemplo, si un usuario solicita, “Muéstrame el historial médico de John,” y el modelo intenta devolver información de salud personal, el enmascaramiento dinámico asegura que los nombres, identificadores o campos de diagnóstico sean reemplazados u ocultos en la respuesta. Esto funciona especialmente bien cuando GenAI está integrado en sistemas de búsqueda empresarial o chatbots.

Una configuración de ejemplo de enmascaramiento en SQL podría ser:

CREATE MASKING POLICY mask_sensitive_fields

AS (val STRING)

RETURN CASE

WHEN CURRENT_ROLE IN ('admin') THEN val

ELSE '***MASKED***'

END;

El descubrimiento te mantiene a la vanguardia de riesgos desconocidos

Es difícil proteger lo que no sabes que tienes. Los sistemas GenAI pueden extraer datos de conjuntos ocultos, hojas de cálculo obsoletas o comparticiones en la nube llenas de PII. El descubrimiento de datos ayuda a identificar y clasificar tales fuentes de datos.

Una vez que el descubrimiento mapea los campos sensibles, las empresas pueden asignar reglas de enmascaramiento, auditoría y acceso a esos campos. Esto cierra el círculo: los datos descubiertos se convierten en datos gobernados. Además, previene que los modelos GenAI accedan accidentalmente a fuentes heredadas con controles débiles.

La inyección de comandos y el uso indebido requieren nuevas reglas de seguridad

La inyección de comandos es la nueva inyección de SQL. En lugar de penetrar en una base de datos, los atacantes intentan influir en el comportamiento del modelo alterando su entrada. GenAI puede ser manipulado para ignorar instrucciones, revelar secretos o ejecutar acciones no autorizadas.

Para mitigar esto, implemente reglas de seguridad que monitoreen el comportamiento de entrada y salida. Limitar la tasa de búsquedas vectoriales, emplear coincidencia de patrones para frases de abuso conocidas y bloquear el acceso a tablas o documentos específicos son métodos efectivos. Combinado con controles de acceso basados en roles, GenAI se vuelve mucho menos explotable.

Un sanitizador de respuestas típico podría aplicarse de la siguiente manera:

if 'SSN' in response:

response = response.replace(user_ssn, '***')

El cumplimiento no es opcional: es un requisito del sistema

GenAI debe operar dentro de límites legales y éticos. Ya sea que su empresa esté sujeta a GDPR, HIPAA o PCI DSS, las reglas de cumplimiento dictan cómo se usa, almacena y registra la información sensible.

Compliance Manager automatiza la vinculación entre las regulaciones y los controles técnicos. Puede vincular reglas de enmascaramiento a los campos de PCI, hacer cumplir políticas de auditoría para registros sujetos a HIPAA y generar documentación que demuestre una adhesión continua.

El cumplimiento no se trata solo de evitar multas. Se trata de generar confianza en los sistemas de IA que actúan responsablemente con los datos que se les proporcionan.

La visibilidad a lo largo de la pila es clave

Para una discusión más amplia sobre cómo la seguridad de los LLM impacta en la infraestructura, consulte la perspectiva del MIT sobre la inyección de comandos y los riesgos de los modelos base. Los riesgos se extienden más allá de los casos de uso empresariales, afectando modelos de código abierto, conjuntos académicos de datos y prácticas públicas de web scraping.

Además, el artículo del Stanford HAI sobre Pruebas en Equipo Rojo para Modelos de Lenguaje muestra cómo los investigadores evalúan los sistemas de IA en busca de fallas éticas y de seguridad, ofreciendo una perspectiva útil para moldear la política corporativa de GenAI.

El futuro de la ciberseguridad con IA reside en la correlación. La auditoría en tiempo real muestra quién hizo qué. El enmascaramiento muestra lo que vieron. El descubrimiento indica dónde residen los datos. Las reglas de seguridad previenen abusos. El cumplimiento lo une todo.

Un sistema GenAI se vuelve seguro solo cuando estas herramientas comparten contexto. Por ello, la seguridad inspirada en los datos—donde las decisiones de seguridad reflejan la clasificación de la información, el rol empresarial y los patrones de uso—es el futuro.

Con este modelo, la innovación y el cumplimiento pueden coexistir, permitiendo que GenAI funcione sin comprometer la integridad de los datos que toca.