Menaces et Risques de Sécurité liés à l’IA

L’intelligence artificielle est devenue un pilier central de la technologie d’entreprise moderne — optimisant les décisions, détectant la fraude et permettant l’analyse en temps réel dans plusieurs secteurs.

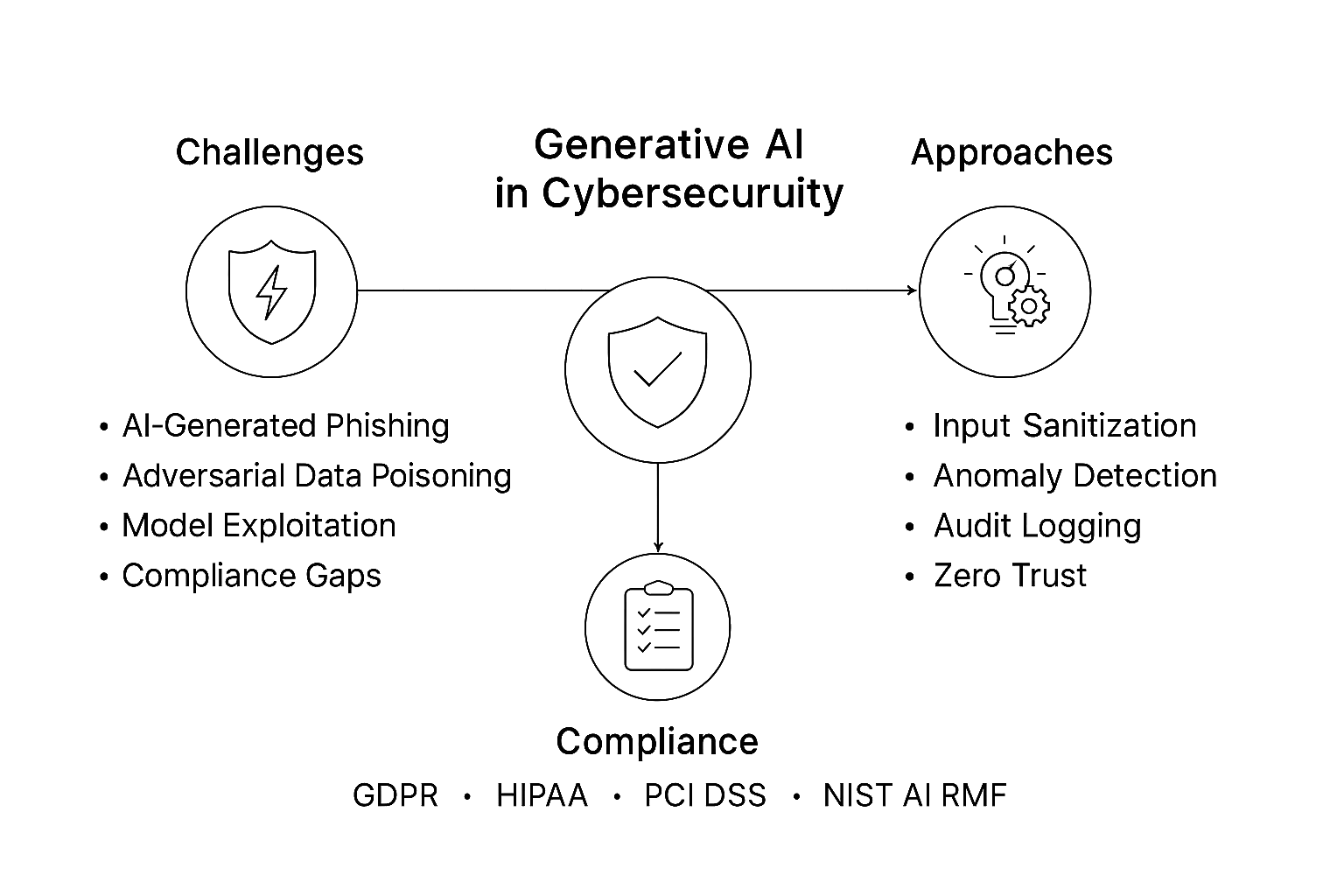

Cependant, à mesure que les systèmes d’IA gagnent en complexité et en autonomie, les menaces liées à l’IA et les surfaces d’attaque augmentent également. Les adversaires ont commencé à s’armer de l’IA elle-même, utilisant des modèles génératifs, un entraînement adversarial et des techniques d’exploitation automatisées pour devancer les défenseurs humains.

Aujourd’hui, de plus en plus d’organisations font face à de nouvelles catégories de risques cyber directement liées à l’adoption de l’IA. De la manipulation de modèles à l’extraction de données, les avantages de l’IA peuvent facilement devenir des vulnérabilités lorsqu’ils ne sont pas protégés.

Comprendre les Menaces liées à l’IA

Les systèmes d’IA traitent d’énormes ensembles de données, s’adaptent de manière autonome et prennent des décisions à fort impact — des attributs qui les rendent également attractifs pour les attaquants.

Les menaces peuvent survenir à chaque étape du cycle de vie de l’IA : de l’ingestion de données à l’inférence du modèle.

1. Empoisonnement des Données

Les modèles d’IA apprennent à partir des données qu’ils reçoivent. Des ensembles de données empoisonnés — contenant des échantillons manipulés ou mal étiquetés — peuvent modifier les frontières de décision d’un modèle.

Dans la détection d’intrusions, cela peut faire apparaître une activité malveillante comme bénigne. Même une contamination mineure peut réduire significativement la précision, un phénomène souvent invisible jusqu’à son exploitation en production.

2. Inversion et Extraction de Modèle

Lorsque des utilisateurs interroge un modèle déployé de manière répétée, ils peuvent en déduire des schémas qui révèlent des données internes ou des paramètres.

Des attaquants ont reconstruit des ensembles de données propriétaires et des attributs sensibles (comme des détails médicaux ou des indicateurs financiers) uniquement à partir des réponses du modèle — réalisant ainsi une espionnage par IA.

3. Exemples Adversariaux

De petites perturbations minutieusement conçues dans les entrées — telles que des modifications imperceptibles de pixels ou des embeddings modifiés — peuvent tromper complètement les systèmes d’IA.

Une voiture autonome pourrait mal interpréter un panneau stop comme une limitation de vitesse, ou un détecteur de fraude pourrait classifier des transactions suspectes comme normales. Ces exploits ne nécessitent aucun accès au code, seulement à l’interface exposée du modèle.

4. Deepfakes Génératifs

Les modèles de génération de texte, image et voix sont utilisés pour fabriquer des identités, diffuser de la désinformation et mener des campagnes d’ingénierie sociale à grande échelle.

Associés à des systèmes de diffusion automatisés, les deepfakes créent des attaques de phishing ou d’usurpation très convaincantes qui contournent les filtres traditionnels.

5. Exploitation d’Agents Autonomes

Les agents IA capables d’exécuter des commandes, planifier des actions ou accéder aux API peuvent être manipulés pour effectuer des opérations nuisibles.

Des invites malveillantes, connues sous le nom d’injections de prompt, peuvent contourner les règles, provoquer des fuites de données ou exécuter des flux de travail non autorisés via une manipulation indirecte.

Solutions Techniques pour la Sécurité de l’IA

Protéger les systèmes d’IA nécessite une fusion entre la discipline classique de cybersécurité et une intelligence machine adaptative. La conception défensive commence au niveau des données et s’étend à la surveillance et à l’audit continus.

1. Validation de l’Intégrité des Données

Avant l’entraînement, chaque ensemble de données doit être vérifié pour son authenticité et son intégrité.

L’extrait ci-dessous illustre une méthode de validation basée sur le hachage pour garantir que seules les données approuvées entrent dans le pipeline.

import hashlib

import os

def verify_dataset(path: str, expected_hash: str) -> bool:

"""Valide l’intégrité du jeu de données en utilisant SHA-256."""

if not os.path.exists(path):

raise FileNotFoundError("Jeu de données introuvable")

hasher = hashlib.sha256()

with open(path, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

hasher.update(chunk)

return hasher.hexdigest() == expected_hash

# Exemple d’utilisation

if not verify_dataset("train.csv", "a91b...c2d"):

raise ValueError("Intégrité du jeu de données compromise !")

En enregistrant les empreintes des jeux de données dans des journaux d’audit, les organisations peuvent détecter les altérations tôt — bien avant que des échantillons empoisonnés n’atteignent les modèles en production.

2. Entraînement Défensif Adversarial

La meilleure façon de se défendre contre des entrées adversariales est d’apprendre à partir d’elles.

Les équipes IA peuvent générer intentionnellement des perturbations et réentraîner les modèles pour améliorer leur robustesse.

import numpy as np

def adversarial_noise(x, epsilon=0.01):

"""Ajoute de petites perturbations pour simuler des attaques adversariales."""

noise = epsilon * np.sign(np.random.randn(*x.shape))

return np.clip(x + noise, 0, 1)

# Exemple : augmenter les données d’entraînement avec du bruit

x_train_adv = adversarial_noise(x_train)

model.fit(x_train_adv, y_train)

Cette exposition contrôlée renforce les modèles contre les attaques réelles et complète les systèmes d’analyse comportementale qui suivent les anomalies dans les requêtes d’inférences.

3. Audit Continu et Explicabilité

Les cadres d’IA explicable (XAI) combinés à des journaux immuables permettent aux enquêteurs de reconstruire les décisions prises — et les raisons.

Enregistrer chaque événement d’inférence offre à la fois transparence opérationnelle et documentation de conformité.

import datetime, json

def log_inference(user, input_summary, prediction):

timestamp = datetime.datetime.utcnow().isoformat()

entry = {"time": timestamp, "user": user, "input": input_summary, "prediction": prediction}

print(json.dumps(entry))

log_inference("analyst01", "tentative de connexion depuis une IP inconnue", "signalé_suspicieux")

Ces enregistrements d’audit peuvent être corrélés avec la surveillance de l’activité des bases de données pour détecter des anomalies inter-systèmes — reliant la logique décisionnelle IA aux traces backend des transactions.

Stratégies Organisationnelles pour Gérer les Risques liés à l’IA

La technologie ne suffit pas sans une gouvernance structurée. La gestion des risques liés à l’IA doit être intégrée dans la politique d’entreprise, les flux de travail d’ingénierie et les rapports de conformité.

1. Établir des Cadres de Gestion des Risques IA

Adoptez des cadres alignés sur le NIST AI RMF ou les directives du paysage des menaces IA d’ENISA.

Ils aident à définir des responsabilités claires à travers les équipes — data scientists, DevOps, responsables conformité — assurant qu’un contrôle cohérent des risques et des modifications soit appliqué à chaque composant IA.

2. Sécuriser les Chaînes d’Approvisionnement IA

Les pipelines IA dépendent de données tierces, de modèles pré-entraînés et de dépendances open source.

Tous les artefacts doivent être vérifiés par signature cryptographique et tracés via des journaux de provenance immuables.

Une seule bibliothèque compromise peut infecter tout l’environnement d’inférence — à l’image des attaques sur la chaîne d’approvisionnement vues dans le DevOps traditionnel.

3. Intégrer des Équipes Red-Team et Blue-Team

Le red teaming IA consiste à attaquer vos propres modèles avant que les adversaires ne le fassent.

En exécutant des simulations d’invites d’exploitation, des tentatives d’extraction de modèle et des entrées adversariales, les organisations identifient tôt les points faibles.

Les équipes bleues adaptent ensuite les règles de sécurité et les plans de réponse en conséquence.

4. Mettre en Place des Contrôles d’Accès Contextuels

Les systèmes d’IA accédant aux bases de données de production doivent fonctionner selon le principe du moindre privilège.

Intégrez le contrôle d’accès basé sur les rôles avec des signaux de risque contextuels — localisation de l’utilisateur, comportement de la session et type de requête — pour restreindre dynamiquement l’accès aux ensembles de données sensibles.

La Dimension Conformité

Les exigences réglementaires convergent vers la responsabilité en matière d’IA — garantissant que les systèmes soient à la fois explicables et sécurisés.

Le non-respect ne signifie plus seulement des amendes ; il peut interrompre les opérations dans des secteurs régulés comme la santé ou la finance.

| Règlementation | Focus Sécurité IA | Contrôle Recommandé |

|---|---|---|

| RGPD | Transparence dans la prise de décision automatisée | Maintenir des modèles explicables avec des pistes d’audit complètes |

| HIPAA | Protection des informations de santé protégées (PHI) utilisées en diagnostic IA | Mettre en œuvre le [masquage dynamique](https://www.datasunrise.com/knowledge-center/dynamic-data-masking/) et le chiffrement |

| PCI DSS 4.0 | Modèles IA analysant les données de paiement | Appliquer la tokenisation et la segmentation des accès |

| SOX | Responsabilité des modèles financiers | Utiliser des [pistes d’audit](https://www.datasunrise.com/knowledge-center/audit-trails/) et des journaux immuables pour la traçabilité |

| NIST AI RMF | Documentation des risques et de la provenance | Déployer une [découverte de données](https://www.datasunrise.com/knowledge-center/data-discovery/) continue et une validation de l’intégrité |

Une stratégie de conformité forte en IA réduit non seulement l’exposition aux risques mais renforce aussi la confiance des régulateurs, clients et investisseurs — prouvant que l’IA peut être à la fois innovante et responsable.

Conclusion : Construire des Systèmes d’IA Résilients

Les menaces liées à l’IA continueront d’évoluer aussi rapidement que la technologie elle-même.

Les attaquants ne se contentent plus de pénétrer les réseaux — ils corrompent les algorithmes, manipulent les données et exploitent les faiblesses cognitives des interactions homme-machine.

Se défendre contre ces risques requiert une posture de sécurité en couches multiples :

- Prévention — valider les données et sécuriser la chaîne d’approvisionnement

- Détection — surveiller les comportements à l’aide de modèles adaptatifs et génératifs

- Réponse — maintenir des journaux immuables et l’explicabilité pour les audits

- Gouvernance — s’aligner sur les cadres de conformité mondiaux et les normes éthiques

L’IA restera à la fois une arme et un bouclier. Les organisations qui prospéreront seront celles qui la traiteront en ce double sens — construisant des systèmes capables de anticiper, résister et évoluer plus rapidement que les menaces qu’elles affrontent.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant