KI-Bedrohungen und Sicherheitsrisiken

Künstliche Intelligenz hat sich zu einem zentralen Pfeiler moderner Unternehmestechnologie entwickelt – sie optimiert Entscheidungen, erkennt Betrug und ermöglicht Echtzeitanalysen in verschiedensten Branchen.

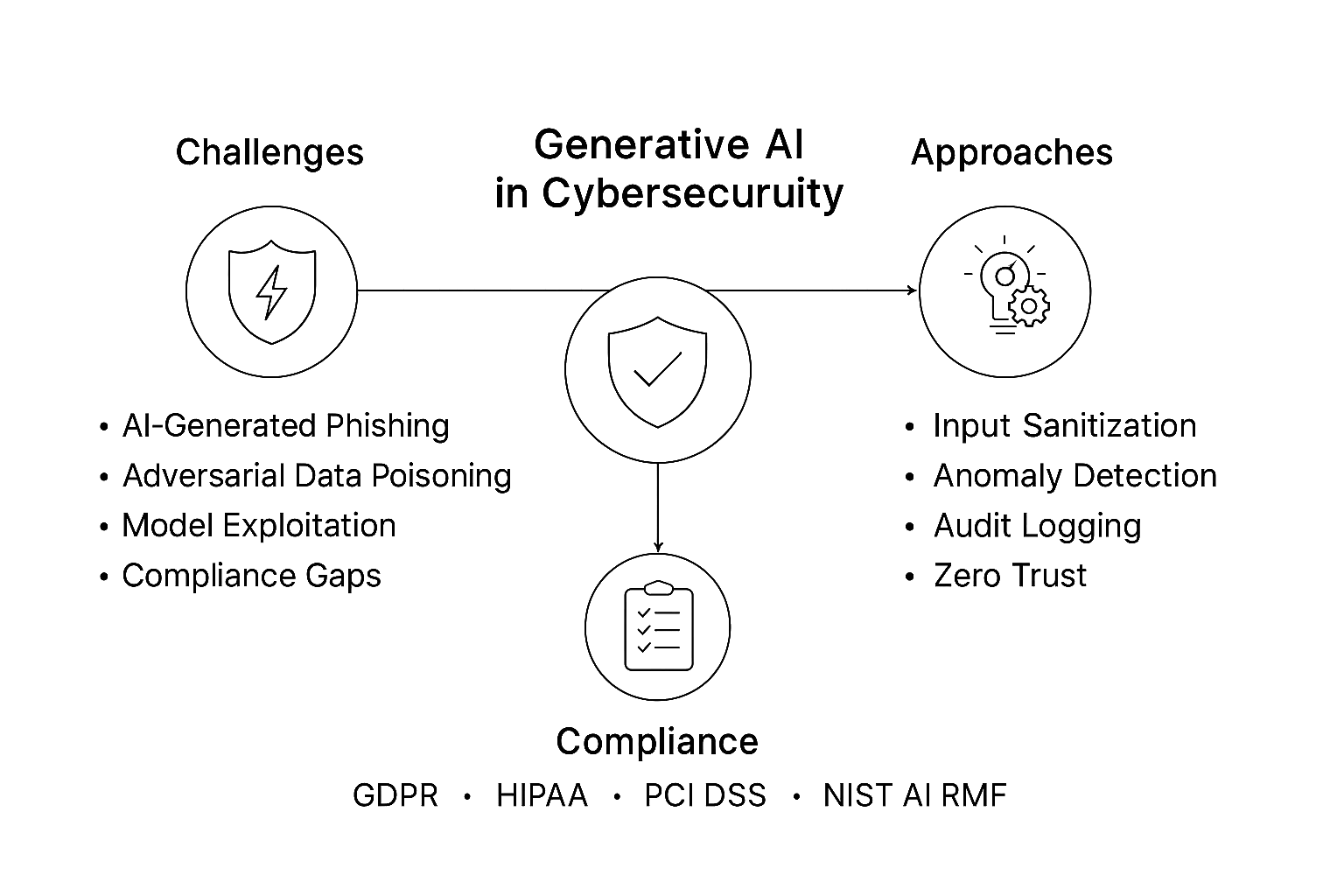

Doch mit der zunehmenden Komplexität und Autonomie der KI-Systeme wachsen auch die KI-Bedrohungen und die Angriffsflächen. Gegner haben begonnen, die KI selbst zu instrumentalisieren, indem sie generative Modelle, adversariales Training und automatisierte Ausnutzungstechniken einsetzen, um menschliche Verteidiger zu übertreffen.

Heutzutage sehen sich immer mehr Organisationen neuen Kategorien von Cyberrisiken gegenüber, die direkt mit der Einführung von KI verbunden sind. Von der Manipulation von Modellen bis hin zur Datenauslesung können sich die Vorteile der KI leicht in Schwachstellen verwandeln, wenn sie ungeschützt bleiben.

Verständnis der KI-Bedrohungen

KI-Systeme verarbeiten massive Datensätze, passen sich autonom an und treffen Entscheidungen mit hohem Einfluss – Eigenschaften, die sie auch für Angreifer attraktiv machen.

Bedrohungen können in jedem Stadium des KI-Lebenszyklus auftreten: von der Datenerfassung bis zur Modellauswertung.

1. Datenvergiftung

KI-Modelle lernen aus den Daten, die ihnen zur Verfügung stehen. Vergiftete Datensätze – die manipulierte oder falsch etikettierte Proben enthalten – können die Entscheidungsgrenzen eines Modells verändern.

Im Bereich der Intrusionserkennung könnte dies dazu führen, dass bösartige Aktivitäten als unbedenklich erscheinen. Selbst geringfügige Verunreinigungen können die Genauigkeit erheblich vermindern, ein Phänomen, das oft erst in der Produktion erkennbar wird, wenn es ausgenutzt wird.

2. Modellinversion und -extraktion

Wenn Benutzer ein bereitgestelltes Modell wiederholt abfragen, können sie Muster erkennen, die interne Daten oder Parameter offenbaren.

Angreifer haben proprietäre Datensätze und sensible Attribute (wie medizinische Details oder finanzielle Indikatoren) allein anhand von Modellantworten rekonstruiert – und damit effektiv KI-Spionage betrieben.

3. Adversariale Beispiele

Kleine, sorgfältig konzipierte Störungen in den Eingaben – wie unmerkliche Pixeländerungen oder modifizierte Einbettungen – können KI-Systeme vollständig täuschen.

Ein autonomes Fahrzeug könnte ein Stoppschild fälschlicherweise als Geschwindigkeitsbegrenzung interpretieren, oder ein Betrugserkennungssystem könnte verdächtige Transaktionen als unbedenklich einstufen. Diese Ausnutzungen erfordern keinen Zugriff auf den Code, sondern lediglich auf die freigelegte Schnittstelle des Modells.

4. Generative Deepfakes

Text-, Bild- und Stimmengenerierungsmodelle werden eingesetzt, um Identitäten zu fälschen, Desinformationen zu verbreiten und Social-Engineering-Kampagnen im großen Stil durchzuführen.

In Kombination mit automatisierten Liefersystemen erzeugen Deepfakes hochgradig überzeugende Phishing- oder Identitätsanmaßungsangriffe, die traditionelle Filter umgehen.

5. Ausnutzung autonomer Agenten

KI-Agenten, die in der Lage sind, Befehle auszuführen, Aktionen zu planen oder auf APIs zuzugreifen, können dazu manipuliert werden, schädliche Operationen durchzuführen.

Bösartige Eingabeaufforderungen, bekannt als Prompt-Injections, können Regeln außer Kraft setzen, Datenlecks auslösen oder unautorisierte Arbeitsabläufe durch indirekte Manipulation bewirken.

Technische Lösungen für KI-Sicherheit

Der Schutz von KI-Systemen erfordert eine Verschmelzung klassischer Cybersicherheitsdisziplin mit adaptiver maschineller Intelligenz. Das defensive Design beginnt auf der Datenschicht und erstreckt sich auf kontinuierliche Überwachung und Audits.

1. Validierung der Datenintegrität

Vor dem Training muss jeder Datensatz auf Authentizität und Integrität geprüft werden.

Der untenstehende Codeausschnitt veranschaulicht eine hash-basierte Validierungsmethode, um sicherzustellen, dass nur freigegebene Daten in die Pipeline gelangen.

import hashlib

import os

def verify_dataset(path: str, expected_hash: str) -> bool:

"""Validiert die Integrität des Datensatzes mittels SHA-256."""

if not os.path.exists(path):

raise FileNotFoundError("Datensatz nicht gefunden")

hasher = hashlib.sha256()

with open(path, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

hasher.update(chunk)

return hasher.hexdigest() == expected_hash

# Beispielhafte Verwendung

if not verify_dataset("train.csv", "a91b...c2d"):

raise ValueError("Datensatzintegrität wurde kompromittiert!")

Durch die Aufzeichnung von Datensatz-Fingerabdrücken in Prüfprotokollen können Organisationen Manipulationen frühzeitig erkennen – und das lange bevor vergiftete Proben Produktionsmodelle erreichen.

2. Defensives adversariales Training

Der beste Weg, sich gegen adversariale Eingaben zu verteidigen, besteht darin, aus ihnen zu lernen.

KI-Teams können gezielt Störungen erzeugen und Modelle neu trainieren, um deren Robustheit zu verbessern.

import numpy as np

def adversarial_noise(x, epsilon=0.01):

"""Fügt kleine Störungen hinzu, um gegnerische Angriffe zu simulieren."""

noise = epsilon * np.sign(np.random.randn(*x.shape))

return np.clip(x + noise, 0, 1)

# Beispiel: Trainingsdaten mit Rauschen erweitern

x_train_adv = adversarial_noise(x_train)

model.fit(x_train_adv, y_train)

Diese kontrollierte Exposition stärkt die Modelle gegen reale Angriffe und ergänzt Verhaltensanalyse-Systeme, die Anomalien in Inferenzanfragen überwachen.

3. Kontinuierliche Prüfung und Erklärbarkeit

Erklärbare KI (XAI)-Rahmenwerke, kombiniert mit unveränderlichen Protokollen, ermöglichen es Ermittlern, nachzuvollziehen, welche Entscheidungen getroffen wurden – und warum.

Die Aufzeichnung jedes Inferenzereignisses bietet sowohl operationelle Transparenz als auch Compliance-Dokumentation.

import datetime, json

def log_inference(user, input_summary, prediction):

timestamp = datetime.datetime.utcnow().isoformat()

entry = {"time": timestamp, "user": user, "input": input_summary, "prediction": prediction}

print(json.dumps(entry))

log_inference("analyst01", "Login-Versuch von unbekannter IP", "flagged_suspicious")

Diese Prüfprotokolle können mit Datenbank-Aktivitätsüberwachung korreliert werden, um systemübergreifende Anomalien aufzudecken – und so die KI-Entscheidungslogik mit den Transaktionspfaden im Backend zu verbinden.

Organisatorische Strategien zur Bewältigung von KI-Risiken

Technologie allein reicht nicht aus, ohne eine strukturierte Governance. Das KI-Risikomanagement muss in die Unternehmenspolitik, die Engineering-Workflows und die Compliance-Berichterstattung eingebettet sein.

1. Etablierung von KI-Risikorahmenwerken

Übernehmen Sie Rahmenwerke, die mit NIST AI RMF oder den ENISA-Richtlinien zur KI-Bedrohungslandschaft übereinstimmen.

Diese helfen dabei, klare Verantwortlichkeiten über Teams – Datenwissenschaftler, DevOps, Compliance-Beauftragte – hinweg festzulegen, sodass jede KI-Komponente einer konsistenten Risikobewertung und Änderungssteuerung unterzogen wird.

2. Sicherung der KI-Lieferketten

KI-Pipelines sind auf Drittanbieterdaten, vortrainierte Modelle und Open-Source-Abhängigkeiten angewiesen.

Alle Artefakte sollten mittels kryptografischer Signaturen überprüft und über unveränderliche Herkunftsprotokolle nachverfolgt werden.

Eine einzelne kompromittierte Bibliothek kann die gesamte Inferenzumgebung infizieren – ähnlich wie bei Lieferkettenangriffen in traditionellen DevOps.

3. Integration von Red-Team und Blue-Team

Das Red-Teaming von KI bedeutet, eigene Modelle anzugreifen, bevor es Angreifer tun.

Durch das Durchführen simulierter Exploit-Aufforderungen, Modellentnahme-Versuche und adversarieller Eingaben identifizieren Organisationen frühzeitig Schwachstellen.

Anschließend passen Blue-Teams Sicherheitsregeln und Reaktionsstrategien entsprechend an.

4. Implementierung kontextabhängiger Zugriffskontrollen

KI-Systeme, die auf Produktionsdatenbanken zugreifen, sollten nach dem Prinzip der minimalen Rechte operieren.

Integrieren Sie rollenbasierte Zugriffskontrollen mit kontextuellen Risikosignalen – wie Nutzerstandort, Sitzungsverhalten und Abfragetyp – um den Zugriff auf sensible Datensätze dynamisch einzuschränken.

Die Dimension der Compliance

Regulatorische Anforderungen konvergieren hin zu mehr Rechenschaftspflicht in der KI – um sicherzustellen, dass Systeme sowohl erklärbar als auch sicher sind.

Nichteinhaltung bedeutet heute nicht mehr nur Bußgelder; sie kann den Betrieb in regulierten Sektoren wie Gesundheitswesen oder Finanzen zum Erliegen bringen.

| Regulierung | KI-Sicherheitsfokus | Empfohlene Maßnahme |

|---|---|---|

| GDPR | Transparenz bei automatisierten Entscheidungsprozessen | Erhalt erklärenbarer Modelle mit vollständigen Prüfprotokollen |

| HIPAA | Schutz der in der KI-Diagnostik verwendeten PHI | Implementieren Sie [dynamisches Maskieren](https://www.datasunrise.com/knowledge-center/dynamic-data-masking/) und Verschlüsselung |

| PCI DSS 4.0 | KI-Modelle, die Zahlungsdaten analysieren | Setzen Sie Tokenisierung und Zugriffstrennung ein |

| SOX | Rechenschaftspflicht bei Finanzmodellen | Verwenden Sie [Prüfprotokolle](https://www.datasunrise.com/knowledge-center/audit-trails/) und unveränderliche Logs zur Rückverfolgbarkeit |

| NIST AI RMF | Risiko- und Herkunftsdokumentation | Setzen Sie kontinuierliche [Datenerkennung](https://www.datasunrise.com/knowledge-center/data-discovery/) und Integritätsvalidierung ein |

Eine starke KI-Compliance-Strategie reduziert nicht nur das Risikoprofil, sondern schafft auch Vertrauen bei Aufsichtsbehörden, Kunden und Investoren – und beweist, dass KI sowohl innovativ als auch verantwortungsvoll sein kann.

Fazit: Aufbau resilienter KI-Systeme

KI-Bedrohungen werden sich so schnell weiterentwickeln wie die Technologie selbst.

Angreifer dringen heute nicht mehr nur in Netzwerke ein – sie manipulieren Algorithmen, verfälschen Daten und nutzen kognitive Schwächen in der Mensch-Maschine-Interaktion aus.

Die Verteidigung gegen diese Risiken erfordert eine mehrschichtige Sicherheitsstrategie:

- Prävention – Daten validieren und die Lieferkette absichern

- Erkennung – Verhaltensmuster mit adaptiven und generativen Modellen überwachen

- Reaktion – Unveränderliche Logs und Erklärbarkeit für Audits aufrechterhalten

- Governance – Mit globalen Compliance-Rahmenwerken und ethischen Standards in Einklang bringen

KI wird sowohl Waffe als auch Schild bleiben. Die Organisationen, die erfolgreich sind, werden diejenigen sein, die sie als beides betrachten – Systeme entwickeln, die den Bedrohungen vorausdenken, widerstehen und sich schneller weiterentwickeln als die Angriffe, denen sie ausgesetzt sind.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen