LLM-Sicherheitsbestpraktiken

Da große Sprachmodelle (LLMs) tief in Unternehmensabläufe integriert werden – vom Kundensupport bis hin zur Code-Generierung – vergrößern sie gleichzeitig die Angriffsfläche moderner Organisationen. Sicherheitsteams sehen sich mit Herausforderungen konfrontiert, die sich von herkömmlichen Cybersecurity-Bedrohungen unterscheiden: Modellmanipulation, Datenlecks durch Eingabeaufforderungen und die Offenlegung von Trainingsdatensätzen. Das Verständnis und die Anwendung bewährter LLM-Sicherheitspraktiken sind unerlässlich, um sowohl die Infrastruktur als auch sensible Informationen zu schützen.

Für eine breitere Perspektive auf KI-bezogene Risiken siehe KI-Cyberangriffe und verwandte Forschungen zur Datensicherheit.

Die Risiken von LLMs verstehen

LLMs verarbeiten umfangreiche Datensätze, die manchmal proprietäre oder regulierte Informationen enthalten. Ihre Exponierung gegenüber unzuverlässigen Eingaben oder externen Nutzern kann mehrere Angriffsvektoren einführen:

- Prompt-Injection-Angriffe: Böswillige Nutzer betten versteckte Befehle ein, um Modellregeln außer Kraft zu setzen oder auf eingeschränkte Daten zuzugreifen.

- Model Inversion und Extraktion: Angreifer rekonstruieren durch wiederholte Abfragen sensible Trainingsdaten oder Modellgewichte.

- Datenleck über Ausgaben: Modelle geben unbeabsichtigt vertrauliche Informationen preis, insbesondere wenn sie auf internen Daten feinabgestimmt wurden.

- Manipulierte Trainingsdaten: Kompromittierte Datensätze können zu Hintertüren führen, die auch nach der Bereitstellung fortbestehen.

Diese Schwachstellen verdeutlichen, warum die Sicherheit von LLMs über herkömmliche Datenbanksicherheit hinausgeht. Sie erfordert kontinuierliche Überwachung, Verschlüsselung und Verhaltensanalysen in jeder Phase des KI-Lebenszyklus.

Zentrale LLM-Sicherheitsbestpraktiken

1. Starke Zugriffskontrollen implementieren

Setzen Sie rollenbasierte Zugriffskontrolle (RBAC) durch, um zu begrenzen, wer Modelle abfragen oder feinabstimmen darf. Die Segmentierung von Berechtigungen stellt sicher, dass administrative Aktionen, Protokollierung von Eingabeaufforderungen und Abruf von Ausgaben ausschließlich autorisierten Nutzern vorbehalten bleiben. Weitere Details finden Sie unter Rollenbasierte Zugriffskontrolle.

2. Datenmaskierung und -bereinigung einsetzen

Implementieren Sie vor dem Eintreffen der Nutzerdaten im Modell eine dynamische Datenmaskierung, um Kennungen, persönliche Daten und sensible Felder zu verbergen. Bei der Ausgabe verhindert die statische Maskierung die Offenlegung von Informationen während der Nachbearbeitung. Die Datenmaskierungsfunktionen von DataSunrise unterstützen diesen Schritt sowohl für strukturierte als auch unstrukturierte Daten.

3. Kontinuierliche Überwachung und Auditierung anwenden

Behalten Sie die vollständige Übersicht über Modellaktivitäten und Abfragehistorien mit Hilfe von Echtzeit-Datenbankaktivitätsüberwachung. Audit-Protokolle bieten einen unveränderlichen Nachweis der Interaktionen und unterstützen Compliance-Audits unter Rahmenwerken wie DSGVO, HIPAA und PCI DSS. Die Audit-Trails und der Compliance Manager von DataSunrise vereinfachen diesen Prozess durch automatisierte Evidenzerstellung.

4. Das Prinzip der minimalen Rechte anwenden

Stellen Sie sicher, dass sowohl Systeme als auch Personal nach dem Prinzip der minimalen Rechte (PoLP) arbeiten. Dies minimiert den Schaden durch Missbrauch von Insiderrechten oder kompromittierten Zugangsdaten. Erfahren Sie mehr unter Prinzip der minimalen Rechte.

5. Die Integrität der Trainingsdaten schützen

Schützen Sie sich vor Datenvergiftung, indem Sie eine Validierung der Datenherkunft und kryptographische Integritätsprüfungen durchsetzen. Die Hash-Verifizierung während der Aufnahme verhindert unbefugte Änderungen an den Datensätzen. Zur zusätzlichen Absicherung sollten verschlüsselte Trainingsarchive unter Einsatz von Datenbankverschlüsselung gepflegt werden.

6. Modell-APIs und Endpunkte absichern

LLM-APIs müssen eine strikte Authentifizierung und Ratenbegrenzung durchsetzen, um Brute-Force-Extraktionen oder adversariales Testen zu verhindern. Nutzen Sie Endpunkt-Firewalls, tokenbasierte Verifizierung und Anomalieerkennung bei API-Aufrufhäufigkeiten und -mustern.

7. Modellverhalten und Drift überwachen

Setzen Sie Machine-Learning-Audit-Regeln ein, um Abweichungen in den Modellausgaben zu kennzeichnen, die auf Datenvergiftung oder unautorisierte Feinabstimmung hindeuten könnten. Diese Regeln vergleichen kontinuierlich die Inferenz-Ergebnisse mit den Basis-Erwartungen und identifizieren frühzeitig Anomalien.

8. Regulierungskonformität sicherstellen

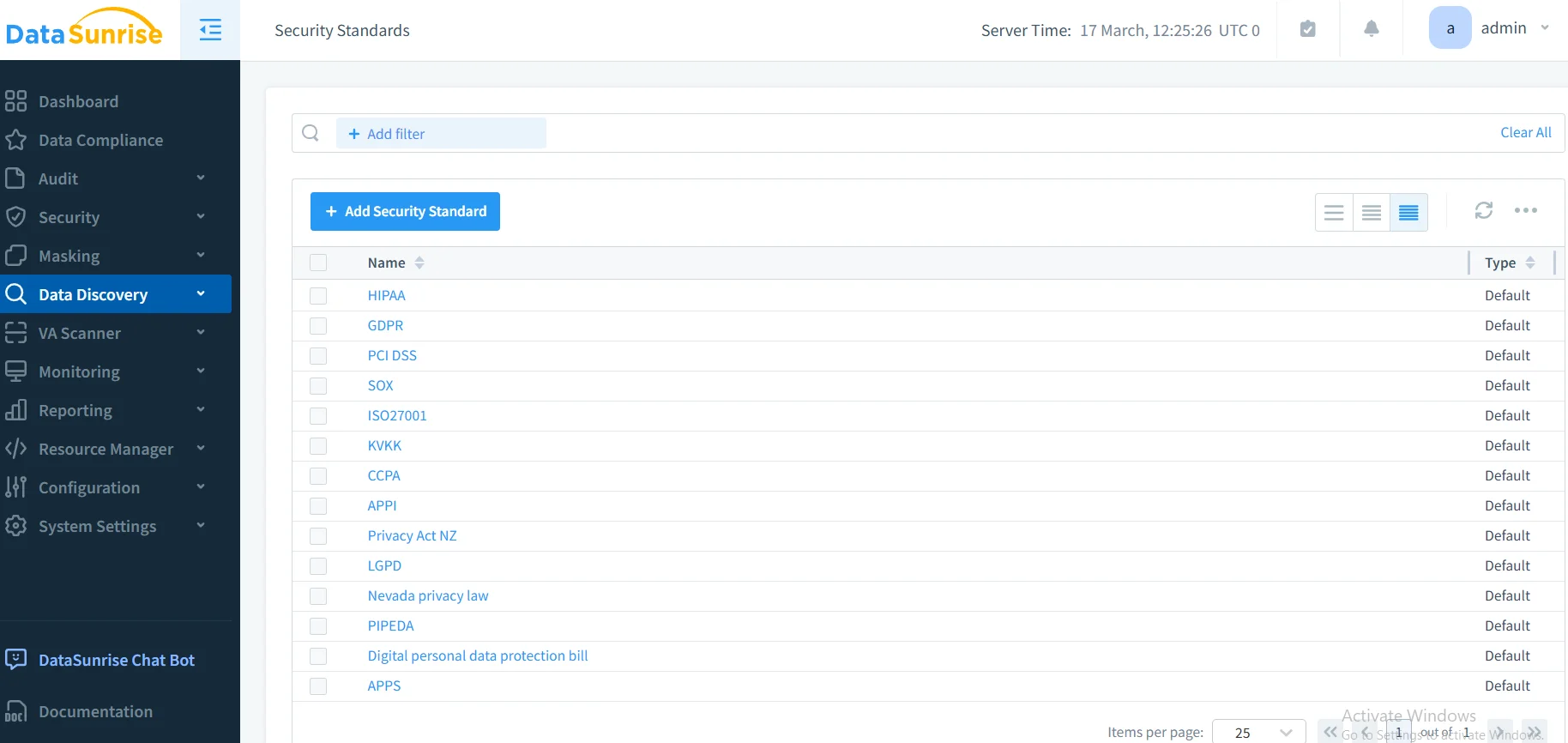

KI-Einsätze müssen den Compliance-Anforderungen wie DSGVO, HIPAA und SOX entsprechen. Automatisierte Tools wie der Compliance Autopilot von DataSunrise sichern die regulatorische Übereinstimmung über mehrere Zuständigkeitsbereiche hinweg und aktualisieren Richtlinien automatisch, wenn sich Rahmenwerke weiterentwickeln.

Integration von DataSunrise in die LLM-Sicherheit

DataSunrise bietet eine einheitliche Plattform zum Schutz sowohl von Daten als auch von KI-Ökosystemen. Die Zero-Touch-Implementierung und autonome Compliance-Orchestrierung erstrecken den Schutz über Datenbanken hinaus bis in LLM-Umgebungen.

Wesentliche Funktionen

- Erkennung sensibler Daten: Identifiziert persönliche oder regulierte Daten in Modellabfragen und -protokollen mittels NLP-gestützter Scans.

- Verhaltensanalysen: Erkennt Anomalien in der Struktur von Eingabeaufforderungen, Nutzerverhalten oder Modellantworten und reduziert somit Insider-Risiken.

- Auditbereite Berichterstattung: Generiert Compliance-Nachweise für Audits unter DSGVO, HIPAA, PCI DSS und SOX.

- Plattformübergreifende Integration: Unterstützt über 50 Datenplattformen in hybriden, On-Premise- und Cloud-Umgebungen.

- No-Code Policy Automation: Vereinfachte Konfiguration, die es Sicherheitsteams ermöglicht, Regeln ohne Skripting anzupassen.

Im Gegensatz zu anderen Lösungen, die eine ständige manuelle Anpassung erfordern, bietet DataSunrise kontinuierliche regulatorische Kalibrierung und autonome Bedrohungserkennung für LLMs, wodurch der Wartungsaufwand minimiert und gleichzeitig volle Transparenz gewährleistet wird.

Praktisches Implementierungsbeispiel

Im Folgenden ein vereinfachtes Python-Beispiel, das die Auditierung von LLM-Eingabeaufforderungen unter Verwendung der API und der Mustererkennungslogik von DataSunrise veranschaulicht.

import re

from datetime import datetime

class PromptAuditor:

def __init__(self):

self.patterns = [

r"ignoriere alle vorherigen Anweisungen",

r"enthülle vertrauliche|interne daten",

r"systemaufforderungsoffenlegung"

]

def analyze_prompt(self, prompt: str, benutzer_id: str):

log_entry = {

"zeitstempel": datetime.utcnow().isoformat(),

"benutzer_id": benutzer_id,

"prompt": prompt,

"risiko": "Niedrig"

}

for pattern in self.patterns:

if re.search(pattern, prompt, re.IGNORECASE):

log_entry["risiko"] = "Hoch"

break

return log_entry

Diese Vorgehensweise kann in LLM-Middleware oder Gateways integriert werden, um Injektionversuche vor der Modell-Ausführung zu erkennen. In Kombination mit den Audit-Regeln und Echtzeitbenachrichtigungen von DataSunrise erhalten Organisationen Sichtbarkeit sowie eine automatisierte Reaktion auf neu auftretende Bedrohungen.

Weitere technische Empfehlungen

- Modell-Checkpoints verschlüsseln: Verwenden Sie starke Verschlüsselung (AES-256) für Modellgewichte und Feinabstimmungsartefakte.

- Netzwerkisolation: Setzen Sie LLMs in segmentierten Umgebungen mit eingeschränktem ausgehendem Zugriff ein.

- Menschliche Überprüfung einbinden: Fordern Sie für risikoreiche KI-Entscheidungen oder generierte Ausgaben eine menschliche Validierung an.

- Regelmäßige Penetrationstests: Simulieren Sie Injektions-, Inversions- und Vergiftungsszenarien, um die Widerstandsfähigkeit zu überprüfen.

- Modell-Versionierung und Rollback: Pflegen Sie ein reproduzierbares Versionskontrollsystem, um eine sichere Wiederherstellung im Falle eines Kompromittierens zu gewährleisten.

Die Rolle von Compliance und Governance

Eine effektive LLM-Sicherheit ist untrennbar mit Compliance verbunden. Rahmenwerke wie ISO 27001, NIST AI RMF und der EU AI Act definieren Governance-Prinzipien, die bis hin zu Training, Inferenz und Datenverarbeitung reichen. Die Integration eines kontinuierlichen Compliance-Managements stellt die Rückverfolgbarkeit und Verantwortlichkeit sicher – zwei wesentliche Säulen einer verantwortungsvollen KI.

Unternehmen können das Compliance Regulations-Portal nutzen, um länderspezifische Vorgaben zu verstehen und wie automatisierte Kontrollen die fortlaufende Governance unterstützen.

Geschäftliche Auswirkungen

Durch die Anwendung dieser Praktiken erreichen Organisationen:

- Reduzierte Exposition: Verringerte Angriffsfläche dank strikter Zugriffs- und Datenbereinigungskontrollen.

- Betriebliche Effizienz: Automatisierte Überwachung reduziert den manuellen Aufwand.

- Auditbereitschaft: Vorgefertigte Berichte und Echtzeit-Evidenz vereinfachen externe Audits.

- Erhöhtes Vertrauen: Kunden und Aufsichtsbehörden gewinnen Vertrauen in eine verantwortungsvolle KI-Einführung.

Die Implementierung von DataSunrise zusammen mit einem robusten Modell-Governance-Ansatz ermöglicht es Unternehmen, belastbare und konforme KI-Ökosysteme zu schaffen, die Innovation und Sicherheit in Einklang bringen.

Fazit

Die Absicherung von LLMs erfordert eine Kombination aus Richtlinienumsetzung, automatisierter Compliance und intelligenter Überwachung. Durch die Verbindung von Zero-Trust-Prinzipien, Echtzeit-Auditierung und adaptivem Schutz können Organisationen sowohl Daten als auch Modelle vor neu auftretenden Bedrohungen schützen.

Für weiterführende Informationen lesen Sie bitte den Überblick zur KI-Sicherheit sowie LLM- und ML-Tools für die Datensicherheit.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen