Schutz sensibler Daten in Vertica

Der Schutz sensibler Daten in Vertica ist eine grundlegende Anforderung für Organisationen, die die Plattform als zentrales Analysewerkzeug verwenden und dabei persönliche, finanzielle oder regulierte Informationen verarbeiten. Vertica ist für hochperformante analytische Workloads konzipiert, was sie ideal für BI-Berichte, Kundenanalysen und Datenwissenschaft macht. Allerdings bringt diese Flexibilität auch Risiken mit sich, wenn sensible Werte von vielen Benutzern, Tools und automatisierten Pipelines abgerufen werden.

In realen Umgebungen bedienen Vertica-Cluster selten nur eine einzelne Workload. Stattdessen greifen Analysten, BI-Dashboards, ETL-Jobs und Machine-Learning-Pipelines alle auf dieselben Tabellen zu. Mit wachsendem Datenvolumen und sich entwickelnden Schemata stoßen traditionelle Kontrollen wie statische Berechtigungen oder manuell gepflegte Views an ihre Grenzen, um sensible Informationen zu schützen. Um dieses Problem zu lösen, setzen Organisationen auf dynamische, richtliniengesteuerte Schutzmechanismen, die in Echtzeit arbeiten.

Dieser Artikel erklärt, wie der Schutz sensibler Daten in Vertica mittels zentralisierter Kontrollen, dynamischer Maskierung und Auditing implementiert wird, wobei DataSunrise als externe Durchsetzungsschicht agiert.

Warum der Schutz sensibler Daten in Vertica komplex ist

Die interne Architektur von Vertica legt den Schwerpunkt auf analytische Performance. Daten werden in spaltenorientierten ROS-Containern gespeichert, aktuelle Updates werden im WOS gehalten, und Projektionen schaffen mehrere optimierte physische Layouts derselben logischen Daten. Während dieses Design Abfragen beschleunigt, erschwert es auch die konsistente Nachverfolgung und den Schutz sensibler Attribute.

Mehrere betriebliche Realitäten erhöhen das Risiko einer Exposition:

- Breit angelegte analytische Tabellen mischen oft Geschäftsdaten mit personenbezogenen Daten (PII) oder Zahlungsinformationen.

- Mehrere Projektionen replizieren sensible Spalten im gesamten Cluster.

- Gemeinsame Umgebungen erlauben sowohl vertrauenswürdigen als auch semi-vertrauenswürdigen Benutzern den Zugriff auf dieselben Datensätze.

- Ad-hoc-SQL-Abfragen umgehen vordefinierte Reporting- oder Governance-Schichten.

- Native rollenbasierte Zugriffskontrollen (RBAC) redigieren keine Werte auf Spaltenebene.

Infolgedessen kann Vertica sensible Werte im Klartext zurückgeben, sobald ein Benutzer SELECT-Zugriff hat. Um dieses Risiko zu minimieren, implementieren Organisationen Schutzmechanismen, die Abfragen bewerten und Ergebnisse transformieren, bevor Daten den Client erreichen.

Für architektonische Hintergründe siehe die offizielle Vertica-Architekturdokumentation.

Zentralisierte Architektur für den Schutz sensibler Daten

Ein üblicher Ansatz zum Schutz sensibler Daten in Vertica ist die Trennung von Durchsetzung und Speicherung. In diesem Modell verbinden sich Client-Anwendungen über ein zentrales Sicherheits-Gateway und nicht direkt mit Vertica. Jede SQL-Abfrage wird vor der Ausführung inspiziert, und Schutzrichtlinien werden konsistent angewendet.

Viele Organisationen realisieren diese Architektur mit DataSunrise Data Compliance. DataSunrise fungiert als transparenter Proxy vor Vertica und erzwingt Schutzregeln, ohne die Datenbankschemata oder die Anwendungslogik zu verändern.

Diese zentrale Schicht ermöglicht:

- Automatische Identifikation sensibler Spalten.

- Echtzeit-Maskierung geschützter Werte.

- Konsistente Durchsetzung über BI-Tools, Skripte und Services hinweg.

- Einheitliche Audit-Protokollierung als Nachweis für Compliance.

Aus betrieblicher Sicht vereinfacht diese Architektur zudem die langfristige Wartung. Anstatt Schutzlogik in dutzenden SQL-Views, ETL-Skripten oder BI-Dashboards einzubetten, verwalten Teams Richtlinien an einem einzigen Ort. Wenn sich Compliance-Anforderungen ändern, aktualisieren Administratoren zentral die Regeln und wenden diese sofort auf alle Vertica-Workloads an.

Darüber hinaus passt diese Trennung der Zuständigkeiten gut zu modernen Sicherheitsmodellen. Datenbankadministratoren verwalten weiterhin Performance, Projektionen und Speicherung, während Sicherheits- und Compliance-Teams Maskierung, Auditing und Zugriffsverhalten kontrollieren. Diese klare Abgrenzung reduziert betriebliche Reibungsverluste und minimiert das Risiko unbeabsichtigter Fehlkonfigurationen.

Dynamische Maskierung als Kernschutzmechanismus

Dynamische Datenmaskierung ist eine der effektivsten Techniken zum Schutz sensibler Daten in Vertica. Anstatt gespeicherte Daten zu verändern, wird die Maskierung zur Abfragezeit angewendet. Wenn ein Benutzer oder eine Anwendung Daten anfragt, werden sensible Werte im Ergebnis durch anonymisierte oder teilweise verdeckte Darstellungen ersetzt.

DataSunrise bietet eine integrierte dynamische Datenmaskierung, die jede Abfrage anhand von Richtlinienregeln bewertet. Diese Regeln können folgende Kriterien berücksichtigen:

- Den Datenbankbenutzer oder die Rolle.

- Die Art der Client-Anwendung.

- Die Umgebung (Produktion, Staging, Analytics).

- Die Sensitivitätsklassifizierung jeder Spalte.

Die zugrunde liegenden Vertica-Tabellen bleiben unverändert, was die Performance erhält und Datenduplikation vermeidet. Gleichzeitig verlassen sensible Werte niemals in Klartext die Datenbankgrenze.

Ein weiterer wichtiger Vorteil der dynamischen Maskierung ist die Wahrung der analytischen Genauigkeit. Im Gegensatz zu statischer Maskierung oder Redaktion während des Ladens können Berechnungen und Aggregationen intern weiterhin mit den echten Werten durchgeführt werden. Maskierte Darstellungen gelten nur auf der Präsentationsebene.

Diese Unterscheidung ist insbesondere in Vertica-Umgebungen wichtig, in denen analytische Korrektheit und Performance eng miteinander verbunden sind. Geschäftskennzahlen, Trendanalysen und Feature-Extraktionen für Machine Learning bleiben zuverlässig, während sensible Attribute geschützt bleiben.

Konfiguration von Richtlinien zum Schutz sensibler Daten

Schutzrichtlinien definieren, wie sensible Daten behandelt werden sollen. Eine typische Richtlinie adressiert eine spezifische Vertica-Instanz, wählt ein oder mehrere Schemata oder Tabellen aus und identifiziert, welche Spalten geschützt werden müssen.

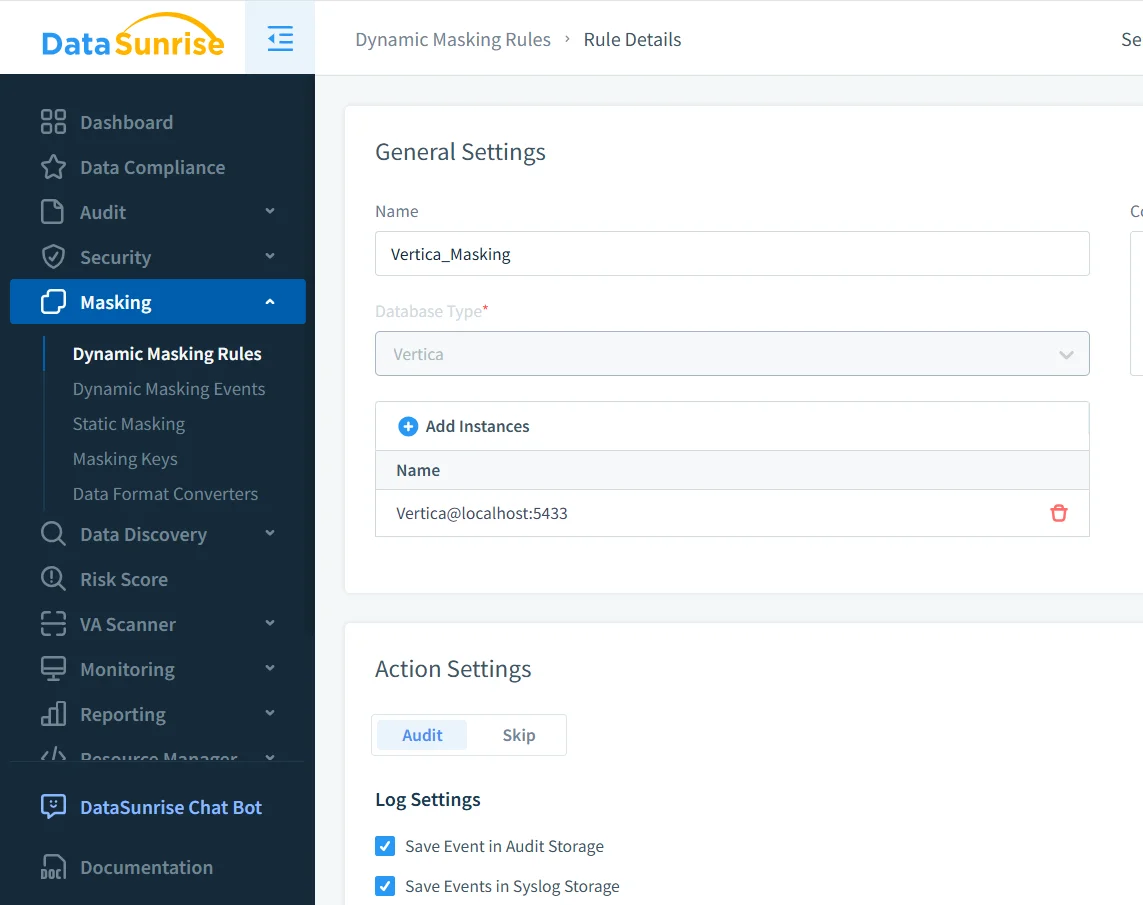

Einrichtung der dynamischen Maskierungsregel für eine Vertica-Datenbankinstanz.

In diesem Schritt ordnen Administratoren die Vertica-Instanz zu, definieren das Maskierverhalten und aktivieren das Auditing. Da die Regeln außerhalb von Vertica verwaltet werden, bleiben sie auch bei geänderten Schemata und Projektionen wirksam.

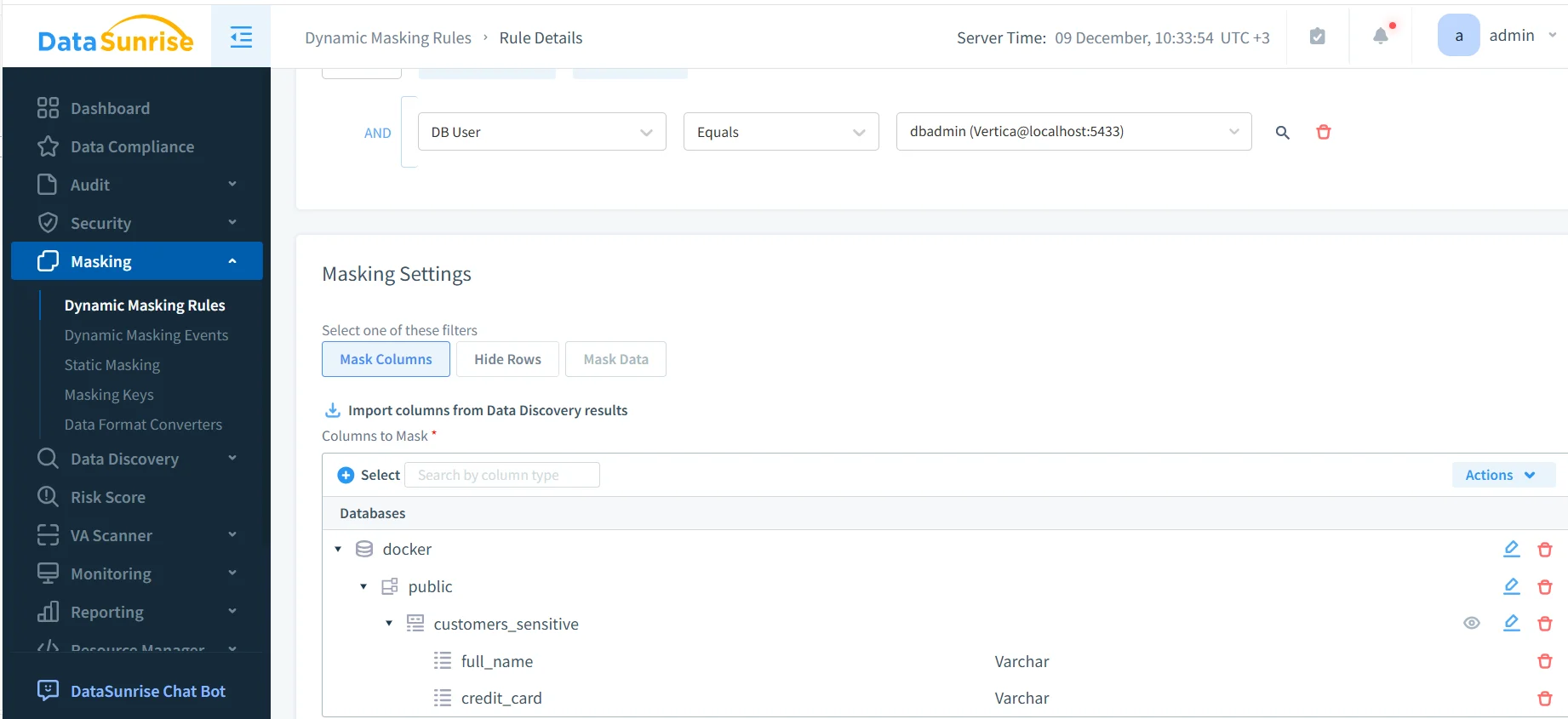

Nach dem Anlegen der Regel wählen Administratoren aus, welche Spalten geschützt werden sollen. Die Spaltenlisten werden häufig direkt aus den Entdeckungsergebnissen importiert.

Auswahl sensibler Spalten wie Namen und Zahlungsdaten zur Maskierung.

Dieser entdeckungsgetriebene Ansatz reduziert blinde Flecken und manuellen Aufwand erheblich.

Maskierte Ergebnisse in analytischen Workflows

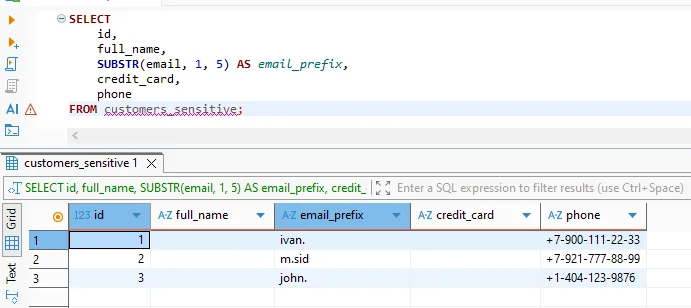

Aus Sicht von Analysten und Anwendungen ist der Schutz sensibler Daten transparent. Abfragen werden mit Standard-SQL geschrieben, und Vertica führt sie normal aus. Der Unterschied zeigt sich nur in den zurückgegebenen Werten.

Maskierte Ergebnisse unterstützen weiterhin Joins, Filter, Aggregationen und Gruppierungen. Das macht dynamische Maskierung geeignet für BI-Dashboards, explorative Analysen und Feature-Engineering-Workflows.

Da der Schutz einheitlich angewandt wird, vermeiden Teams die Pflege separater „sicherer“ Tabellen oder das Umschreiben von Berichten. Stattdessen folgen Richtlinien dem Benutzer und dem Kontext, nicht der Abfrage.

Zusätzlich unterstützt die dynamische Maskierung kollaborative Analysen. Mehrere Teams können dieselben Vertica-Tabellen sicher mit unterschiedlichen Sichtbarkeitsstufen abfragen, was breiteren Datenzugang ermöglicht, ohne die Vertraulichkeit zu gefährden.

Auditing und Transparenz beim Zugriff auf sensible Daten

Schutz ohne Transparenz reicht für Compliance nicht aus. Organisationen müssen nachweisen, dass sensible Daten konsistent geschützt wurden und Zugriffe überwacht werden.

Audit-Trail zeigt maskierte Abfrageausführung und Regelanwendung.

DataSunrise zeichnet automatisch Audit-Ereignisse für jede geschützte Abfrage auf. Diese Aufzeichnungen umfassen:

- Den Datenbankbenutzer und die Client-Anwendung.

- Die ausgeführte SQL-Anweisung.

- Die ausgelöste Schutzregel.

- Den Zeitstempel und Kontext der Ausführung.

Diese Audit-Logs lassen sich in Database Activity Monitoring integrieren und können für Langzeitaufbewahrung an SIEM-Plattformen weitergeleitet werden.

Auditing spielt auch eine entscheidende Rolle bei der Incident Response. Bei ungewöhnlichen Zugriffsmustern können Compliance-Teams schnell feststellen, ob maskierte Daten exponiert wurden, welche Regeln galten und welche Anwendungen die Abfragen initiierten.

Vergleich der Schutztechniken

| Technik | Beschreibung | Eignung für Vertica |

|---|---|---|

| Statisch maskierte Kopien | Erstellung separater maskierter Datensätze | Hoher Wartungsaufwand, nicht skalierbar |

| SQL-Views | Maskierte Spalten über Views bereitstellen | Leicht durch direkte Abfragen umgehbar |

| Nur RBAC | Zugriff auf Tabellenebene beschränken | Kein Schutz auf Werteebene |

| Dynamische Maskierung | Ergebnisse zur Abfragezeit umschreiben | Zentralisiert und skalierbar |

Best Practices für den Schutz sensibler Daten in Vertica

- Beginnen Sie mit automatisierter Discovery zur Identifikation sensibler Felder.

- Wenden Sie Schutz auf der Abfrageebene an, anstatt Daten zu kopieren.

- Testen Sie Richtlinien mit echten BI- und Analyse-Workloads.

- Überprüfen Sie Audit-Logs regelmäßig auf unerwartete Zugriffsmuster.

- Richten Sie Maskierungsregeln auf umfassendere Datensicherheits-Strategien aus.

Fazit

Der Schutz sensibler Daten in Vertica erfordert Kontrollen, die dem Umfang und der Flexibilität analytischer Workloads gerecht werden. Dynamische Maskierung, zentralisierte Durchsetzung und einheitliches Auditing ermöglichen es Organisationen, regulierte Informationen zu schützen, ohne dabei Leistung oder Benutzerfreundlichkeit einzuschränken.

Durch die Implementierung einer dedizierten Schutzschicht mit DataSunrise erhalten Teams konsistente Schutzmaßnahmen über Dashboards, Skripte und Pipelines hinweg. Mit zunehmendem Datenvolumen und wachsendem Benutzerzugriff stellt dieser Ansatz sicher, dass sensible Informationen geschützt bleiben, während Vertica weiterhin hochperformante Analysen liefert.