Auditoría de IA Generativa

La IA generativa está impulsando una rápida innovación en el panorama tecnológico, potenciando herramientas como ChatGPT de OpenAI, Amazon Bedrock y una oleada de nuevas plataformas. Aunque estas tecnologías redefinen la interacción entre humanos y máquinas, también generan serias preocupaciones en materia de privacidad, en particular en lo que respecta al uso y exposición de Información de Identificación Personal (PII).

Este artículo explora las implicaciones más amplias de las auditorías de IA generativa, destacando los principales riesgos de privacidad y estrategias para fortalecer las prácticas de auditoría y seguridad de datos.

El Mundo en Expansión de la Auditoría de IA Generativa

La IA generativa ha trascendido una única plataforma. Hoy en día, vemos un ecosistema diverso:

- ChatGPT de OpenAI: Una IA conversacional que se ha convertido en sinónimo de capacidades generativas.

- Amazon Bedrock: Un servicio totalmente administrado que permite la integración sencilla de modelos base en aplicaciones.

- Bard de Google: Un servicio experimental de IA conversacional impulsado por LaMDA.

- Azure OpenAI Service de Microsoft: Proporciona acceso a los modelos de OpenAI, con la seguridad adicional y las características empresariales de Azure.

Estas plataformas proporcionan acceso mediante API para desarrolladores y interfaces web para los usuarios. Esto aumenta considerablemente el riesgo de violaciones de datos.

Riesgos de Privacidad en el Panorama de la IA Generativa

La adopción generalizada de la IA generativa introduce varias preocupaciones en materia de privacidad:

- Retención de Datos: Los modelos de IA pueden almacenar entradas para su mejora, incluyendo potencialmente información sensible.

- Divulgación No Intencionada de Información: Los usuarios podrían revelar accidentalmente PII durante las interacciones.

- Explotación del Modelo: Ataques sofisticados podrían extraer potencialmente datos de entrenamiento de los modelos.

- Agregación de Datos entre Plataformas: El uso de múltiples servicios de IA podría llevar a la creación de perfiles de usuario completos.

- Vulnerabilidades en APIs: Implementaciones inseguras de API podrían exponer datos de los usuarios.

Estrategias Generales para Mitigar los Riesgos de Privacidad

Para abordar estas preocupaciones, las organizaciones deberían considerar los siguientes enfoques:

- Minimización de Datos: Limitar la cantidad de datos personales procesados por los sistemas de IA.

- Anonimización y Seudonimización: Transformar los datos para eliminar u ocultar la información que permita identificar a una persona.

- Cifrado: Implementar un cifrado robusto para los datos en tránsito y en reposo.

- Controles de Acceso: Gestionar estrictamente quién puede acceder a los sistemas de IA y a los datos almacenados.

- Auditorías de Seguridad Regulares: Realizar revisiones exhaustivas de los sistemas de IA y sus prácticas de manejo de datos.

- Educación del Usuario: Informar a los usuarios sobre los riesgos y las mejores prácticas al interactuar con la IA.

- Marcos de Cumplimiento: Alinear el uso de la IA con regulaciones como GDPR, CCPA y normas específicas de la industria.

Auditoría de Interacciones con la IA Generativa: Aspectos Clave

La auditoría efectiva es crucial para mantener la seguridad y el cumplimiento. Los aspectos clave incluyen:

- Registro Integral: Registrar todas las interacciones, incluidos los inputs de los usuarios y las respuestas de la IA.

- Monitoreo en Tiempo Real: Implementar sistemas para detectar y alertar de posibles infracciones de privacidad de manera inmediata.

- Análisis de Patrones: Utilizar aprendizaje automático para identificar patrones de uso inusuales que puedan indicar un uso indebido.

- Revisiones Periódicas: Examinar regularmente los registros y patrones de uso para garantizar el cumplimiento e identificar riesgos potenciales.

- Auditorías por Terceros: Involucrar a expertos externos para proporcionar evaluaciones imparciales del uso de la IA y las medidas de seguridad.

DataSunrise: Una Solución Integral para la Auditoría de la IA

DataSunrise ofrece una solución robusta para auditar las interacciones con la IA generativa a través de diversas plataformas. Nuestro sistema se integra de forma fluida con diferentes servicios de IA, proporcionando un enfoque unificado en materia de seguridad y cumplimiento.

Componentes Clave de la Solución de Auditoría de IA de DataSunrise:

- Servicio Proxy: Intercepta y analiza el tráfico entre los usuarios y las plataformas de IA.

- Descubrimiento de Datos: Identifica y clasifica automáticamente la información sensible en las interacciones con la IA.

- Monitoreo en Tiempo Real: Proporciona alertas inmediatas sobre posibles violaciones de privacidad.

- Registro de Auditoría: Crea registros detallados e inalterables de todas las interacciones con la IA.

- Generación de Informes de Cumplimiento: Genera informes adaptados a diversos requisitos regulatorios.

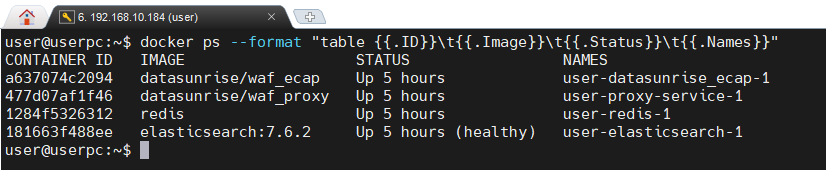

La imagen a continuación muestra cuatro contenedores Docker en funcionamiento. Estos contenedores brindan funcionalidad de Firewall de Aplicación Web de DataSunrise, mejorando la seguridad del sistema representado.

Ejemplo de Configuración con DataSunrise

Una implementación típica de DataSunrise para la auditoría de la IA podría incluir:

- Proxy de DataSunrise: Desplegado como un proxy inverso delante de los servicios de IA.

- Redis: Para la caché y gestión de sesiones, mejorando el rendimiento.

- Elasticsearch: Para el almacenamiento y recuperación eficiente de los registros de auditoría.

- Kibana: Para la visualización de datos de auditoría y la creación de paneles personalizados.

- Consola de Gestión de DataSunrise: Para configurar políticas y visualizar informes.

Esta configuración puede ser desplegada fácilmente usando herramientas de orquestación de contenedores como Docker y Kubernetes, asegurando escalabilidad y facilidad de gestión.

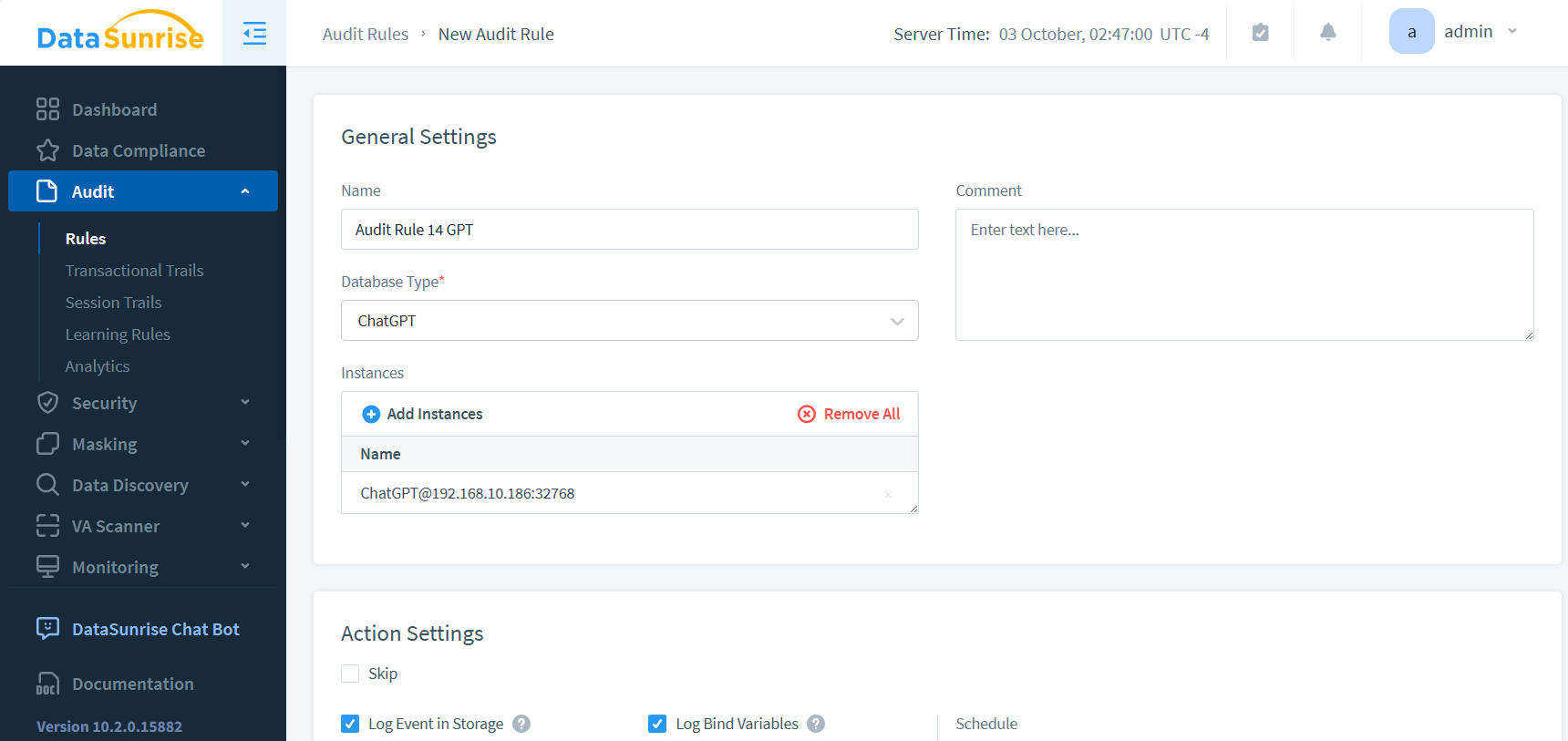

Configurar las reglas de auditoría es un proceso sencillo. En este caso, seleccionamos la instancia relevante, que no es una base de datos, sino ChatGPT, una aplicación web. Este proceso demuestra la flexibilidad del sistema de auditoría para manejar diversos tipos de aplicaciones.

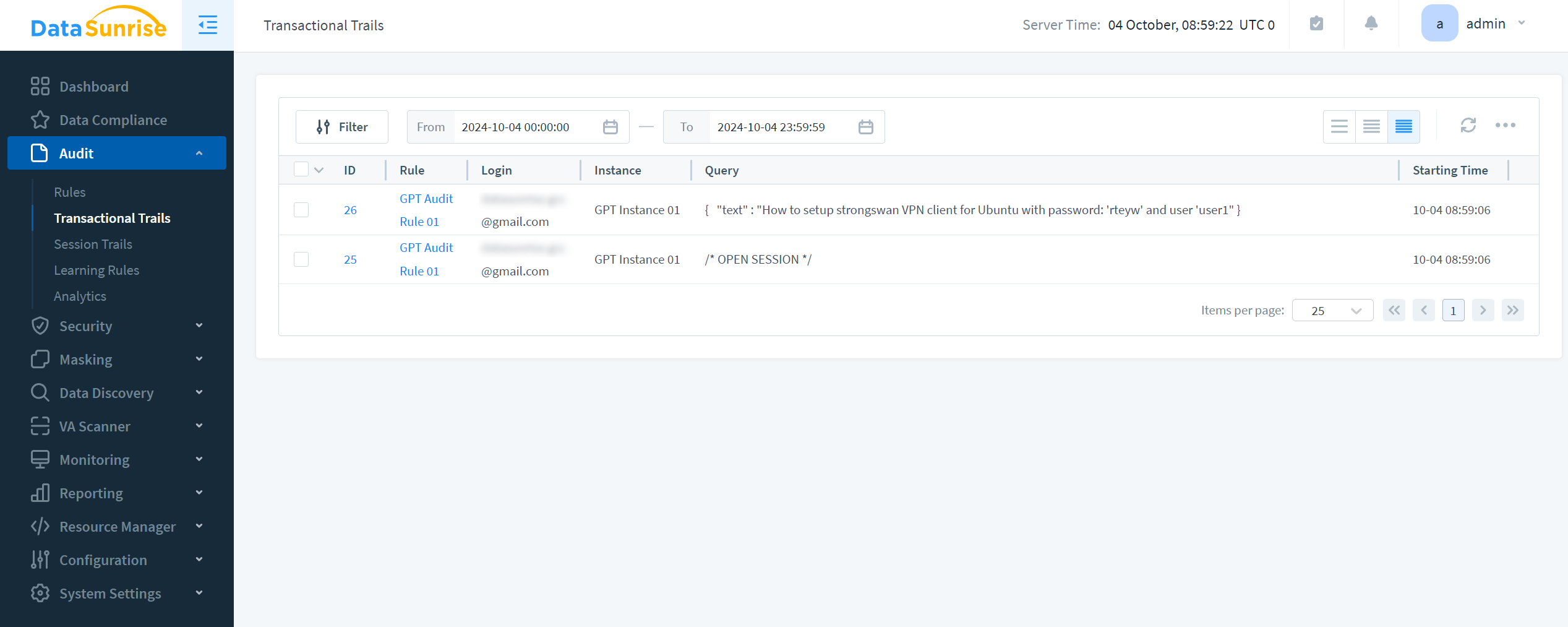

Los resultados de la auditoría y el correspondiente prompt GPT son los siguientes:

Conclusión: Abracemos la IA con Confianza

La IA generativa se está convirtiendo en parte de nuestra vida diaria y de las empresas. A medida que evoluciona, necesitamos medidas sólidas de auditoría y seguridad. Estas medidas son esenciales para garantizar la seguridad.

Utilizando estrategias claras y herramientas avanzadas de DataSunrise, las organizaciones pueden usar la IA de manera eficaz, manteniendo los datos seguros y protegiendo la privacidad.

El futuro de la IA es prometedor, pero debe construirse sobre una base de confianza y seguridad. Al aplicar adecuadas medidas de auditoría y privacidad, podremos desbloquear completamente el potencial de la IA generativa, ayudando a proteger los derechos y la información tanto de individuos como de organizaciones.

DataSunrise: Su Socio en la Seguridad de la IA

DataSunrise es líder en seguridad de la IA. Ofrece no solo herramientas de auditoría, sino un conjunto completo de funciones que protegen sus datos en diversas plataformas y bases de datos.

Nuestra solución se adapta a los desafíos específicos de la IA generativa, ayudando a su organización a adelantarse a posibles amenazas.

Le invitamos a explorar cómo DataSunrise puede mejorar su postura de seguridad en la IA. Visite el sitio web de DataSunrise para programar una demostración y descubrir cómo nuestras soluciones avanzadas pueden ayudarle a gestionar el gobierno de la IA y la protección de datos.