Evaluación de la Postura de Seguridad en Contextos de IA y LLM

La IA generativa (GenAI) y los modelos de lenguaje a gran escala (LLMs) han desbloqueado nuevas formas para que las organizaciones automaticen, analicen y aceleren la toma de decisiones. Sin embargo, su diseño inherente —que maneja datos dinámicos, a menudo no estructurados y sensibles— plantea serias preocupaciones de seguridad. Evaluar la postura de seguridad en contextos de IA y LLM requiere nuevas estrategias adaptadas a cómo estos modelos procesan y exponen los datos.

De los Modelos de Seguridad Tradicionales a los Adaptativos

En los sistemas tradicionales, la seguridad de los datos se basaba a menudo en el perímetro. Con la GenAI, la seguridad debe volverse contextual. Estos modelos ingieren grandes conjuntos de datos, retienen patrones y pueden regenerar información sensible si no se configuran adecuadamente. Un comando podría extraer inadvertidamente credenciales, secretos comerciales o información de identificación personal (PII).

Por lo tanto, asegurar las canalizaciones de IA no se trata solo de firewalls y roles. Requiere seguridad de datos adaptable, registros conscientes de la privacidad y controles en tiempo real integrados en el ciclo de vida de la IA. Como lo destacan las prácticas seguras de IA de Google, los controles específicos de IA deben alinearse tanto con la infraestructura como con el comportamiento del modelo.

Auditoría en Tiempo Real y Seguimiento de Comportamiento

Las cargas de trabajo de IA necesitan mecanismos de auditoría en tiempo real para capturar cada interacción entre usuarios y modelos. Dado que los sistemas de GenAI pueden generar una salida novedosa en cada comando, el registro debe cubrir la entrada, la salida, la identidad de la sesión y las consultas posteriores.

Considere este escenario: un analista de datos interactúa con un sistema interno de GenAI mediante lenguaje natural.

Prompt: "Enumere todos los clientes de Alemania que realizaron compras superiores a $10,000 en el último trimestre."

El LLM genera la consulta SQL:

SELECT customer_id, name, email, country, total_purchase

FROM sales.customers

WHERE country = 'Alemania' AND total_purchase > 10000 AND purchase_date BETWEEN '2024-10-01' AND '2024-12-31';

Esta solicitud toca identificadores de clientes, información de contacto y datos financieros. Un registro de auditoría bien diseñado capturará tanto el comando como el SQL generado, atándolo a la sesión del usuario y al contexto temporal. Herramientas como la auditoría de aprendizaje de comportamiento ayudan a identificar si dicho acceso es habitual o potencialmente abusivo. Este enfoque se alinea con el Marco de Gestión de Riesgos de IA del NIST, que enfatiza la monitorización continua.

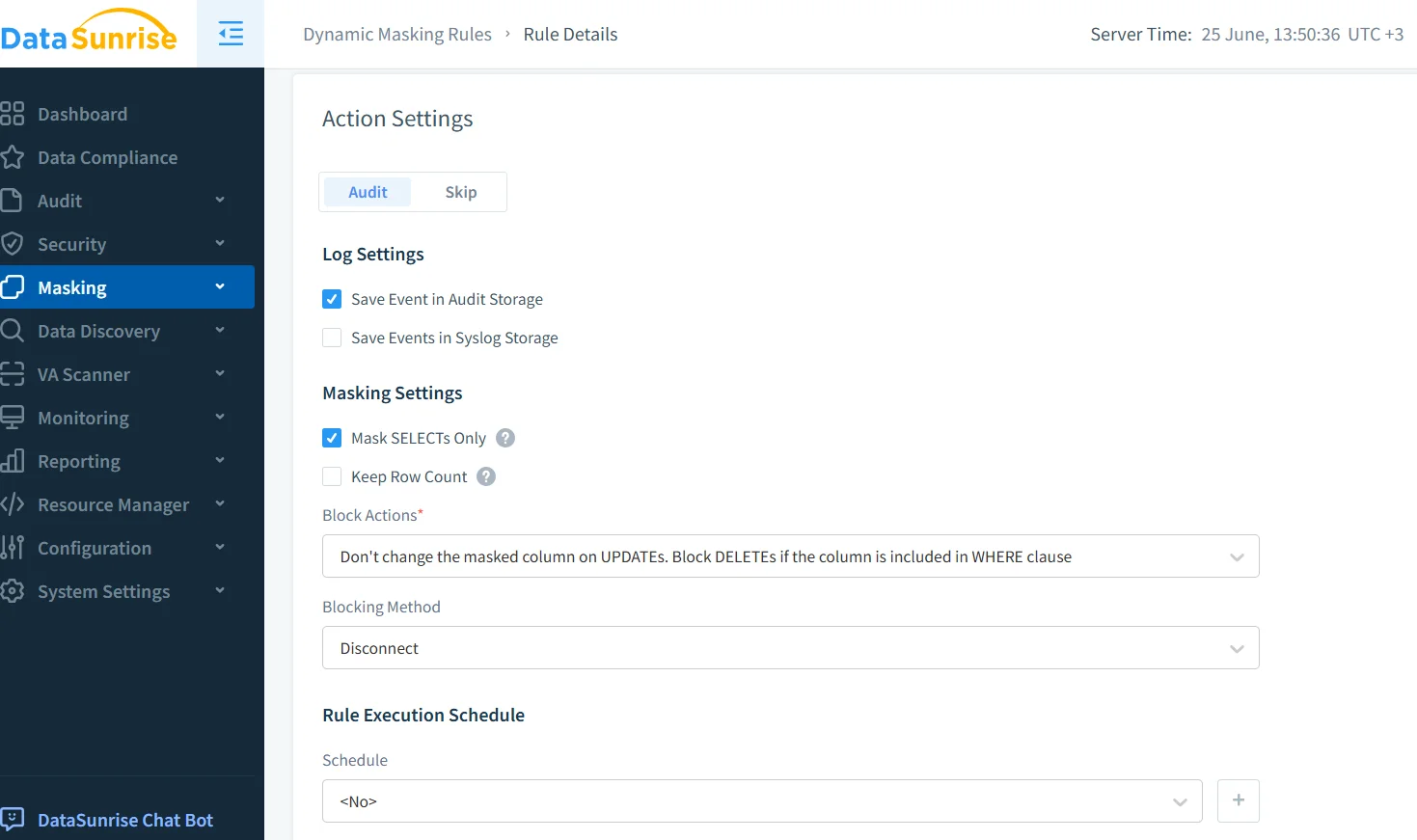

Enmascaramiento Dinámico para las Respuestas del Modelo

Debido a que las salidas de GenAI se generan dinámicamente, el enmascaramiento dinámico de datos garantiza que la información sensible se oculte antes de mostrarse. Este enfoque equilibra la usabilidad y el cumplimiento.

Supongamos que un bot de soporte está conectado a una base de datos de servicio al cliente. Cuando se le pregunte:

"Muéstrame el perfil del cliente para John Doe."

El backend puede producir:

{

"name": "John Doe",

"email": "[email protected]",

"ssn": "123-45-6789",

"credit_card": "4111 1111 1111 1111"

}

Con el enmascaramiento activado para campos sensibles:

{

"name": "John Doe",

"email": "j*****[email protected]",

"ssn": "***-**-6789",

"credit_card": "**** **** **** 1111"

}

El enmascaramiento es consciente del contexto y depende del rol del usuario, la fuente y las reglas de clasificación. Microsoft también recomienda proteger las salidas de datos en los sistemas de IA mediante técnicas de aplicación en capas.

Descubrimiento de Datos Antes de la Exposición a la IA

Antes de alimentar datos en los LLM, las organizaciones deben utilizar herramientas de descubrimiento de datos para escanear en busca de PII, identificadores financieros y valores sensibles para el negocio. Esto permite a los equipos de seguridad etiquetar activos de alto riesgo y excluirlos de los conjuntos de entrenamiento o del acceso en tiempo real.

En lugar de depender únicamente de la configuración manual, el descubrimiento automatizado puede clasificar campos sensibles e integrarse con enmascaramiento, encriptación o reglas de acceso. La guía de gobernanza de datos de IBM ofrece prácticas valiosas para configurar estos flujos de trabajo de manera efectiva. La integración con motores de políticas automatizados garantiza una aplicación consistente en los entornos de IA.

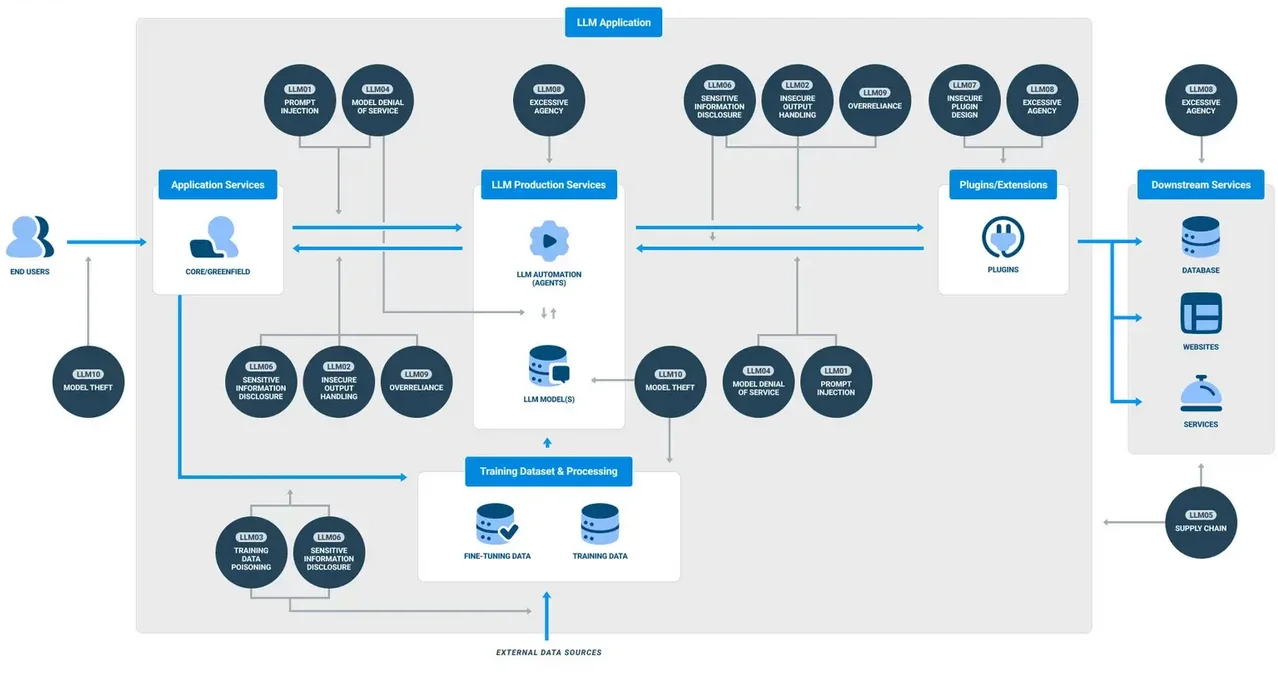

Políticas de Seguridad Adaptadas a la IA

Las reglas estáticas de permitir/denegar son insuficientes en el contexto de GenAI. Las políticas deben adaptarse en función del comportamiento del usuario, la intención del comando y la sensibilidad de la salida. Por ejemplo, el análisis de patrones puede detectar intentos maliciosos de inyección de comandos, mientras que los límites basados en el tiempo pueden restringir el acceso a ciertos datos durante las horas no laborales.

Los sistemas como la protección contra inyección de SQL deben evolucionar para analizar no solo SQL, sino también comandos en lenguaje natural que generan actividad en la base de datos. Investigaciones de Stanford destacan cómo sutiles variaciones en los comandos pueden evadir los filtros tradicionales y extraer datos privilegiados.

Alineando la GenAI con los Estándares de Cumplimiento de Datos

Los sistemas basados en LLM aún deben cumplir con GDPR, HIPAA y PCI DSS. Esto incluye garantizar la auditabilidad, respetar los derechos de eliminación de datos de los usuarios y prevenir la exposición no autorizada de datos a nivel transfronterizo.

El cumplimiento en entornos de GenAI significa implementar políticas de retención de datos que limiten el almacenamiento del historial de comandos, aplicar restricciones de acceso mediante controles basados en roles y aplicar enmascaramiento a los registros de auditoría. Los gestores de cumplimiento simplifican la supervisión mediante la generación de informes automatizados y la aplicación de políticas estandarizadas. Como referencia, la guía de la CNIL sobre IA y GDPR proporciona marcos útiles adaptados al uso de la IA.

Conclusión: Un Marco de Seguridad Vivo

Evaluar la postura de seguridad en contextos de IA y LLM no es una lista de verificación única. Es un ciclo continuo de monitoreo, enmascaramiento, auditoría y alineación con el cumplimiento. Las herramientas deben ser interoperables, en tiempo real y conscientes de la IA. La seguridad debe extenderse más allá de la infraestructura y adentrarse en los comandos del modelo, las salidas y el comportamiento del usuario.

Las organizaciones que adoptan la GenAI deben construir un marco de seguridad vivo, uno que se adapte a medida que el modelo evoluciona, aprende e interactúa con un entorno cada vez más dinámico.