Aprendizaje Federado Seguro

Mientras las organizaciones compiten para entrenar modelos de IA más inteligentes de manera conjunta, el aprendizaje federado (FL) se ha convertido en una de las técnicas más prometedoras para la colaboración sin comprometer la privacidad de los datos. En lugar de centralizar los datos en un servidor, cada participante entrena un modelo local y comparte únicamente sus actualizaciones.

Si bien este enfoque reduce la exposición, también introduce nuevas superficies de ataque. Vulnerabilidades como la inversión de gradiente y la contaminación de datos aún pueden revelar información privada o manipular los resultados. Garantizar el aprendizaje federado seguro requiere una combinación de criptografía, monitoreo y sólidos marcos de cumplimiento de datos.

Entendiendo el Aprendizaje Federado Seguro

En los sistemas federados, los participantes — a menudo hospitales, bancos o instituciones de investigación — entrenan colaborativamente un modelo compartido. Cada nodo calcula actualizaciones localmente y envía únicamente los parámetros del modelo o gradientes a un agregador.

Sin embargo, los atacantes aún pueden reconstruir datos sensibles a partir de estos gradientes. Investigadores de Google AI introdujeron inicialmente el concepto, pero estudios posteriores demostraron que incluso los gradientes encriptados pueden filtrar información identificable cuando no se gestionan adecuadamente.

Ahí es donde entra el aprendizaje federado seguro — introduciendo:

Encriptación de extremo a extremo (encriptación)

Monitoreo de actividad para auditoría

Detección de anomalías utilizando análisis de comportamiento

Estas medidas garantizan que las actualizaciones del modelo permanezcan verificables, encriptadas y en cumplimiento entre todos los participantes.

Principales Desafíos de Seguridad

Ataques de inversión de gradiente – Los adversarios reconstruyen muestras privadas a partir de gradientes compartidos, exponiendo PII.

Envenenamiento del modelo – Contribuyentes maliciosos pueden inyectar datos sesgados o puertas traseras, eludiendo las defensas de firewall.

Agregadores no confiables – Sin un estricto control de acceso basado en roles, los nodos centrales se convierten en puntos únicos de fallo.

Deriva de cumplimiento – Los flujos de datos multi-jurisdiccionales desafían la alineación continua con GDPR y HIPAA.

Reseñas académicas recientes, como Zhu et al. (2023), enfatizan que los modelos federados requieren no solo encriptación sino también gobernanza comportamental — validando las contribuciones, control de acceso y registros a lo largo del ciclo de vida del modelo.

Implementación de Agregación Segura

El siguiente fragmento de Python demuestra un mecanismo simplificado de agregación segura que valida la confianza y filtra las actualizaciones maliciosas antes de la integración:

from typing import Dict, List

import hashlib

class FederatedSecurityAggregator:

def __init__(self, threshold: float = 0.7):

self.threshold = threshold

self.trust_registry: Dict[str, float] = {}

def hash_gradient(self, gradient: List[float]) -> str:

"""Genera un hash para la verificación de integridad."""

return hashlib.sha256(str(gradient).encode()).hexdigest()

def validate_node(self, node_id: str, gradient: List[float]) -> Dict:

"""Evalúa la fiabilidad del nodo y detecta anomalías."""

gradient_hash = self.hash_gradient(gradient)

trust_score = self.trust_registry.get(node_id, 0.8)

malicious = trust_score < self.threshold

return {

"node": node_id,

"hash": gradient_hash,

"trust_score": trust_score,

"malicious": malicious,

"recommendation": "Excluir" if malicious else "Aceptar"

}

def aggregate(self, updates: Dict[str, List[float]]):

"""Agrega únicamente las actualizaciones verificadas."""

return {

node: self.validate_node(node, grad)

for node, grad in updates.items()

}

Esta lógica se puede integrar en los registros de auditoría y el historial de actividad de datos para la trazabilidad y validación del cumplimiento.

Mejores Prácticas de Implementación

Para Organizaciones

Privacidad desde el Diseño – Aplica el enmascaramiento de datos dinámico y estático antes del entrenamiento.

Estrategia de Auditoría Unificada – Mantén registros de auditoría continuos a través de los nodos utilizando herramientas de descubrimiento de datos.

Cumplimiento Normativo – Valida la adherencia a marcos regionales (GDPR, HIPAA, PCI DSS).

Colaboración Encriptada – Emplea la encriptación de bases de datos para los canales entre organizaciones.

Para Equipos Técnicos

Evaluación de Confianza – Mantén métricas de confiabilidad de los nodos mediante análisis de comportamiento.

Seguridad del Proxy Inverso – Dirige todo el tráfico a través de un proxy inverso para flujos de datos controlados.

Monitoreo Centralizado – Combina el monitoreo de actividad de la base de datos con políticas de seguridad adaptativas.

Validación Continua – Reevalúa periódicamente las actualizaciones del modelo y aplica el principio de menor privilegio.

FAQ: Aprendizaje Federado Seguro

P1. ¿Qué es el aprendizaje federado en una oración?

El aprendizaje federado permite que múltiples partes entrenen un modelo compartido manteniendo los datos sin procesar de manera local y compartiendo únicamente las actualizaciones del modelo.

P2. ¿El FL hace que el intercambio de datos sea conforme por defecto?

No — el FL reduce la exposición, pero aún se necesitan políticas, registros y controles para cumplir con marcos como GDPR y HIPAA; utiliza verificaciones continuas de cumplimiento de datos.

P3. ¿Cómo prevengo fugas por inversión de gradiente?

Combina la agregación segura (por ejemplo, computación multipartita o encriptación homomórfica) con ruido de privacidad diferencial en las actualizaciones, además de un estricto control de acceso y registros de auditoría.

P4. TLS vs. Agregación Segura: ¿cuál es la diferencia?

TLS protege las actualizaciones en tránsito; la agregación segura garantiza que el servidor no pueda ver las actualizaciones individuales incluso si el transporte es seguro. Utiliza ambos.

P5. ¿Cómo se detectan las actualizaciones envenenadas o con puertas traseras?

Utiliza la evaluación de confianza y la detección de anomalías (por ejemplo, identificadores de similitud coseno, filtros basados en pérdida), aísla los nodos sospechosos y aplica un control de acceso basado en roles.

P6. ¿Qué hace realmente un agregador?

Verifica, agrega las actualizaciones encriptadas, produce un modelo global y lo redistribuye; no debería acceder a los datos sin procesar ni a las actualizaciones de clientes sin anonimizar.

P7. ¿Dónde encaja el cumplimiento en el proceso?

Como una capa de supervisión: monitorea registros, configuraciones y evidencias (configuraciones de DP, ciclos de claves, correspondencia de políticas) en lugar de recibir gradientes. Consulta el monitoreo de actividad de la base de datos y los registros de auditoría.

P8. ¿Necesito privacidad diferencial en cada ronda?

Preferiblemente sí para datos sensibles; el ruido por ronda con contabilidad de privacidad limita la fuga acumulativa mientras conserva la utilidad.

P9. ¿Puedo enmascarar campos sensibles antes del entrenamiento?

Sí — aplica el enmascaramiento de datos dinámico o estático en el borde para que los campos sensibles nunca ingresen al flujo de características.

P10. ¿Cómo registro sin comprometer datos?

Registra metadatos (alertas de reglas, presupuestos de DP, identificadores de nodos, hashes) y almacena en un almacenamiento de auditoría inalterable; evita cargas útiles sin procesar.

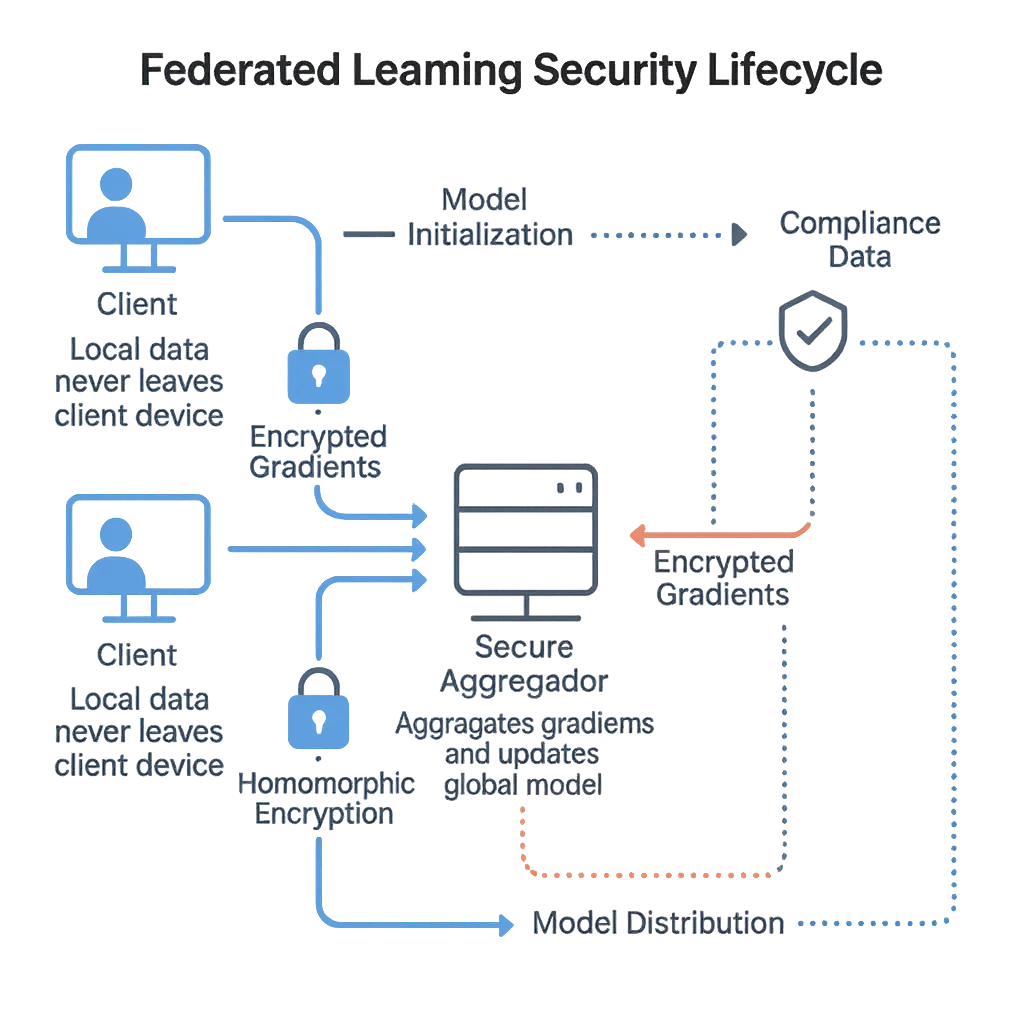

P11. ¿Cuál es el ciclo de vida del modelo en el aprendizaje federado seguro?

Inicialización → distribución a clientes → entrenamiento local → actualización encriptada → agregación segura → validación → actualización del modelo global → redistribución; se repite con versionado y posibilidad de retroceso.

P12. ¿Cómo ayuda DataSunrise?

Proporciona monitoreo basado en proxy, encriptación, análisis de comportamiento, aplicación de políticas y evidencias de cumplimiento a lo largo del pipeline federado.

Construyendo Confianza en la IA Colaborativa

El aprendizaje federado demuestra que la colaboración y la privacidad pueden coexistir — pero solo con auditorías transparentes, encriptación y gobernanza. Sin estos, corre el riesgo de convertirse en un punto ciego para la explotación.

Al combinar la agregación segura, el análisis de comportamiento y la alineación regulatoria, DataSunrise proporciona una base para una IA colaborativa confiable. Sus módulos de Protección de Datos y Auditoría garantizan que cada contribución al modelo permanezca verificable, rastreable y en cumplimiento.

Lecturas Recomendadas:

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora