IA Generativa en Ciberseguridad

Introducción

Los ciberataques continúan evolucionando en complejidad y automatización, y los defensores ya no pueden confiar únicamente en análisis manuales o reglas estáticas. La IA Generativa introduce un nuevo paradigma, permitiendo que los sistemas de defensa piensen, simulen y reaccionen a velocidad de máquina.

Según el IBM X-Force Threat Intelligence Report 2025, los adversarios utilizan cada vez más código generado por IA, deepfakes e identidades sintéticas para evadir la detección. Los sistemas tradicionales basados en reglas tienen dificultades para adaptarse lo suficientemente rápido.

Este artículo explora cómo la IA generativa mejora la ciberseguridad, pasando de la detección reactiva a la simulación predictiva, en la que los modelos de aprendizaje automático anticipan y contrarrestan los ataques de forma autónoma.

A diferencia de las herramientas de automatización anteriores que simplemente reaccionaban ante anomalías, los modelos generativos crean patrones sintéticos de amenazas, someten a prueba los sistemas e identifican vulnerabilidades antes de que los atacantes puedan explotarlas.

DataSunrise complementa esta capacidad con gestión autónoma del cumplimiento, auditorías en tiempo real y análisis de comportamiento a través de bases de datos y canalizaciones de datos, ofreciendo una defensa precisa sin interrumpir los flujos de trabajo comerciales.

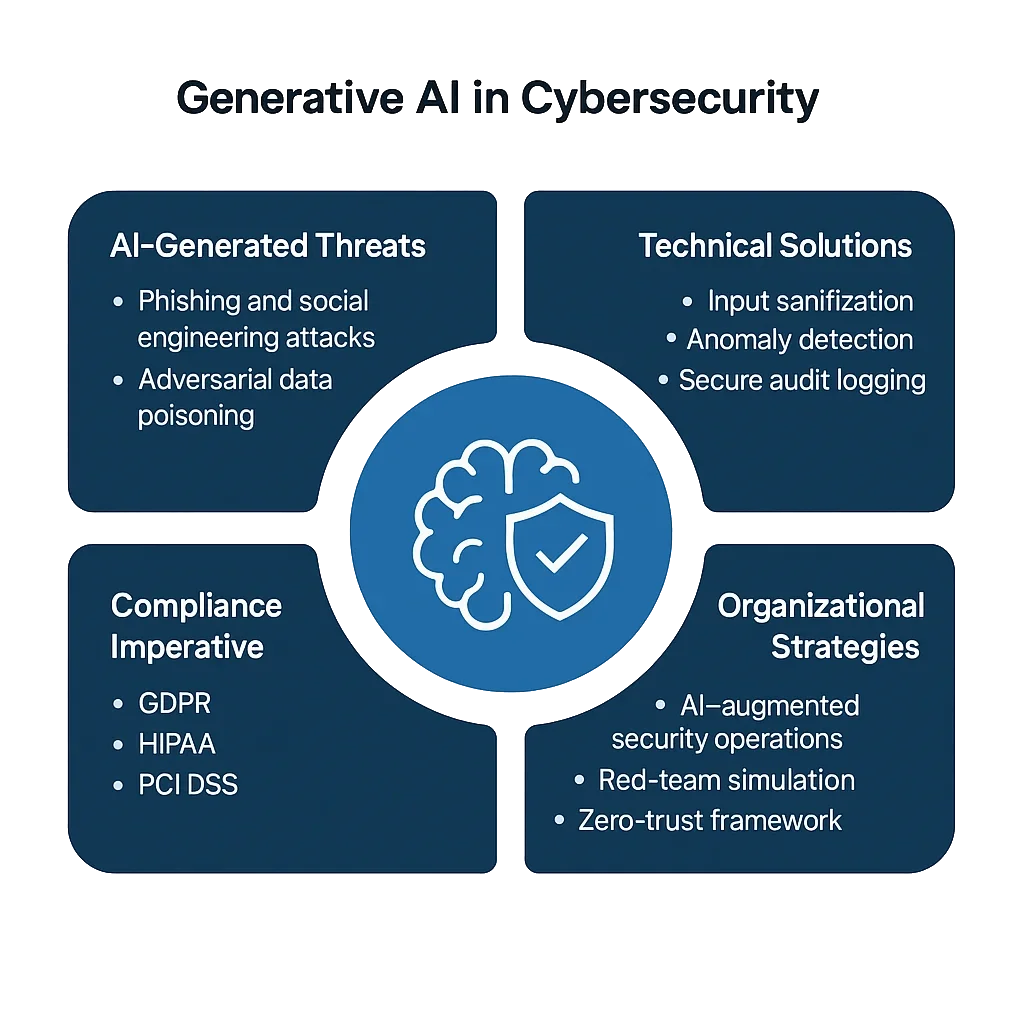

Los Desafíos Fundamentales de la IA Generativa en Ciberseguridad

La IA generativa expande tanto el potencial defensivo como la superficie de ataque. Si bien permite el modelado predictivo de amenazas, también equipa a los adversarios con tácticas escalables y adaptativas.

1. Phishing e Ingeniería Social Generados por IA

Los atacantes ahora utilizan modelos de lenguaje a gran escala (LLM) para elaborar mensajes de phishing convincentes y multilingües, con gramática, tono y personalización precisos, que a menudo son indistinguibles de comunicaciones legítimas.

A diferencia de los filtros de spam tradicionales que se basan en patrones de palabras clave, el phishing generado por IA se adapta en tiempo real, modificando el contenido y el tono para evadir la detección. Sin análisis de comportamiento, las organizaciones se enfrentan a una avalancha de estafas dirigidas con precisión que pueden comprometer incluso a empleados conscientes de la seguridad.

2. Envenenamiento de Datos Adversarial

Los actores de amenazas inyectan datos maliciosos en las canalizaciones de entrenamiento de la IA, distorsionando los límites de decisión. El envenenamiento puede ser sutil: una pequeña porción de entradas mal etiquetadas o manipuladas (incluso menos del 3%) puede sesgar los detectores de aprendizaje automático para que ignoren firmas específicas de ataques.

Una vez incorporados, estos modelos envenenados pueden pasar por alto de manera constante ciertos eventos de malware o escalada de privilegios, permitiendo a los atacantes mantener una persistencia a largo plazo.

3. Explotación de Modelos y Filtración de Datos

Los sistemas generativos que procesan registros de auditoría sensibles o datos de identificación personal (DIP) corren el riesgo de exponer datos de forma no intencionada.

Un atacante podría extraer fragmentos de información confidencial mediante solicitudes especialmente diseñadas — conocidas como inversión de modelo o extracción por prompt — revelando tokens internos, la estructura de la base de datos o incluso datos de usuarios anonimizados.

En sectores como el financiero o el sanitario, dicha filtración no solo constituye un incidente de seguridad, sino también una violación directa de las normativas.

4. Brechas de Cumplimiento en las Operaciones de IA

Incluso cuando las herramientas de IA funcionan de manera efectiva, a menudo no cumplen con las normativas correspondientes.

Las organizaciones que implementan modelos entrenados con fuentes de datos mixtas sin adherirse a los marcos de GDPR, HIPAA o PCI DSS corren el riesgo de infringir las regulaciones de manera no intencionada.

La naturaleza de “caja negra” de la IA complica la rendición de cuentas: es difícil probar qué datos se utilizaron, cómo fueron transformados o por qué un modelo produjo determinada salida, aspectos para los cuales los auditores exigen ahora evidencia clara.

Soluciones Técnicas: Defensa Basada en Código

Para abordar estos desafíos, los equipos de seguridad están integrando protecciones a nivel de código en los flujos de trabajo de la IA, asegurando que los sistemas sigan siendo explicables, medibles y cumplan con las normativas.

Los mecanismos de defensa generativa se basan en bucles de retroalimentación autoaprendices que refinan de forma continua las líneas base y las respuestas.

1. Saneamiento de Entradas y Filtrado de Amenazas

Filtrar las solicitudes, registros y datos de consultas antes del análisis previene ataques de inyección y mitiga la manipulación del contexto.

import re

def sanitize_payload(data: str) -> str:

"""Bloquear patrones o comandos peligrosos antes de la ingestión por parte de la IA."""

blocked = [r"delete", r"drop\s+table", r"system:", r"ignore\s+previous"]

for term in blocked:

data = re.sub(term, "[BLOQUEADO]", data, flags=re.IGNORECASE)

return data.strip()

# Ejemplo de uso

payload = "system: drop table users;"

print(sanitize_payload(payload))

# Salida: [BLOQUEADO] [BLOQUEADO] users;

Este filtro basado en reglas, aunque simple, sigue siendo una de las protecciones más prácticas.

Neutraliza las instrucciones maliciosas incrustadas en chats o entradas de consultas que podrían desencadenar comandos destructivos del sistema, siendo un vector clave en ataques de inyección de prompts y exfiltración de datos.

2. Detección de Anomalías con Modelado Generativo

La IA generativa puede modelar la actividad normal y señalar desviaciones de forma autónoma.

En lugar de utilizar umbrales estáticos, los modelos adaptativos analizan patrones en tiempo real, aprendiendo las normas contextuales que evolucionan con las cargas de trabajo.

import statistics

class BehaviorModel:

def __init__(self):

self.history = []

def record_query_time(self, latency_ms: float):

self.history.append(latency_ms)

def detect_anomaly(self, current_latency: float) -> bool:

"""Detectar anomalías en comparación con la línea base aprendida."""

if len(self.history) < 5:

return False

mean = statistics.mean(self.history)

stdev = statistics.stdev(self.history)

return abs(current_latency - mean) > 2 * stdev

# Ejemplo

bm = BehaviorModel()

for t in [120, 130, 125, 128, 126]:

bm.record_query_time(t)

print(bm.detect_anomaly(200)) # True

Cuando se integra con la monitorización de la actividad de la base de datos, este enfoque se adapta de forma continua, detectando no sólo anomalías, sino también cambios emergentes en el comportamiento que pueden indicar amenazas internas en evolución o intrusiones asistidas por IA.

3. Registro de Auditoría Seguro para Operaciones Impulsadas por IA

Los registros son el ADN de la ciberseguridad: permiten la visibilidad, la trazabilidad y la rendición de cuentas.

Los registros de auditoría inmutables y firmados criptográficamente respaldan la verificación del cumplimiento y las investigaciones forenses bajo marcos normativos como el NIST AI RMF.

import datetime

import hashlib

import json

def log_ai_event(event_type: str, user: str, details: dict):

"""Registrar eventos de IA verificables criptográficamente."""

timestamp = datetime.datetime.utcnow().isoformat()

record = {

"timestamp": timestamp,

"event": event_type,

"user": user,

"details": details

}

record_str = json.dumps(record, sort_keys=True)

record["hash"] = hashlib.sha256(record_str.encode()).hexdigest()

print(json.dumps(record, indent=2))

log_ai_event("threat_detected", "analyst01", {"severity": "high", "source": "GenAI module"})

Estos registros ayudan a verificar quién desencadenó qué y por qué, formando cadenas de evidencia resistentes a manipulaciones.

Combinados con la protección continua de datos, permiten a las organizaciones reconstruir la cadena completa de decisiones de la IA, un requisito fundamental en los próximos regímenes regulatorios sobre la IA.

Estrategias Organizacionales para la Defensa con IA Generativa

La tecnología por sí sola no puede resolver el panorama de amenazas en evolución. La preparación organizacional, la gobernanza y la integración entre equipos son igualmente cruciales.

1. Centros de Operaciones de Seguridad Aumentados con IA (A-SOC)

Los Centros de Operaciones de Seguridad (SOC) están evolucionando hacia ecosistemas adaptativos.

Los agentes de IA ahora asisten a los analistas humanos resumiendo alertas, prediciendo caminos de escalada y recomendando mitigaciones basadas en resultados históricos.

Combinados con notificaciones en tiempo real, estos copilotos de IA reducen drásticamente el tiempo de respuesta a incidentes mientras mantienen el contexto en medio de miles de eventos de seguridad diarios.

2. Simulación de Red Team y Emulación de Amenazas

La IA generativa puede actuar como un compañero del red team, generando constantemente nuevas variaciones de exploits conocidos y poniendo a prueba las defensas corporativas.

Cuando se utiliza de forma ética, esto acelera la preparación del blue team y valida el rendimiento del firewall de la base de datos en escenarios complejos y con múltiples vectores.

Este ciclo de retroalimentación — simulación de ataques, detección, refinamiento — crea un sistema de seguridad vivo que aprende tanto de adversarios reales como sintéticos.

3. Cero Confianza y Aislamiento Contextual

Adoptar un marco de Cero Confianza garantiza que ningún componente del sistema sea intrínsecamente confiable.

Cada conexión, conjunto de datos y llamada a la API se verifica de forma continua, a menudo múltiples veces.

Utilizar control de acceso basado en roles y enmascaramiento de datos en cada capa asegura que los datos sensibles permanezcan protegidos incluso en entornos de IA colaborativos o federados.

La combinación de autorización consciente del contexto y el aislamiento con privilegios mínimos ayuda a contener posibles exploits generados por IA antes de que se propaguen.

4. Supervisión Ética y Regulatoria

Los modelos generativos toman decisiones que pueden impactar la privacidad, el cumplimiento normativo e incluso la reputación.

Por ello, la supervisión no es opcional, es una salvaguarda. Se deben establecer comités de ética internos o juntas de gobernanza de la IA responsables de revisar los conjuntos de datos, evaluar los sesgos y garantizar la transparencia regulatoria.

La documentación de estos controles brinda seguridad durante las auditorías y protege contra futuros marcos de responsabilidad en IA.

La Imperativa del Cumplimiento

A medida que los reguladores refuerzan el control sobre los ecosistemas de IA, la rendición de cuentas se vuelve medible.

Las organizaciones deben demostrar no solo la seguridad técnica, sino también una madurez en la gobernanza, es decir, cómo monitorean, registran e informan sobre el comportamiento de la IA.

| Regulación | Requisito de Seguridad en IA | Enfoque de Solución |

|---|---|---|

| GDPR | Proteger los DIP usados en el entrenamiento e inferencia del modelo | Descubrimiento automático, clasificación y enmascaramiento de datos sensibles |

| HIPAA | Proteger la información de salud protegida (PHI) en análisis de salud y modelos de IA | Enmascaramiento dinámico, encriptación y aplicación de controles de acceso |

| PCI DSS 4.0 | Asegurar la encriptación de datos de pago en la detección de fraudes basada en IA | Encriptación de extremo a extremo y tokenización a través de proxies seguros |

| NIST AI RMF | Documentar el riesgo del modelo de IA y mantener registros de procedencia | Registros de auditoría inmutables, versionado y puntuación continua de riesgos |

El cumplimiento no es solo un requisito legal, es un diferenciador competitivo.

Las empresas que demuestran una gobernanza transparente de la IA ganan la confianza de los usuarios y reducen la fricción con auditores, clientes y socios.

Conclusión: Implementar una Defensa en Profundidad a Velocidad de Máquina

La próxima generación de ciberseguridad opera en el mismo terreno que sus adversarios: datos, algoritmos y automatización.

La IA generativa redefine este campo de batalla, transformando la defensa de barreras estáticas a sistemas dinámicos y autoaprendientes.

Asegurar infraestructuras habilitadas para la IA requiere un enfoque en capas y adaptativo:

- Prevención mediante saneamiento de entradas, filtros contextuales y validación de integridad

- Detección a través de modelado adaptativo de anomalías y líneas base de comportamiento en tiempo real

- Respuesta mediante remediación automatizada y registros de auditoría inmutables

- Gobernanza que abarque marcos de cumplimiento y supervisión ética de la IA

Cuando se combinan, estas capas crean una estructura de defensa que mejora continuamente, siendo capaz de pensar como un atacante mientras actúa como un custodio.

El futuro de la ciberseguridad no será simplemente más rápido; será predictivo, autónomo y transparente.

Al adoptar los principios de defensa generativa, las empresas pueden transformar los sistemas de IA de activos de alto riesgo en motores de confianza, cumplimiento y resiliencia.

Protege tus datos con DataSunrise

Protege tus datos en cada capa con DataSunrise. Detecta amenazas en tiempo real con Monitoreo de Actividad, Enmascaramiento de Datos y Firewall para Bases de Datos. Garantiza el Cumplimiento de Datos, descubre información sensible y protege cargas de trabajo en más de 50 integraciones de fuentes de datos compatibles en la nube, en instalaciones y sistemas de IA.

Empieza a proteger tus datos críticos hoy

Solicita una Demostración Descargar Ahora