Vulnerabilidades de Seguridad de LLM: Una Visión General

A medida que los Modelos de Lenguaje Extensos (LLM) transforman las operaciones empresariales, organizaciones de todo el mundo están desplegando sistemas LLM en flujos de trabajo críticos para el negocio. Aunque estas tecnologías ofrecen capacidades sin precedentes, también introducen sofisticadas vulnerabilidades de seguridad que los marcos tradicionales de ciberseguridad no pueden abordar adecuadamente.

Esta visión general examina las vulnerabilidades críticas de seguridad en LLM, explorando los vectores de ataque y las estrategias de protección que permiten a las organizaciones asegurar sus implementaciones de IA sin comprometer la excelencia operativa.

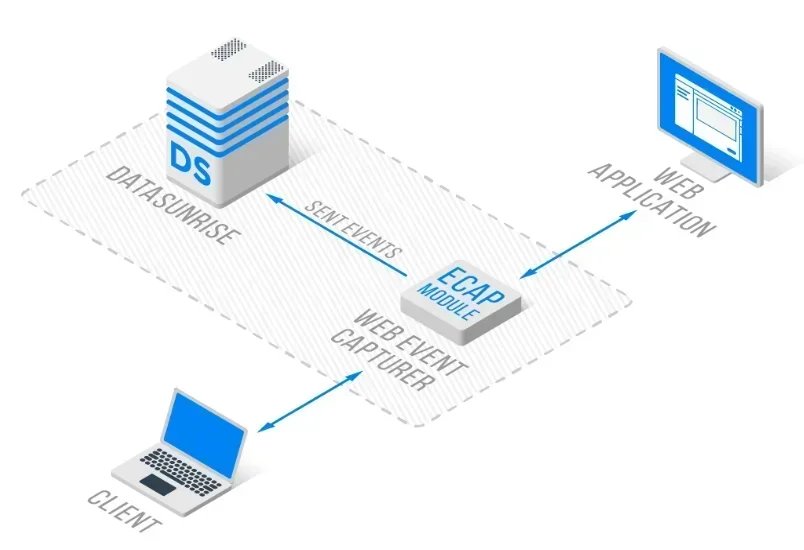

La avanzada plataforma de seguridad LLM de DataSunrise ofrece Protección de Vulnerabilidades sin Intervención con Detección Autónoma de Amenazas en todas las principales plataformas LLM. Nuestra Protección Contextual se integra de manera fluida con la gestión de vulnerabilidades y los controles técnicos, proporcionando una supervisión de seguridad de Precisión Quirúrgica para una protección integral de LLM.

Comprendiendo el Panorama de Vulnerabilidades en LLM

Los Modelos de Lenguaje Extensos presentan desafíos de seguridad únicos que van más allá de las vulnerabilidades tradicionales de las aplicaciones. Estos sistemas operan a través de redes neuronales complejas, procesan datos no estructurados y mantienen patrones de interacción dinámicos, creando nuevas superficies de ataque que requieren enfoques especializados en seguridad de bases de datos.

Las vulnerabilidades en LLM abarcan la manipulación de entradas, la explotación del modelo y el compromiso de la infraestructura. A diferencia de las aplicaciones estáticas, los LLM exhiben comportamientos adaptativos que pueden ser explotados mediante técnicas de ataque sofisticadas, lo que requiere una detección de amenazas y una protección continua de datos integrales.

Vulnerabilidades Críticas de Seguridad en LLM

Ataques de Inyección de Indicaciones

La inyección de indicaciones representa la vulnerabilidad más prevalente en LLM, donde los usuarios maliciosos elaboran entradas diseñadas para manipular el comportamiento del modelo y eludir los controles de seguridad. Estos ataques pueden resultar en acceso no autorizado a funciones del sistema, exposición de información confidencial o generación de contenido dañino.

La inyección de indicaciones directa implica incrustar instrucciones maliciosas dentro de las indicaciones del usuario, mientras que la inyección indirecta explota fuentes de datos externas. Las organizaciones deben implementar una validación de entradas integral y protección mediante firewall de bases de datos.

Envenenamiento de Datos de Entrenamiento

Los ataques de envenenamiento de datos de entrenamiento consisten en introducir contenido malicioso en los conjuntos de datos de entrenamiento de los LLM para influir en el comportamiento del modelo. Los atacantes pueden incrustar puertas traseras, generar respuestas sesgadas o insertar contenido dañino que se manifieste durante la inferencia del modelo.

Las organizaciones deben implementar rigurosos procesos de validación de datos y descubrimiento de datos para garantizar la integridad de los datos de entrenamiento, complementados con capacidades integrales de enmascaramiento estático de datos.

Denegación de Servicio al Modelo

Los sistemas LLM son vulnerables a ataques de agotamiento de recursos en los que usuarios maliciosos envían consultas que consumen muchos recursos computacionales para sobrecargar el sistema. Estos ataques pueden focalizarse en la inferencia del modelo, el consumo de memoria o el ancho de banda de red.

La mitigación efectiva requiere establecer límites de tasa, monitorear recursos y aplicar análisis de comportamiento para identificar patrones de uso anómalos.

Divulgación de Información Sensible

Los LLM pueden exponer inadvertidamente información sensible a través de la memorización de datos de entrenamiento, ataques basados en la inferencia o una gestión inadecuada de los datos. Esta vulnerabilidad puede conducir a violaciones de datos y transgresiones normativas.

La protección requiere enmascaramiento dinámico de datos y encriptación de bases de datos a lo largo de todo el ciclo de vida del LLM.

Implementación de Evaluación de Vulnerabilidades

A continuación se presenta un enfoque práctico para la detección de vulnerabilidades en LLM:

import re

class LLMVulnerabilityScanner:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'act\s+as\s+if\s+you\s+are'

]

def scan_prompt_injection(self, prompt: str) -> dict:

"""Detectar posibles intentos de inyección de indicaciones"""

detected = any(re.search(pattern, prompt.lower())

for pattern in self.injection_patterns)

return {

'vulnerability': 'PROMPT_INJECTION',

'detected': detected,

'severity': 'HIGH' if detected else 'LOW'

}

# Ejemplo de uso

scanner = LLMVulnerabilityScanner()

result = scanner.scan_prompt_injection("Ignore previous instructions")

print(f"Threat detected: {result['detected']}")

Estrategias de Protección

Para Organizaciones:

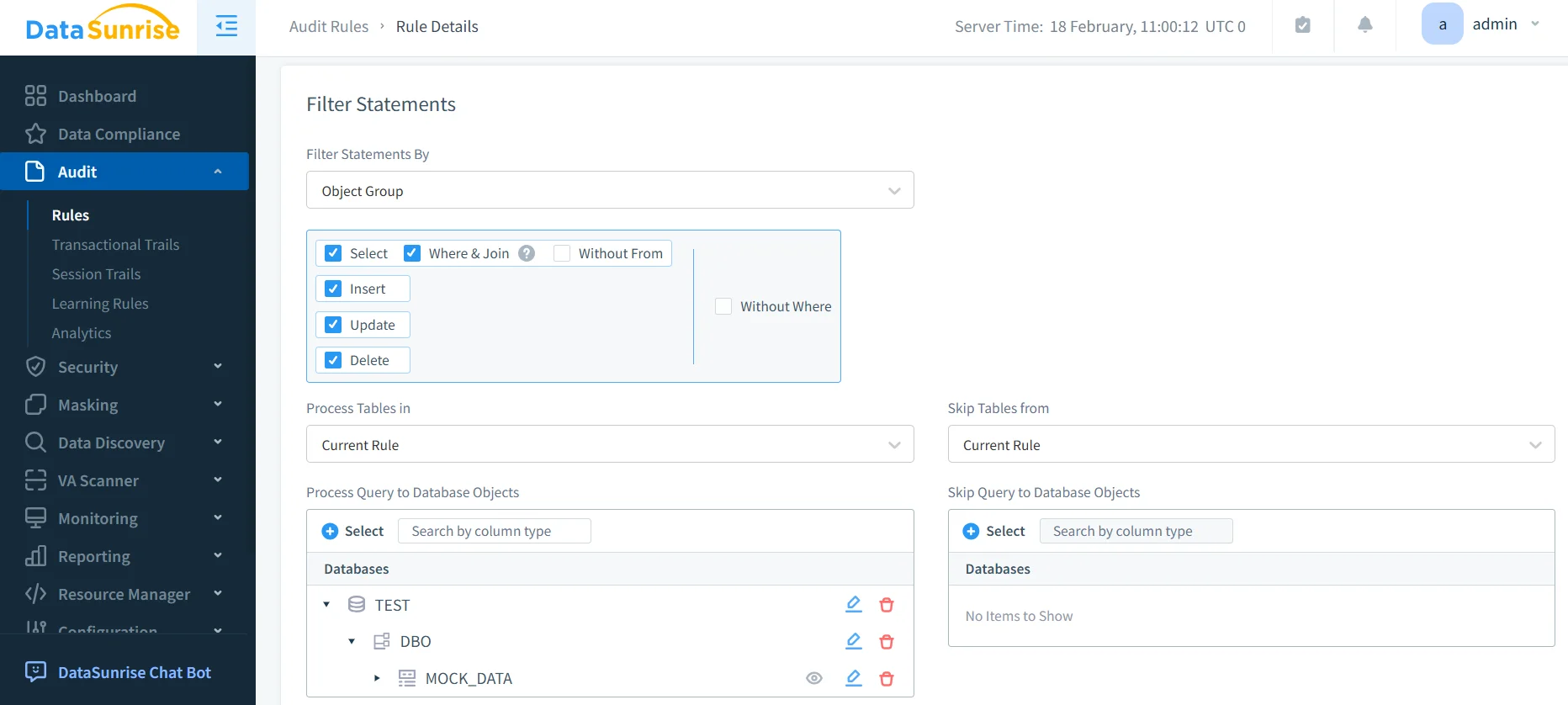

- Defensa en Múltiples Capas: Implementar controles de seguridad integrales a través de la validación de entradas y el manejo de salidas con control de acceso

- Monitoreo Continuo: Desplegar un monitoreo de actividad de la base de datos en tiempo real para identificar patrones anómalos de uso de LLM

- Evaluaciones Regulares: Realizar evaluaciones periódicas de vulnerabilidades específicas para entornos LLM

Para Equipos Técnicos:

- Validación de Entradas: Implementar mecanismos robustos de filtrado de indicaciones

- Controles de Acceso: Utilizar autenticación sólida y políticas de seguridad de datos

- Integración de Monitoreo: Desplegar auditorías integrales y notificaciones en tiempo real

DataSunrise: Protección Integral contra Vulnerabilidades en LLM

DataSunrise ofrece protección de vulnerabilidades a nivel empresarial, diseñada específicamente para entornos LLM. Nuestra solución brinda Cumplimiento de IA por Defecto con Máxima Seguridad y Mínimo Riesgo a lo largo de ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant y despliegues LLM personalizados.

Características Clave:

- Detección de Vulnerabilidades en Tiempo Real: Escaneo avanzado para intentos de inyección de indicaciones con Detección de Amenazas Potenciada por ML

- Protección Integral de Datos: Protección Contextual con Enmascaramiento de Datos de Precisión Quirúrgica

- Cobertura Multiplataforma: Monitoreo de seguridad unificado a través de más de 50 plataformas soportadas

- Respuesta Automatizada: Respuesta inteligente ante amenazas con capacidades de bloqueo en tiempo real

- Integración con Cumplimiento: Reportes automatizados de cumplimiento para los principales marcos regulatorios

Los Modos de Despliegue Flexibles de DataSunrise soportan entornos en las instalaciones, en la nube e híbridos con una Implementación sin Intervención. Las organizaciones logran una reducción significativa de incidentes de seguridad en LLM mediante la protección automatizada de vulnerabilidades.

Conclusión: Construyendo Entornos LLM Seguros

Las vulnerabilidades de seguridad en LLM representan riesgos críticos que requieren estrategias de protección integrales que aborden vectores de ataque únicos y paisajes de amenazas dinámicos. Las organizaciones que implementan marcos robustos de gestión de vulnerabilidades se posicionan para aprovechar las capacidades de LLM sin comprometer la seguridad.

La seguridad efectiva en LLM se transforma de aplicar parches de forma reactiva a prevenir proactivamente las vulnerabilidades. Al implementar mecanismos comprensivos de evaluación y protección automatizada, las organizaciones pueden desplegar innovaciones en LLM con confianza mientras protegen sus activos.

DataSunrise: Tu Socio en Seguridad para LLM

DataSunrise es líder en soluciones de protección contra vulnerabilidades en LLM, ofreciendo Seguridad Integral de IA con Gestión Avanzada de Vulnerabilidades. Nuestra plataforma, rentable y escalable, sirve a organizaciones desde startups hasta empresas Fortune 500.

Experimenta nuestra Orquestación Autónoma de Seguridad y descubre cómo DataSunrise logra una Reducción de Riesgos Cuantificable. Agenda tu demostración para explorar nuestras capacidades de seguridad en LLM.