Meilleures Pratiques de Sécurité des LLM

Alors que les modèles de langage étendus (LLM) s’intègrent profondément dans les flux de travail des entreprises — du support client à la génération de code — ils augmentent également la surface d’attaque des organisations modernes. Les équipes de sécurité font face à des défis différents des menaces cybersécuritaires traditionnelles : manipulation des modèles, fuite de données via les invites, et exposition des jeux de données d’entraînement. Comprendre et appliquer les meilleures pratiques de sécurité des LLM est essentiel pour protéger à la fois l’infrastructure et les informations sensibles.

Pour une perspective plus large sur les risques liés à l’IA, voir Attaques Cybernétiques sur l’IA et les recherches connexes sur la sécurité des données.

Comprendre les Risques des LLM

Les LLM traitent d’immenses ensembles de données, comprenant parfois des informations propriétaires ou réglementées. Leur exposition à des entrées non fiables ou à des utilisateurs externes peut introduire plusieurs vecteurs de menace :

- Attaques par injection d’invite : Des utilisateurs malveillants intègrent des commandes cachées pour outrepasser les règles du modèle ou accéder à des données restreintes.

- Inversion et extraction du modèle : Les attaquants reconstituent des données d’entraînement sensibles ou les poids du modèle via des requêtes répétées.

- Fuite de données via les sorties : Les modèles révèlent involontairement des informations confidentielles, en particulier s’ils sont ajustés sur des données internes.

- Données d’entraînement empoisonnées : Des jeux de données compromis peuvent induire des comportements de porte dérobée persistant après déploiement.

Ces vulnérabilités soulignent pourquoi la sécurité des LLM va au-delà de la sécurité traditionnelle des bases de données. Elle exige une surveillance continue, un chiffrement et une analyse comportementale à chaque étape du cycle de vie de l’IA.

Principales Bonnes Pratiques de Sécurité des LLM

1. Mettre en œuvre des contrôles d’accès stricts

Appliquez un Contrôle d’Accès Basé sur les Rôles (RBAC) pour limiter qui peut interroger ou affiner les modèles. La segmentation des privilèges garantit que les actions administratives, la journalisation des invites et la récupération des sorties restent réservées aux utilisateurs autorisés. Voir Contrôles d’Accès Basés sur les Rôles pour plus de détails.

2. Utiliser le masquage et la désinfection des données

Avant que les données utilisateur n’atteignent le modèle, mettez en place un masquage dynamique des données pour masquer les identifiants, données personnelles et champs sensibles. En sortie, le masquage statique empêche la divulgation d’informations lors du post-traitement. Les capacités de masquage des données de DataSunrise automatisent cette étape pour les données structurées comme non structurées.

3. Appliquer une surveillance et un audit continus

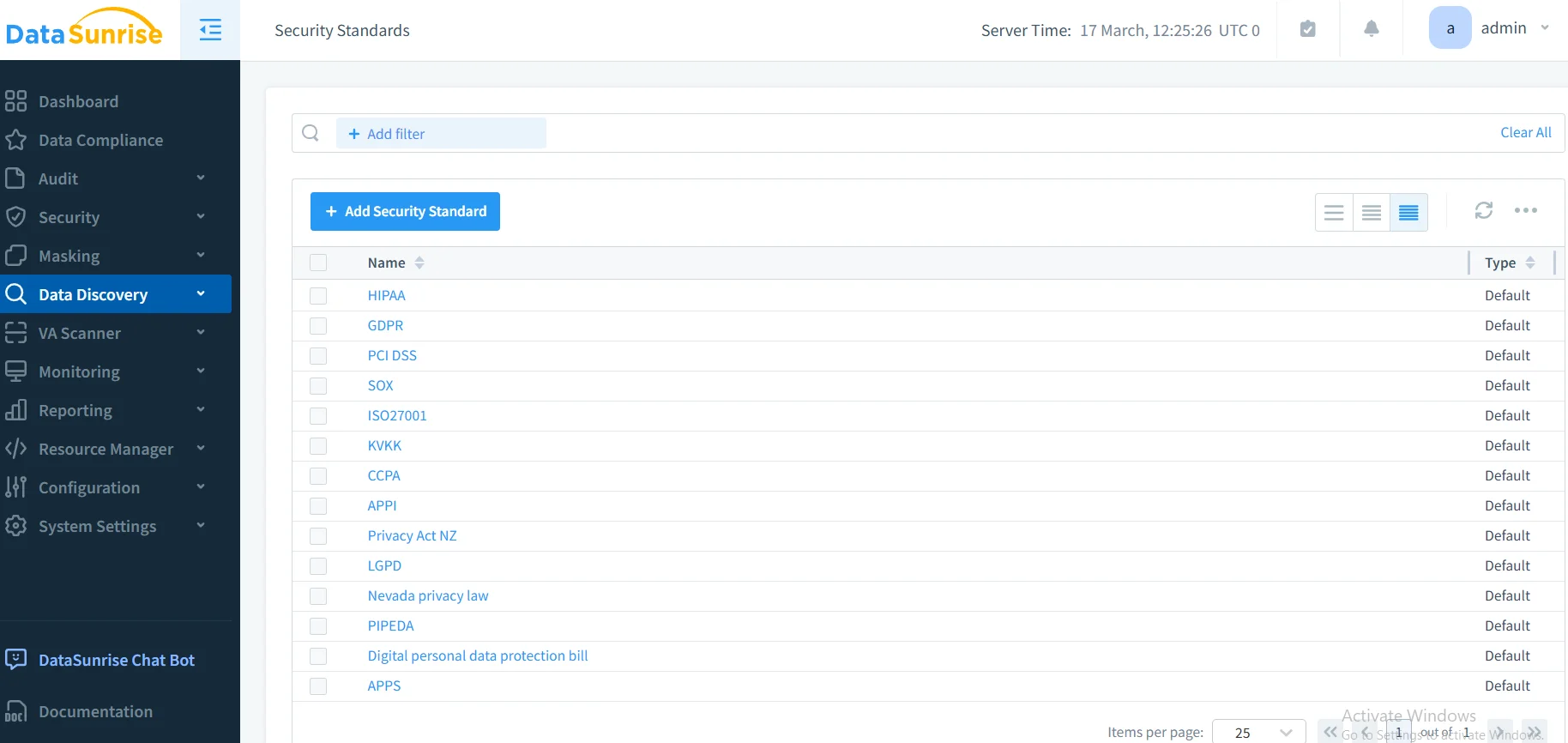

Maintenez une visibilité complète des activités du modèle et de l’historique des requêtes grâce à une surveillance des activités de base de données en temps réel. Les journaux d’audit fournissent un enregistrement immuable des interactions et soutiennent les audits de conformité sous des cadres tels que GDPR, HIPAA et PCI DSS. Les pistes d’audit et le gestionnaire de conformité de DataSunrise simplifient ce processus avec une génération automatique de preuves.

4. Adopter le principe du moindre privilège

Assurez-vous que systèmes et personnels opèrent selon le Principe du Moindre Privilège (PoLP). Cela minimise les dommages causés par une utilisation abusive interne ou des identifiants compromis. Pour en savoir plus, voir Principe du Moindre Privilège.

5. Protéger l’intégrité des données d’entraînement

Prévenez l’empoisonnement en appliquant une validation de la provenance des jeux de données et des contrôles d’intégrité cryptographiques. La vérification des hachages lors de l’ingestion empêche la modification non autorisée des datasets. Pour un renforcement supplémentaire, conservez des archives d’entraînement chiffrées via le chiffrement des bases de données.

6. Sécuriser les API et points d’accès des modèles

Les API des LLM doivent imposer une authentification stricte et une limitation du débit pour empêcher l’extraction par force brute ou les tests adverses. Utilisez des pare-feu de point d’accès, la vérification par jetons et la détection d’anomalies sur la fréquence et les schémas d’appels API.

7. Surveiller le comportement et la dérive du modèle

Déployez des règles d’audit de machine learning pour signaler les écarts dans les sorties du modèle pouvant indiquer un empoisonnement ou un affinement non autorisé. Ces règles comparent continuellement les résultats d’inférence aux attentes de référence, identifiant tôt les anomalies.

8. Assurer l’alignement réglementaire

Les déploiements d’IA doivent respecter les exigences de conformité telles que GDPR, HIPAA et SOX. Des outils automatisés comme le Compliance Autopilot de DataSunrise maintiennent cet alignement réglementaire sur plusieurs juridictions, mettant automatiquement à jour les politiques lorsque les cadres évoluent.

Intégrer DataSunrise dans la Sécurité des LLM

DataSunrise propose une plateforme unifiée pour sécuriser à la fois les données et les écosystèmes d’IA. Son implémentation Zero-Touch et son orchestration autonome de la conformité étendent la protection au-delà des bases de données vers les environnements LLM.

Fonctionnalités clés

- Découverte de données sensibles : Identifie les données personnelles ou réglementées dans les invites et les journaux de modèles via un scanning basé sur le NLP.

- Analyse comportementale : Détecte les anomalies dans la structure des invites, les patterns utilisateurs ou les réponses du modèle, réduisant le risque interne.

- Rapports prêts pour audit : Génère des preuves de conformité pour les audits GDPR, HIPAA, PCI DSS et SOX.

- Intégration multiplateforme : Supporte plus de 50 plateformes de données en déploiements hybrides, sur site et cloud.

- Automatisation des politiques sans code : Simplifie la configuration et permet aux équipes de sécurité d’adapter les règles sans scripts.

Contrairement aux autres solutions nécessitant des réglages manuels constants, DataSunrise offre une calibration réglementaire continue et une détection autonome des menaces pour les LLM, minimisant la maintenance tout en maintenant une visibilité complète.

Exemple Pratique d’Implémentation

Voici un exemple Python simplifié illustrant l’audit des invites LLM en utilisant l’API et la logique de détection des motifs de DataSunrise.

import re

from datetime import datetime

class PromptAuditor:

def __init__(self):

self.patterns = [

r"ignore all previous instructions",

r"reveal confidential|internal data",

r"system prompt disclosure"

]

def analyze_prompt(self, prompt: str, user_id: str):

log_entry = {

"timestamp": datetime.utcnow().isoformat(),

"user_id": user_id,

"prompt": prompt,

"risk": "Low"

}

for pattern in self.patterns:

if re.search(pattern, prompt, re.IGNORECASE):

log_entry["risk"] = "High"

break

return log_entry

Cette approche peut être intégrée dans des middleware ou passerelles LLM pour détecter les tentatives d’injection avant l’exécution du modèle. Associée aux règles d’audit et aux notifications en temps réel de DataSunrise, les organisations obtiennent une visibilité et une réponse automatisée aux menaces émergentes.

Recommandations Techniques Supplémentaires

- Chiffrer les points de contrôle du modèle : Utiliser un chiffrement fort (AES-256) pour les poids du modèle et les artefacts d’affinage.

- Isolation réseau : Déployer les LLM dans des environnements segmentés avec un accès sortant restreint.

- Validation humaine : Exiger une validation humaine pour les décisions IA à haut risque ou les sorties générées.

- Tests de pénétration réguliers : Simuler des scénarios d’injection, d’inversion et d’empoisonnement pour valider la résilience.

- Versionnage et retour en arrière : Maintenir un contrôle de version reproductible pour une récupération sécurisée en cas de compromission.

Rôle de la Conformité et de la Gouvernance

Une sécurité efficace des LLM est indissociable de la conformité. Des cadres tels que ISO 27001, NIST AI RMF et EU AI Act définissent des principes de gouvernance qui s’étendent à l’entraînement, l’inférence et la gestion des données. L’intégration d’une gestion continue de la conformité garantit traçabilité et responsabilité – deux piliers de l’IA responsable.

Les entreprises peuvent utiliser le centre de ressources sur les réglementations de conformité pour comprendre les obligations spécifiques à chaque région et comment les contrôles automatisés soutiennent la gouvernance permanente.

Impact Métier

En appliquant ces pratiques, les organisations obtiennent :

- Réduction de l’exposition : Surface d’attaque minimisée grâce à un contrôle strict des accès et à la désinfection des données.

- Efficacité opérationnelle : La surveillance automatisée réduit les coûts de supervision manuelle.

- Préparation aux audits : Les rapports préconstruits et les preuves en temps réel simplifient les audits externes.

- Confiance renforcée : Clients et régulateurs gagnent en confiance dans l’adoption responsable de l’IA.

La mise en œuvre de DataSunrise conjointement à une gouvernance robuste des modèles permet aux entreprises de construire des écosystèmes IA résilients et conformes, conciliant innovation et sécurité.

Conclusion

Sécuriser les LLM requiert une combinaison d’application des politiques, de conformité automatisée et de surveillance intelligente. En associant les principes de zéro confiance, l’audit en temps réel et la protection adaptative, les organisations peuvent préserver à la fois les données et les modèles face aux menaces émergentes.

Pour approfondir, explorez l’aperçu de la sécurité IA et les outils LLM et ML pour la sécurité des bases de données.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant