Minacce AI e Rischi di Sicurezza

L’Intelligenza Artificiale è diventata un pilastro centrale della tecnologia aziendale moderna — ottimizzando decisioni, rilevando frodi e abilitando analisi in tempo reale attraverso i settori.

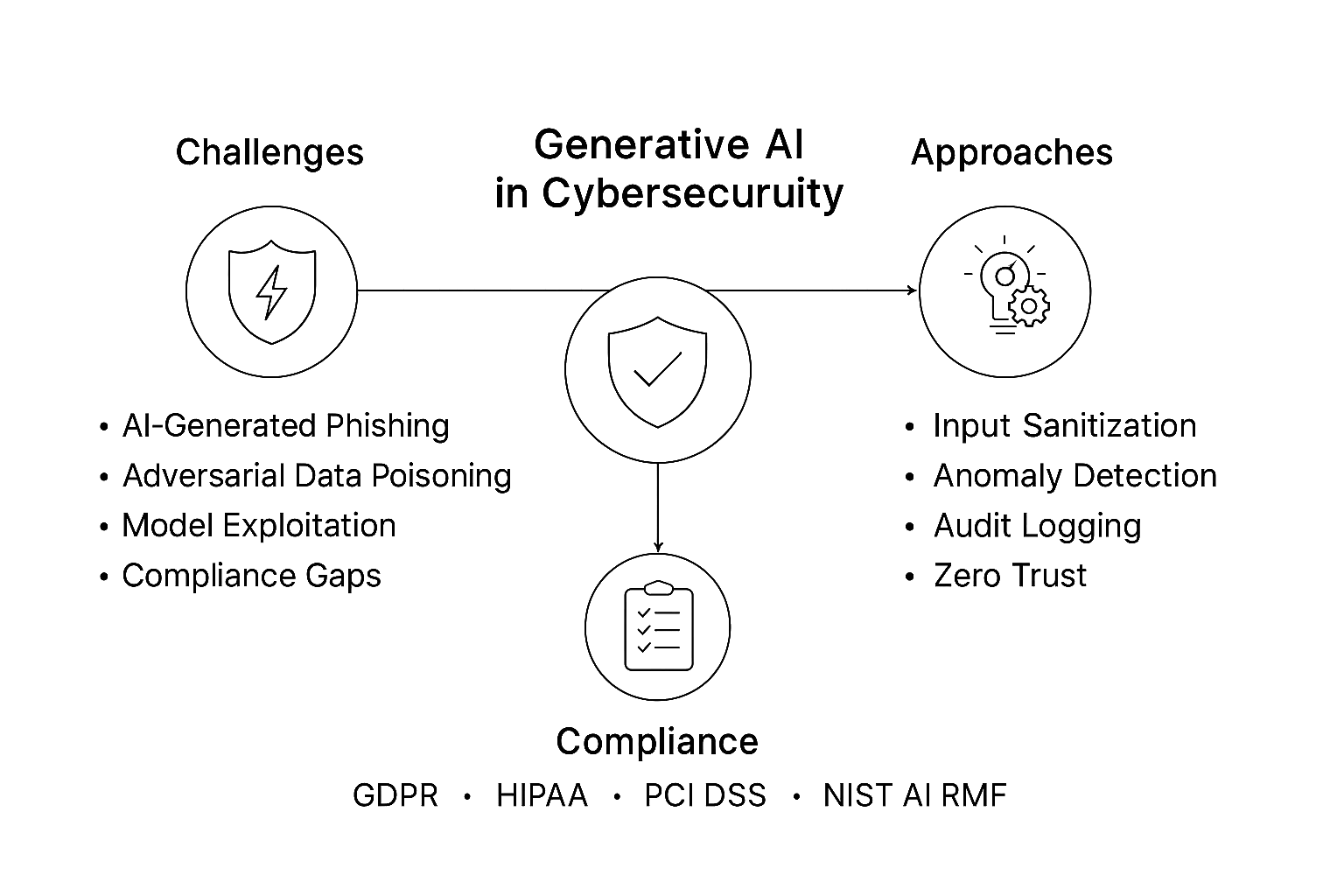

Tuttavia, man mano che i sistemi AI crescono in complessità e autonomia, crescono anche le minacce AI e le superfici di attacco. Gli avversari hanno iniziato ad armare l’AI stessa, usando modelli generativi, addestramento adversariale e tecniche automatizzate di sfruttamento per superare i difensori umani.

Oggi sempre più organizzazioni affrontano nuove categorie di rischio informatico direttamente legate all’adozione dell’AI. Dalla manipolazione dei modelli all’estrazione dei dati, i vantaggi dell’AI possono facilmente trasformarsi in vulnerabilità se lasciati incustoditi.

Comprendere le Minacce AI

I sistemi AI elaborano massicci dataset, si adattano autonomamente e prendono decisioni ad alto impatto — caratteristiche che li rendono anche attraenti per gli attaccanti.

Le minacce possono verificarsi in ogni fase del ciclo di vita dell’AI: dalla acquisizione dati all’inferenza del modello.

1. Avvelenamento dei Dati

I modelli AI apprendono da ciò che viene loro fornito. Dataset avvelenati — contenenti campioni manipolati o etichettati erroneamente — possono alterare i confini decisionali di un modello.

Nel rilevamento delle intrusioni, questo potrebbe far apparire attività dannose come innocue. Anche una contaminazione minima può ridurre significativamente la precisione, un fenomeno spesso invisibile finché non viene sfruttato in produzione.

2. Inversione ed Estrazione del Modello

Quando gli utenti interrogano ripetutamente un modello distribuito, possono dedurre schemi che rivelano dati interni o parametri.

Gli attaccanti hanno ricostruito dataset proprietari e attributi sensibili (come dettagli medici o indicatori finanziari) solamente dalle risposte del modello — eseguendo di fatto una spionaggio AI.

3. Esempi Adversariali

Piccole perturbazioni accuratamente progettate negli input — come modifiche impercettibili ai pixel o alterazioni negli embedding — possono ingannare completamente i sistemi AI.

Un’auto a guida autonoma potrebbe interpretare un segnale di stop come un limite di velocità, o un rilevatore di frodi potrebbe classificare transazioni sospette come normali. Questi exploit non richiedono accesso al codice, solo all’interfaccia esposta del modello.

4. Deepfake Generativi

Modelli di generazione di testo, immagini e voce sono utilizzati per fabbricare identità, diffondere disinformazione ed eseguire campagne di social engineering su larga scala.

Combinati con sistemi di distribuzione automatizzati, i deepfake creano attacchi di phishing o di impersonificazione altamente convincenti che superano filtri tradizionali.

5. Sfruttamento di Agenti Autonomi

Agenti AI capaci di eseguire comandi, pianificare azioni o accedere a API possono essere manipolati per compiere operazioni dannose.

Prompt maligni, noti come iniezioni di prompt, possono sovrascrivere regole, causare fughe di dati o eseguire flussi di lavoro non autorizzati tramite manipolazione indiretta.

Soluzioni Tecniche per la Sicurezza AI

Proteggere i sistemi AI richiede una fusione tra la disciplina classica della cybersecurity e l’intelligenza adattativa delle macchine. La progettazione difensiva inizia dallo strato dati e si estende alla continua sorveglianza e audit.

1. Validazione dell’Integrità dei Dati

Prima dell’addestramento, ogni dataset deve essere verificato per autenticità e integrità.

Lo snippet sottostante illustra un metodo di validazione basato su hashing per garantire che soltanto dati approvati entrino nella pipeline.

import hashlib

import os

def verify_dataset(path: str, expected_hash: str) -> bool:

"""Valida l’integrità del dataset usando SHA-256."""

if not os.path.exists(path):

raise FileNotFoundError("Dataset non trovato")

hasher = hashlib.sha256()

with open(path, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

hasher.update(chunk)

return hasher.hexdigest() == expected_hash

# Esempio di utilizzo

if not verify_dataset("train.csv", "a91b...c2d"):

raise ValueError("Integrità del dataset compromessa!")

Registrando le impronte digitali dei dataset nei log di audit, le organizzazioni possono rilevare manomissioni precocemente — molto prima che i campioni avvelenati raggiungano i modelli in produzione.

2. Addestramento Adversariale Difensivo

Il modo migliore per difendersi dagli input adversariali è apprendere da essi.

I team AI possono generare intenzionalmente perturbazioni e riaddestrare i modelli per migliorarne la robustezza.

import numpy as np

def adversarial_noise(x, epsilon=0.01):

"""Aggiunge piccole perturbazioni per simulare attacchi adversariali."""

noise = epsilon * np.sign(np.random.randn(*x.shape))

return np.clip(x + noise, 0, 1)

# Esempio: aumentare il set di addestramento con rumore

x_train_adv = adversarial_noise(x_train)

model.fit(x_train_adv, y_train)

Questa esposizione controllata rafforza i modelli contro attacchi reali e completa i sistemi di analisi del comportamento che monitorano anomalie nelle richieste di inferenza.

3. Audit Continuo e Spiegabilità

I framework di Explainable AI (XAI) combinati con logging immutabile permettono agli investigatori di ricostruire quali decisioni sono state prese — e perché.

Registrare ogni evento di inferenza fornisce sia trasparenza operativa che documentazione per la conformità.

import datetime, json

def log_inference(user, input_summary, prediction):

timestamp = datetime.datetime.utcnow().isoformat()

entry = {"time": timestamp, "user": user, "input": input_summary, "prediction": prediction}

print(json.dumps(entry))

log_inference("analyst01", "tentativo di login da IP sconosciuto", "segnalato_sospetto")

Questi record di audit possono essere correlati con il monitoraggio delle attività di database per individuare anomalie cross-system — collegando la logica decisionale AI con le tracce delle transazioni backend.

Strategie Organizzative per Gestire i Rischi AI

La tecnologia può arrivare fino a un certo punto senza una governance strutturata. La gestione del rischio AI deve essere incorporata nelle policy aziendali, nei flussi di lavoro di engineering e nella reportistica di conformità.

1. Stabilire Framework di Rischio AI

Adottare framework allineati con il NIST AI RMF o le linee guida sul panorama delle minacce AI di ENISA.

Questi aiutano a definire chiaramente responsabilità tra i team — data scientist, DevOps, compliance officer — assicurando che ogni componente AI subisca valutazioni di rischio e controllo delle modifiche coerenti.

2. Mettere in Sicurezza le Catene di Fornitura AI

Le pipeline AI dipendono da dati di terze parti, modelli pre-addestrati e dipendenze open source.

Tutti gli artefatti devono essere verificati tramite firme crittografiche e tracciati tramite log di provenienza immutabili.

Una singola libreria compromessa può infettare l’intero ambiente di inferenza — proprio come negli attacchi alla supply chain osservati nel DevOps tradizionale.

3. Costruire l’Integrazione tra Red Team e Blue Team

Il red teaming sull’AI significa attaccare i propri modelli prima che lo facciano gli avversari.

Eseguendo simulazioni di prompt di sfruttamento, tentativi di estrazione del modello e input adversariali, le organizzazioni identificano i punti deboli precocemente.

I blue team adattano poi regole di sicurezza e playbook di risposta di conseguenza.

4. Implementare Controlli di Accesso Context-Aware

I sistemi AI che accedono a database di produzione devono operare secondo il principio del minimo privilegio.

Integrare il controllo di accesso basato sui ruoli con segnali contestuali di rischio — posizione dell’utente, comportamento di sessione e tipo di query — per limitare dinamicamente l’accesso ai dataset sensibili.

La Dimensione della Conformità

I requisiti normativi stanno convergendo verso la responsabilità nell’AI — assicurando che i sistemi siano sia spiegabili che sicuri.

La non conformità ormai non comporta solo multe; può bloccare le operazioni in settori regolati come sanità o finanza.

| Normativa | Focus sulla Sicurezza AI | Controllo Consigliato |

|---|---|---|

| GDPR | Trasparenza nelle decisioni automatizzate | Mantenere modelli spiegabili con tracce di audit complete |

| HIPAA | Protezione delle PHI usate nelle diagnosi AI | Implementare [dynamic masking](https://www.datasunrise.com/knowledge-center/dynamic-data-masking/) e crittografia |

| PCI DSS 4.0 | Modelli AI che analizzano dati di pagamento | Applicare tokenizzazione e segmentazione degli accessi |

| SOX | Responsabilità dei modelli finanziari | Usare [audit trails](https://www.datasunrise.com/knowledge-center/audit-trails/) e log immutabili per la tracciabilità |

| NIST AI RMF | Documentazione di rischi e provenienza | Implementare continuo [data discovery](https://www.datasunrise.com/knowledge-center/data-discovery/) e validazione dell’integrità |

Una solida strategia di compliance AI non solo riduce l’esposizione ai rischi ma costruisce fiducia con regolatori, clienti e investitori — dimostrando che l’AI può essere sia innovativa che responsabile.

Conclusione: Costruire Sistemi AI Resilienti

Le minacce AI continueranno a evolversi tanto rapidamente quanto la tecnologia stessa.

Gli attaccanti non violano più solo le reti — corrompono algoritmi, manipolano dati e sfruttano debolezze cognitive nelle interazioni uomo-macchina.

Difendersi da questi rischi richiede una postura di sicurezza multilivello:

- Prevenzione — validare i dati e mettere in sicurezza la supply chain

- Rilevamento — monitorare i comportamenti usando modelli adattativi e generativi

- Risposta — mantenere log immutabili e spiegabilità per gli audit

- Governance — allinearsi con framework globali di conformità e standard etici

L’AI resterà sempre sia un’arma che uno scudo. Le organizzazioni che prospereranno saranno quelle che la trattano come entrambi — costruendo sistemi che anticipano, resistono e evolvono più velocemente delle minacce che affrontano.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora