Cloud-Datensicherheit in KI- & LLM-Bereitstellungen

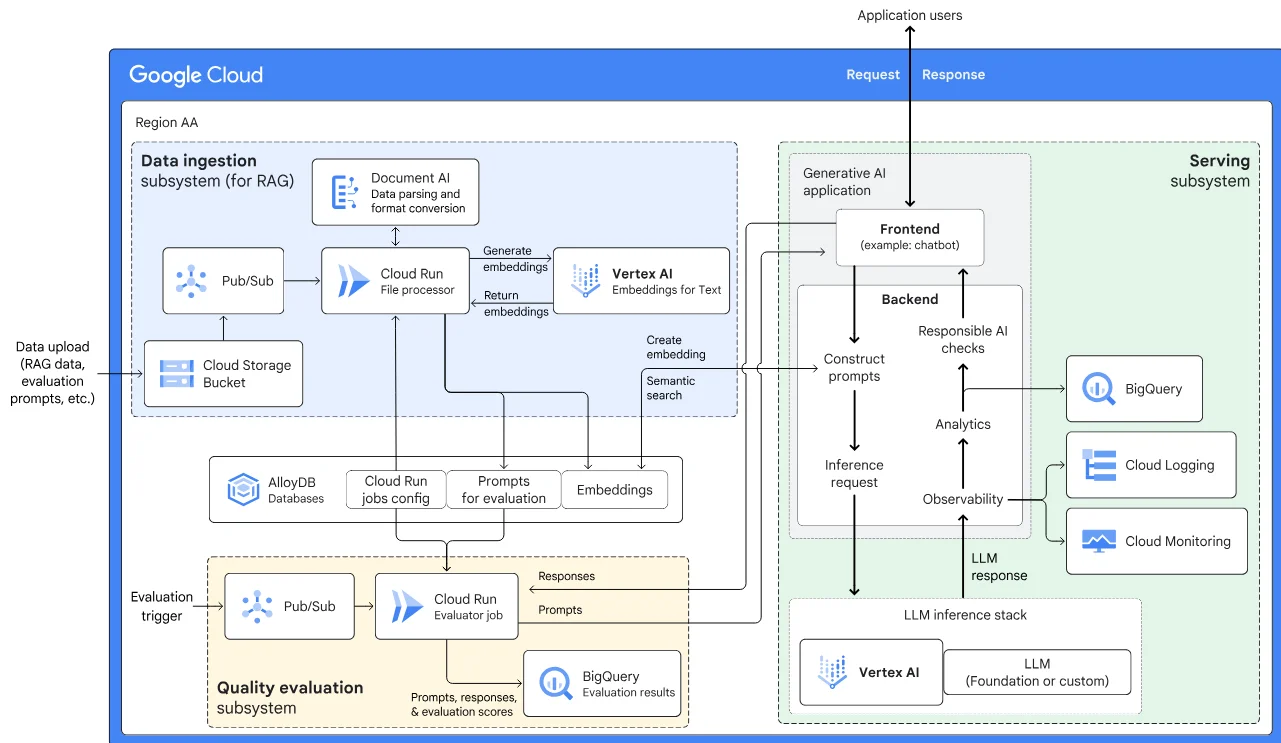

Generative KI (GenKI)-Modelle und große Sprachmodelle (LLMs) haben die Art und Weise verändert, wie cloud-native Anwendungen Daten verarbeiten und generieren. Diese Werkzeuge verbessern die Automatisierung, Entscheidungsfindung und Personalisierung, bringen jedoch auch erhebliche Herausforderungen für die Datensicherheit mit sich. Da Modelle mit sensiblen oder regulierten Informationen interagieren, wird ein sicherer und konformer Umgang unerlässlich. In diesem Artikel untersuchen wir die wesentlichen Komponenten der Cloud-Datensicherheit in KI- und LLM-Bereitstellungen, wobei der Schwerpunkt auf Echtzeit-Audit, dynamischem Maskieren, Datenentdeckung und Strategien zur Daten-Compliance liegt.

Cloud-spezifische Risiken von KI und LLMs

LLMs, die in Cloud-Umgebungen bereitgestellt werden, können sensible Unternehmensdaten aufnehmen, verarbeiten und darauf basierende Antworten generieren. Diese Antworten können unbeabsichtigt personenbezogene Identifikatoren, Geschäftsgeheimnisse oder regulierte Inhalte wie Gesundheits- oder Zahlungsinformationen preisgeben. Da Cloud-Plattformen Workloads dynamisch skalieren und verteilen, wird die Sichtbarkeit des Datenzugriffs und der Datenverarbeitung komplexer. Dieser Mangel an Transparenz und Kontrolle birgt das Risiko, dass unbefugt Daten offengelegt werden, insbesondere wenn GenKI-Ausgaben unsachgemäß protokolliert oder zwischengespeichert werden.

Sichern von KI-Workloads mit Echtzeit-Audit

Eines der grundlegenden Elemente zur Sicherung von KI- und LLM-Workflows ist die Implementierung eines Echtzeit-Audits. Echtzeit-Audits erfassen alle Interaktionen zwischen Benutzern, Diensten und der zugrunde liegenden Dateninfrastruktur. Durch die Analyse dieser Interaktionen in Echtzeit können Organisationen Richtlinienverletzungen, verdächtige Aktivitäten und verborgene Nutzungsmuster der KI erkennen.

Beispielsweise sollte beim Abfragen eines KI-Modells durch einen Benutzer, um eine Kundenprofilzusammenfassung zu generieren, ein Audit-Trail Folgendes erfassen:

SELECT * FROM customer_profiles WHERE customer_id = '12345';

Diese Spur kann dann mit der Modellausgabe verknüpft und in einem manipulationssicheren Protokoll gespeichert werden, sodass Teams das Verhalten der Abfrage untersuchen oder Compliance-Probleme diagnostizieren können. Plattformen wie DataSunrise bieten detaillierte Audit-Protokollierung, die sich in SIEMs integrieren lässt und automatisierte Warnungen sowie Visualisierungen riskanter KI-Interaktionen ermöglicht.

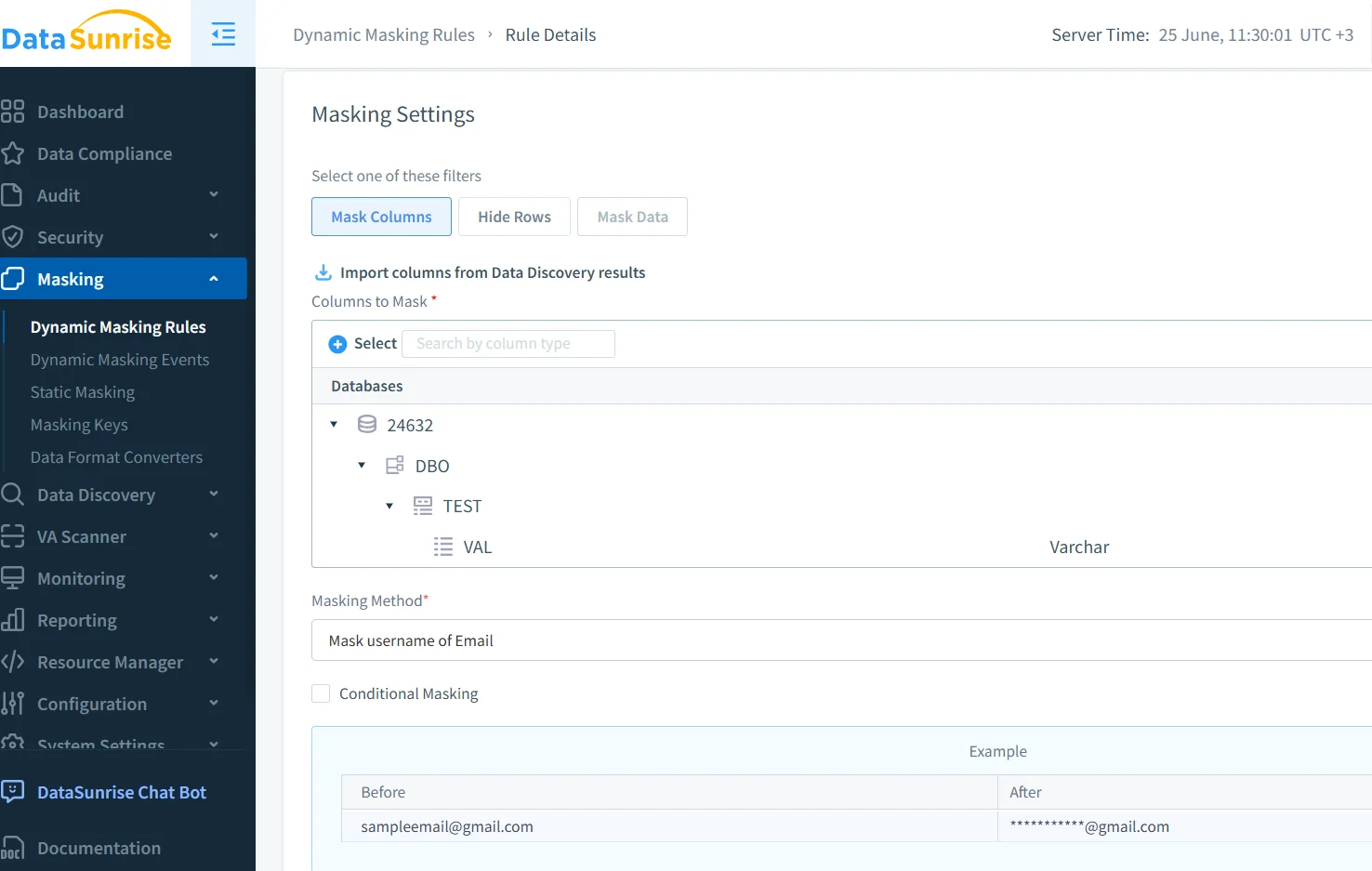

Anwenden von dynamischem Maskieren auf KI-Ausgaben

Dynamisches Maskieren spielt eine entscheidende Rolle, um Datenlecks während der GenKI-Inferenz zu verhindern. Im Gegensatz zu statischem Maskieren, das Daten im Ruhezustand verändert, erfolgt das dynamische Maskieren in Echtzeit – unmittelbar bevor die Ausgabe den Benutzer oder das Modell erreicht. Dies stellt sicher, dass sensible Felder wie Sozialversicherungsnummern, medizinische Codes oder Finanzaufzeichnungen während der KI-Interaktionen stets maskiert werden.

Stellen Sie sich ein LLM vor, das Kundendienstmitarbeitern assistiert. Wenn ein Mitarbeiter das Modell auffordert, eine Bestellung mit personenbezogenen Daten zusammenzufassen, müssen die Maskierungsregeln gewährleisten, dass Felder wie diese:

{"customer": "John Smith", "card_number": "4111-XXXX-XXXX-1234"}

sowohl an den Mitarbeiter als auch an die gespeicherten Protokolle mit maskierten Werten geliefert werden. DataSunrise unterstützt dynamisches Maskieren, das über Cloud-Datenbanken hinweg funktioniert und sich in LLM-basierte Pipelines integriert.

Aufspüren sensibler Daten, bevor sie auslaufen

KI-Modelle, die auf unbekannten Datenquellen trainiert oder abgefragt werden, sind anfällig für Informationslecks. Datenentdeckungstools helfen, dies zu verhindern, indem sie Data Lakes, Data Warehouses und Datenströme nach sensitiven Attributen durchsuchen – wie beispielsweise persönlichen Gesundheitsakten, Zugriffstoken oder Finanzkennungen. Die Integration der Entdeckungsergebnisse in GenKI-Pipelines stellt sicher, dass Modelle nur auf konforme Datensätze zugreifen.

Das Datenentdeckungsmodul von DataSunrise klassifiziert Informationen automatisch über Cloud-Speicherplattformen hinweg und unterstützt Compliance-Teams dabei, zu verhindern, dass regulierte Daten in Trainings- oder Inferenzphasen gelangen. Dieser proaktive Schritt ist der Schlüssel zur Ermöglichung sicherer KI-gesteuerter Automatisierung.

Stärkung der Compliance in KI-gesteuerten Architekturen

Da cloud-basierte KI-Systeme mit regulierten Inhalten interagieren, werden Compliance-Rahmenwerke wie DSGVO, HIPAA und PCI-DSS unerlässlich. Diese Vorschriften fordern Nachvollziehbarkeit, Datenminimierung und rollenbasierte Zugriffskontrollen. Die Anwendung dieser Kontrollen auf KI-Modelle sowie deren Ein- und Ausgaben ist heutzutage keine Option mehr.

Lösungen wie der Compliance Manager von DataSunrise ermöglichen es Sicherheitsadministratoren, maßgeschneiderte Richtlinien zu erstellen, die an Industriestandards ausgerichtet sind. Regeln können die Maskierung bestimmter Spalten erzwingen, den Modellzugriff auf Basis von Rollen einschränken oder sicherstellen, dass jede Nutzung von LLMs mit personenbezogenen Daten vollständig nachvollziehbar ist.

Mehrschichtige Sicherheit für Cloud-KI aufbauen

Sicherheit in cloud-basierten GenKI-Stapeln beruht nicht auf einer einzelnen Kontrolle. Es erfordert ein verteidigungsorientiertes Mehrschichtmodell:

- Audit: Erfassen und Analysieren von Interaktionen in Echtzeit.

- Maskieren: Verhindern der Offenlegung sensibler Inhalte.

- Entdeckung: Kartierung und Klassifizierung sensibler Datenbestände.

- Zugriffskontrollen: Implementierung kontextbezogener rollenbasierter Zugriffskontrollen (RBAC) und des Prinzips der minimalen Berechtigung.

- Compliance: Ausrichtung der Architektur an Standards wie DSGVO oder HIPAA.

Tools wie die Datenbank-Firewall von DataSunrise und Sicherheitspolicen-Vorlagen unterstützen Sicherheitsteams dabei, diese Kontrollen in KI-zentrierten Umgebungen durchzusetzen.

Externe Ressourcen wie Googles Secure AI Framework (SAIF) und NISTs AI Risk Management Framework bieten weitere Leitlinien für Organisationen, die robuste KI-Systeme aufbauen.

Fazit

Cloud-Datensicherheit in KI- & LLM-Bereitstellungen geht über den reinen Perimeterschutz hinaus. Mit der Weiterentwicklung von KI-Systemen müssen sich auch die Sicherheitsstrategien weiterentwickeln. Echtzeit-Audit-Trails, dynamisches Maskieren, intelligente Datenentdeckung und automatisierte Compliance-Schutzmaßnahmen bilden die Grundlage für vertrauenswürdige GenKI. Mit Plattformen wie DataSunrise können Unternehmen schnell agieren, ohne die Kontrolle zu verlieren, und so sichere, skalierbare und konforme KI-Innovationen ermöglichen.