Verbesserung des Datenmanagements und der Leistung durch Datenunterteilung

Einführung

Die Explosion digitaler Technologien, Internet of Things (IoT)-Geräte und Online-Interaktionen hat enorme Datenmengen erzeugt, die gesammelt und analysiert werden können. In der heutigen datengesteuerten Welt ist die effiziente Verwaltung großer Datensätze für Unternehmen und Forscher gleichermaßen von entscheidender Bedeutung. Eine leistungsstarke Technik, die in den letzten Jahren an Bedeutung gewonnen hat, ist die Datenunterteilung. Dieser Artikel wird tief in die Welt der Datenunterteilung eintauchen, ihre Grundlagen, Vorteile und praktischen Anwendungen untersuchen. Wir werden auch einige Open-Source-Tools betrachten und Beispiele liefern, die Ihnen den Einstieg in diese essenzielle Datenmanagement-Technik erleichtern.

Was ist Datenunterteilung?

Datenunterteilung ist der Prozess, bei dem ein kleinerer, handhabbarer Teil eines größeren Datensatzes erstellt wird, während dessen wesentliche Merkmale und Beziehungen erhalten bleiben. Diese Technik ermöglicht es den Benutzern, mit einer repräsentativen Stichprobe von Daten zu arbeiten, was die Handhabung, Analyse und Tests erleichtert, ohne die Integrität des Originaldatensatzes zu beeinträchtigen.

Warum sollten Sie an der Unterteilung interessiert sein?

Datenunterteilung gewinnt in unserer Big-Data-Ära zunehmend an Bedeutung. Hier sind einige Gründe, warum Sie dieser Technik Beachtung schenken sollten:

- Umgang mit massiven Datensätzen: Moderne Datensätze können enorm sein. So könnte beispielsweise eine Social-Media-Plattform täglich Petabytes an Daten generieren. Ohne Datenunterteilung wäre die Arbeit mit solch großen Datenmengen oft unpraktisch oder unmöglich.

- Ressourcenoptimierung: Die Verarbeitung vollständiger Datensätze erfordert häufig erhebliche Rechenressourcen. Durch die Unterteilung können Sie mit einem Bruchteil der Daten arbeiten, was Zeit spart und Hardwareanforderungen reduziert.

- Kostensenkung: Cloud-Computing- und Speicherkosten sind direkt an das Datenvolumen gekoppelt. Durch die Arbeit mit Teilmengen können Sie diese Ausgaben erheblich reduzieren.

- Schnellere Entwicklungszyklen (Softwaretests): In der Softwareentwicklung kann die Verwendung vollständiger Produktions-datensätze für Tests den Entwicklungsprozess verlangsamen. Teilmengen ermöglichen schnellere Iterationen und eine schnellere Fehleridentifikation.

- Datenschutzkonformität: Bei Regelungen wie GDPR und CCPA kann die Verwendung vollständiger Datensätze mit sensiblen Informationen für Tests oder Analysen riskant sein. Die Unterteilung hilft, anonymisierte, konforme Datensätze zu erstellen.

- Verbesserte Datenqualität: Kleinere Datensätze lassen sich leichter bereinigen und validieren, was potenziell zu qualitativ hochwertigeren Daten für Ihre Analysen oder Modelle führt.

Wie groß können Datensätze sein? Ein Beispiel aus der Praxis

Um das Ausmaß moderner Datensätze zu verdeutlichen, betrachten wir einige Beispiele:

- Walmarts Data Warehouse: Im Jahr 2019 wurde geschätzt, dass Walmarts Data Warehouse über 2,5 Petabytes an Daten enthielt. Das entspricht dem 167-fachen aller Bücher der US Library of Congress.

- Facebooks Benutzerdaten: Facebook verarbeitet täglich über 500 Terabytes an Daten. Dies umfasst Benutzerbeiträge, Fotos, Videos und Interaktionsdaten.

- CERNs Large Hadron Collider: Der LHC erzeugt enorme Mengen an Daten, die mehr als 20.000 Jahre HD-Videoaufnahme rund um die Uhr entsprechen.

- Genomikdaten: Das menschliche Genom besteht aus etwa 3 Milliarden Basenpaaren. Das Sequenzieren und Speichern dieser Daten von Millionen Menschen erstellt Datensätze im Petabyte-Bereich.

- Klimawissenschaft: Das NASA Center for Climate Simulation (NCCS) verwaltet über 32 Petabytes an Daten aus verschiedenen Erdbeobachtungsmissionen.

Um dies ins Verhältnis zu setzen: 1 Petabyte entspricht 20 Millionen vierfachen Aktenschränken, die mit Text gefüllt sind. Stellen Sie sich vor, Sie müssten diese Datenmenge vollständig analysieren oder verarbeiten – hier wird die Datenunterteilung unschätzbar wertvoll.

Wenn Sie beispielsweise ein Data Scientist bei Walmart wären und das Kundenverhalten analysieren wollten, wäre es unpraktisch, mit den vollen 2,5 Petabytes zu arbeiten. Stattdessen könnten Sie eine Teilmenge der Daten für einen bestimmten Zeitraum, eine Region oder Produktkategorie erstellen, wodurch Ihr bearbeiteter Datensatz vielleicht auf verwaltbare 50 Gigabytes reduziert würde.

Praktische Anwendungen der Unterteilung

Sehen wir uns einige praxisnahe Szenarien an, in denen die Datenunterteilung von unschätzbarem Wert ist:

1. Softwareentwicklung und -tests

Entwickler müssen oft mit realistischen Daten für Anwendungstests arbeiten. Allerdings kann die Verwendung vollständiger Produktionsdatensätze unpraktisch und riskant sein. Die Unterteilung ermöglicht die Erstellung kleinerer, repräsentativer Testdatensätze, die die Komplexität realer Daten beibehalten, ohne sensible Informationen preiszugeben.

2. Datenanalyse und Exploration

Bei der Arbeit mit massiven Datensätzen kann die anfängliche explorative Datenanalyse zeitaufwendig sein. Durch die Erstellung einer Teilmenge können Analysten schnell Einblicke gewinnen und Hypothesen testen, bevor sie auf den vollständigen Datensatz zugreifen.

3. Entwicklung von Machine-Learning-Modellen

In den frühen Phasen der Modellentwicklung können Data Scientists Teilmengen verwenden, um schnell an verschiedenen Algorithmen und Hyperparametern zu iterieren, bevor sie auf dem vollständigen Datensatz trainieren.

4. Datenbankoptimierung

Datenbankadministratoren können die Unterteilung nutzen, um kleinere Versionen von Produktionsdatenbanken für Entwicklungs- und Testumgebungen zu erstellen und somit eine optimale Leistung zu gewährleisten, ohne den Aufwand für die Verwaltung von Voll-Replica-Daten zu haben.

Überblick über Datenkonformität | Regulatorische Rahmenbedingungen

Automatisierte, policy-gesteuerte Unterteilung & Maskierung

Manuell erstellte SQL-Extrakte scheitern im Moment, in dem sich Schemata ändern. Moderne Teams verlassen sich stattdessen auf automatisierte Erkennung, Regel-Engines und dynamische Maskierung, um bedarfsgerechte, konforme Teilmengen zu generieren. DataSunrise scannt Quellsysteme, identifiziert sensible Spalten und erstellt dann referentiell intakte Ausschnitte – komplett mit Maskierung on-the-fly für PII oder PHI – sodass QA- und Analyseteams nie Rohproduktionsdaten berühren.

Jeder Export ist versioniert, protokolliert und über eine REST-API reproduzierbar, was den Prüfern eine klare Spur hinterlässt und DevOps ermöglicht, frische, verkleinerte Kopien in CI/CD-Pipelines auszulösen. Das Ergebnis: schnellere Entwicklungszyklen, geringere Cloud-Kosten und absolute Konformität, ohne auch nur eine einzige Abfrage neu schreiben zu müssen.

Tools und Techniken zur Datenunterteilung

Nachdem wir die Bedeutung der Datenunterteilung verstanden haben, werfen wir einen Blick auf einige beliebte Tools und Techniken, um sie effektiv umzusetzen.

SQL für Datenunterteilung

SQL ist eine leistungsstarke Sprache zur Datenmanipulation und eignet sich hervorragend zur Unterteilung relationaler Datenbanken. Hier ist ein Beispiel, wie man mit SQL eine Teilmenge von Daten erstellt:

-- Erstellen einer Teilmenge von Kundendaten für das Jahr 2023 CREATE TABLE customer_subset_2023 AS SELECT * FROM customers WHERE EXTRACT(YEAR FROM order_date) = 2023 LIMIT 10000;

Diese Abfrage erstellt eine neue Tabelle customer_subset_2023, die bis zu 10.000 Kundenaufzeichnungen aus dem Jahr 2023 enthält. Das Ergebnis ist ein kleinerer, leichter handhabbarer Datensatz für Analyse- oder Testzwecke.

Python für Datenunterteilung

Mit seinem reichhaltigen Ökosystem an Datenmanipulationsbibliotheken bietet Python leistungsstarke Werkzeuge zur Datenunterteilung.

Es verfügt über einen eingebauten Datentyp namens “set”, der nützlich ist, um eindeutige Elemente zu speichern und mathematische Mengenoperationen durchzuführen. Allerdings werden Mengen in der Regel nicht für Big-Data-Operationen verwendet. Für die Handhabung großer Datensätze in Python kommen spezialisierte Bibliotheken wie pandas, NumPy oder PySpark häufiger zum Einsatz, da sie eine optimierte Leistung und fortgeschrittene Datenmanipulationsmöglichkeiten bieten.

Sehen wir uns ein Beispiel mit pandas an:

import pandas as pd

import numpy as np

# Laden des vollständigen Datensatzes

full_dataset = pd.read_csv('large_dataset.csv')

# Erstellen einer Teilmenge basierend auf einer Bedingung und zufälliger Stichprobe

subset = full_dataset[full_dataset['category'] == 'electronics'].sample(n=1000, random_state=42)

# Speichern der Teilmenge in einer neuen CSV-Datei

subset.to_csv('electronics_subset.csv', index=False)Dieses Skript lädt einen großen Datensatz, filtert ihn so, dass nur Elektronikartikel enthalten sind, und zieht dann zufällig 1.000 Zeilen, um eine Teilmenge zu erstellen. Das Ergebnis wird als neue CSV-Datei gespeichert.

Außerdem können Sie in Pandas Daten mit folgenden Anweisungen filtern:

filtered_df_loc = df.loc[df['age'] > 25, ['name', 'city']]

oder

filtered_df = df[df['age'] > 25]

Bedingungsbasierte Datenfilterung in R

R ist eine weitere leistungsstarke Sprache zur Datenmanipulation und Analyse, die in der statistischen Auswertung und Data Science weit verbreitet ist. Während Python häufig für Deep Learning bevorzugt wird, bietet R starke Funktionen im statistischen Lernen und traditionellen Machine Learning. Dies kann von Vorteil sein, wenn Ihre Datenunterteilung modellbasierte Ansätze beinhaltet oder wenn Sie die statistischen Eigenschaften Ihrer Teilmengen analysieren müssen.

Sie können diesen Code in der kostenlosen Posit Cloud-Version von RStudio ausführen.

# Notwendige Bibliothek laden

library(dplyr)

# Angenommen, wir haben einen großen Datensatz namens 'full_dataset'

# Für dieses Beispiel erstellen wir einen Beispieldatensatz

set.seed(123) # für Reproduzierbarkeit

full_dataset <- data.frame(

id = 1:1000,

category = sample(c("A", "B", "C"), 1000, replace = TRUE),

value = rnorm(1000)

)

# Erstellen einer Teilmenge basierend auf einer Bedingung und zufälliger Stichprobe

subset_data <- full_dataset %>%

filter(category == "A") %>%

sample_n(100)

# Anzeige der ersten Zeilen der Teilmenge

head(subset_data)

# Speichern der Teilmenge in einer CSV-Datei

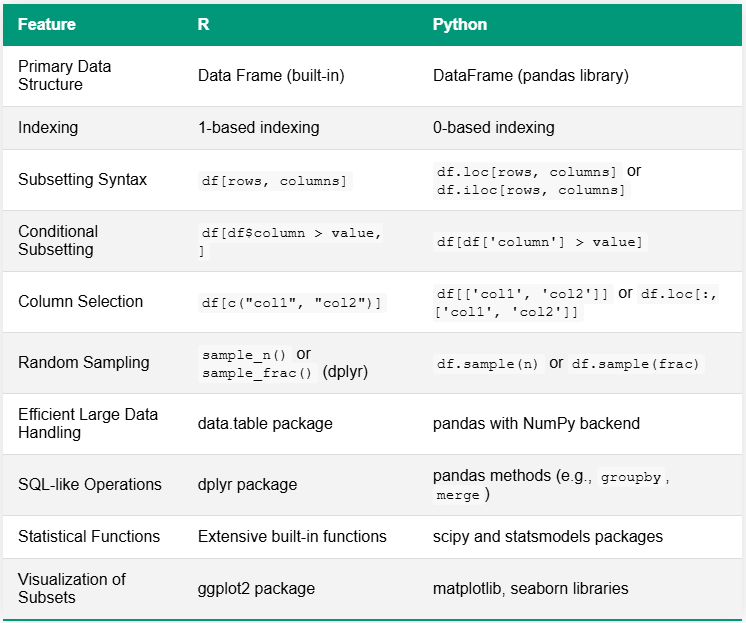

write.csv(subset_data, "category_A_subset.csv", row.names = FALSE)Die Tabelle unten vergleicht R und Python bei Aufgaben der Datenunterteilung und hebt wesentliche Unterschiede in der Syntax und Funktionalität hervor. Ein auffälliger Unterschied liegt in ihren Ökosystemen: R verfügt häufig über eingebaute Funktionen oder verlässt sich auf wenige umfassende Pakete, während Python in der Regel eine Vielzahl spezialisierter Bibliotheken für ähnliche Funktionen verwendet.

Open-Source-Tools für Datenunterteilung

Mehrere Open-Source-Tools stehen für fortgeschrittene Anforderungen zur Verfügung:

- Jailer: Ein Tool zur Datenunterteilung in Datenbanken, das die referenzielle Integrität bewahrt.

- Benerator CE: Ein Open-Source-Framework zur Generierung und Unterteilung von Testdaten.

- Subsetter: Eine Python-Bibliothek zur Unterteilung relationaler Datenbanken unter Wahrung der referenziellen Integrität.

Diese Tools bieten fortschrittlichere Funktionen, wie die Aufrechterhaltung komplexer Beziehungen zwischen Tabellen und die Generierung synthetischer Daten zur Ergänzung von Teilmengen.

Best Practices für eine effektive Datenunterteilung

Um das Beste aus der Datenunterteilung herauszuholen, sollten Sie diese Best Practices beachten:

- Wahren Sie die Datenintegrität: Stellen Sie sicher, dass Ihre Teilmenge die Beziehungen und Einschränkungen des Originaldatensatzes bewahrt.

- Verwenden Sie repräsentative Stichproben: Streben Sie an, Teilmengen zu erstellen, die die Eigenschaften des vollständigen Datensatzes genau widerspiegeln.

- Berücksichtigen Sie die Datensensitivität: Seien Sie bei der Unterteilung für Tests oder Entwicklungszwecke vorsichtig mit sensiblen Informationen und wenden Sie geeignete Anonymisierungstechniken an.

- Dokumentieren Sie Ihren Prozess: Führen Sie klare Aufzeichnungen darüber, wie die Teilmengen erstellt wurden, um die Reproduzierbarkeit zu gewährleisten.

- Validieren Sie Ihre Teilmengen: Überprüfen Sie regelmäßig, ob Ihre Teilmenge den vollständigen Datensatz, während er sich im Laufe der Zeit weiterentwickelt, noch genau widerspiegelt.

Fazit

Datenunterteilung ist eine leistungsstarke Technik, die Ihre Datenmanagementpraktiken erheblich verbessern kann. Durch die Erstellung kleinerer, handhabbarer Datensätze können Sie die Leistung verbessern, Kosten senken und Ihre Entwicklungs- und Testprozesse optimieren. Ob Sie SQL, Python oder spezialisierte Tools verwenden – die Beherrschung der Datenunterteilung ist eine wesentliche Fähigkeit für jeden Datenexperten.

Wenn Sie sich auf Ihre Reise zur Datenunterteilung begeben, denken Sie daran, dass der Schlüssel zum Erfolg darin liegt, die Datenintegrität aufrechtzuerhalten, repräsentative Teilmengen zu erstellen und die richtigen Tools für Ihre spezifischen Anforderungen auszuwählen.