Datenschutzstrategien für genAI-Architekturen

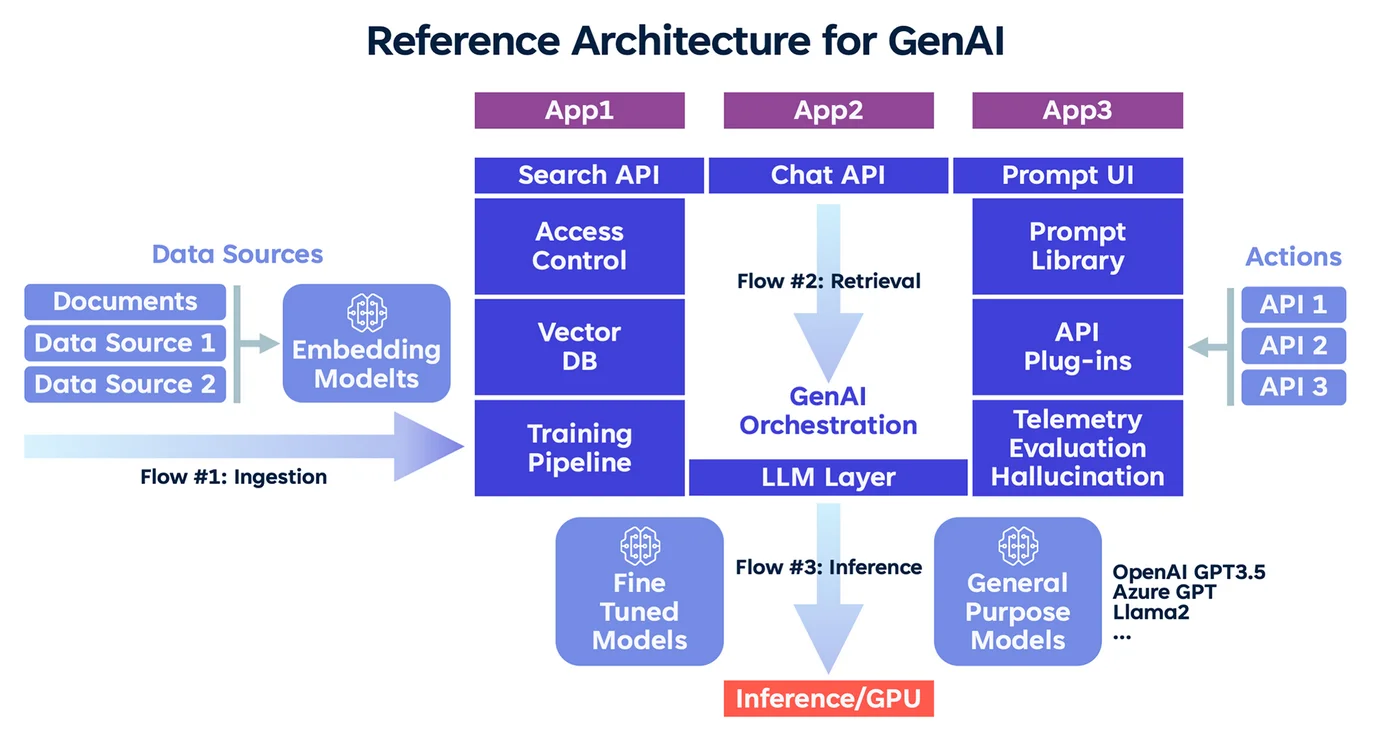

Generative KI verändert, wie Organisationen mit Daten interagieren. Aber mit der Weiterentwicklung ihrer Fähigkeiten wachsen auch die Risiken – insbesondere wenn große Sprachmodelle persönliche, finanzielle oder proprietäre Informationen verarbeiten. Das Design sicherer genAI-Systeme erfordert einen gezielten Fokus auf Privatsphäre, Kontrolle und Sichtbarkeit.

Dieser Artikel untersucht wesentliche Datenschutzstrategien für genAI-Architekturen, einschließlich Echtzeit-Audit, dynamischer Maskierung, Datenentdeckung und Compliance-Management. Zusammen stellen diese Ansätze sicher, dass Innovationen die Integrität der Informationen nicht gefährden.

Warum genAI stärkere Schutzmaßnahmen erfordert

genAI-Modelle sind darauf ausgelegt, Ausgaben basierend auf erlernten Mustern zu generieren. Obwohl dies sie nützlich für die Inhaltserstellung, Zusammenfassung oder Codevervollständigung macht, birgt es auch Risiken. Modelle können sensible Daten einprägen, Trainingsartefakte offenbaren oder hallucinierten Inhalt mit regulierten Informationen produzieren.

Diese Risiken werden verstärkt, wenn Eingabeaufforderungen, Benutzerdaten und Zwischenrepräsentationen nicht ordnungsgemäß kontrolliert werden. Ein robustes Schutzkonzept muss in Echtzeit überwachen, redigieren und Richtlinien durchsetzen.

Echtzeit-Audit als Kontrollschicht

Audit-Logs sind für KI-Systeme nicht länger optional – sie sind eine Notwendigkeit für Compliance und Sicherheit. Das Protokollieren jeder Abfrage, jeder Benutzerinteraktion und jeder Modellausgabe ermöglicht es Teams, riskante Abläufe zu rekonstruieren, Versuche der Prompt Injection zu entdecken und Compliance-Berichte für Regularien wie DSGVO oder HIPAA zu erstellen.

Tools wie DataSunrise Audit bieten Echtzeit-Protokollierung über Datenbanken und Anwendungen, die sowohl strukturierte als auch unstrukturierte Aktivitäten erfasst. In Kombination mit Verhaltensanalysen können Organisationen Anomalien in der Nutzung oder im Missbrauch von genAI erkennen.

-- Beispiel: Audit-Tabelle für Eingabeaufforderungen und Antworten

CREATE TABLE genai_audit (

id SERIAL PRIMARY KEY,

user_id TEXT,

prompt TEXT,

response TEXT,

timestamp TIMESTAMPTZ DEFAULT now()

);

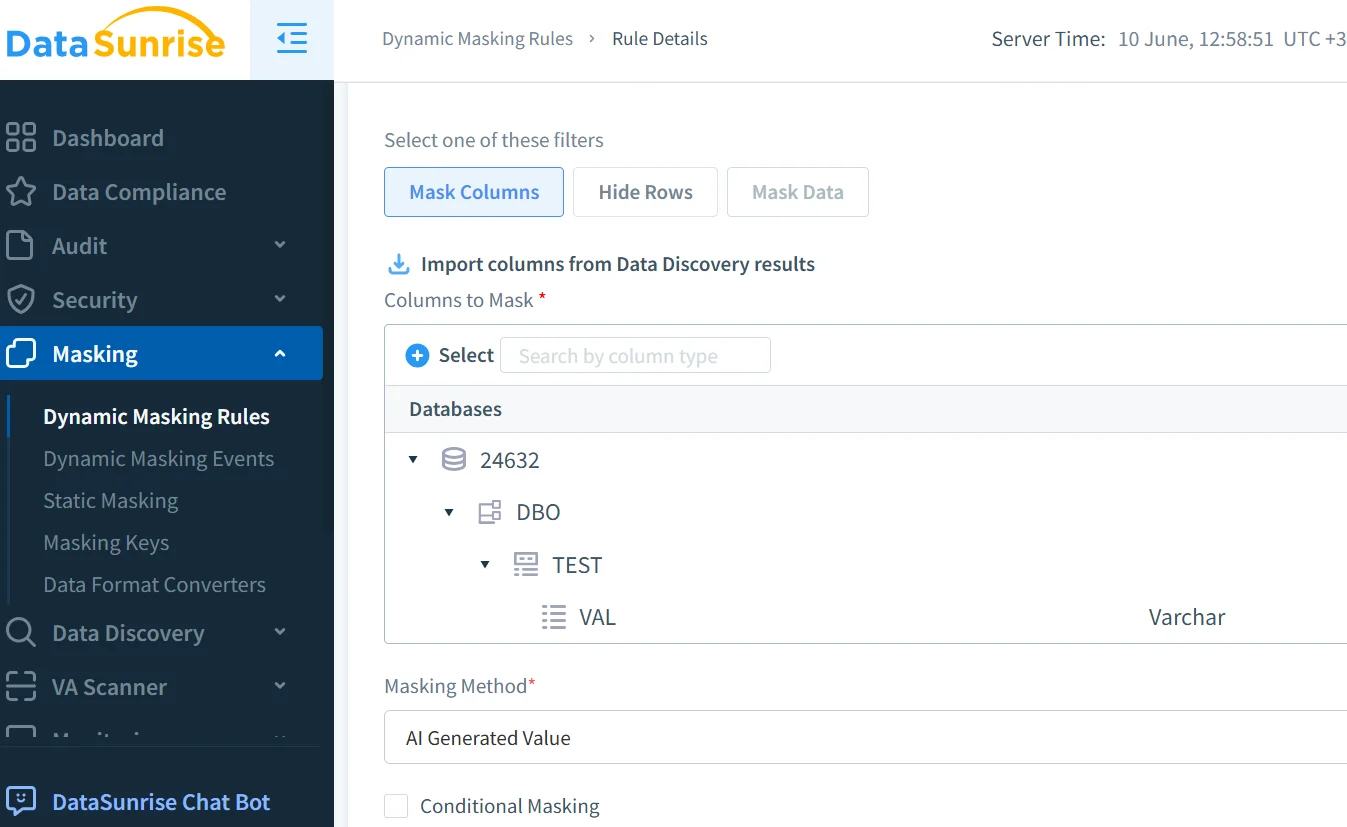

Dynamische Maskierung zur Verhinderung von Lecks

Einer der effektivsten Schutzmechanismen ist die dynamische Maskierung, die sensible Inhalte während der KI-Verarbeitung oder der Generierung von Antworten redigiert. Im Gegensatz zur statischen Maskierung passt sie sich in Echtzeit an – was für generative Aufgaben unerlässlich ist.

Wenn beispielsweise eine Eingabeaufforderung eine Sozialversicherungsnummer enthält, können Maskierungs-Engines diese abfangen und verdecken, bevor das Modell die Eingabe verarbeitet.

DataSunrises dynamische Maskierung integriert sich in NLP-Systeme und wendet granulare Regeln an, die sich an Kontext und Rollen anpassen. Dies verhindert die Offenlegung von PII und entspricht den rollenbasierten Zugangskontrollen.

Datenentdeckung für KI-Eingabe-Pipelines

Man kann nichts schützen, von dessen Existenz man nichts weiß. Datenentdeckungs-Tools durchsuchen Data Lakes, Vektorspeicher und Modelleingaben. Sie helfen dabei, PII, PHI und PCI-Daten zu lokalisieren, sensiblen Trainingsinhalt aufzudecken und Schatten-Datenbanken zu enthüllen, die bei manuellen Überprüfungen oft übersehen werden.

Mit den Datenentdeckungsfunktionen von DataSunrise können Teams die Klassifizierung automatisieren, bevor Datensätze in den Trainings- oder Inferenz-Workflow gelangen. Dies hilft dabei, Aufbewahrungsgrenzen, zustimmungsbasierte Nutzung und Redaktion durchzusetzen.

Ausrichtung an Compliance-Rahmenwerken für Daten

Datenschutz in genAI geht nicht nur um gute Praktiken – er ist auch eine Compliance-Vorgabe. Je nach Branche und geografischer Lage müssen Organisationen möglicherweise die DSGVO in Europa, HIPAA im Gesundheitswesen oder PCI DSS im Finanzsektor einhalten.

Compliance-Tools wie der DataSunrise Compliance Manager unterstützen automatisierte Berichterstattung und Datensicherheitsrichtlinien. Diese können an KI-Endpunkte gekoppelt werden, um sicherzustellen, dass Eingabeaufforderungen und Ausgaben gemäß den gesetzlichen und ethischen Standards verarbeitet werden.

End-to-End-Sicherheit in KI-gesteuerten Workflows

Über Maskierung und Audit hinaus muss die genAI-Sicherheit auch Risiken auf Infrastruktur-Ebene adressieren. Dies beinhaltet den Einsatz von Reverse-Proxy-Kontrollen zur Inspektion des LLM-Verkehrs, die Anwendung von SQL-Injektions-Erkennung bei integrierten Abfragen und die Durchsetzung von Least-Privilege-Zugriffsrichtlinien sowohl auf Modell- als auch auf Datenbankebene.

Wenn Modelle Abfragen an Datenbanken ausführen oder Inhalte mithilfe von Retrieval-augmented Generation (RAG) anreichern, verhindern diese Kontrollen laterale Bewegungen und eine Überexposition der Daten.

GenAI aufbauen, das Grenzen respektiert

Das eigentliche Ziel des Datenschutzes in genAI besteht nicht darin, einzuschränken, sondern vertrauenswürdige Nutzung zu ermöglichen. Durch die Kombination von Audit-Sichtbarkeit, kontextbewusster Maskierung und sicherheitsorientierter Datenentdeckung können Organisationen die Kontrolle über sensible Daten behalten, eine skalierbare KI-Einführung ermöglichen und das Compliance-Risiko in allen Abteilungen verringern.

Letztendlich dienen Datenschutzstrategien für genAI-Architekturen als Grundlage für eine ethische, sichere und skalierbare KI-Integration. Für ein umfassenderes Verständnis von KI-bezogenen Datenschutzherausforderungen siehe das AI Risk Management Framework der NIST. Um Open-Source-Sicherheitspraktiken von LLM zu erkunden, ist die MITRE ATLAS Wissensdatenbank eine weitere wertvolle externe Ressource. Die Herausforderung besteht nicht nur darin, KI mächtig zu machen – sondern sie auch verantwortlich zu gestalten.