Datenschutzstrategien in GenAI- & LLM-Umgebungen

Generative KI (GenAI) und große Sprachmodelle (LLMs) revolutionieren, wie Organisationen Inhalte automatisieren, analysieren und generieren. Diese Systeme arbeiten mit umfangreichen Datensätzen – die oft sensible oder regulierte Informationen enthalten. Ohne ausreichende Sicherheitsvorkehrungen könnten sie unbeabsichtigt private Daten preisgeben oder in den Ausgaben reproduzieren. Dieses Risiko verstärkt sich, wenn diese Modelle in Produktionsabläufe für Kundensupport, Programmierung oder Analysen integriert werden. Experten, wie die des Harvard Berkman Klein Center, haben Bedenken geäußert, wie LLMs mit sensiblen Trainingsdaten umgehen.

Kernstrategien zum Datenschutz in GenAI- & LLM-Umgebungen

Um die Kontrolle über sensible Daten in GenAI-Systemen zu behalten, müssen Unternehmen mehrschichtige Abwehrmaßnahmen ergreifen. Die effektivsten Strategien kombinieren Echtzeit-Auditing, dynamische Datenmaskierung, automatisierte Erkennung und Richtliniendurchsetzung. Lassen Sie uns untersuchen, wie diese Techniken zusammenarbeiten, um robuste Schutzmechanismen zu schaffen.

Echtzeit-Audit und transparente Protokollierung

Echtzeit-Auditing hilft dabei, zu erkennen und zu verstehen, wie Daten von GenAI-Prozessen abgerufen oder abgefragt werden. Zum Beispiel, wenn ein Prompt versehentlich den Zugriff auf Kundenadressen auslöst, wird dieses Ereignis in einem Live-Audit-Trail zur sofortigen Überprüfung protokolliert. Dies ist besonders wertvoll, wenn LLMs an Datenbanken angeschlossen sind, die Vektorsuche oder Retrieval-augmented Generation (RAG) verwenden.

DataSunrise bietet flexible Audit-Regeln und Sitzungsverfolgung, die SQL-Abfragen, Benutzersitzungen und Verhaltensanomalien erfassen. Diese Audit-Protokolle können exportiert oder in SIEM-Tools integriert werden, um eine kontinuierliche Compliance-Schicht bereitzustellen. Erfahren Sie mehr über Audit-Konfigurationsoptionen.

Die Bedeutung der Prüf- und Nachvollziehbarkeit in LLMs wird in Initiativen wie der System Card für GPT-4 von OpenAI hervorgehoben, die Risiken in Zusammenhang mit unbeabsichtigtem Informationsleck aufzeigt.

SELECT * FROM customers WHERE notes ILIKE '%refund%';

Falls eine solche Abfrage von einem GenAI-Modell ausgelöst wird, wird sie sofort protokolliert, nach Risikostufe gekennzeichnet und je nach Richtlinie gegebenenfalls blockiert oder maskiert.

Dynamische Datenmaskierung zur Laufzeit

Statische Maskierung ist nützlich, um Datensätze vor dem Training zu anonymisieren, aber in Produktionsabläufen von GenAI ist die dynamische Maskierung unerlässlich. Diese Technik verbirgt sensible Felder in Echtzeit, ohne die Quelldaten zu verändern. Wenn ein GenAI-Agent das Backend abfragt, gewährleisten maskierte Antworten die Einhaltung der Vorschriften, ohne den Service zu unterbrechen.

-- Beispiel: Dynamische Maskierung auf die SSN-Spalte anwenden

CREATE MASKING RULE mask_ssn

ON customers(ssn)

USING FULL MASK;

Die dynamische Maskierung stellt sicher, dass LLMs, die auf Live-Datenquellen trainiert wurden, niemals rohe Identifikatoren zurückgeben, selbst wenn ihre Prompts unerwartet oder bösartig sind. In Kombination mit RBAC-Richtlinien begrenzt sie die Exposition für bestimmte Benutzer und KI-Agenten.

Wie das NIST in seinem AI Risk Management Framework feststellt, sind kontextabhängige Zugriffskontrollen und Maskierung essenziell zum Schutz wertvoller Datensätze in KI-Systemen.

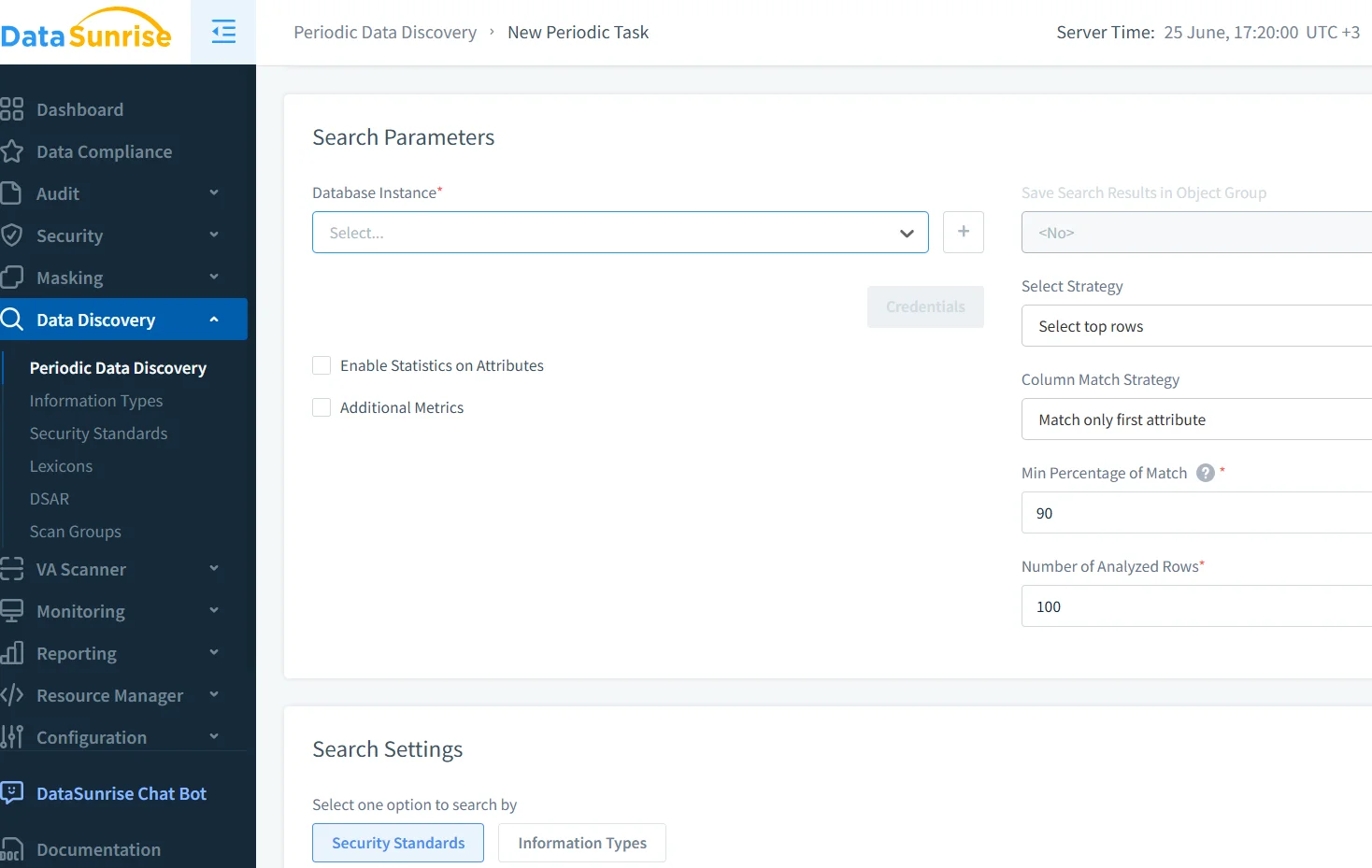

Automatisierte Datenerkennung und Klassifikation

Bevor Sie Daten schützen können, müssen Sie wissen, wo sie sich befinden. Automatisierte Datenerkennungs-Scans helfen dabei, PII, PHI, Finanzunterlagen oder regulierte Inhalte in strukturierten und halbstrukturierten Speichern zu lokalisieren. Dies ist entscheidend für GenAI-Anwendungen, die auf mehrere Data Lakes oder Vektorindizes zugreifen.

DataSunrise ermöglicht periodische oder bedarfsorientierte Scans mit Tagging und Empfindlichkeitsklassifizierung. In Kombination mit Audit- und Maskierungsmodulen verbessert die Erkennung die Sichtbarkeit und stellt sicher, dass neue Quellen nicht übersehen werden.

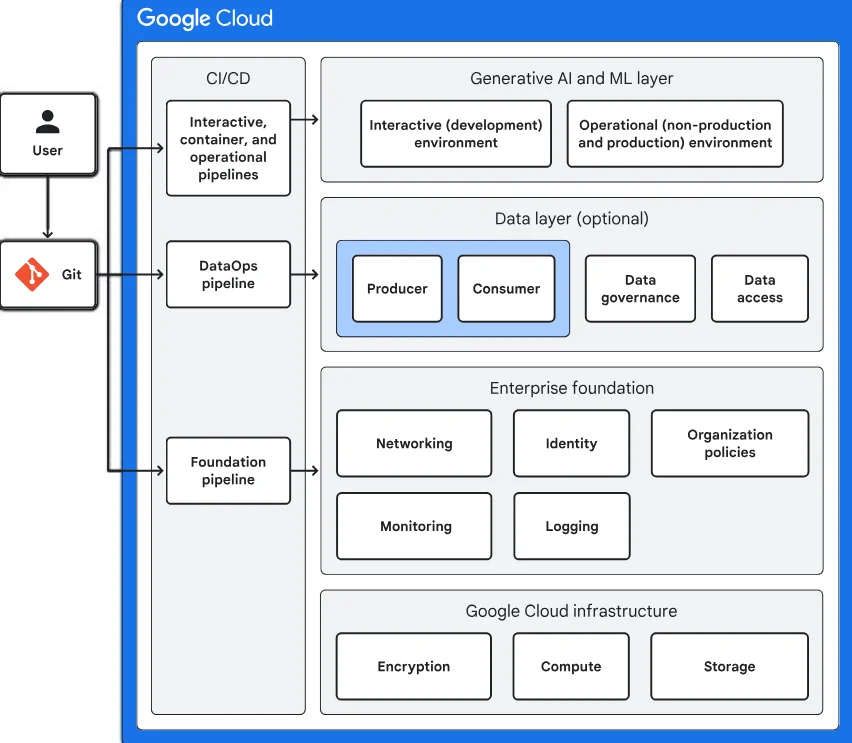

Tools wie Googles Sensitive Data Protection bieten ergänzende Ansätze zur automatischen Klassifikation in cloudbasierten Umgebungen.

Sicherheitsdurchsetzung in GenAI-Einsätzen

Neben Audit und Maskierung benötigen GenAI-Einsätze einen aktiven Schutz gegen Bedrohungen wie Prompt Injection, Inferenz-Leckagen oder versehentliche Memorierung. Mehrere zusätzliche Techniken tragen dazu bei:

- Verhaltensanalysen zur Erkennung ungewöhnlicher Abfragemuster

- Richtlinienbasierte Zugriffskontrollen für externe Integrationen

- Verhinderung von SQL-Injektionen während der Übersetzung natürlicher Sprache

DataSunrise integriert diese Techniken über seine Datensicherheitsplattform. Mit speziell für GenAI-Workflows angepassten Sicherheitsregeln können Administratoren Eingabe-/Ausgabeströme überprüfen und verdächtige Vorgänge blockieren, bevor sie die Datenbankebene erreichen.

Forschungen des Center for Research on Foundation Models der Stanford Universität verdeutlichen zudem den Bedarf an Laufzeitschutzmaßnahmen und mehrschichtigen Sicherheitsrahmenwerken beim Einsatz von LLMs.

Regulatorische Abstimmung und Compliance-Management

Compliance ist häufig der Auslöser für Datenschutzstrategien. Ob Ihre GenAI-Modelle mit Kundendaten im Rahmen von GDPR, HIPAA oder PCI DSS interagieren, die Risiken bei fehlerhafter Handhabung sind erheblich. Automatisierte Compliance-Manager helfen dabei, Anforderungen mit vorgefertigten Vorlagen, Audit-Regeln und exportierbaren Berichten durchzusetzen.

Beispielsweise muss unter der DSGVO jeder Zugriff auf personenbezogene Daten nachvollziehbar und begrenzt sein. Audit-Trails, Zugriffskontroll-Logs und Maskierungsregeln erfüllen gemeinsam diese Anforderung, ohne die Leistung oder Fähigkeiten von LLMs zu beeinträchtigen.

Die Leitlinien des ICO zu KI und Datenschutz unter dem UK GDPR bieten praxisnahe Schritte, um sicherzustellen, dass LLM-Operationen mit dem Datenschutzgesetz übereinstimmen.

Best Practices für den Datenschutz in GenAI

Um die Datenintegrität aufrechtzuerhalten und Risiken in GenAI-Pipelines zu reduzieren, sollten Organisationen:

- Echtzeit-Auditing für alle KI-verbundenen Datenbanken aktivieren

- Dynamische Maskierung verwenden, um direkten Zugriff auf personenbezogene Daten zu verhindern

- Automatisierte Erkennungs-Scans für alle neuen Datenquellen durchführen

- Kontextbezogene Zugriffspolitiken für LLM-Dienste anwenden

- Compliance-Berichte über Regionen und Standards hinweg automatisieren

Diese Praktiken können zusätzlich erweitert werden, etwa durch synthetische Datengenerierung, Red-Teaming für LLM-Prompts und Validierungsgates für Modell-Ausgaben – insbesondere in regulierten Bereichen wie Finanzwesen oder Gesundheitswesen. Das Future of Privacy Forum erörtert viele dieser Techniken in seiner Untersuchung verantwortungsvoller KI-Einsätze.

Fazit

Datenschutzstrategien in GenAI- & LLM-Umgebungen müssen die einzigartigen Risiken von Inferenz, Prompt-Engineering und dynamischem Zugriff adressieren. Mit Werkzeugen wie Echtzeit-Audit, dynamischer Maskierung, automatisierter Erkennung und der Durchsetzung von Richtlinien durch Plattformen wie DataSunrise können Teams die Einführung von GenAI sicher skalieren, ohne sensible Daten oder regulatorische Anforderungen zu gefährden. Da sich GenAI stetig weiterentwickelt, müssen auch die Schutzmechanismen, die wir in seine Architektur integrieren, entsprechend anpassbar bleiben.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen