Führende LLM-Sicherheitsunternehmen

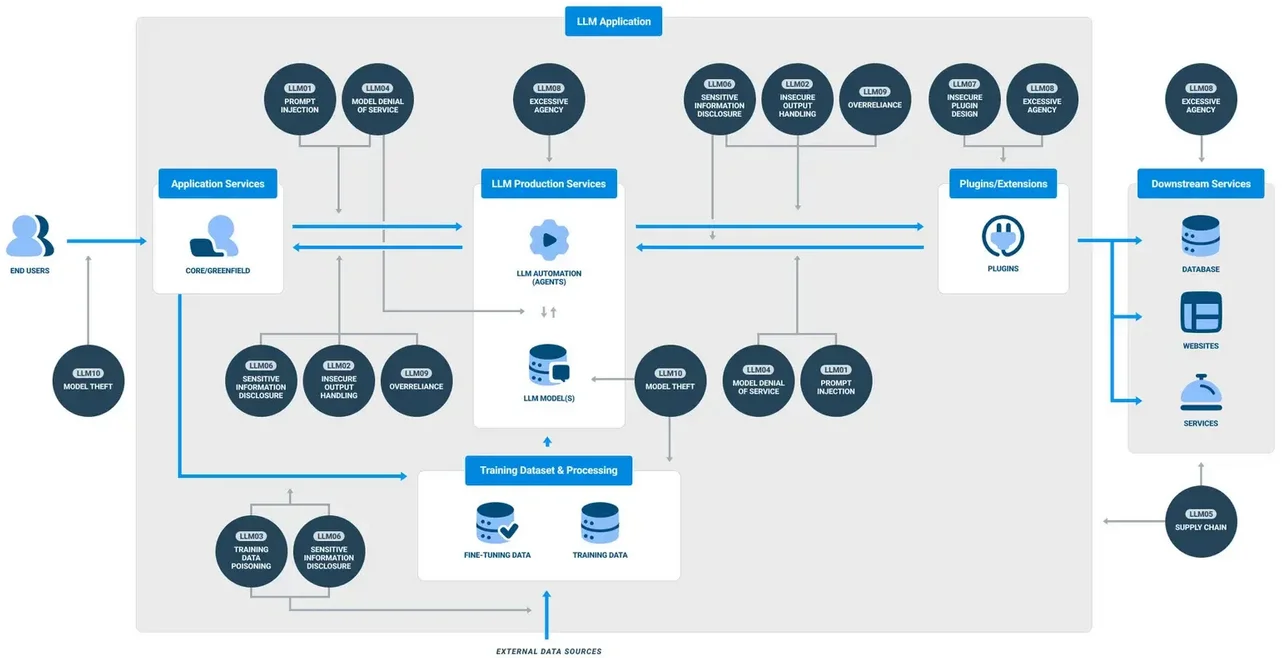

Da generative KI (GenAI)-Systeme in Unternehmens-Workflows zunehmend kritisch werden, wächst der Bedarf an robuster, Echtzeit-Sicherheit. Diese großen Sprachmodelle (LLMs) verarbeiten enorme Mengen sensibler Informationen, von Kundendaten bis hin zu proprietären Algorithmen. Angesichts von Bedrohungen, die von Prompt-Injektionen bis zu Datenlecks reichen, setzen Unternehmen vermehrt auf fortschrittliche Plattformen, die sich auf LLM-Transparenz, Audits, Maskierung und Compliance spezialisiert haben. In diesem Umfeld stechen mehrere Anbieter hervor. Dieser Artikel untersucht die Führenden LLM-Sicherheitsunternehmen und zeigt, wie sie eine sichere GenAI-Einführung durch Kernfunktionen wie Echtzeit-Audit, dynamische Maskierung und automatisierte Durchsetzung der Compliance ermöglichen.

Absicherung von GenAI: Die technischen Grundlagen

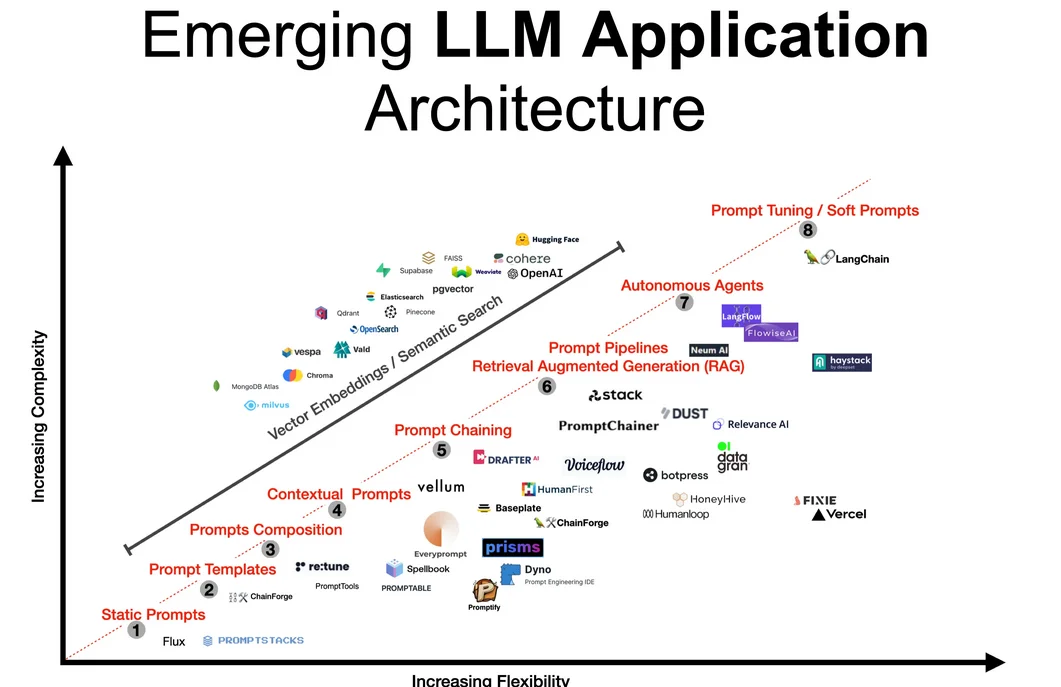

Die Sicherheit von LLMs geht über die Verschlüsselung von Speicher oder die Aktivierung grundlegender Protokollierung hinaus. Eine sichere GenAI-Pipeline erfordert eine vollständige Sichtbarkeit des gesamten Systems – von der Eingabe des Prompts bis zur endgültigen LLM-Antwort – sowie eine Inline-Durchsetzung von Richtlinien und Datenklassifizierung. Dazu gehören:

- Echtzeit-Audit von Benutzerinteraktionen und LLM-Entscheidungen

- Dynamische Maskierung von PII/PHI während der Inferenz

- Datenerkennung und -klassifizierung vor der Modelleingabe

- Zugangskontrollrichtlinien, die sich an Nutzungsmustern orientieren

- Compliance-Workflows, die an Standards wie DSGVO oder HIPAA angelehnt sind

Laut MIT Sloan gehört es zu den bewährten Verfahren, LLMs sowohl als Risikooberflächen als auch als intelligente Endpunkte zu betrachten.

Schauen wir uns an, wie die führenden Sicherheitsanbieter in diesem Bereich diese Anforderungen erfüllen.

DataSunrise: Granulare Richtlinien für LLM- und Datenbank-Pipelines

Ursprünglich auf Datenbanksicherheit fokussiert, hat DataSunrise seine Fähigkeiten erweitert, um die Sicherheit von GenAI zu unterstützen. Seine Echtzeit-Audit-Engine ermöglicht es Organisationen, LLM-Abfragen nachzuverfolgen, die über eingebettetes SQL oder promptverbundene APIs ausgeführt werden. Die Maskierung erfolgt dynamisch, basierend auf der Benutzerrolle und dem Regelkontext, wobei flexible dynamische Maskierungsregeln verwendet werden. Diese Richtlinien passen sich auf Basis von Verhaltensanalysen und Zugangskontext an.

Auch die Datenerkennung ist eine wesentliche Stärke. Die Plattform durchsucht automatisch strukturierte und semi-strukturierte Datenspeicher, um PII oder sensible Felder zu identifizieren, noch bevor sie die Phasen des Modelltrainings oder der Inferenz erreichen. In Kombination mit Sicherheitsrichtlinien und Techniken zur Optimierung der Audit-Speicherung gewährleistet DataSunrise, dass GenAI-Bereitstellungen in Produktionsumgebungen nachvollziehbar, maskiert und compliant bleiben.

-- Beispiel: Wende dynamische Maskierung auf eine von einem LLM abgefragte Spalte an

CREATE MASKING RULE mask_llm_sensitive_data

ON schema.customer_data (ssn, email)

WHEN ROLE IN ('llm_user', 'analyst')

USING 'XXXX-XX-####', '***@example.com';

Securiti.ai: Autonome Datenintelligenz für GenAI

Securiti bietet eine von KI unterstützte Cloud-Plattform zur Datenkontrolle, die die Erkennung, Klassifizierung und Zugriffssteuerung in hybriden Umgebungen automatisiert. Die Lösungen werden zunehmend in GenAI-Pipelines eingesetzt, in denen Entwickler Modelle mit Unternehmensdaten verfeinern oder LLMs in Analyse-Workflows integrieren.

Echtzeit-Compliance-Warnungen, klassifizierungsbasierte Maskierung und KI-gesteuerte Zugangskontrollrichtlinien sind zentrale Highlights. Die Integration von Securiti mit cloud-nativen Tools wie Snowflake, Azure SQL und Cosmos DB gewährleistet die nahtlose Durchsetzung von DSGVO und HIPAA von der Inferenz bis zur Speicherung.

Die Plattform wurde kürzlich in der Forrester Wave for Privacy Management Software für ihre Führungsrolle bei der automatisierten Richtliniendurchsetzung anerkannt.

Duality Technologies: Datenschutzwahrende GenAI-Zusammenarbeit

Duality konzentriert sich auf die sichere Zusammenarbeit bei Daten und das KI-Training mittels homomorpher Verschlüsselung und sicherer Mehrparteienberechnung. Obwohl es kein umfassendes LLM-Schutztool ist, ermöglicht Duality Anwendungsszenarien, in denen GenAI mit gemeinsamen Datensätzen trainiert wird, ohne Rohinformationen preiszugeben. Dies ist besonders für den Finanzsektor oder das Gesundheitswesen entscheidend, wo die Einhaltung von PCI-DSS oder strengen Gesetzen zur Datenlokalisierung von großer Bedeutung ist.

IDC berichtet, dass föderiertes Lernen und datenschutzwahrende Berechnungen in den Initiativen zur KI-Governance an Bedeutung gewinnen, wobei Duality als führender Anbieter gilt.

HiddenLayer: ML-spezifische Bedrohungserkennung

HiddenLayer bietet eine Sicherheitsplattform, die speziell auf maschinelle Lernsysteme zugeschnitten ist. Für Organisationen, die LLMs einsetzen, bietet sie Schutz vor adversarialen Prompts, Modellextraktion und Umgehungsangriffen. Die Laufzeitüberwachungsebene der Plattform kann Anomalien in GenAI-Ausgaben oder im Zugriffsverhalten erkennen und automatisierte Abwehrmaßnahmen auslösen.

Obwohl HiddenLayer nativ keine Datenerkennung oder Maskierung durchführt, macht der spezialisierte Fokus auf die Sicherheit von KI-Modellen während und nach dem Training es zu einem starken Kandidaten für risikoreiche Umgebungen. Seine Erkennungs-Engine stimmt mit dem NIST AI Risk Management Framework überein und verbessert die Praktiken zur Modellsicherung.

Die Zukunft schützen: Best Practices über die Tools hinaus

Die Wahl der richtigen Plattform ist entscheidend, aber die Absicherung von GenAI erfordert auch klar definierte operative Verfahren. Einige Erkenntnisse:

- Scannen und klassifizieren Sie stets die Eingabedaten vor dem Training

- Aktivieren Sie das Auditieren bei jeder Prompt-Aufrufstelle

- Verwenden Sie datengestützte Sicherheit zur Definition adaptiver Maskierung

- Stimmen Sie LLM-Protokolle mit Compliance-Richtlinien und Aufbewahrungszeiträumen ab

Weitere Informationen von Google DeepMind erläutern, warum Feinabstimmung, Sicherheitsleitplanken und kontinuierliche Audit-Schleifen für die Sicherheit von LLMs in Bereichen mit hohen Einsätzen unerlässlich sind.

Sicherheitsteams müssen LLMs als dynamische Datenverbraucher und -erzeuger behandeln – was nicht nur Perimeterschutz, sondern auch tiefgehende Beobachtbarkeit und fein abgestimmte Zugangskontrolle erfordert.

Fazit

Da die Verbreitung von LLMs zunimmt, müssen Unternehmen ihre Sicherheitsarchitektur an neue Risiken und regulatorische Anforderungen anpassen. Die hier vorgestellten führenden LLM-Sicherheitsunternehmen – DataSunrise, Securiti.ai, Duality und HiddenLayer – bringen verschiedene Stärken ein. Ob es sich um Audit-Trails, Maskierung, verschlüsselte Zusammenarbeit oder Bedrohungserkennung handelt, jedes bietet essenzielle Sicherheitsmaßnahmen, die auf GenAI-Workloads zugeschnitten sind. Ein mehrschichtiger Ansatz, der diese Fähigkeiten kombiniert, ist der effektivste Weg, um generative KI in Unternehmensumgebungen zu sichern.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen