Sichern von KI-Modell-Ein- und Ausgaben

GenAI-Systeme transformieren nicht nur, wie Daten verarbeitet werden – sie stellen auch in Frage, wie Sicherheit durchgesetzt wird. Im Gegensatz zu statischen Anwendungen passen sich KI-Modelle in Echtzeit an Eingaben an und erzeugen Ausgaben, die häufig herkömmliche Sicherheitsprüfungen umgehen. Wenn Sie LLMs in Arbeitsabläufe integrieren, ist das Übersehen von Ein- und Ausgangssicherheit keine Option mehr. So können Organisationen Risiken mindern und gleichzeitig sicherstellen, dass GenAI-Systeme funktional und konform bleiben.

Warum Ein- und Ausgangspfade wichtig sind

LLMs beantworten nicht nur Fragen – sie interpretieren, rekonstruieren und halluzinieren manchmal sensible Details. Eine unzureichend gefilterte Eingabe kann private Informationen extrahieren, während eine unüberwachte Ausgabe Daten preisgeben könnte, die durch Compliance-Regeln geschützt sind.

Betrachten Sie diese scheinbar harmlose Eingabe:

"Give me a breakdown of all complaints from EU customers."

Ohne geeignete Schutzmaßnahmen könnte dies zu einer unautorisierten Datenoffenlegung führen. Was wie eine hilfreiche Ausgabe erscheint, könnte jedoch personenbezogene Daten (PII) oder Gesundheitsdaten enthalten. In solchen Umgebungen muss die Sicherheit sowohl das Eingangstor als auch den Ausgabekanal abdecken.

Kontext erfassen mit Echtzeit-Audit

Man kann nicht beheben, was man nicht sieht. Echtzeit-Audit-Tools verfolgen jede Anfrage, jedes Ergebnis und die zugehörigen Metadaten – und bilden so die Grundlage für Alarmierungen und Nachuntersuchungen nach Vorfällen. Diese Tools helfen zudem, Verantwortlichkeit über Benutzer und Teams hinweg durchzusetzen.

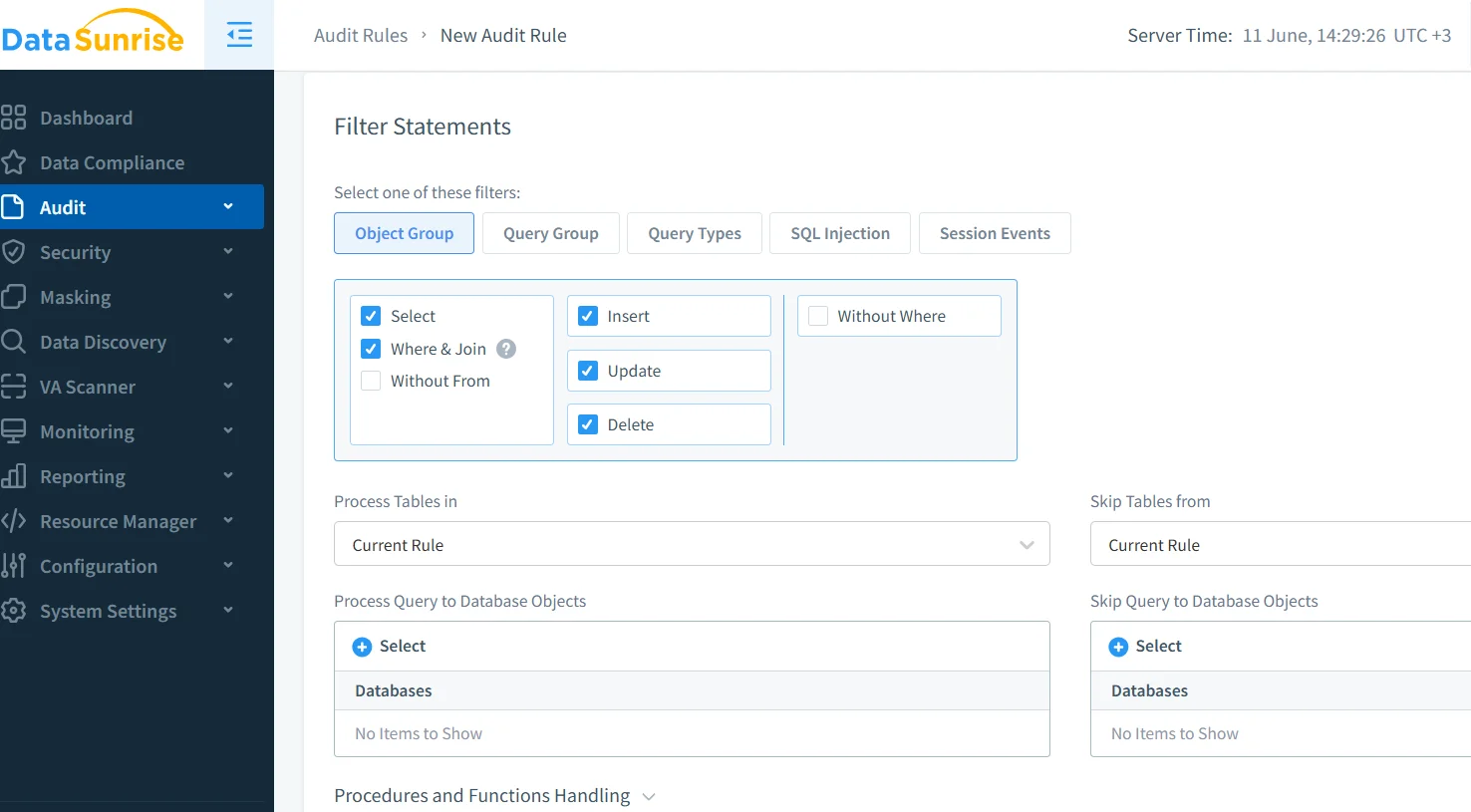

Mithilfe der Logging-Mechanismen von DataSunrise können Sicherheitsteams laufende Abfragen inspizieren und alles markieren, was bekannten Risikomustern entspricht. Dies ist besonders nützlich in Szenarien, in denen GenAI-Modelle mit sensiblen Back-End-Daten interagieren.

Für weitere Best Practices lesen Sie die Hinweise von Microsoft zum sicheren Prompt Engineering für LLMs.

Redigieren von Ausgaben mit dynamischer Maskierung

Selbst wenn Eingaben sicher sind, können Ausgaben zusätzliche Sorgfalt erfordern. Dynamische Maskierung greift unmittelbar vor der Auslieferung der Antwort ein, indem sie sensible Felder im Ergebnis ausblendet oder anonymisiert. Zum Beispiel sieht der Empfänger, auch wenn ein Modell auf echte Daten zugreift, folgendes:

{"user": "Maria G.", "email": "[hidden]", "passport": "***-**-9123"}

Dies stellt sicher, dass Sie niemals PII preisgeben – auch nicht, wenn LLMs in Live-Systeme integriert sind. Erfahren Sie mehr über dynamische Maskierung, um Redaktionen auf der Antwort-Ebene anzuwenden.

Wissen, was Sie schützen, mit Datenerkennung

Sicherheit ohne Überblick ist reines Ratespiel. Bevor Sie mit dem Schutz beginnen, müssen Sie Ihre Daten kartieren. Die Discovery-Engine von DataSunrise durchsucht Repositorien, um sensible Vermögenswerte zu erkennen – einschließlich Namen, Identifikatoren und regulatorischer Kennzeichnungen.

Sobald Sie Ihre Daten klassifiziert haben, können Sie GenAI-Systeme so konfigurieren, dass sie bestimmte Elemente nicht berühren oder preisgeben. Dies ist entscheidend, wenn Modelle Kontext aus Live-Tabellen oder indizierten Wissensdatenbanken abrufen.

Um Ihre Discovery-Bemühungen zu ergänzen, lesen Sie das IBM AI Governance Whitepaper für einen richtlinienkonformen Abgleich in großem Maßstab.

Eingangskontrolle: Bereinigung vor der Verarbeitung

Benutzereingaben sind unvorhersehbar – und manchmal bösartig. Die Bereinigung von Prompts stellt sicher, dass das Modell nicht dazu verleitet wird, unsichere Logik auszuführen oder sensible Kontexte zurückzugeben. Zu den Techniken gehören Regex-Filterung, Prompt-Klassifizierung und das Erzwingen von strukturellen Eingaberegeln.

Dies spiegelt Prinzipien der traditionellen Websicherheit wider. Stellen Sie sich dies wie den Schutz vor SQL-Injection vor – nur dass es nun auf KI-Prompts angewendet wird. Die Sicherheitspolitiken von DataSunrise können unsichere Prompts abfangen, bevor sie Ihr Modell erreichen.

Wenn Sie in Python entwickeln, sollten Sie sich die OpenAI Prompt Injection Mitigation Examples ansehen.

Regulatorischer Druck auf KI-Arbeitsabläufe

Compliance ist nicht nur für Prüfer – es ist ein Gestaltungsprinzip. Wenn Ihr GenAI-System mit PCI-, HIPAA- oder GDPR-regulierten Daten interagiert, müssen Sie die Kontrolle über den Zugriff und die Audit-Historie nachweisen.

Die Compliance-Engine von DataSunrise ordnet GenAI-Abfragen den regulatorischen Anforderungen zu. Sie können automatisch nachweisen, wer was wann und unter welcher Richtlinie aufgerufen hat.

Um zu verstehen, wie Compliance mit Fairness und Erklärbarkeit bei KI zusammenhängt, lesen Sie die KI-Prinzipien der OECD.

Praxisbeispiel: Steuerung einer Live-Abfrage

Angenommen, ein Benutzer sendet:

SELECT name, email, ssn FROM patients WHERE clinic = 'Berlin';

Ihre KI-Schnittstelle erfasst die Anfrage, protokolliert diese zusammen mit der Benutzer-ID und leitet sie durch eine Maskierungs-Engine. Die finale Ausgabe, die an den Benutzer geliefert wird:

{"name": "E. Krause", "email": "[redacted]", "ssn": "***-**-2210"}

Parallel dazu wird ein Alarm ausgelöst und ein Compliance-Eintrag mit vollständigen Metadaten erstellt. So entsteht eine kontinuierliche Kette von der Eingabe über die Ausgabe bis hin zum Protokoll.

Abschließende Gedanken

Das Sichern von KI-Modell-Ein- und Ausgaben bedeutet, die gesamte Interaktion ernst zu nehmen – vom Moment, in dem ein Benutzer spricht, bis zur Sekunde, in der ein Modell antwortet. Durch die Kombination von Echtzeitüberwachung, intelligenter Maskierung, automatisierter Erkennung und Compliance-Mapping können Sie Ihre GenAI-Systeme leistungsstark halten, ohne sie gefährlich zu machen.

Wenn Sie tiefer einsteigen möchten, sehen Sie sich das AI Risk Management Framework der NIST an – eine wesentliche Ressource, um Sicherheitsarchitektur mit ethischem KI-Design in Einklang zu bringen.